DeepSeek MCP-server

DeepSeek MCP-server integrerar DeepSeek's avancerade språkmodeller med MCP-kompatibla applikationer, och erbjuder säker, anonymiserad API-åtkomst samt möjliggör...

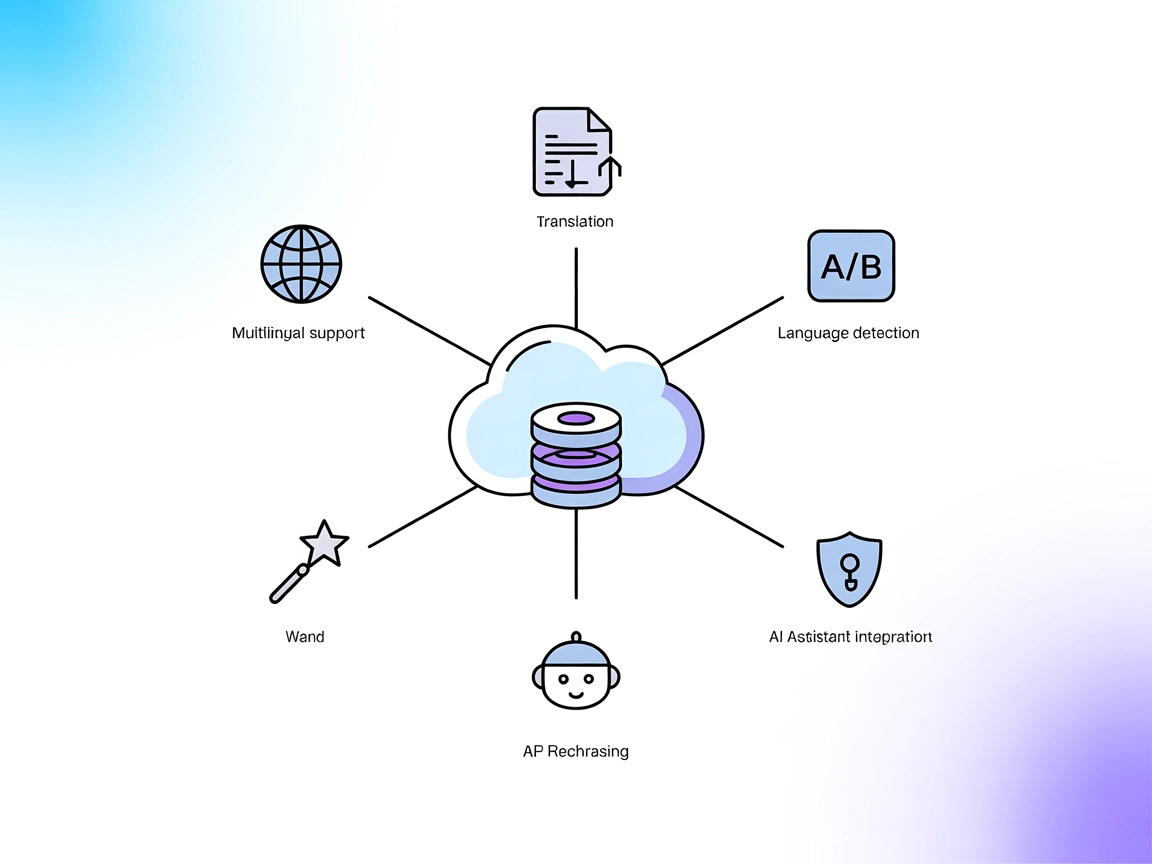

Låt dina AI-assistenter översätta, omformulera och upptäcka språk i realtid med DeepL:s API, allt via en enkel MCP-serverintegration.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

DeepL MCP-servern är en Model Context Protocol (MCP)-server som ger AI-assistenter avancerade översättningsmöjligheter genom att integrera DeepL API. Den fungerar som ett mellanprogram och låter AI-klienter utföra realtidsöversättning av text, omformulering och språkdetektering via standardiserade MCP-gränssnitt. Denna server stöder utvecklingsflöden som kräver flerspråkigt stöd, automatisk språkkänning och justering av formell/informell ton. Genom att koppla AI-assistenter till DeepL API möjliggör DeepL MCP-servern uppgifter som att översätta och omformulera innehåll, upptäcka språk i användarinput och stödja ett brett utbud av språk – vilket ökar flexibilitet och intelligens i AI-drivna applikationer.

Inga promptmallar är uttryckligen listade i repot eller dokumentationen.

Inga specifika MCP-resurser är beskrivna i repot eller dokumentationen.

Inga installationsinstruktioner för Windsurf finns i repot.

~/Library/Application Support/Claude/claude_desktop_config.json%AppData%\Claude\claude_desktop_config.json~/.config/Claude/claude_desktop_config.json{

"mcpServers": {

"deepl": {

"command": "npx",

"args": ["-y", "/path/to/deepl-mcp-server"],

"env": {

"DEEPL_API_KEY": "your-api-key-here"

}

}

}

}

/path/to/deepl-mcp-server mot den absoluta sökvägen till ditt lokala repo.your-api-key-here mot din faktiska DeepL API-nyckel.Skydda dina API-nycklar:

Använd fältet env för att lagra API-nycklar på ett säkert sätt. Exempel visas ovan i JSON-exemplet.

Inga installationsinstruktioner för Cursor finns i repot.

Inga installationsinstruktioner för Cline finns i repot.

Använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde börjar du med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I avsnittet för systemets MCP-konfiguration anger du dina MCP-serverdetaljer enligt detta JSON-format:

{

"deepl": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När detta är konfigurerat kan AI-agenten nu utnyttja denna MCP som ett verktyg med tillgång till alla dess funktioner och möjligheter. Kom ihåg att ändra “deepl” till det faktiska namnet på din MCP-server och byt ut URL:en mot din egen MCP-server-URL.

| Avsnitt | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | |

| Lista över promptar | ⛔ | |

| Lista över resurser | ⛔ | |

| Lista över verktyg | ✅ | |

| Skydda API-nycklar | ✅ | Använd "env" |

| Stöder sampling (mindre viktigt) | ⛔ |

Utifrån ovan är DeepL MCP-servern fokuserad och produktionsklar för översättningsuppgifter, men saknar dokumenterade promptmallar och resurser samt har begränsade installationsguider för andra plattformar än Claude. Den täcker viktiga säkerhetsaspekter med hantering av API-nycklar och erbjuder ett robust utbud av översättningsverktyg.

Denna MCP-server får ganska höga poäng vad gäller nytta och verklig användbarhet tack vare sina robusta översättningsverktyg och enkla Claude-integration, men tappar poäng för brist på dokumentation kring resurser och promptar samt begränsad plattformsstöd.

| Har LICENSE | ✅ (MIT) |

|---|---|

| Har minst ett verktyg | ✅ |

| Antal forks | 5 |

| Antal stjärnor | 19 |

DeepL MCP-servern är en mellanlag som tillför DeepL:s avancerade översättning, omformulering och språkdetektering till AI-assistenter. Den fungerar som en brygga mellan dina AI-arbetsflöden och DeepL:s API, med stöd för realtidskommunikation på flera språk och tonjusteringar.

Den erbjuder verktyg för att hämta tillgängliga käll- och målspråk, översätta text och omformulera innehåll — vilket gör det möjligt för AI-agenter att programmässigt hantera en mängd olika språkuppgifter.

Använd fältet `env` i din MCP-serverkonfiguration för att lagra din API-nyckel. Detta håller känsliga data utanför din kodbas och säkerställer säker åtkomsthantering.

Ja! Lägg till MCP-komponenten i ditt FlowHunt-flöde, ange din DeepL MCP-serverkonfiguration, så får din AI-agent direkt tillgång till översättning, omformulering och språkdetekteringsfunktioner.

Ja, DeepL:s API och MCP-servern stöder justering av formalitet, så att du kan anpassa översättningar för professionella eller vardagliga användningsområden.

Detaljerade installationsinstruktioner finns för Claude Desktop. Andra plattformar som Cursor och Cline är inte uttryckligen dokumenterade, men MCP-servern är kompatibel om den konfigureras korrekt.

Ge din chatbot eller AI-arbetsflöde ett lyft med DeepL MCP-server för sömlös, realtidsöversättning, omformulering och språkdetektering – ingen manuell kodning krävs.

DeepSeek MCP-server integrerar DeepSeek's avancerade språkmodeller med MCP-kompatibla applikationer, och erbjuder säker, anonymiserad API-åtkomst samt möjliggör...

DeepSeek MCP-server fungerar som en säker proxy som kopplar DeepSeeks avancerade språkmodeller till MCP-kompatibla applikationer som Claude Desktop eller FlowHu...

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.