mcp-proxy MCP-server

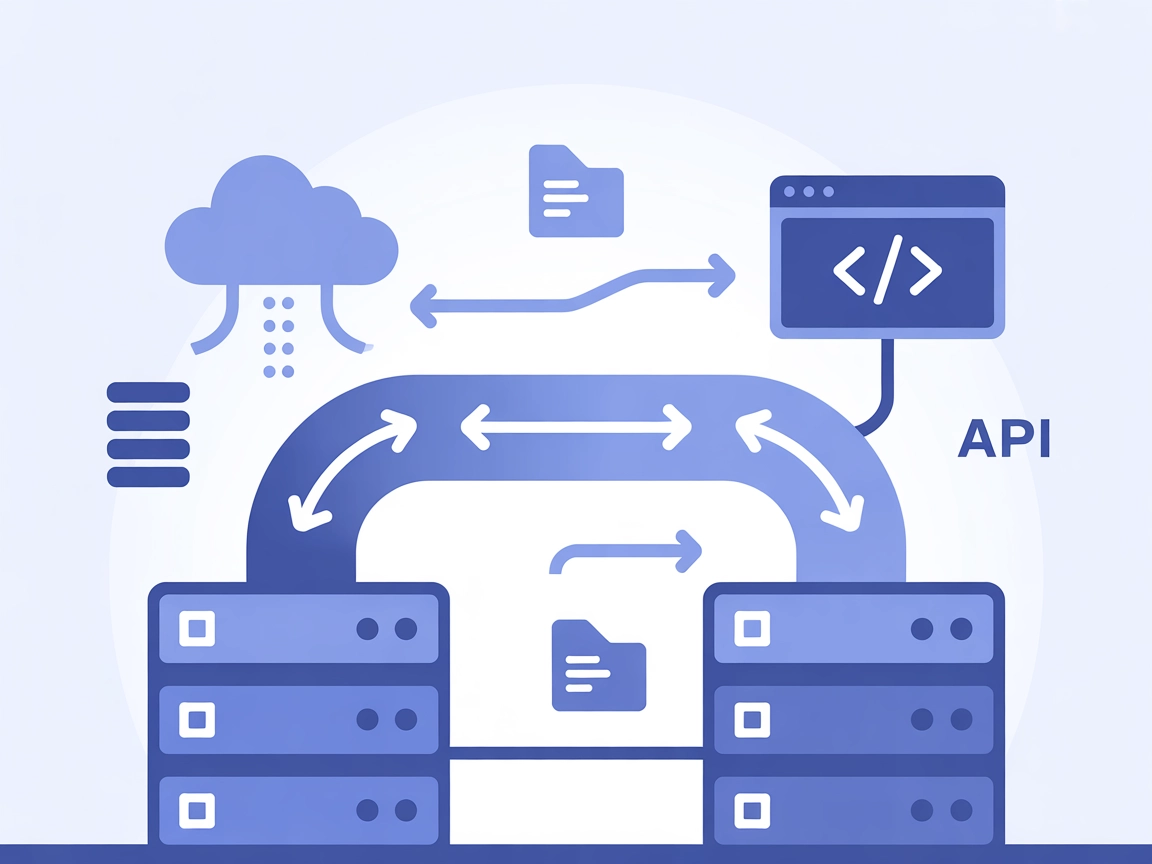

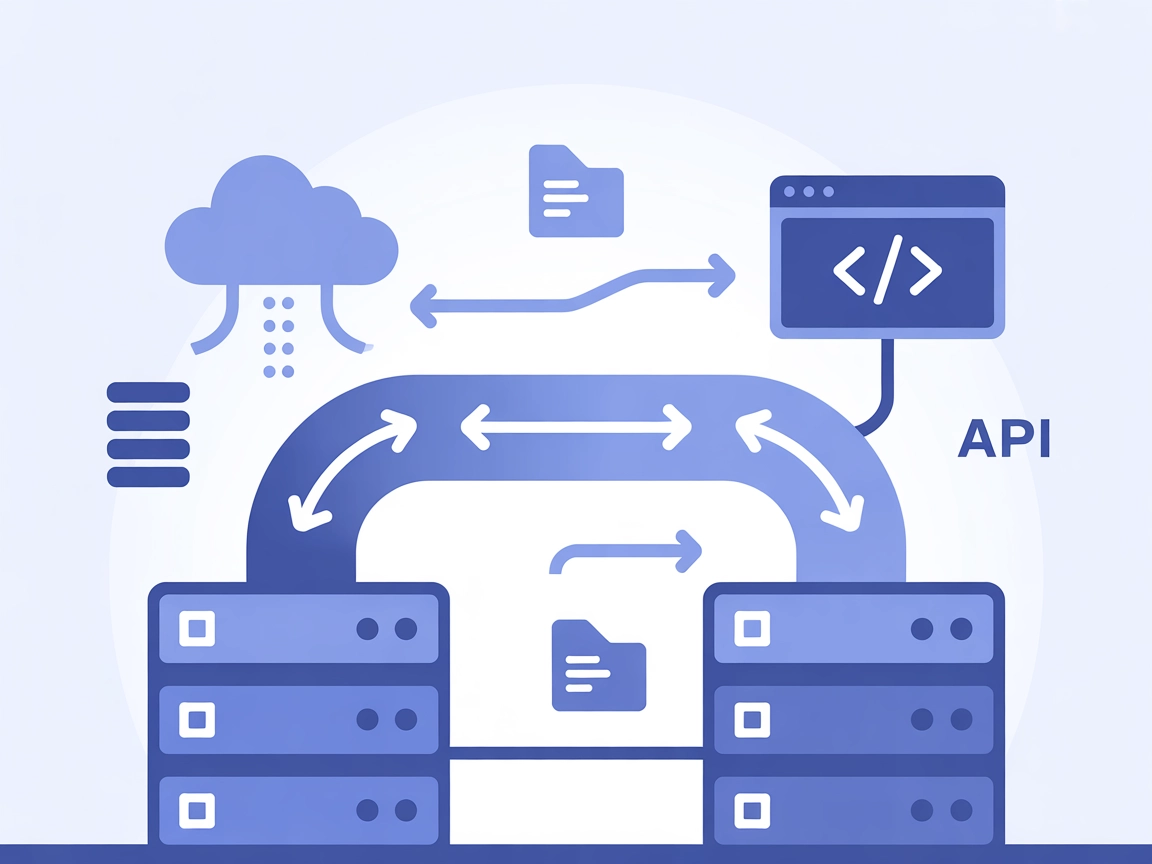

mcp-proxy MCP-servern överbryggar Streamable HTTP och stdio MCP-transporter, vilket möjliggör sömlös integration mellan AI-assistenter och olika Model Context P...

Samla flera MCP-servrar till en enda, enhetlig slutpunkt för strömlinjeformade AI-arbetsflöden, med realtidsströmning och centraliserad konfiguration.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

MCP Proxy-servern är ett verktyg som samlar och tillhandahåller flera MCP (Model Context Protocol) resursservrar genom en enda HTTP-server. Genom att agera som proxy möjliggör den för AI-assistenter och klienter att ansluta till flera olika MCP-servrar samtidigt, och kombinerar deras verktyg, resurser och funktioner i ett enhetligt gränssnitt. Denna uppsättning förenklar integrationen, eftersom utvecklare och AI-arbetsflöden kan komma åt olika externa datakällor, API:er eller tjänster via en enda slutpunkt. MCP Proxy-servern stödjer realtidsuppdateringar via SSE (Server-Sent Events) eller HTTP-streaming och är mycket konfigurerbar, vilket gör det enklare att utföra komplexa uppgifter som databasfrågor, filhantering eller API-interaktioner genom att routa dessa till rätt underliggande MCP-servrar.

Ingen information om promptmallar finns i arkivet eller dokumentationen.

Inga explicita resurser dokumenterade i arkivet eller exempelkonfigurationen. Servern samlar resurser från anslutna MCP-servrar, men inga listas direkt.

Inga verktyg tillhandahålls direkt av MCP Proxy-servern själv; den fungerar som proxy till verktyg från andra konfigurerade MCP-servrar (t.ex. github, fetch, amap enligt konfigurationsexemplet).

mcpServers."mcpServers": {

"mcp-proxy": {

"command": "npx",

"args": ["@TBXark/mcp-proxy@latest"],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "<YOUR_TOKEN>"

}

}

}

Obs: Säkra dina API-nycklar med miljövariabler enligt ovan.

mcpServers:"mcpServers": {

"mcp-proxy": {

"command": "npx",

"args": ["@TBXark/mcp-proxy@latest"],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "<YOUR_TOKEN>"

}

}

}

Obs: Använd miljövariabler för hemliga tokens.

"mcpServers": {

"mcp-proxy": {

"command": "npx",

"args": ["@TBXark/mcp-proxy@latest"],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "<YOUR_TOKEN>"

}

}

}

Obs: Använd miljövariabler för känsliga inloggningsuppgifter.

"mcpServers": {

"mcp-proxy": {

"command": "npx",

"args": ["@TBXark/mcp-proxy@latest"],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "<YOUR_TOKEN>"

}

}

}

Obs: Säkra API-nycklar med egenskapen env som i exemplet ovan.

"mcpServers": {

"github": {

"command": "npx",

"args": ["-y", "@modelcontextprotocol/server-github"],

"env": {

"GITHUB_PERSONAL_ACCESS_TOKEN": "<YOUR_TOKEN>"

}

}

}

Använd MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I avsnittet för systemets MCP-konfiguration lägger du in dina MCP-serverdetaljer med detta JSON-format:

{

"mcp-proxy": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med åtkomst till alla dess funktioner och möjligheter. Kom ihåg att byta ut “mcp-proxy” mot det faktiska namnet på din MCP-server och ersätt URL:en med din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Kommentarer |

|---|---|---|

| Översikt | ✅ | |

| Lista över Promptar | ⛔ | Inga promptmallar dokumenterade i arkivet. |

| Lista över Resurser | ⛔ | Inga explicita resursdefinitioner; samlar från andra MCP-servrar. |

| Lista över Verktyg | ⛔ | Inga direkta verktyg; proxyar verktyg från konfigurerade servrar. |

| Säkra API-nycklar | ✅ | Konfigurationen stödjer env för hemligheter. |

| Samplingsstöd (mindre viktigt vid utvärdering) | ⛔ | Ej nämnt i tillgänglig dokumentation. |

Utifrån ovanstående är MCP Proxy ett användbart aggregeringslager för MCP-resurser men saknar egna verktyg, resurser eller promptmallar; det är främst en konfigurations- och routningslösning.

Denna MCP-server är bäst klassad som ett backend-verktyg, inte lämpad för fristående användning men utmärkt för att samla och hantera flera MCP-servrar i ett enhetligt arbetsflöde. Dokumentationen är tydlig för konfiguration och säkerhet, men saknar detaljer kring promptar, verktyg och resurser. Sammantaget är det en stabil infrastrukturdel för avancerade användare. Betyg: 5/10.

| Har en LICENS | ✅ (MIT) |

|---|---|

| Har åtminstone ett verktyg | ⛔ (Endast proxy, inga verktyg) |

| Antal forkar | 43 |

| Antal stjärnor | 315 |

MCP Proxy-servern är ett backend-verktyg som samlar flera MCP (Model Context Protocol) resursservrar i en enda HTTP-server. Det möjliggör för AI-assistenter och utvecklare att få tillgång till verktyg, API:er och datakällor från flera MCP-servrar via en enhetlig slutpunkt, vilket förenklar integration och hantering.

Viktiga användningsområden inkluderar: att samla flera MCP-servrar för förenklad åtkomst, fungera som en enhetlig API-gateway för olika datakällor, stöd för realtidsdata via SSE/HTTP, möjliggöra flexibel klientintegration och centralisera autentisering och loggning för ökad säkerhet.

Nej, MCP Proxy-servern tillhandahåller inte direkt några verktyg eller resurser. Istället proxyar och samlar den verktyg och resurser från de MCP-servrar som är konfigurerade i din miljö.

Använd alltid miljövariabler (egenskapen `env` i din konfiguration) för att lagra hemligheter som API-tokens, enligt exempelkonfigurationen för varje klient. Detta säkerställer att dina uppgifter förblir säkra och inte exponeras i konfigurationsfiler.

Lägg till en MCP-komponent i ditt flöde, och i systemets MCP-konfiguration lägger du in detaljer för din MCP Proxy-server i JSON-format. Detta gör att din AI-agent får åtkomst till alla samlade verktyg och resurser via en enda slutpunkt. Kom ihåg att uppdatera servernamn och URL för din miljö.

Enhetliggör dina AI- och automationsarbetsflöden genom att koppla ihop flera MCP-servrar via kraftfulla MCP Proxy. Förenkla din integration idag.

mcp-proxy MCP-servern överbryggar Streamable HTTP och stdio MCP-transporter, vilket möjliggör sömlös integration mellan AI-assistenter och olika Model Context P...

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

Prefect MCP-servern fungerar som en brygga mellan AI-assistenter och plattformen Prefect för arbetsflödesorkestrering, vilket möjliggör hantering av flöden, dri...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.