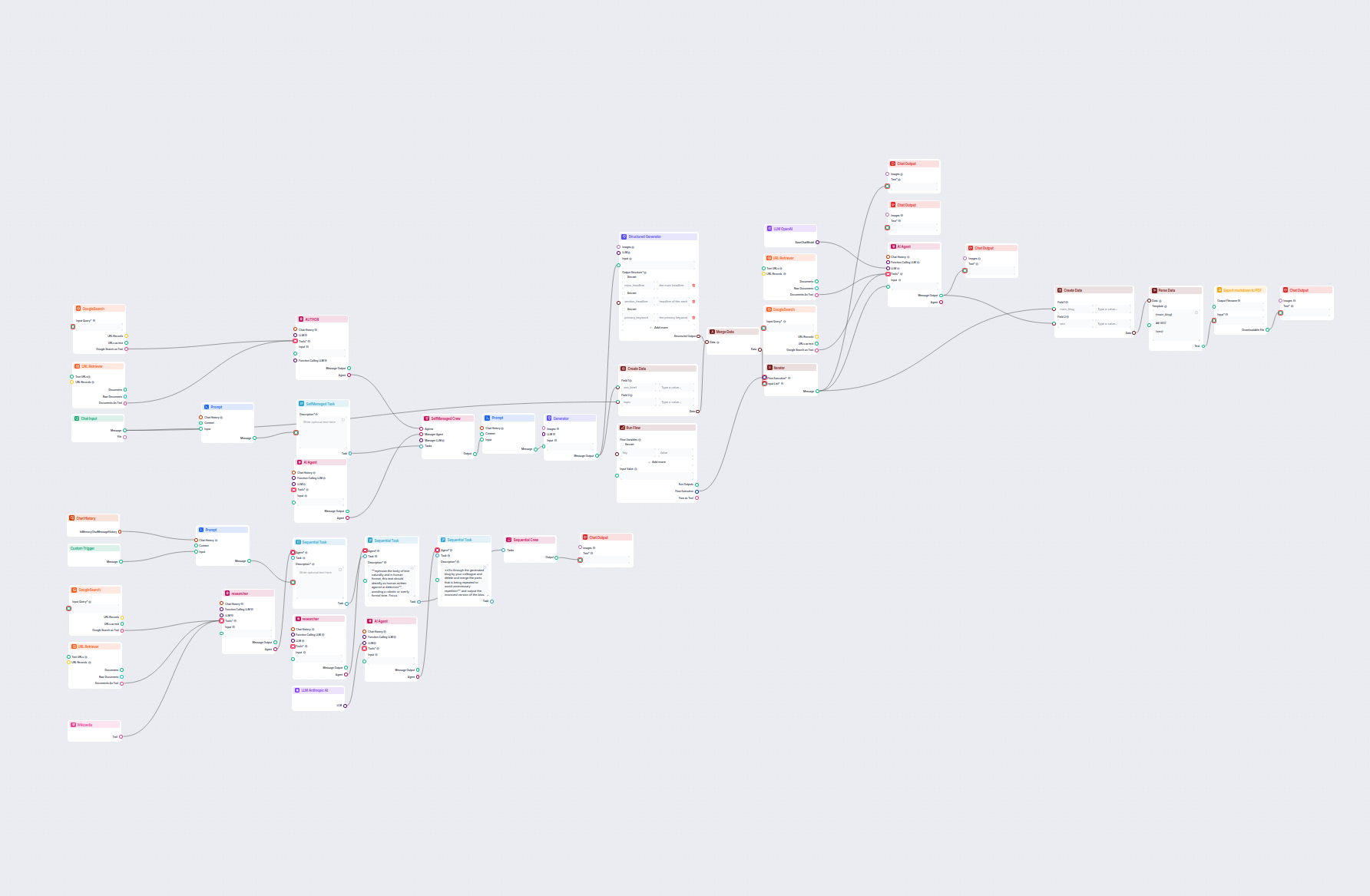

Absatzgenerator für verwandte Artikel

Erzeugt automatisch einen kurzen, ansprechenden Absatz für Ihre Website, der Links zu den relevantesten verwandten Artikeln enthält. Dieser KI-gestützte Workflo...

Komponentenbeschreibung

Without a good prompt, all bots would act the same way and often miss the mark with their answers. Prompts give instructions and context to the language model, helping it to understand what kind of text it should produce.

The Prompt component is designed to generate flexible prompt templates for use in AI workflows, allowing dynamic insertion of variables and context. This component is particularly useful in conversational AI scenarios, such as chatbots or virtual assistants, where creating adaptable and context-aware prompts is essential.

The Prompt component creates a prompt template that can incorporate various dynamic variables, such as user input, chat history, system instructions, and context messages. By leveraging these variables, the component helps you structure rich and context-sensitive prompts that enhance the performance and relevance of downstream AI models or agents.

{input}, {human_input}, {context}, {chat_history}, {system_message}, and {all_input_variables} directly into the prompt template.The following inputs can be provided to the Prompt component:

| Input Name | Type | Required | Description |

|---|---|---|---|

| Chat History | InMemoryChatMessageHistory | No | Previous conversation messages. Useful for maintaining context or generating alternative queries. |

| Context | Message | No | Additional context information to be included in the prompt. |

| Input | Message | No | The main user input or message. |

| System Message | String (multiline) | No | System-level instructions to guide the AI’s behavior. |

| Template | Prompt (multiline) | No | The actual template for the prompt, supporting dynamic variables for customization. |

| Output Name | Type | Description |

|---|---|---|

| Message | Message | The generated prompt, ready for use in downstream AI components. |

| Feature | Benefit |

|---|---|

| Dynamic variable injection | Context-aware, adaptable prompts |

| Support for chat history | Maintains continuity in multi-turn interactions |

| System message integration | Fine-tunes AI personality or instructions |

| Easy integration in workflows | Streamlines prompt creation for downstream AI |

This component is a foundational tool for anyone building sophisticated, context-sensitive AI workflows where prompt construction is key to achieving high-quality results.

This is an advanced optional setting. You can create prompt templates with specified variables to control the chat output fully. For example:

As a skilled SEO, analyze the content of the URL and come up with a title up to 65 characters long.— Content of the URL —{input}Task: Generate a Title similar to others using {human_input} query. Don’t change {human_input} in the new title. NEW TITLE:

The default prompt template looks like this:

You are an AI language model assistant.

Your task is to generate answer based on the input query.

If context is provided, use it to generate the answer to INPUT and HUMAN_INPUT query.

Format answer with markdown.

ANSWER IN LANGUAGE: {lang}

VARIABLES:

{"session_start_time": "2025-06-03 07:35:22", "current_page_url": "https://app.flowhunt.io/aistudio/flows/de6c2e2c-d817-4b2f-af2c-12dba3f46870?ws=74be5f74-d7c5-4076-839d-8ac1771a3b75"}

INPUT: {input}

ANSWER:

The default prompt copies the same structure as the component’s settings. You can override the settings by altering and using the variables in the template field. Creating your own templates gives you greater control over the output.

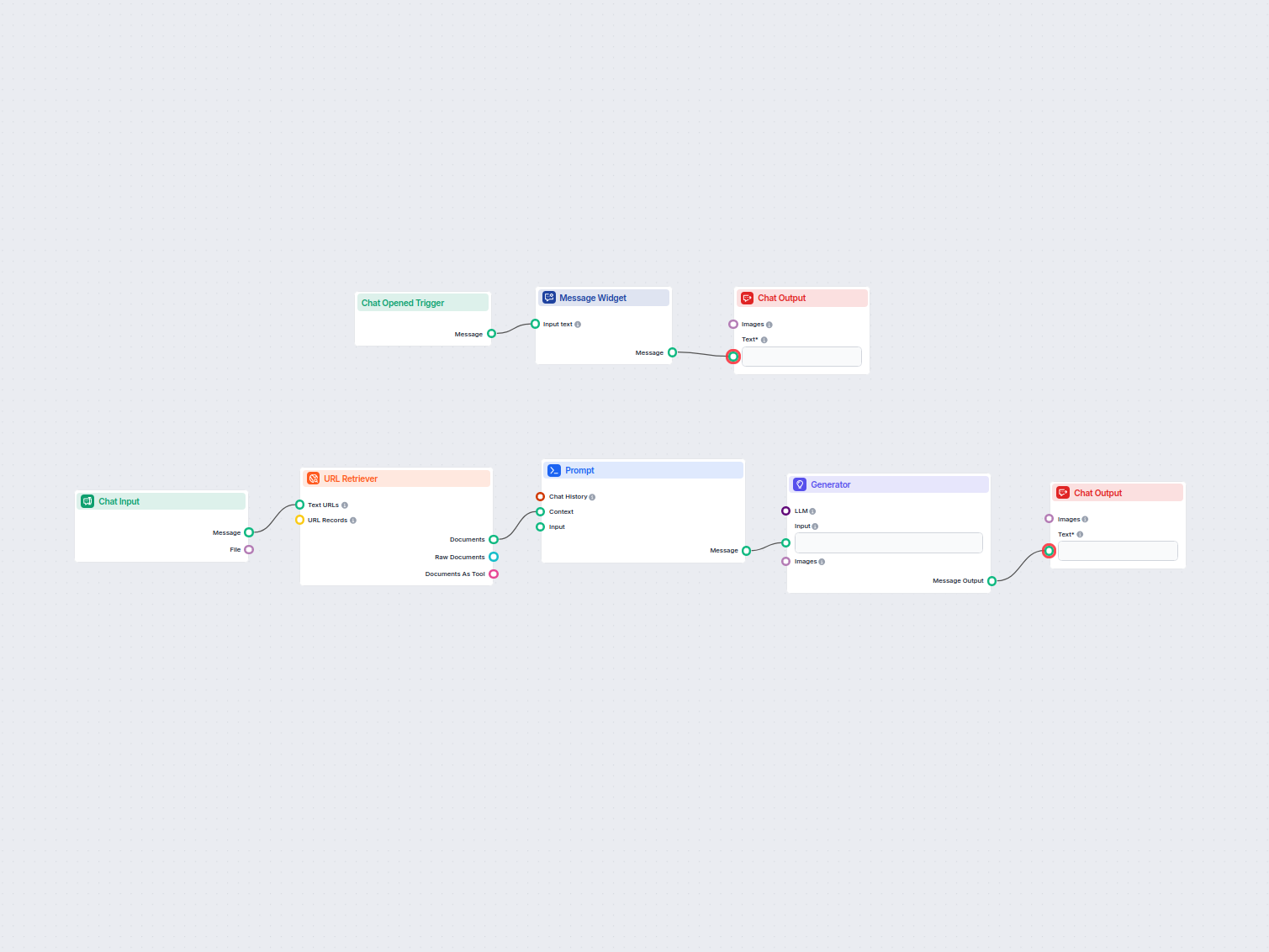

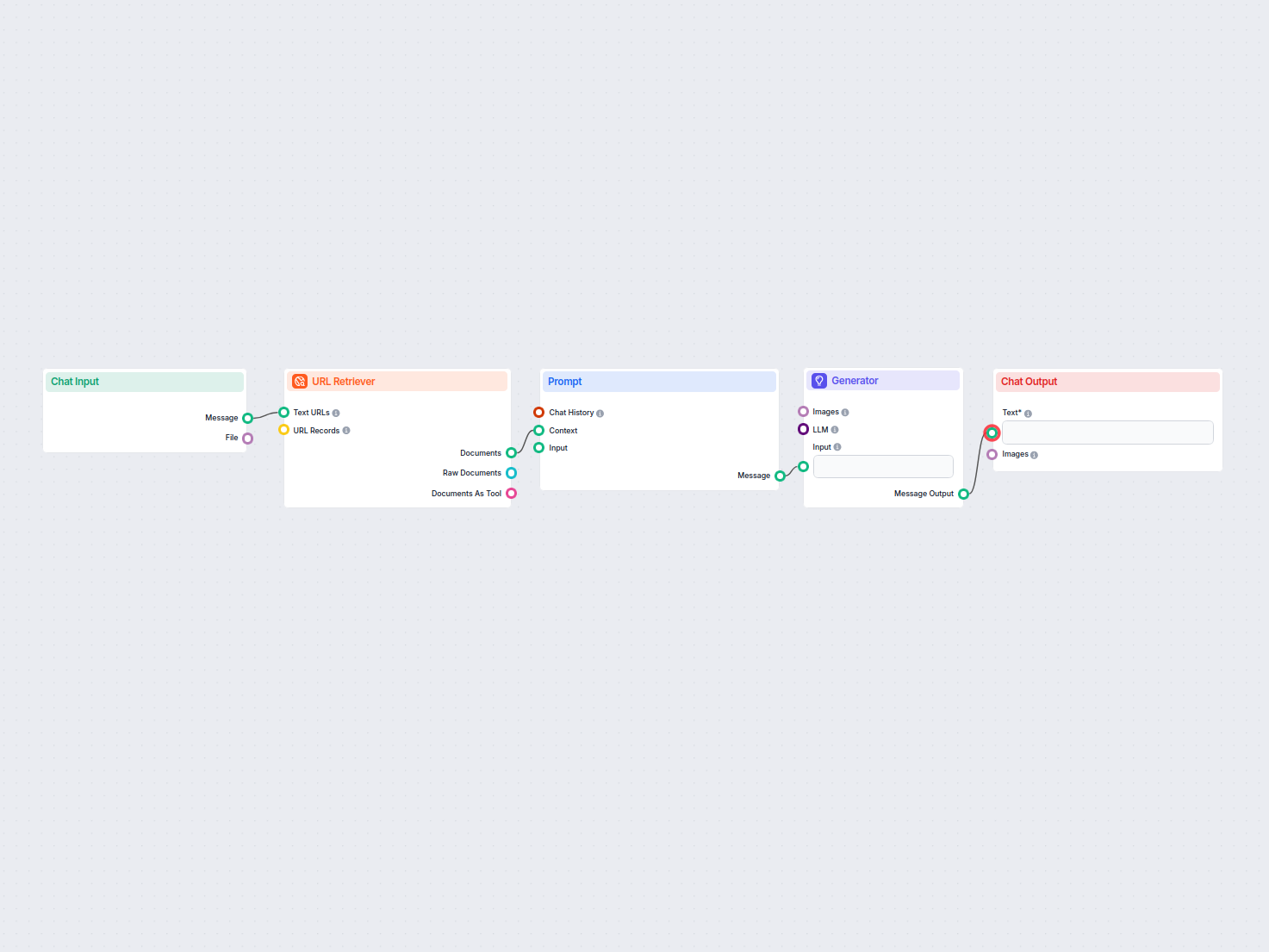

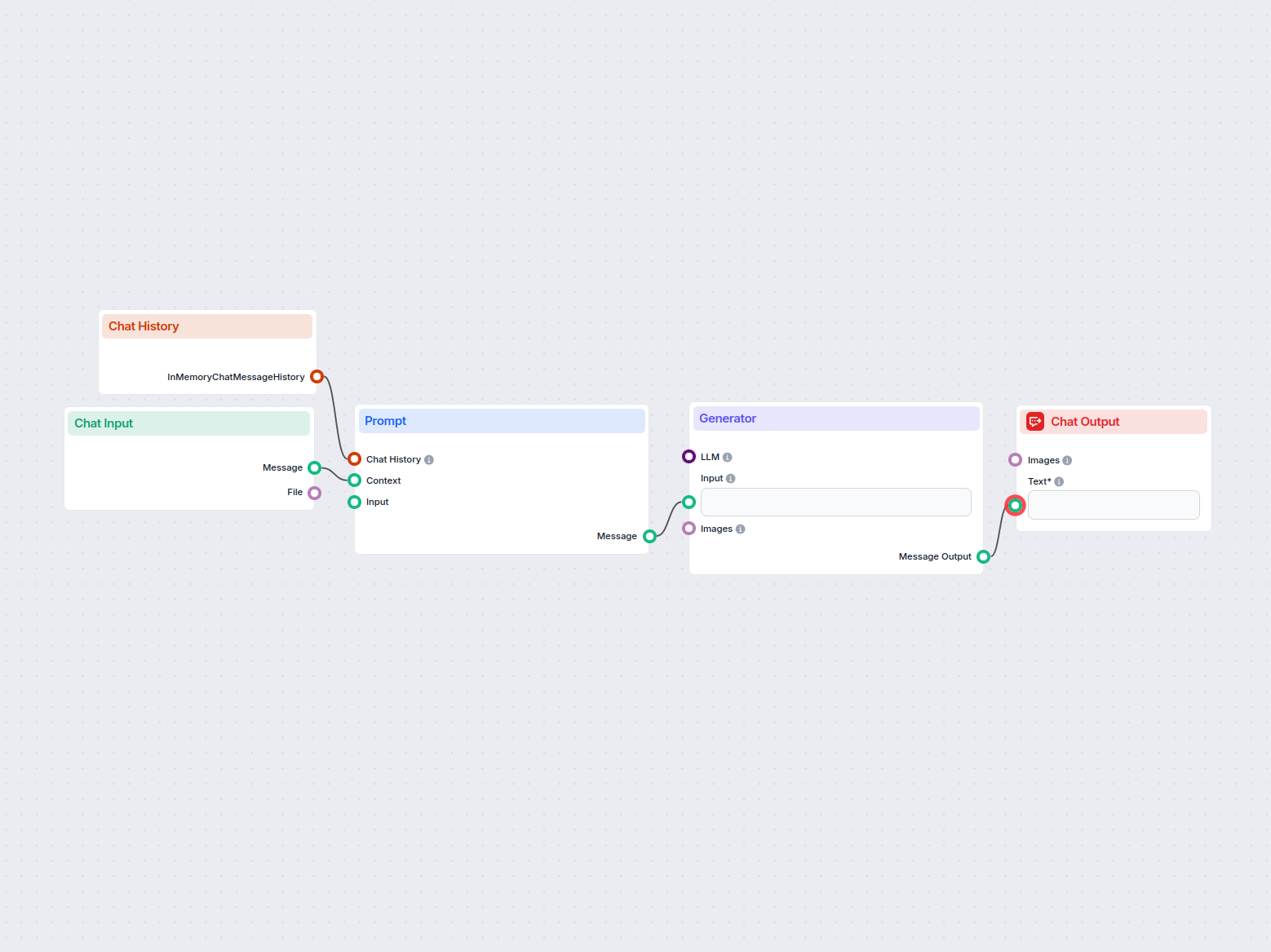

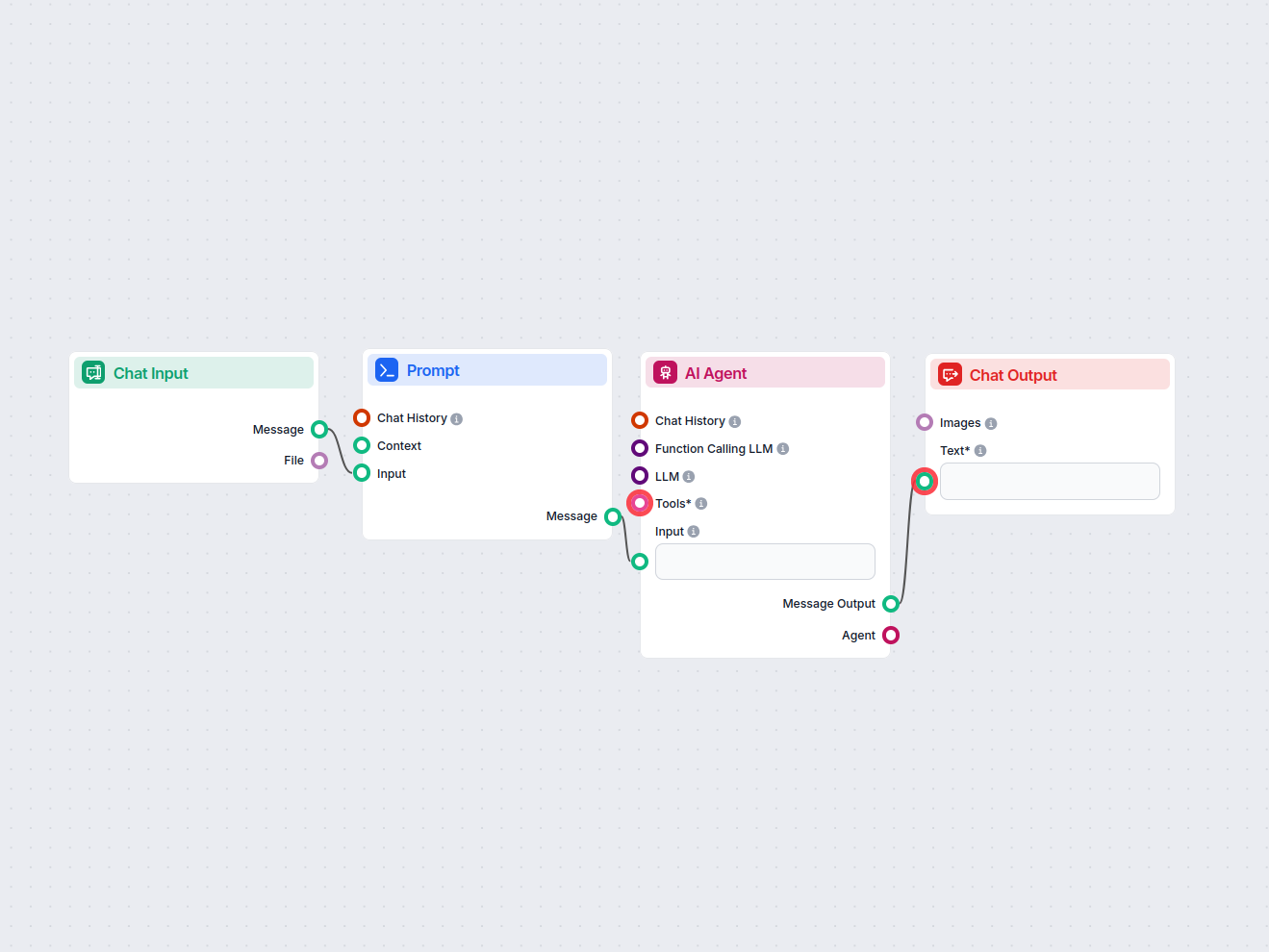

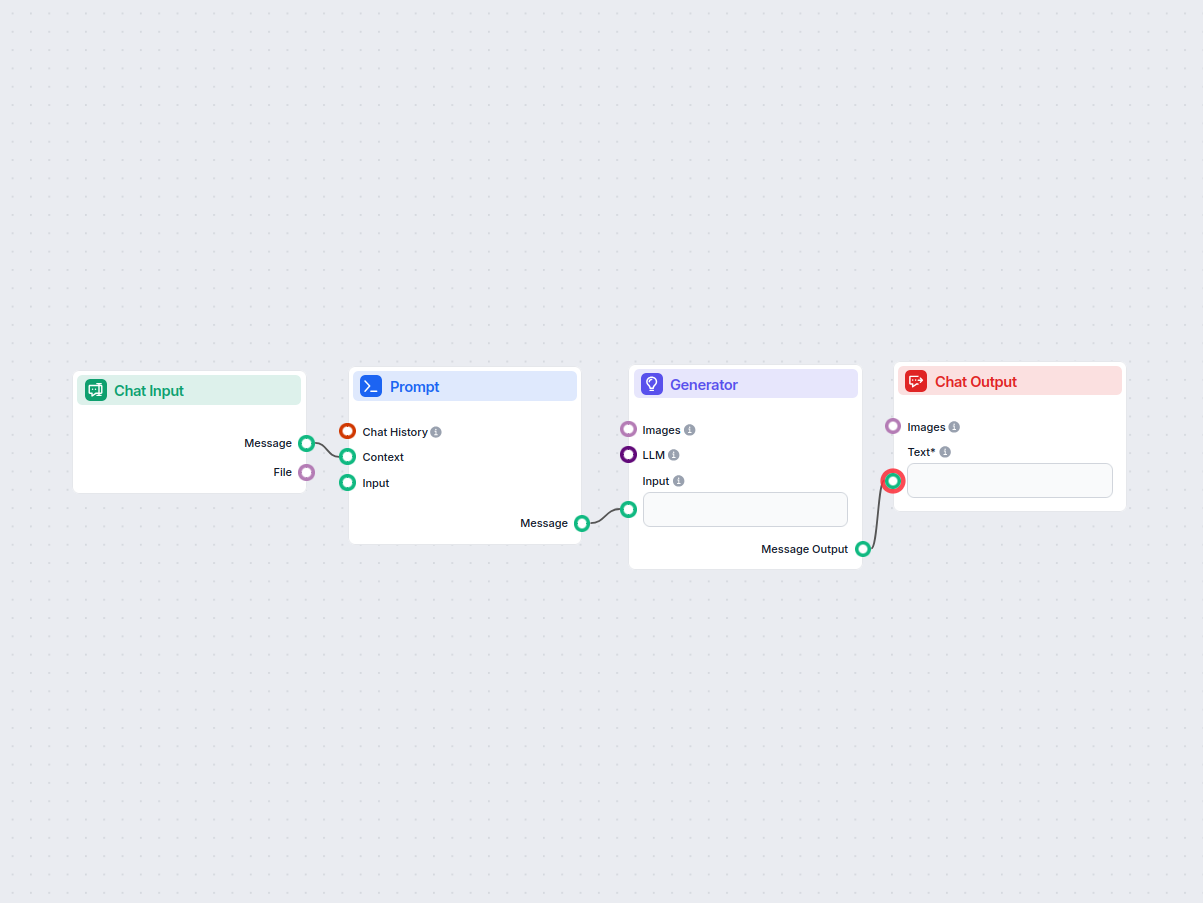

The prompt is an optional component that further modifies and specifies the final output. It needs several components to be connected:

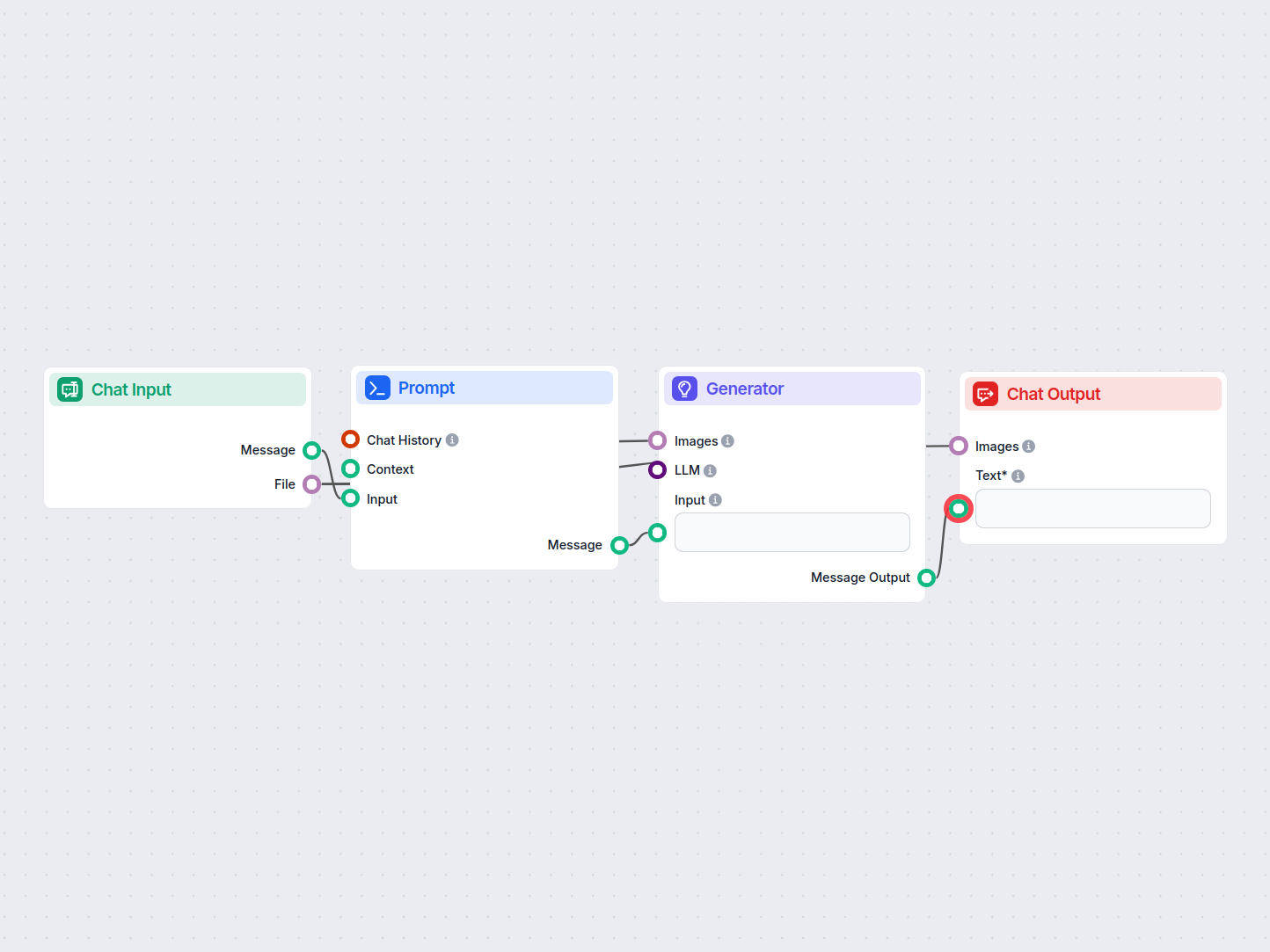

This component’s output is text that can be connected to various components. Most of the time, you immediately follow up with the Generator component to connect the prompt to an LLM.

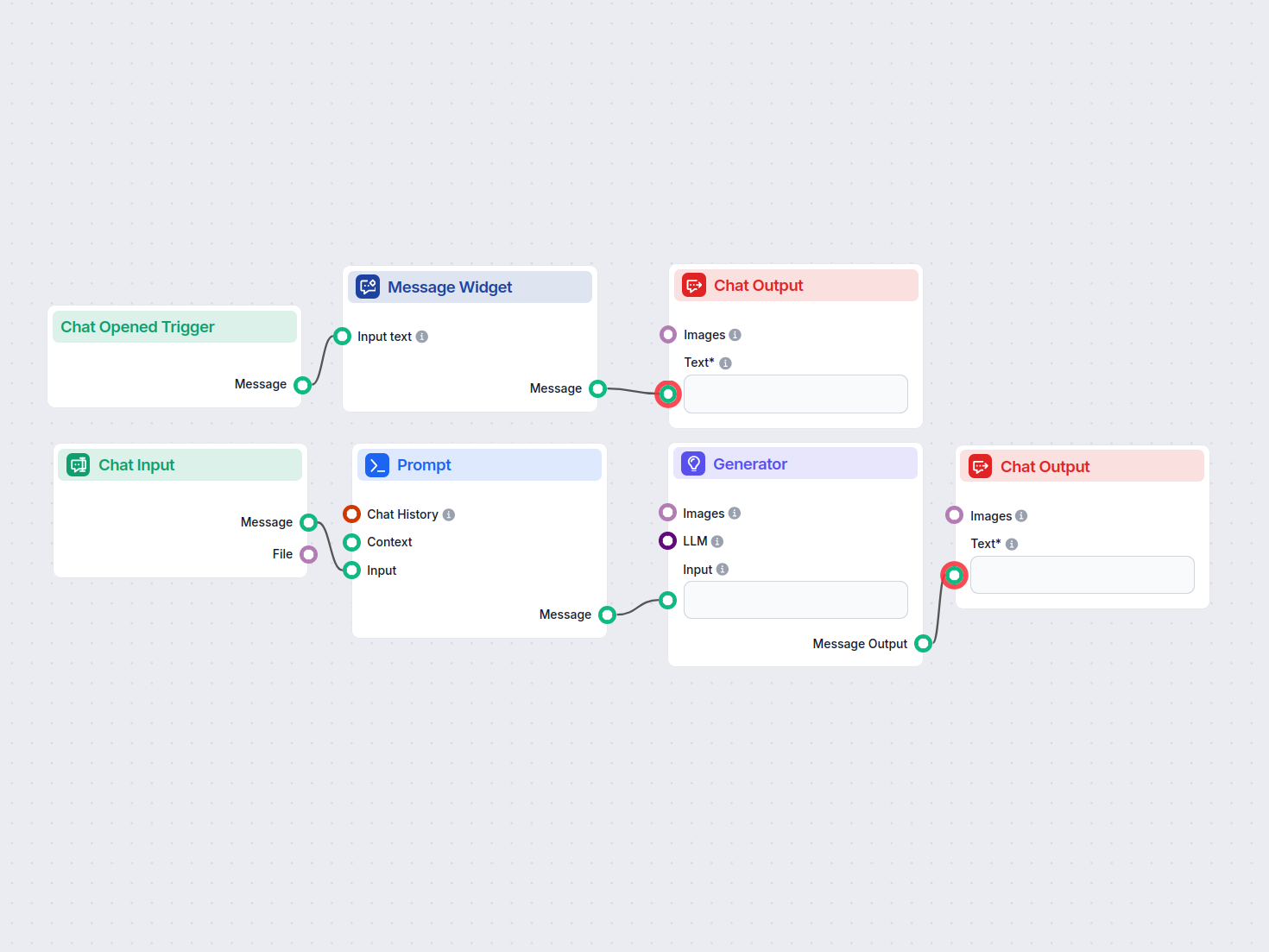

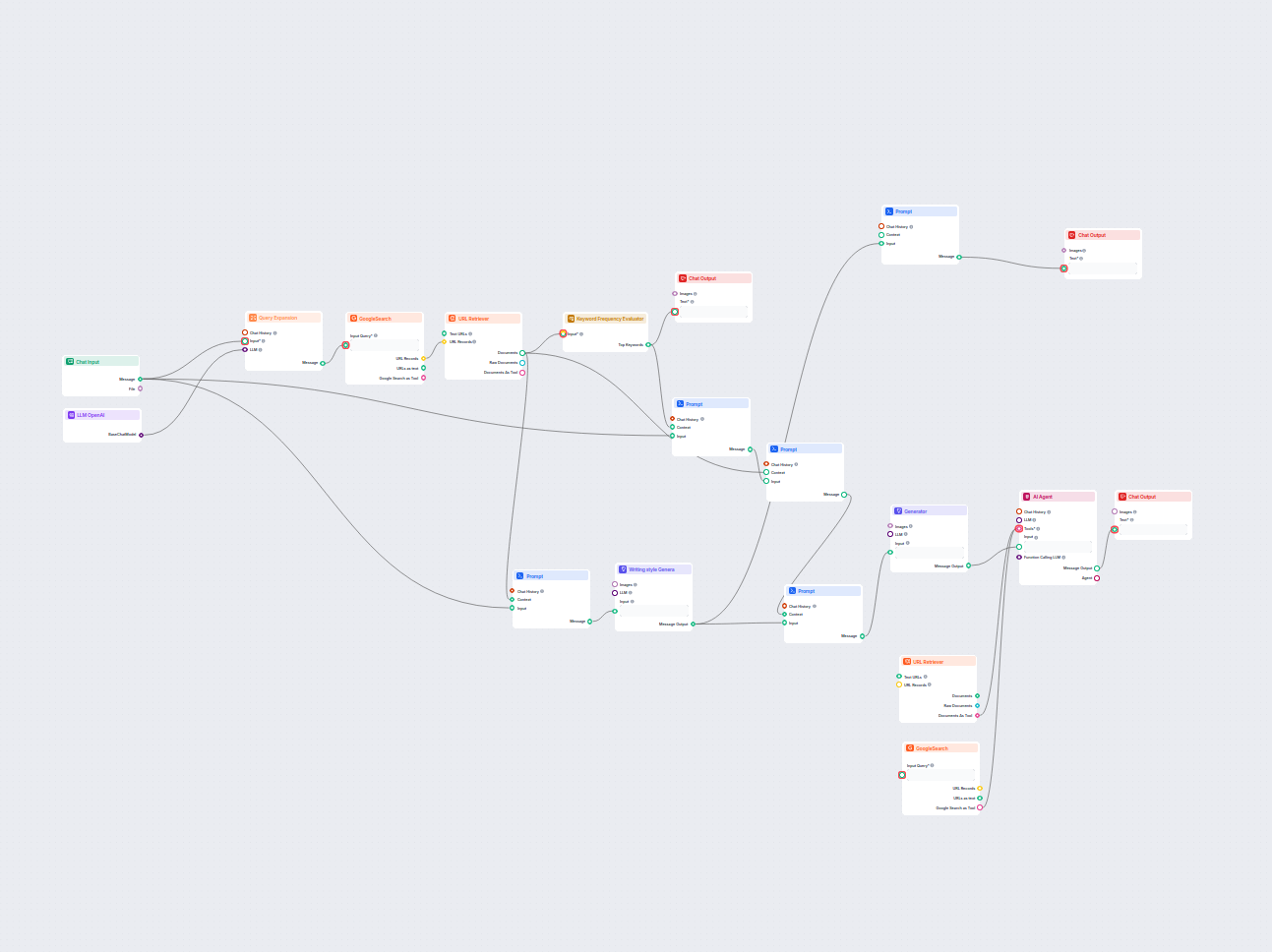

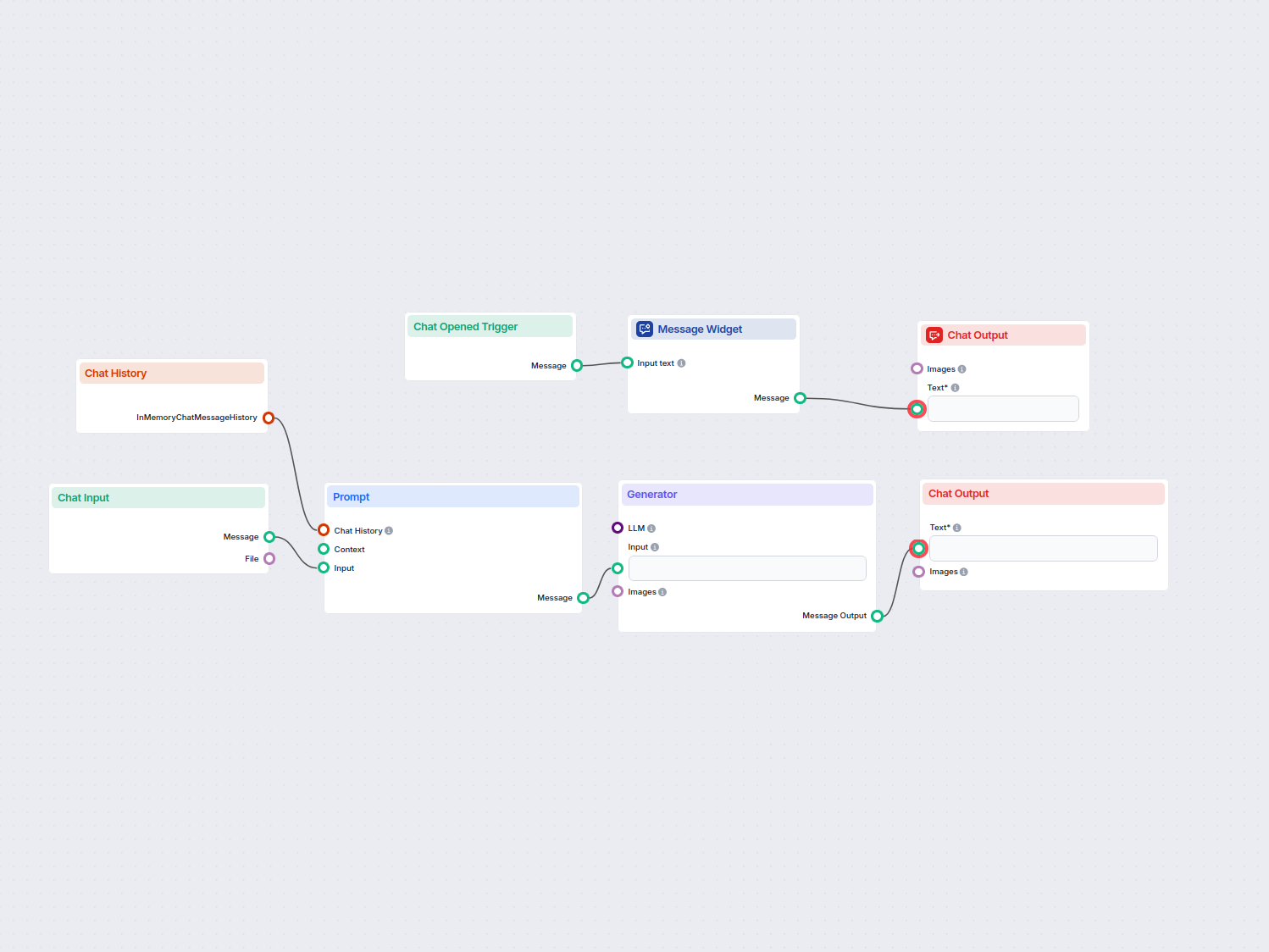

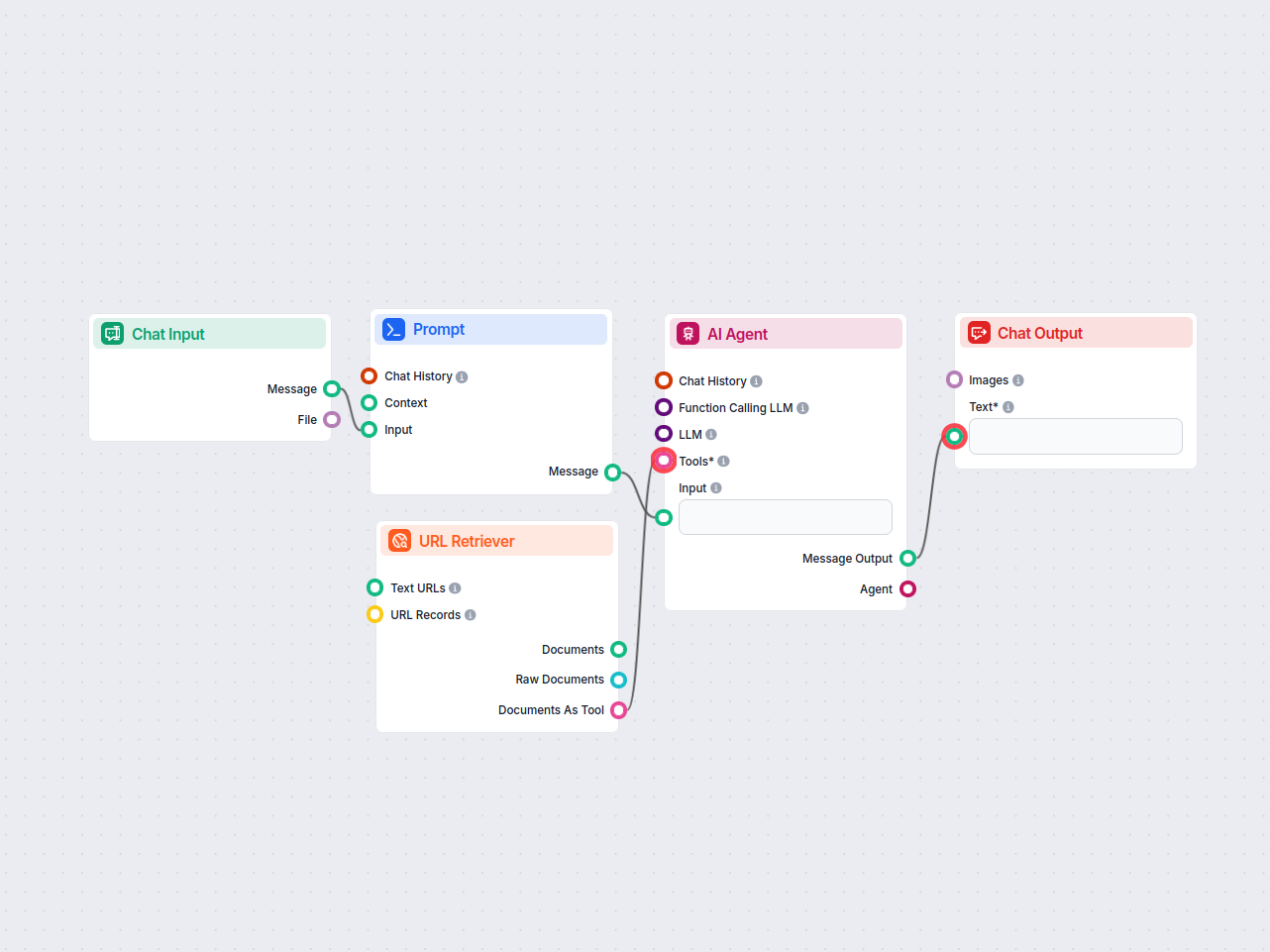

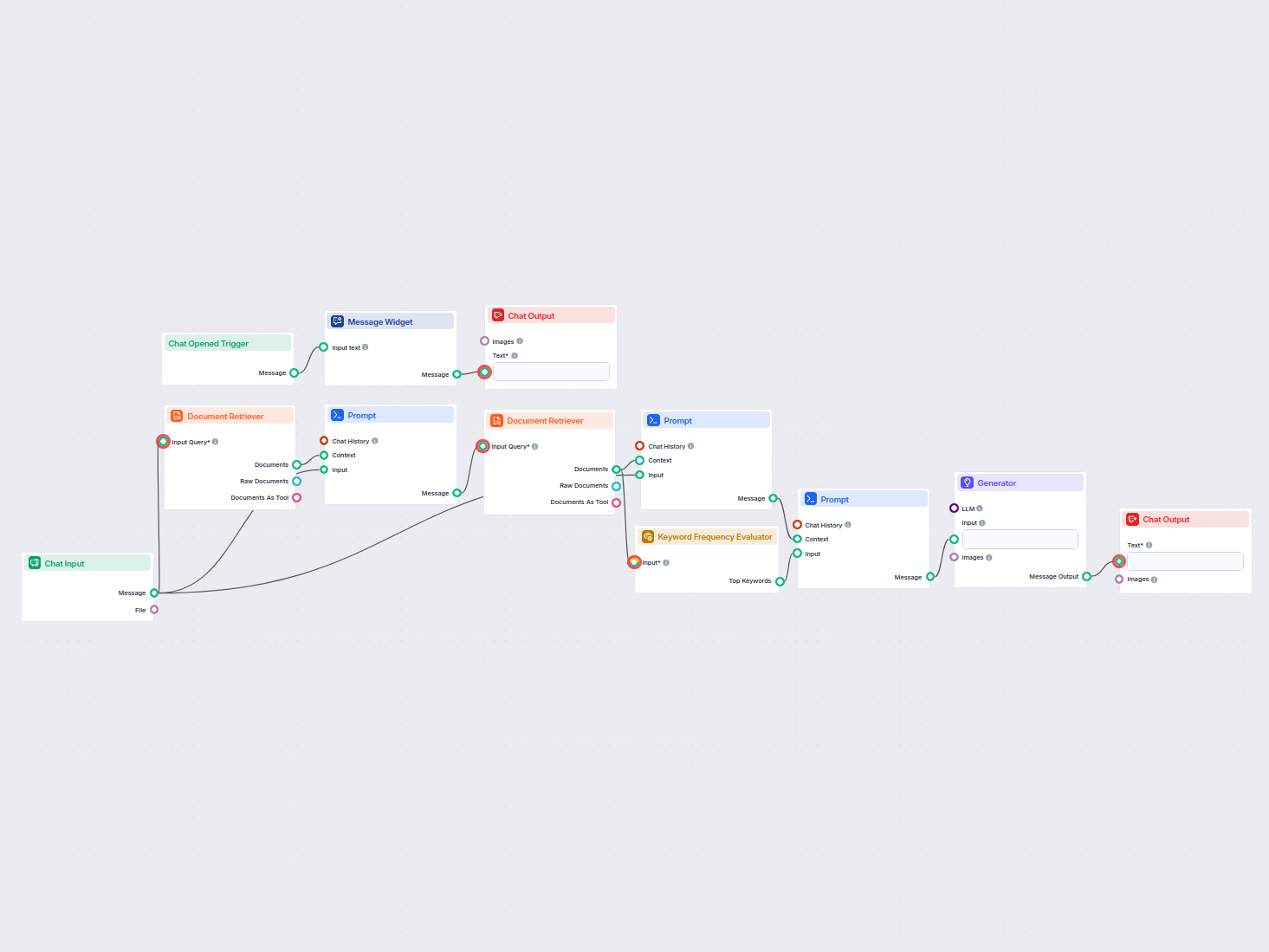

Let’s create a very simple bot. We’ll expand on the medieval knight bot example from earlier. While it talks funny, its main mission is to be a helpful customer service bot, and we want it to provide relevant information.

Let’s ask our bot a typical customer service question. We’ll ask about the pricing of URLsLab. To get a successful answer, we need to:

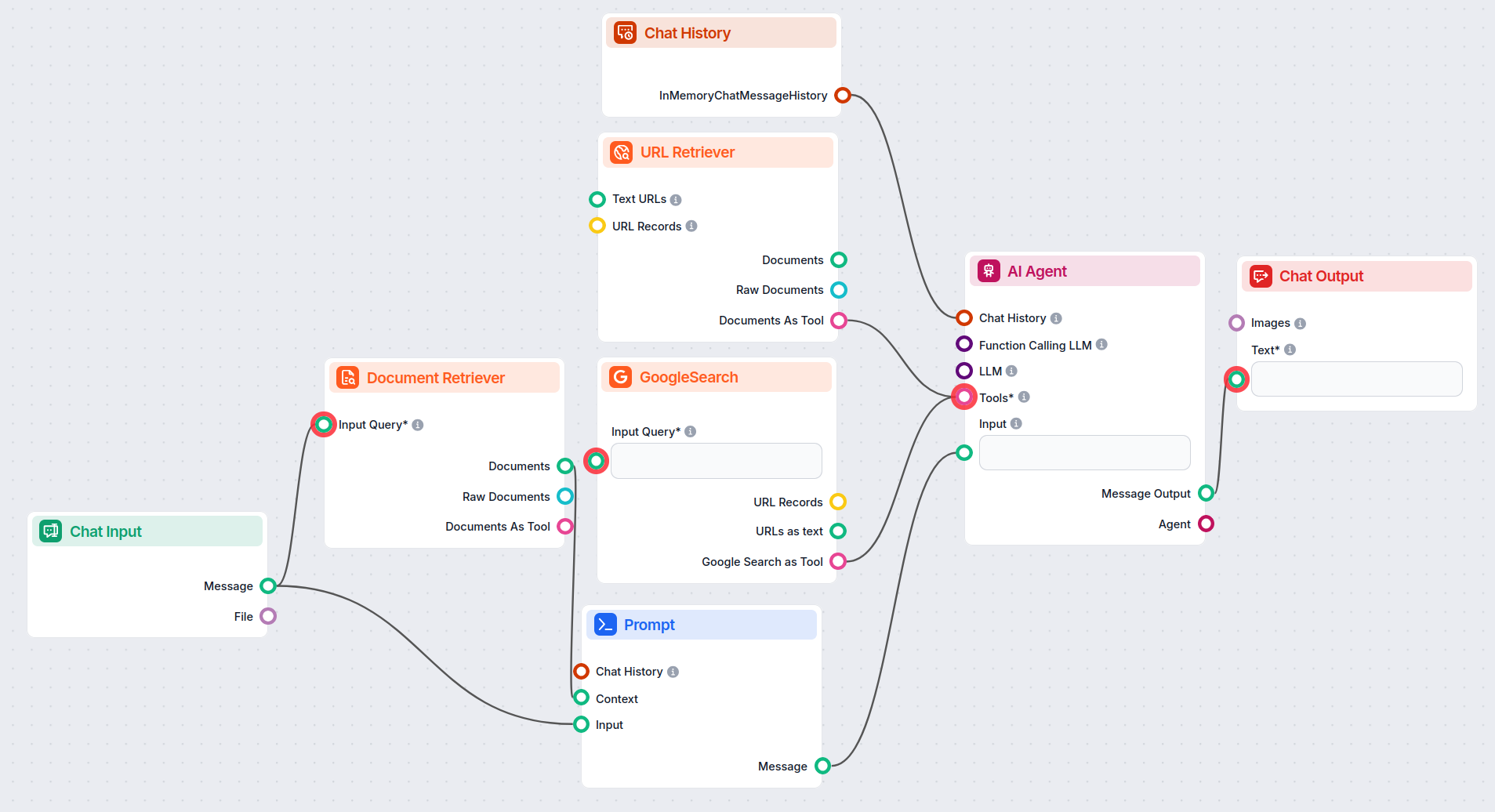

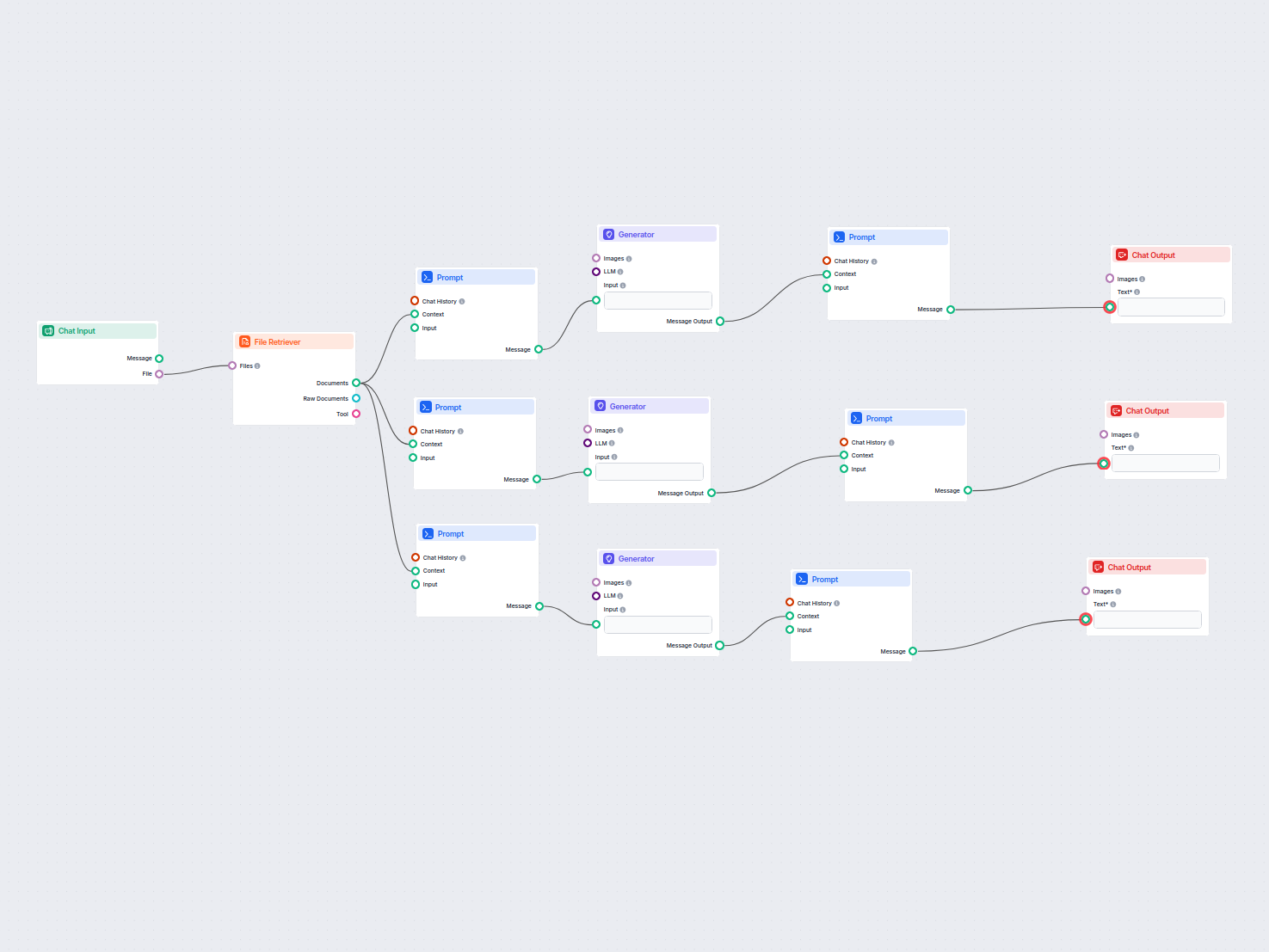

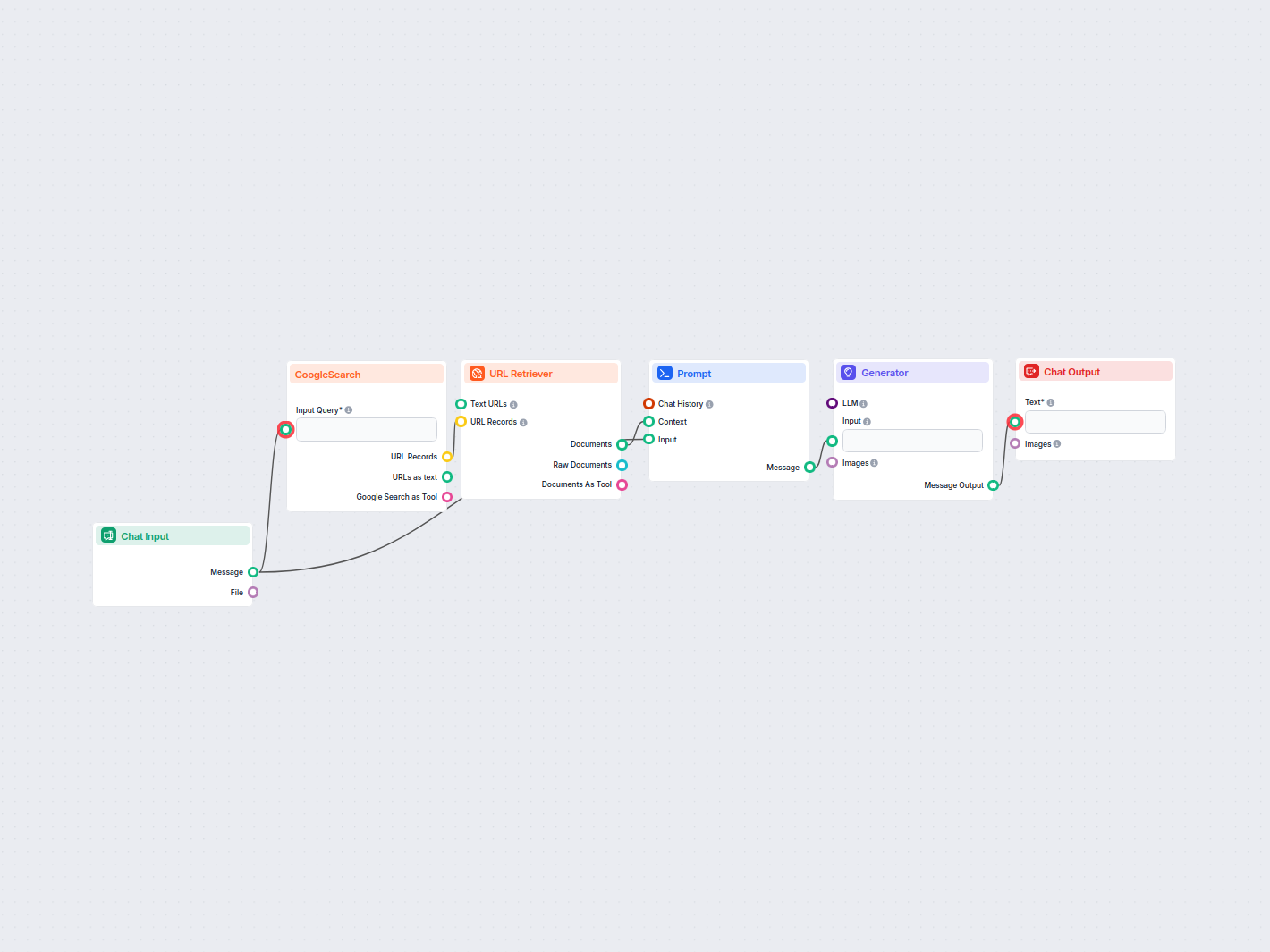

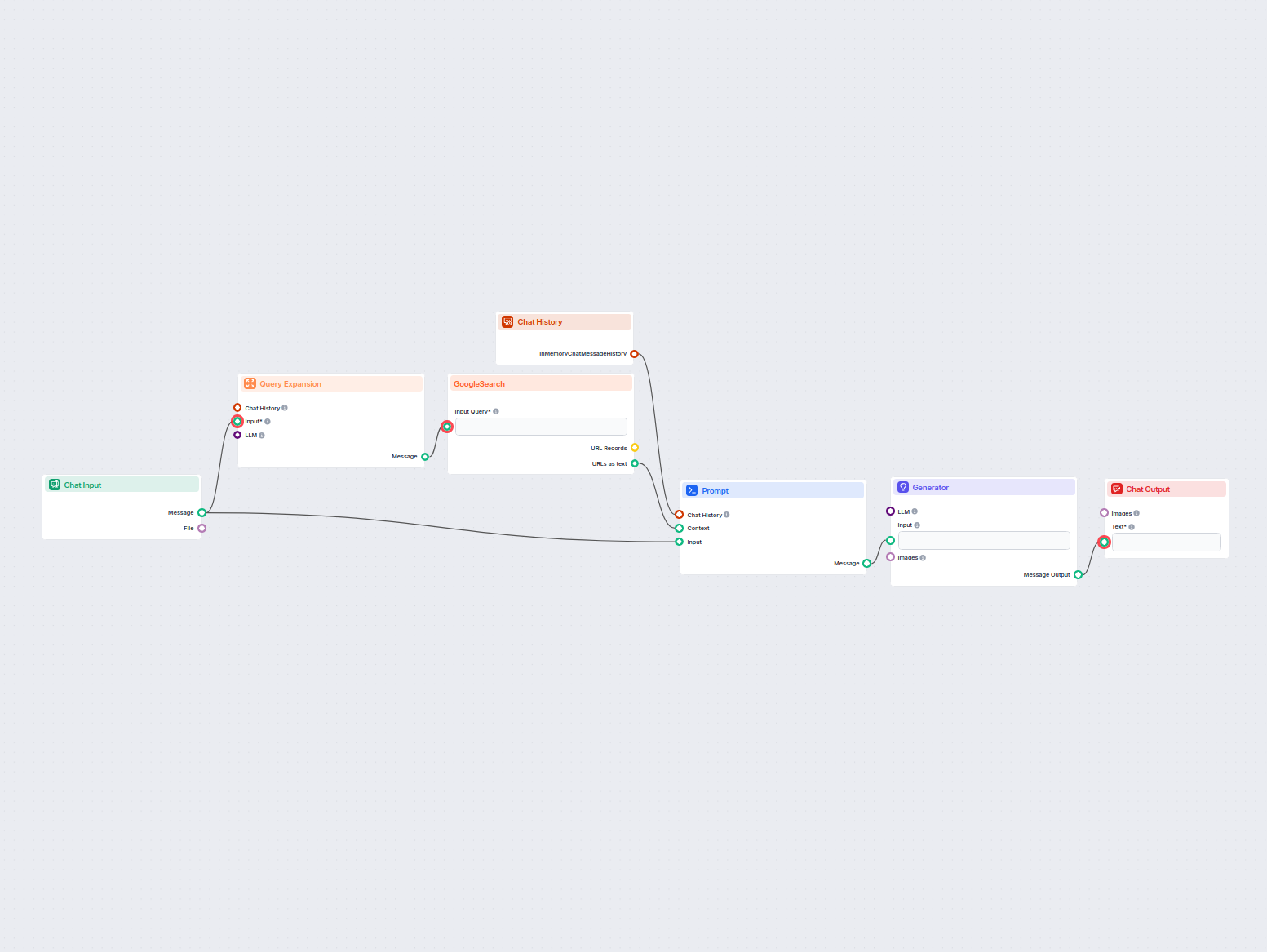

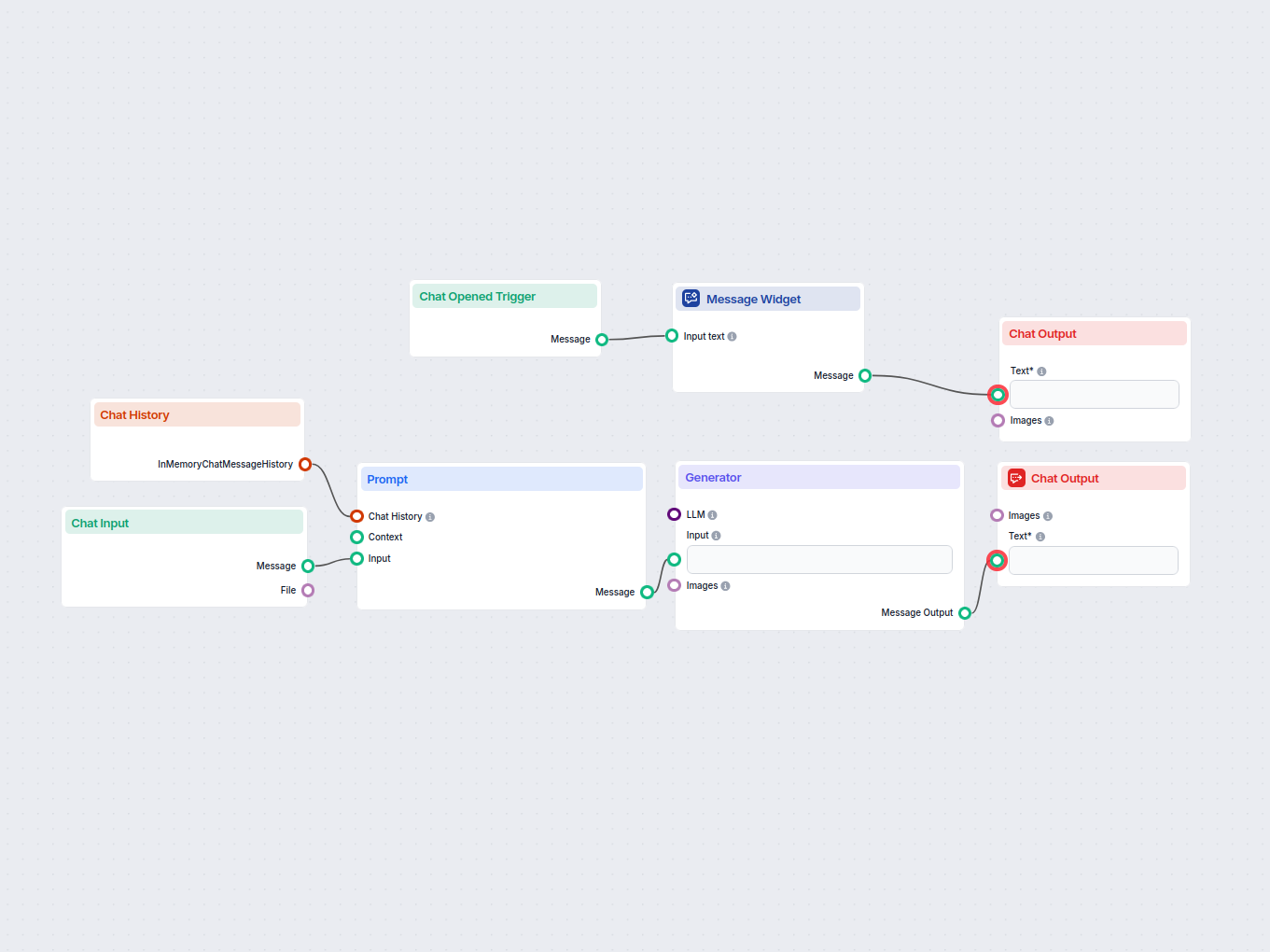

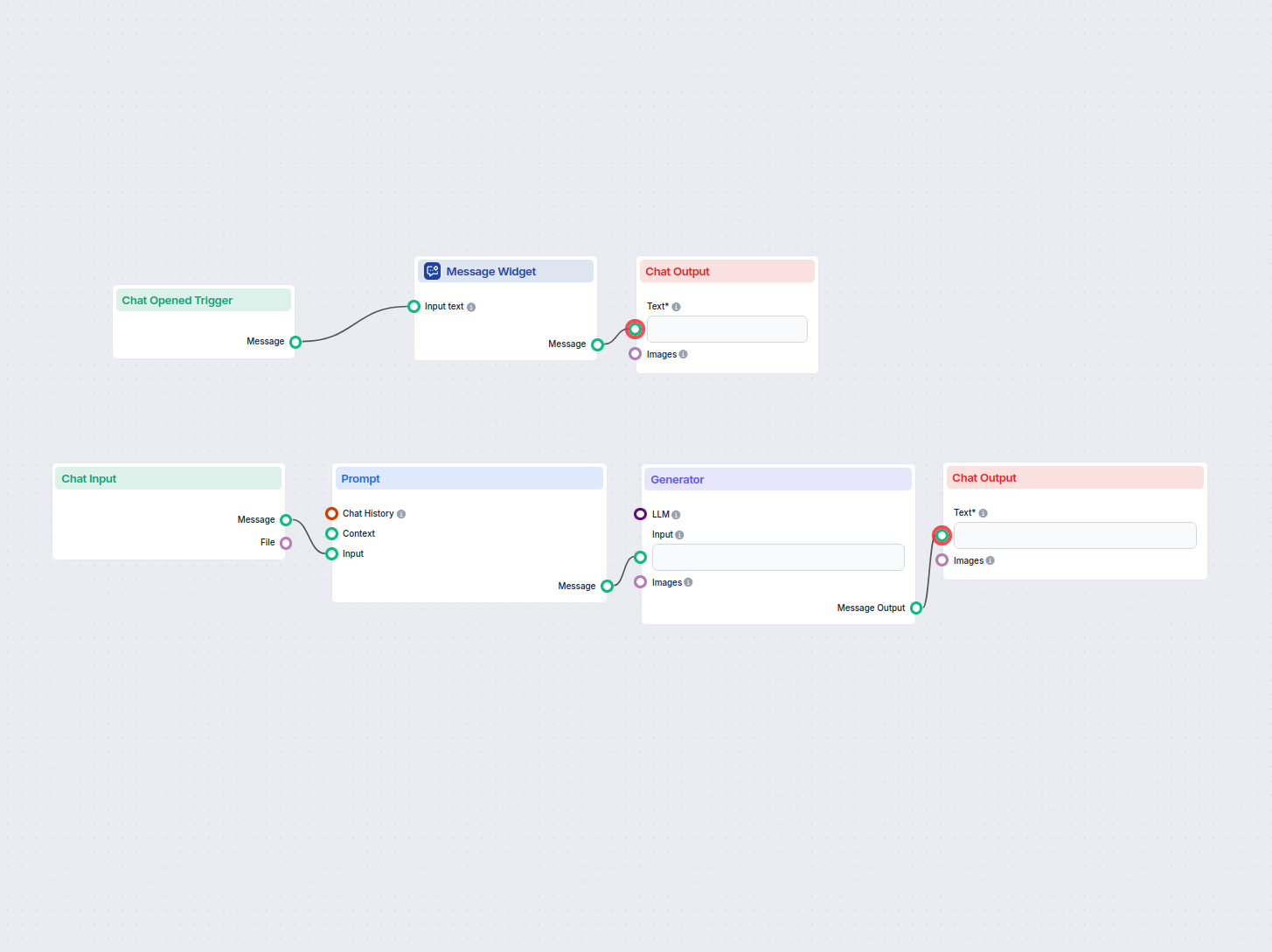

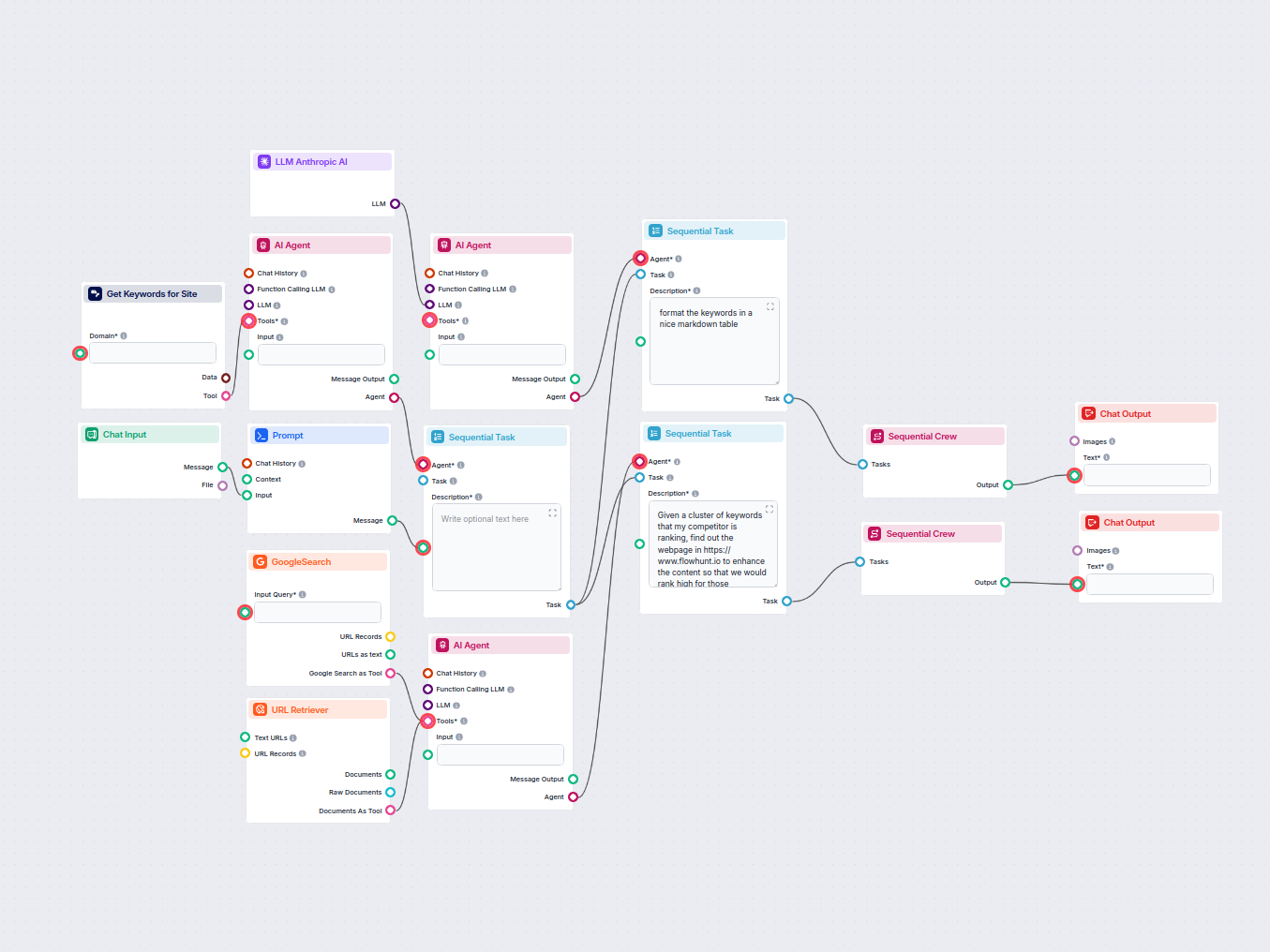

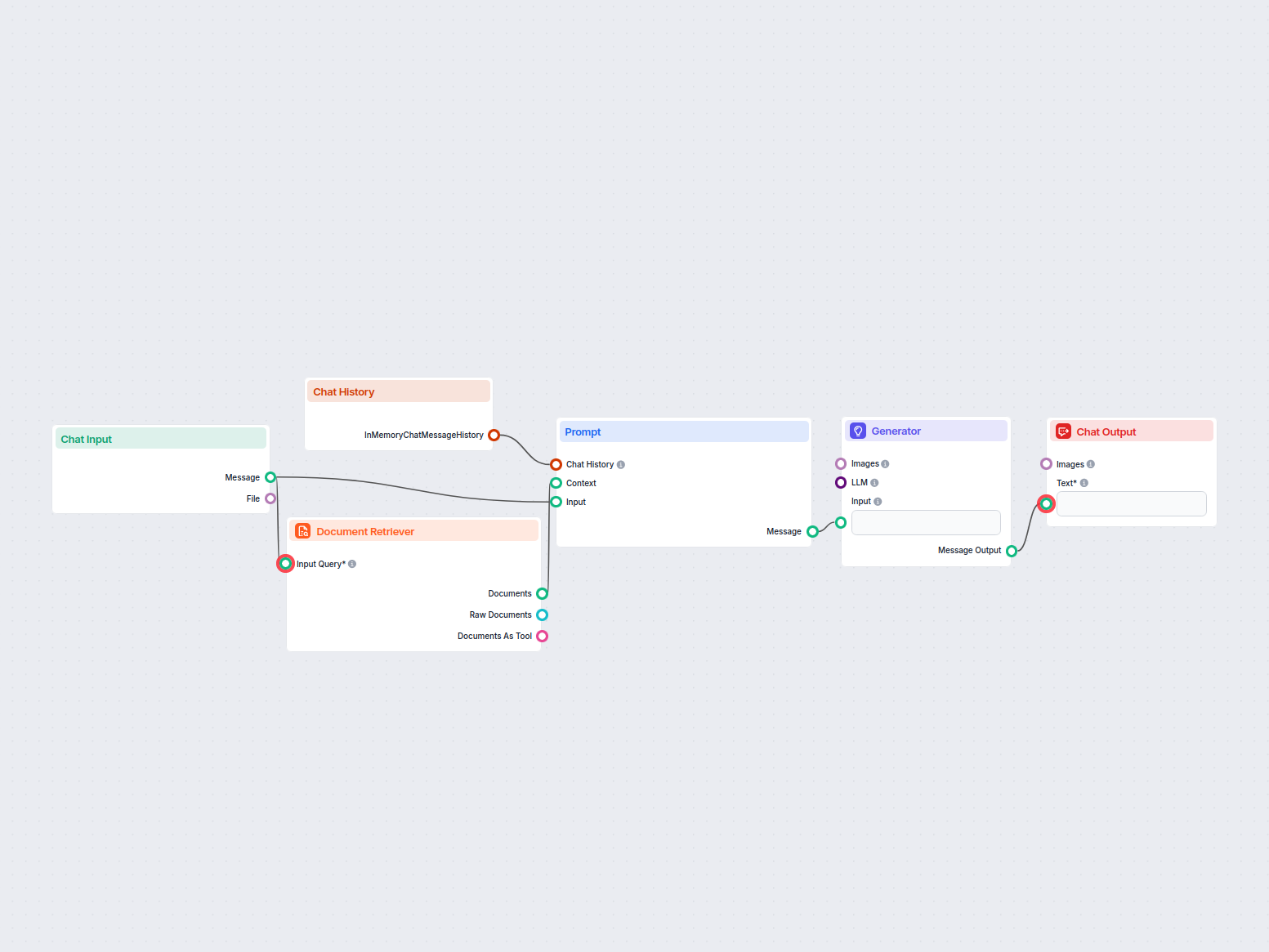

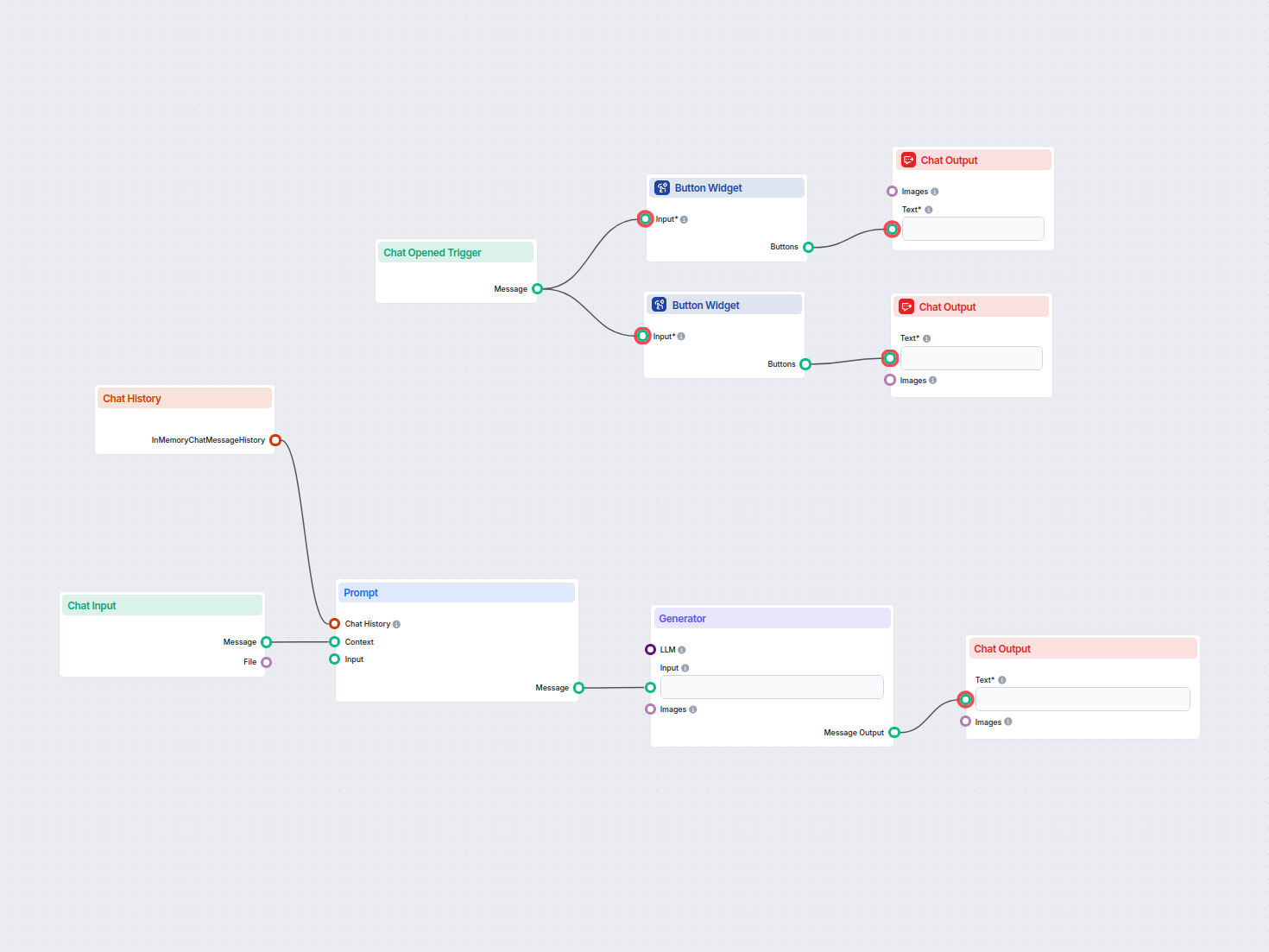

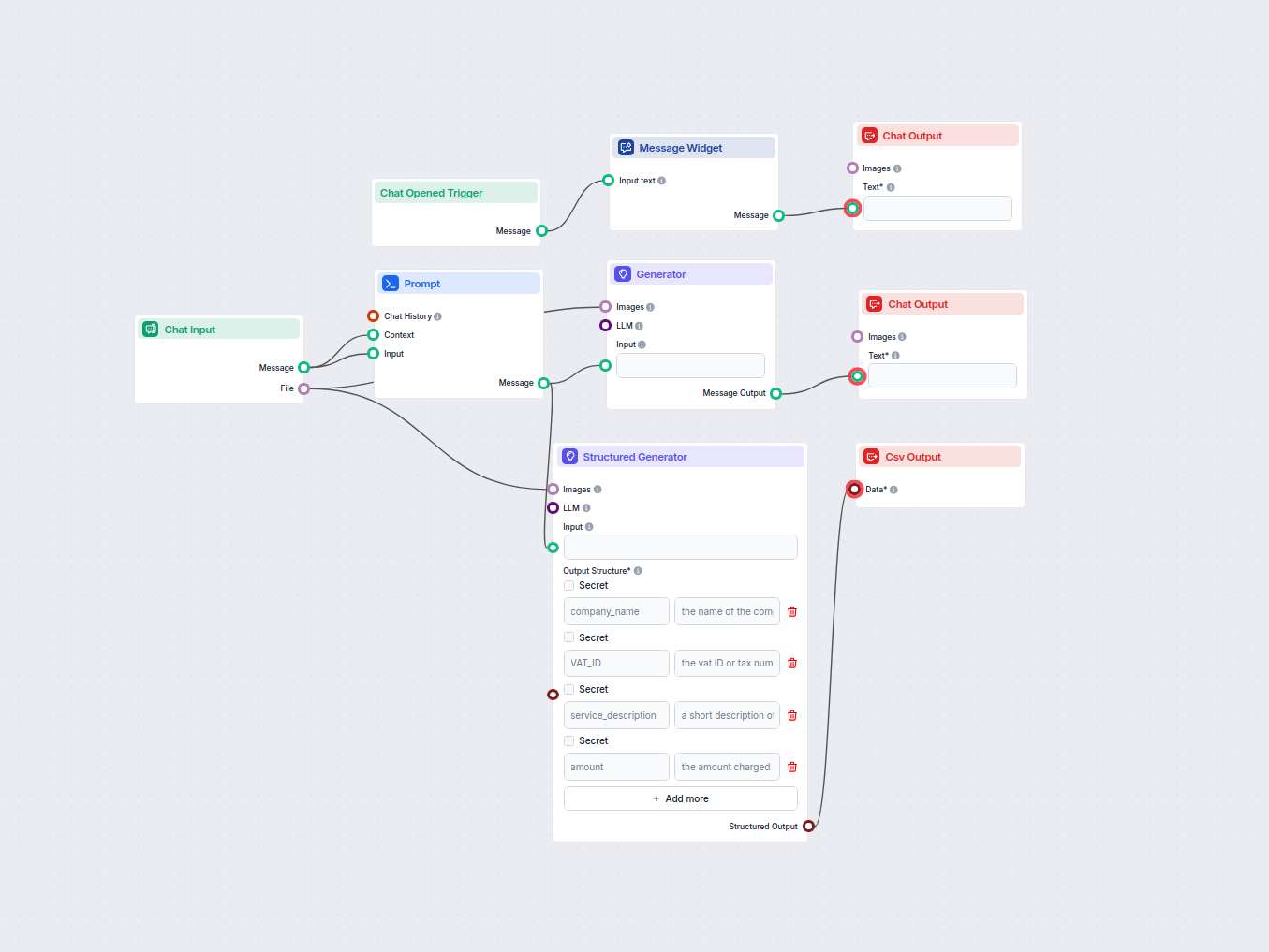

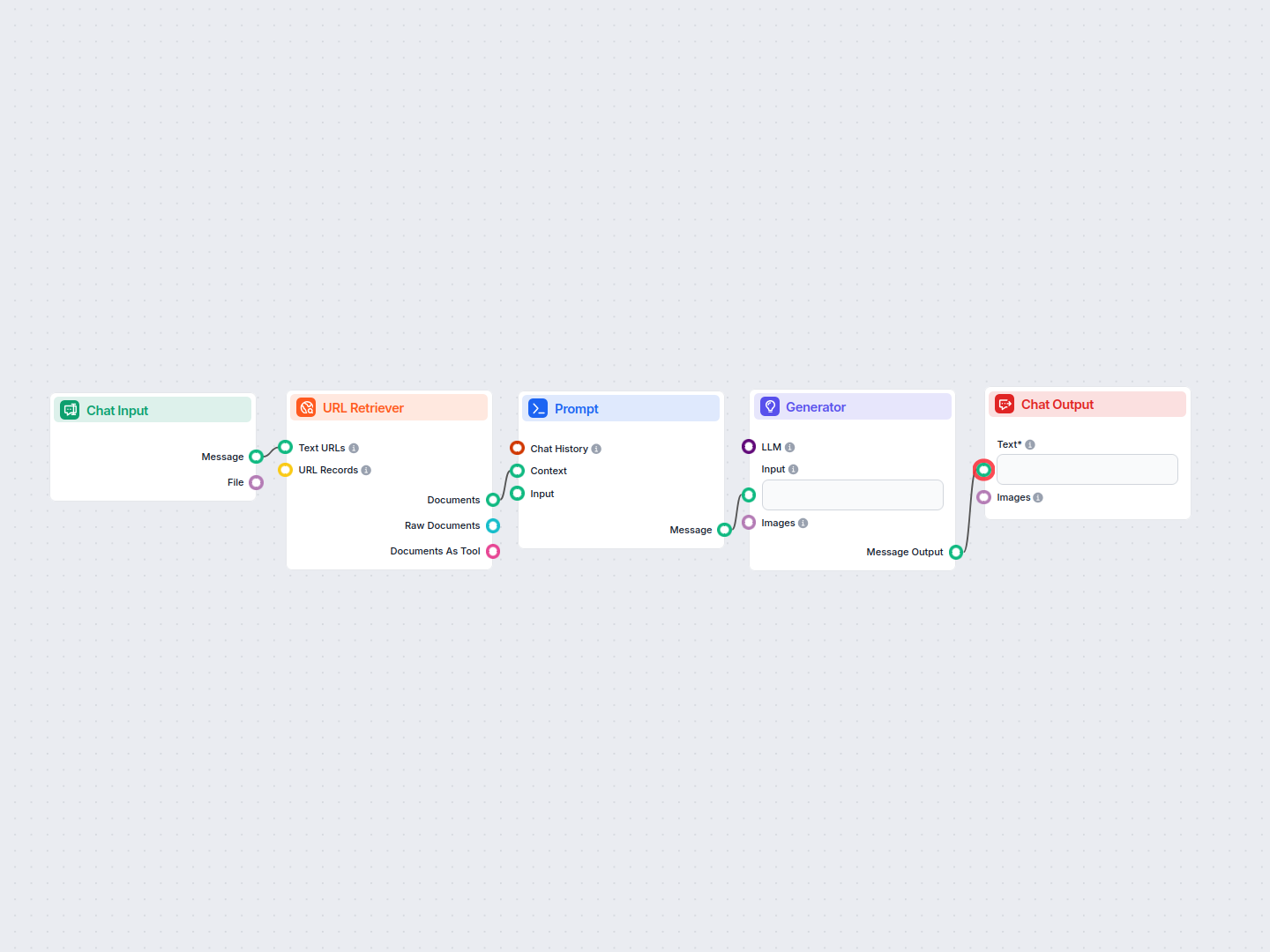

The resulting flow will look something like this:

It’s time to test the knowledge of our medieval knight bot. The URL we gave it is the pricing for URLsLab. So let’s ask about it:

Our bot now uses pompous old-timey language to answer basic queries. But more importantly, notice how the bot adheres to its central role as a helpful customer service bot. Lastly, it successfully uses the information from the specified URL.

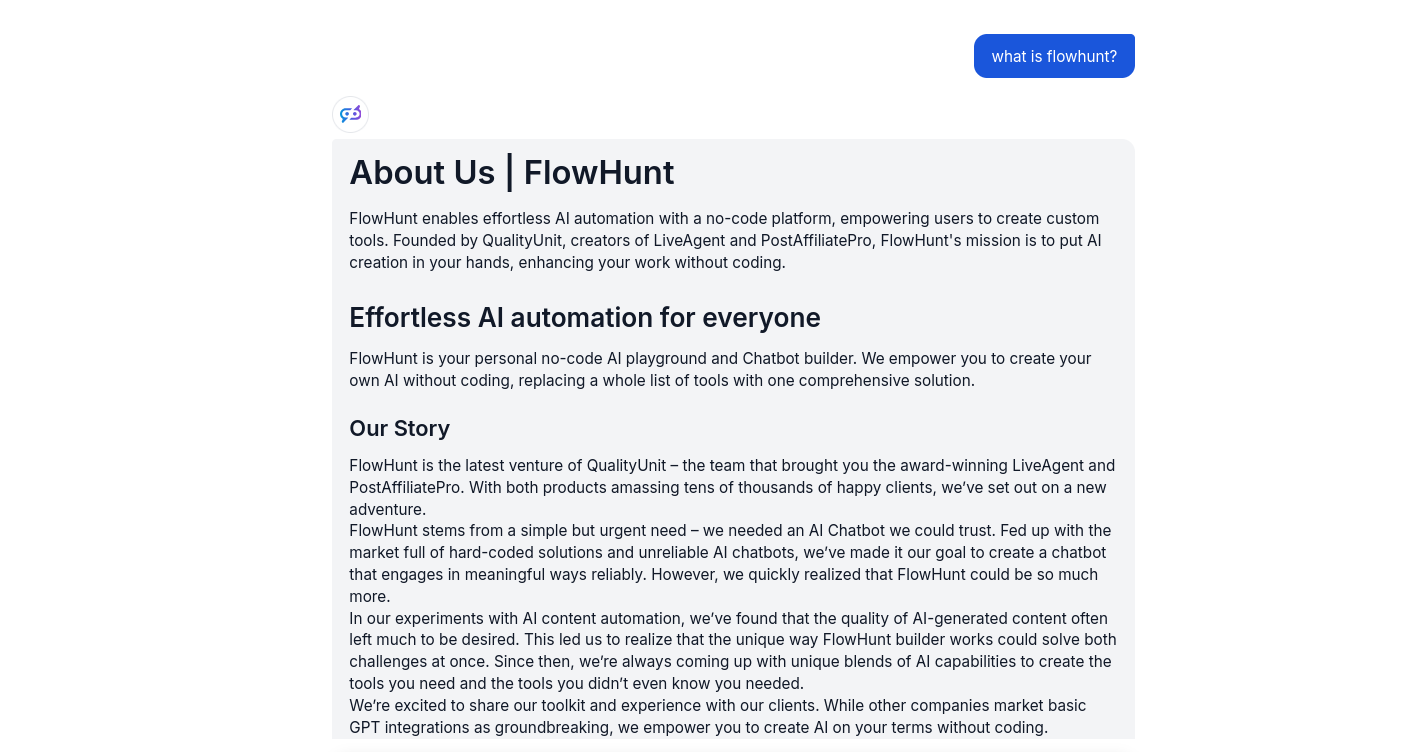

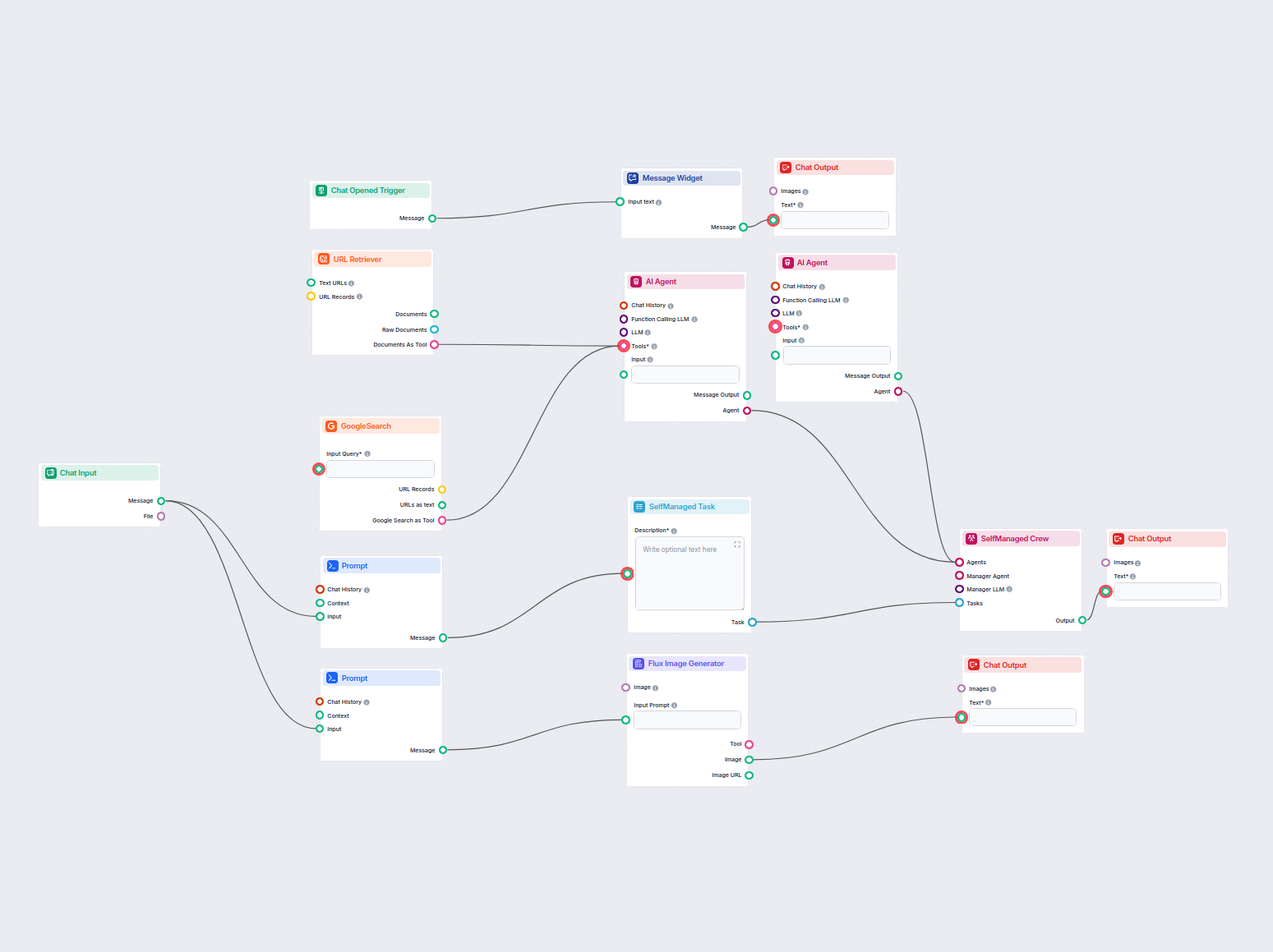

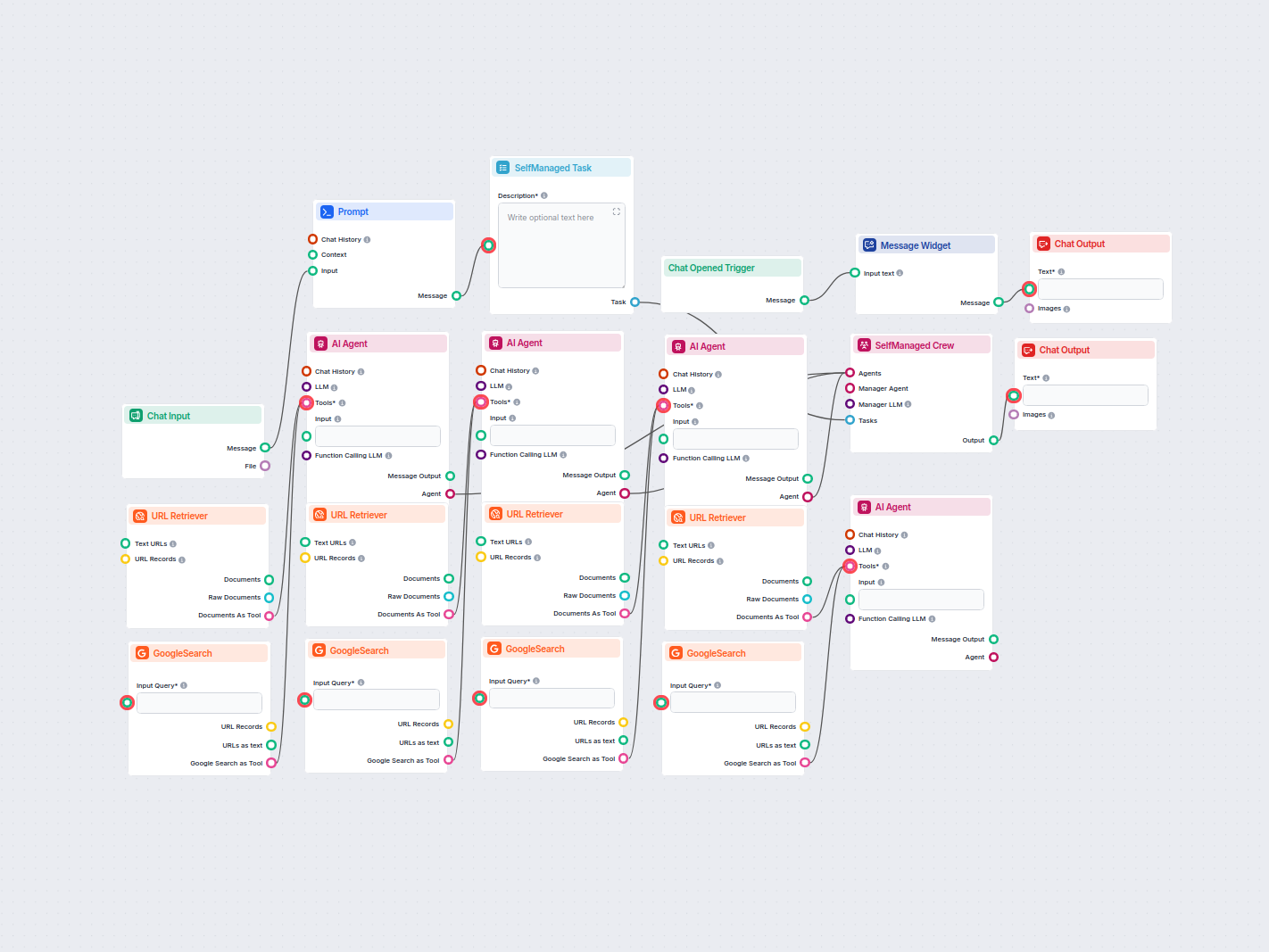

Um Ihnen den schnellen Einstieg zu erleichtern, haben wir mehrere Beispiel-Flow-Vorlagen vorbereitet, die zeigen, wie die Prompt-Komponente in FlowHunt-Komponente effektiv genutzt wird. Diese Vorlagen präsentieren verschiedene Anwendungsfälle und Best Practices und erleichtern Ihnen das Verständnis und die Implementierung der Komponente in Ihren eigenen Projekten.

Erzeugt automatisch einen kurzen, ansprechenden Absatz für Ihre Website, der Links zu den relevantesten verwandten Artikeln enthält. Dieser KI-gestützte Workflo...

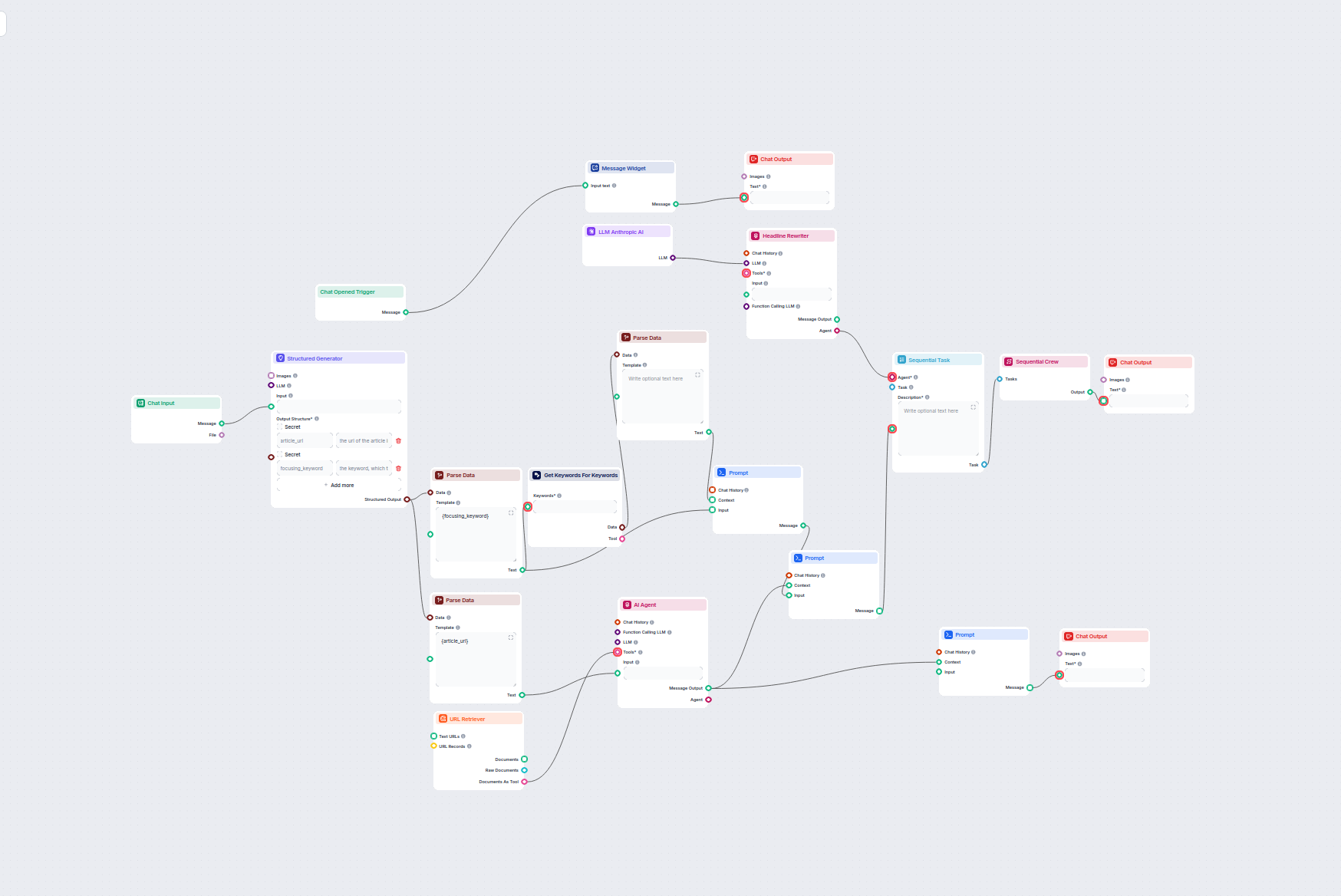

Dieser KI-gestützte Workflow findet die besten SEO-Keywords für Ihren Blogartikel und überarbeitet automatisch die Überschriften, um diese Keywords gezielt anzu...

Formulieren Sie mühelos jeden Text um, indem Wörter durch Synonyme ersetzt werden und die ursprüngliche Bedeutung erhalten bleibt. Perfekt für Marketer, Autoren...

Verwandeln Sie Ihre Meeting-Anhänge mit KI in umsetzbare Zusammenfassungen, Follow-up-E-Mails und Blogartikel. Dieser Workflow automatisiert die Inhaltserstellu...

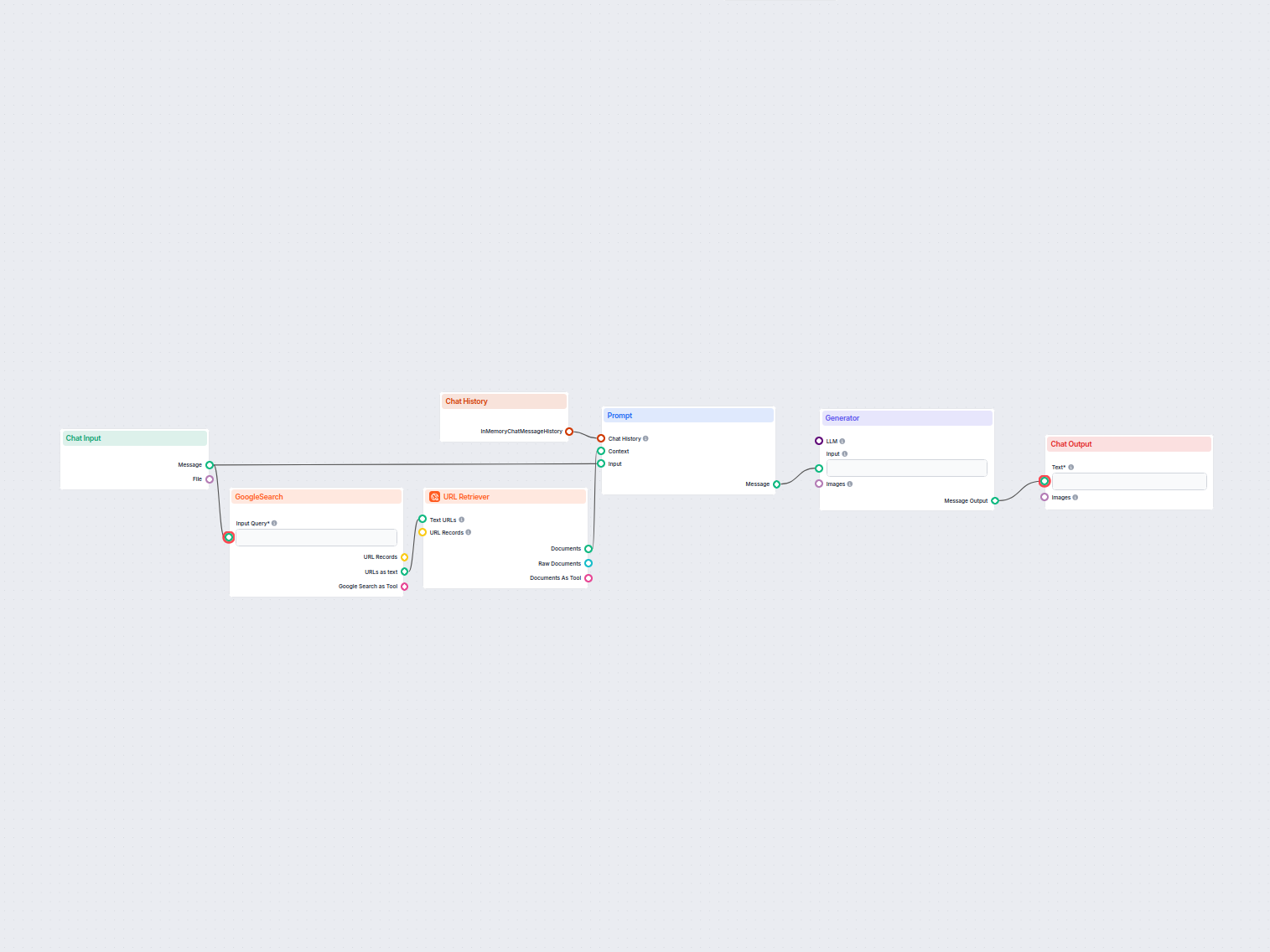

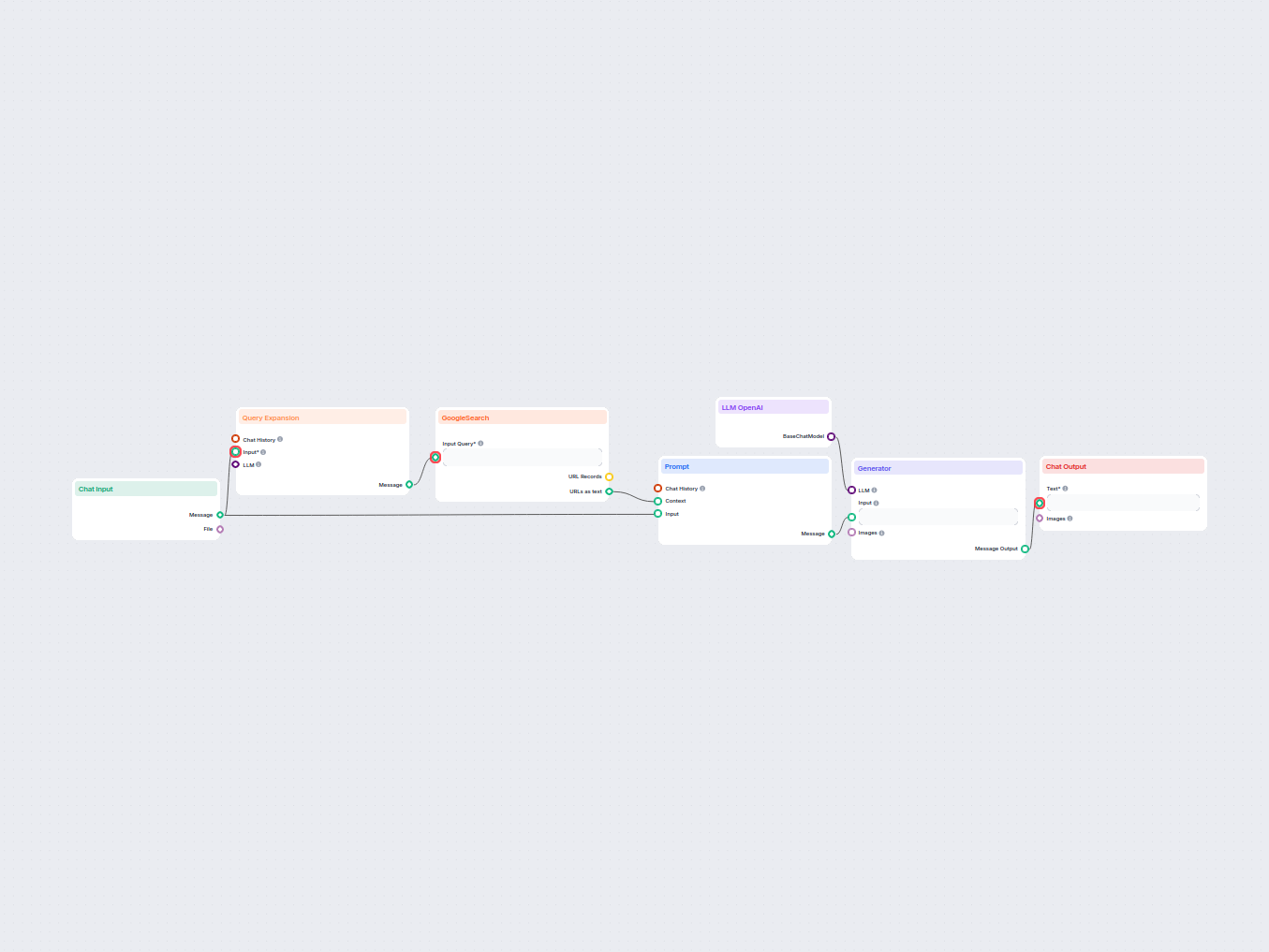

Dieser KI-gestützte Workflow erstellt prägnante, hochwertige FAQ-Antworten für jede beliebige Frage, indem er das Web durchsucht, relevante Inhalte extrahiert u...

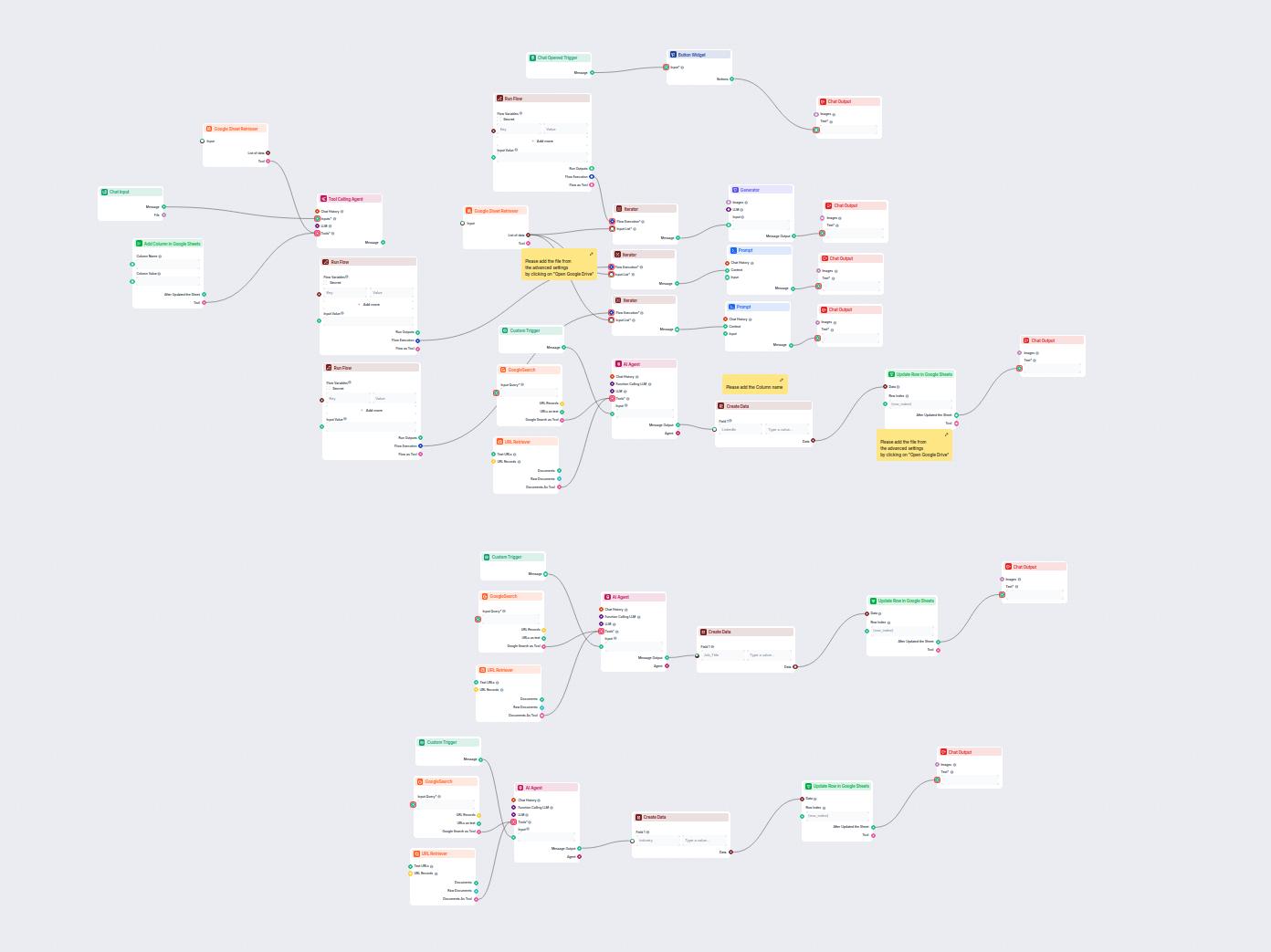

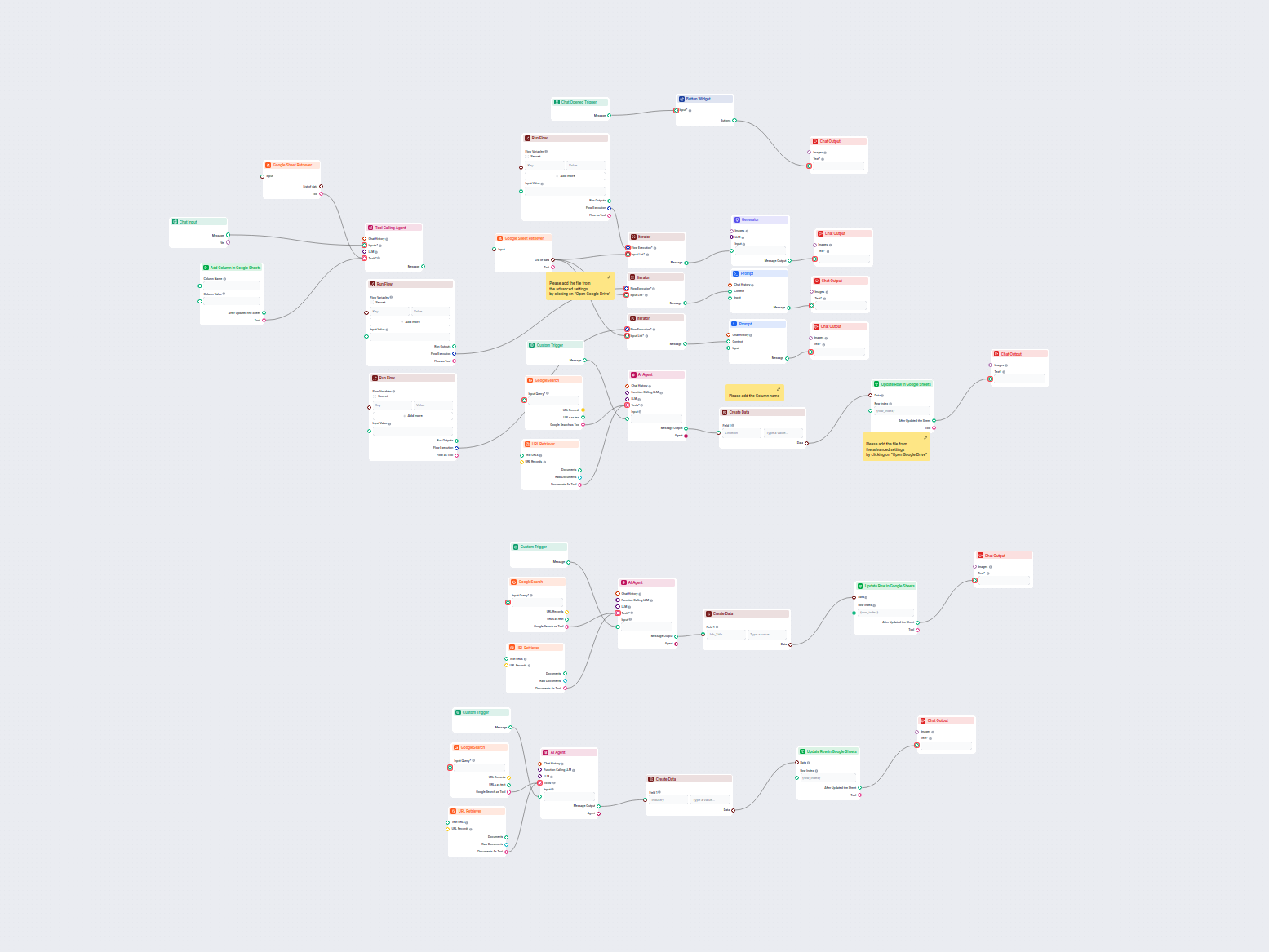

Dieser KI-gesteuerte Workflow reichert Lead-Daten in Google Sheets an, indem fehlende LinkedIn-Profile, Jobtitel und Branchen automatisch aus dem Web mithilfe v...

Dieser Workflow reichert automatisch Google Sheets-Kontaktdaten an, indem er LinkedIn-Profile findet, Jobtitel und Branchen extrahiert und das Sheet mithilfe vo...

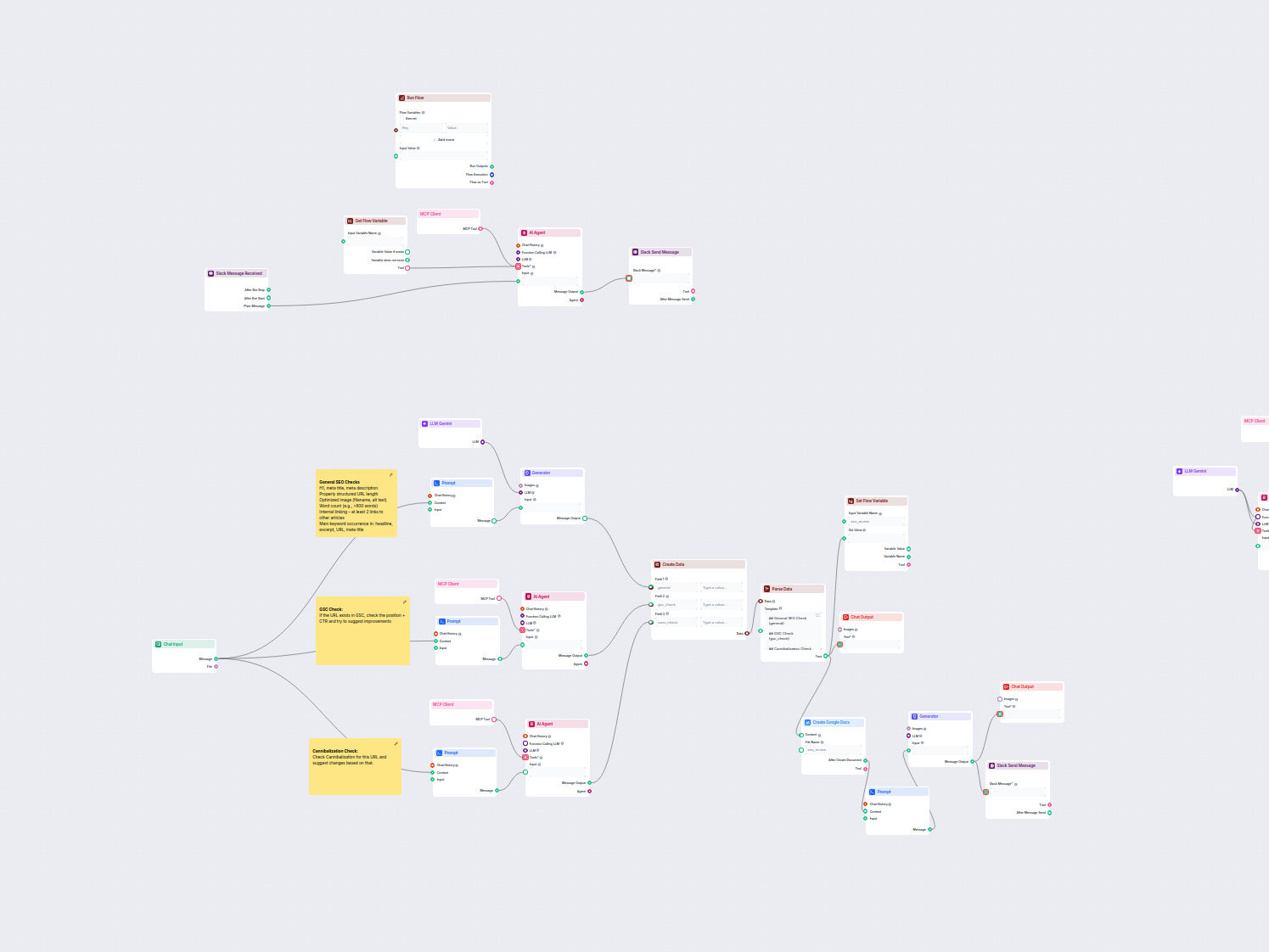

Dieser Workflow automatisiert die SEO-Prüfung und den Audit-Prozess für Webseiten. Er analysiert den Seiteninhalt hinsichtlich SEO-Best Practices, führt Prüfung...

Dieser Workflow ermittelt, ob eine E-Mail-Adresse von einem generischen, kostenlosen E-Mail-Anbieter oder von einer eigenen geschäftlichen Domain stammt. Er ist...

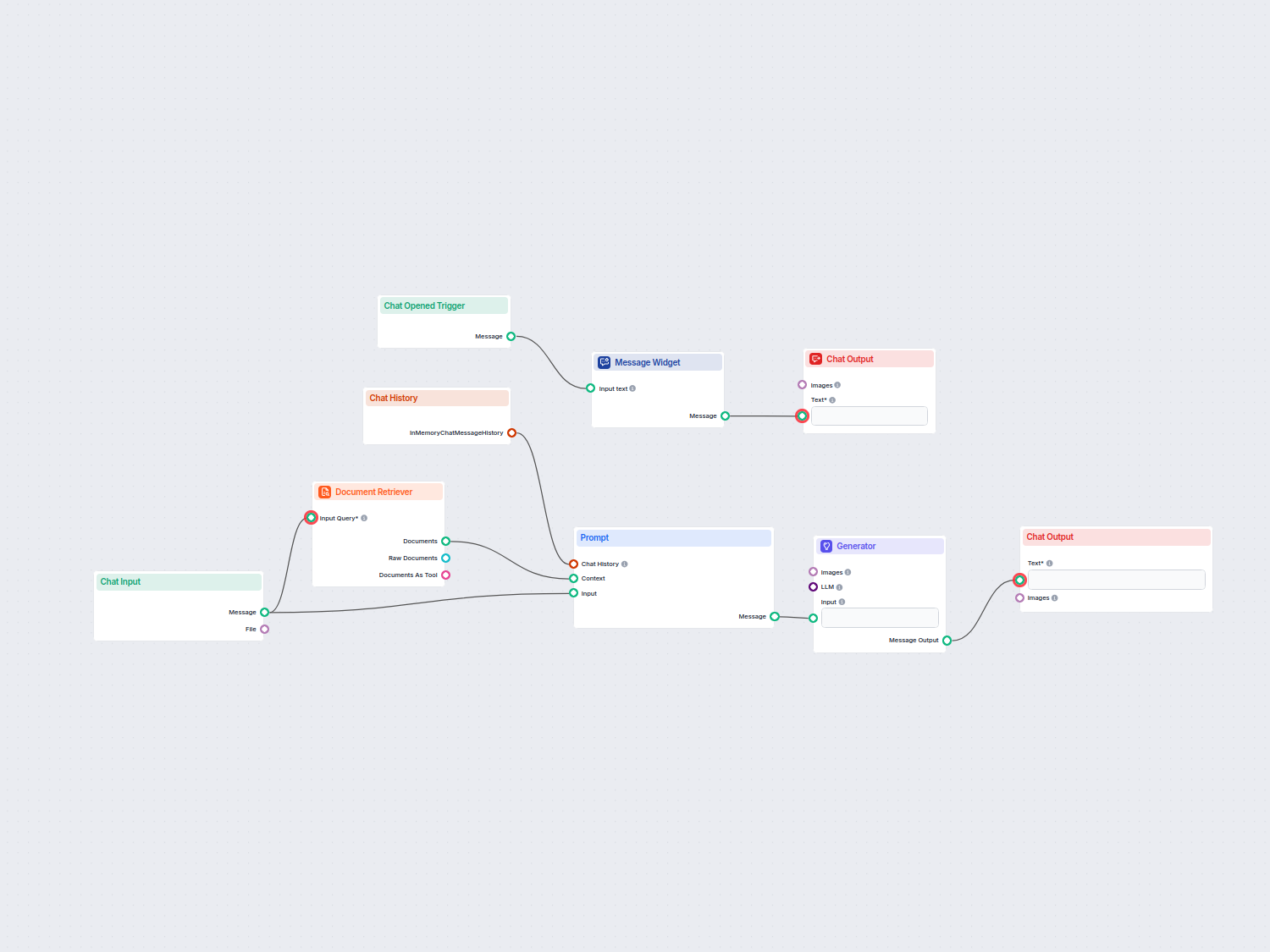

KI-Chatbot-Assistent auf Basis von OpenAI GPT-4o, der automatisch interne Firmendokumente durchsucht und nutzt, um Benutzerfragen zu beantworten. Liefert kontex...

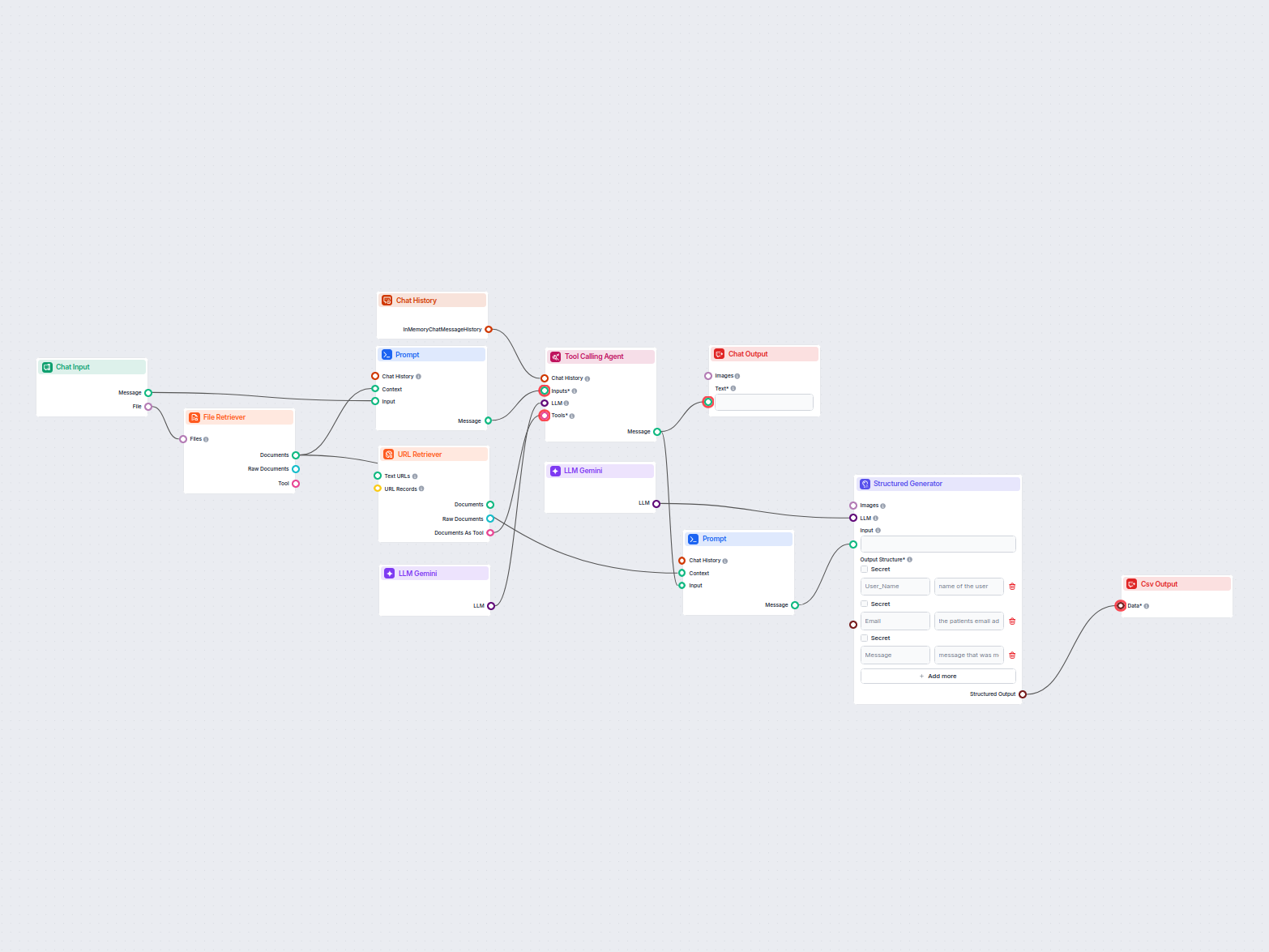

Dieser Workflow extrahiert und organisiert Schlüsselinformationen aus E-Mails und angehängten Dateien, nutzt KI zur Verarbeitung und Strukturierung der Daten un...

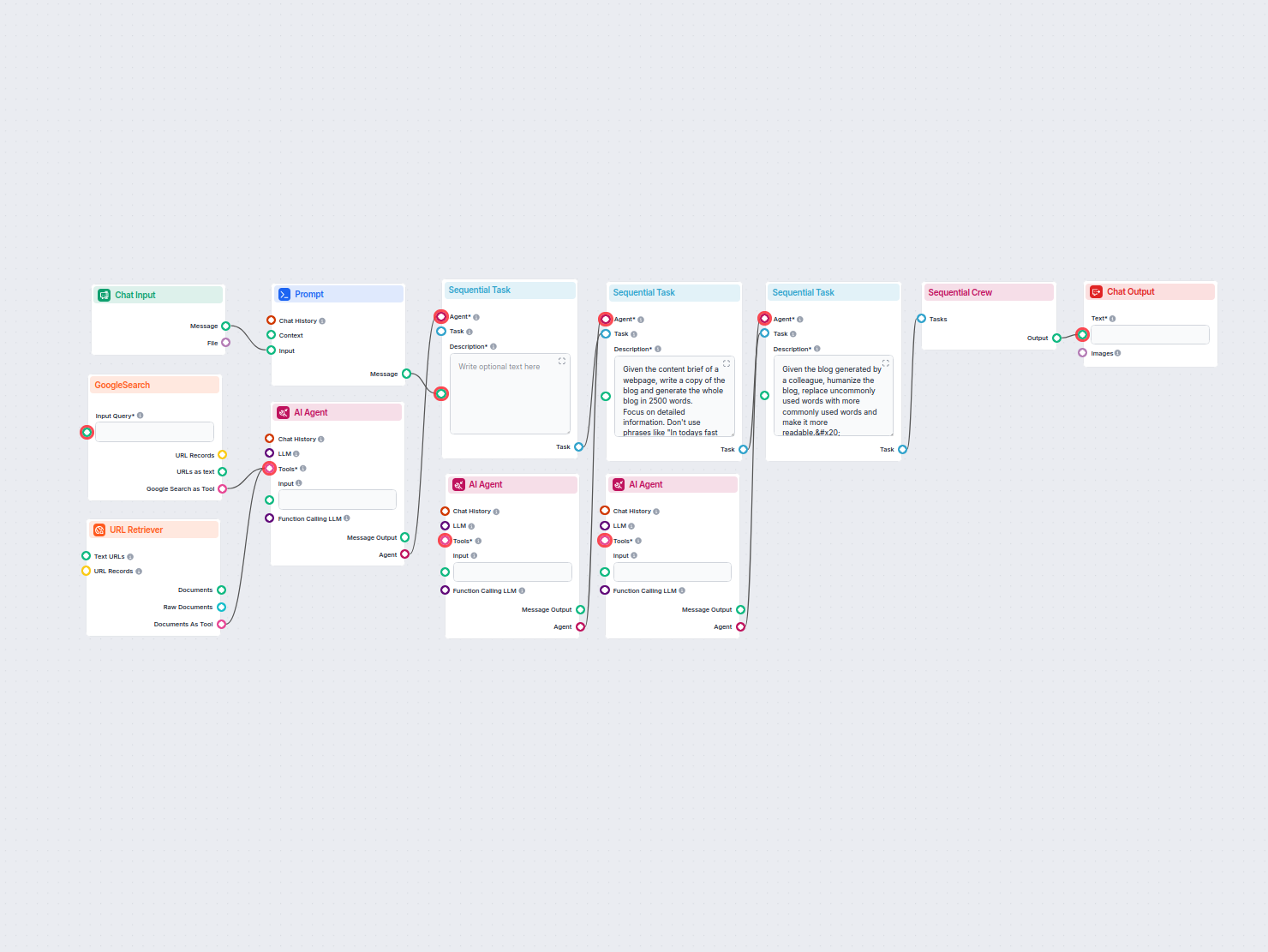

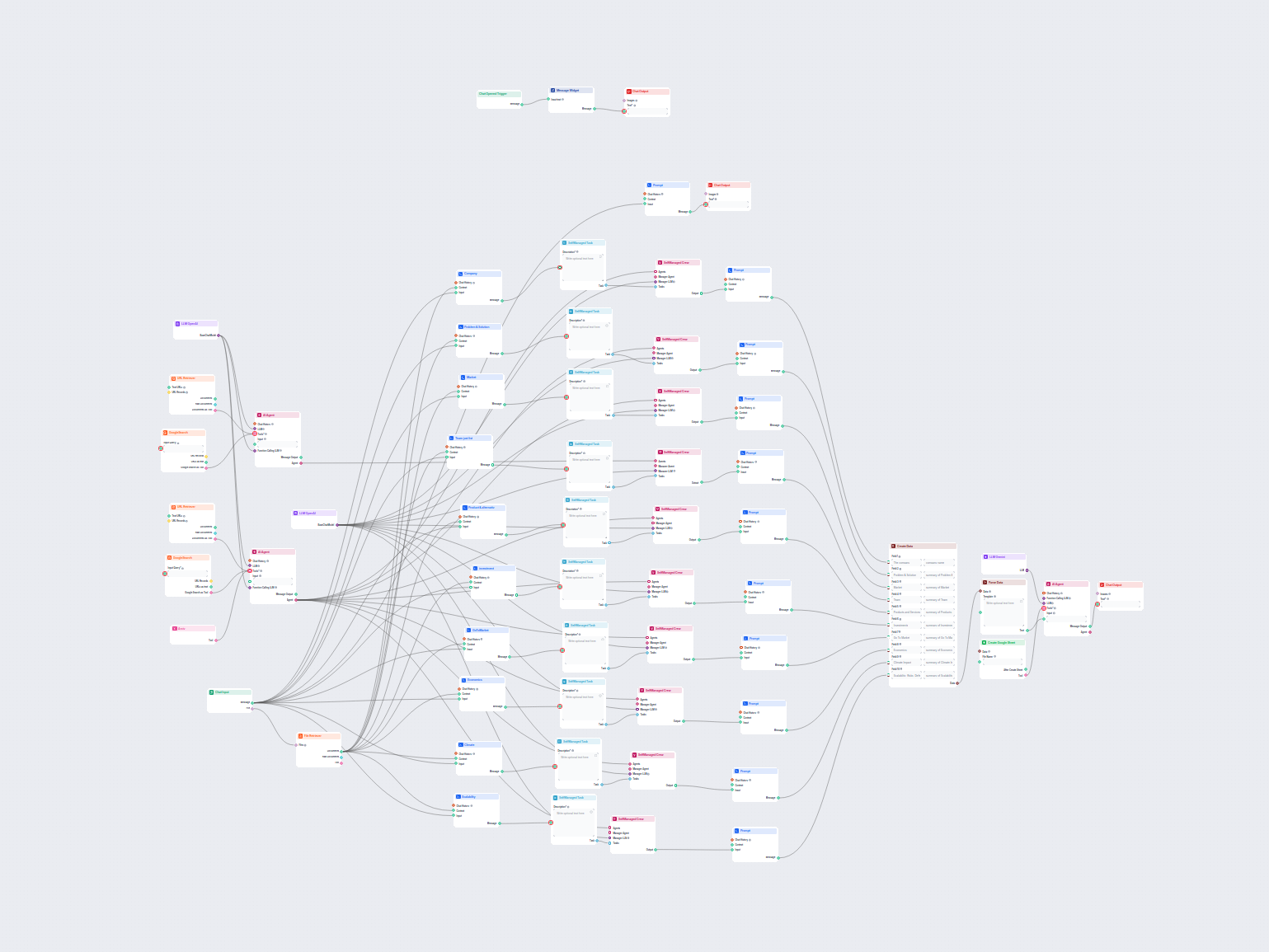

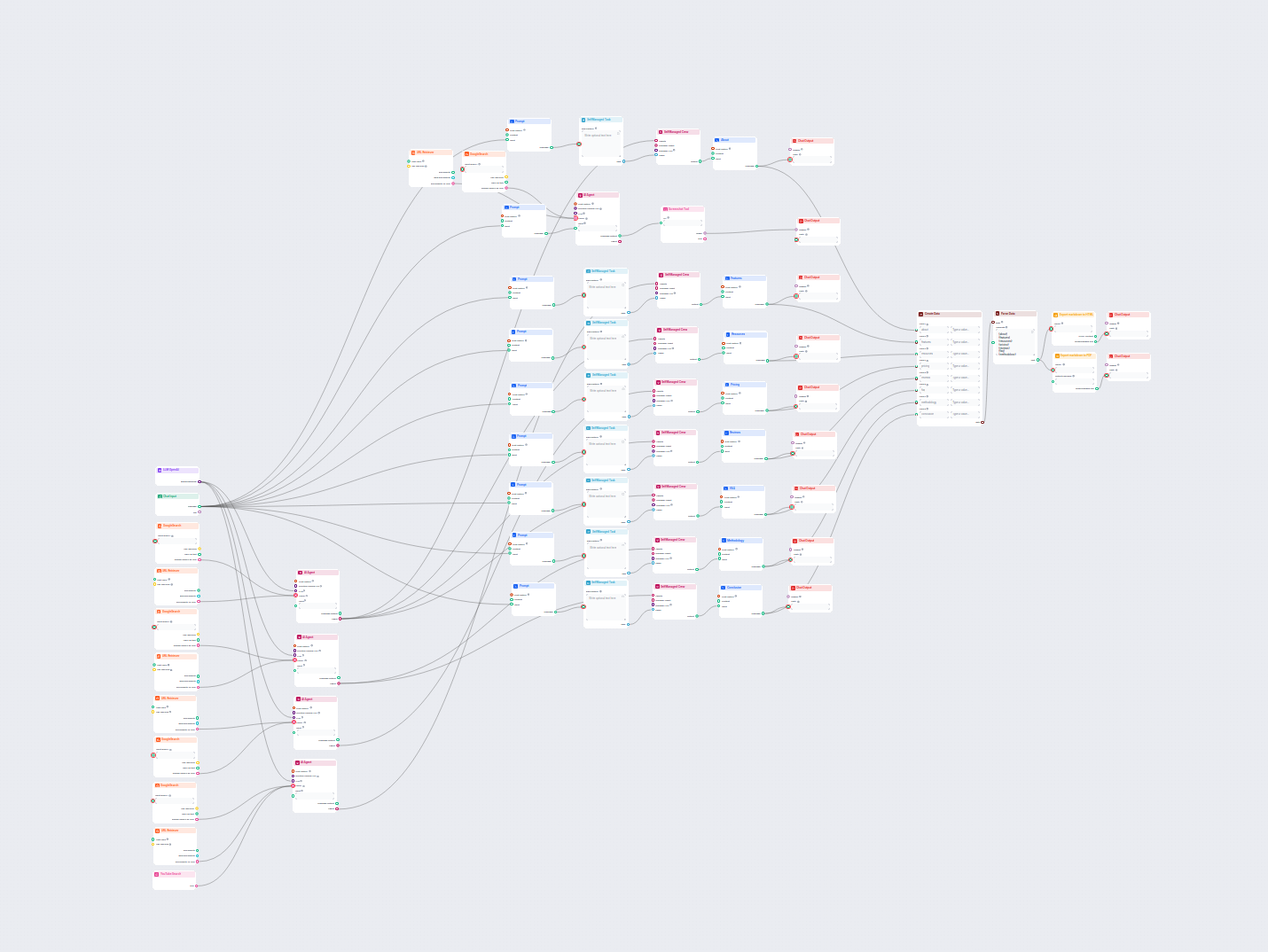

Erstellen Sie umfassende, SEO-optimierte Blogposts mit fortschrittlicher Struktur und hoher Wortanzahl mithilfe mehrerer KI-Agenten. Der Workflow umfasst automa...

Erstellen Sie umfassende, SEO-optimierte Glossarartikel mithilfe von KI und Echtzeit-Webrecherche. Dieser Flow analysiert die bestplatzierten Inhalte und Schrei...

Generieren Sie automatisch mehrere Google Ads-Variationen für jede URL. Fügen Sie Ihren Webseiten-Link ein und erhalten Sie gebrauchsfertige Anzeigentitel und -...

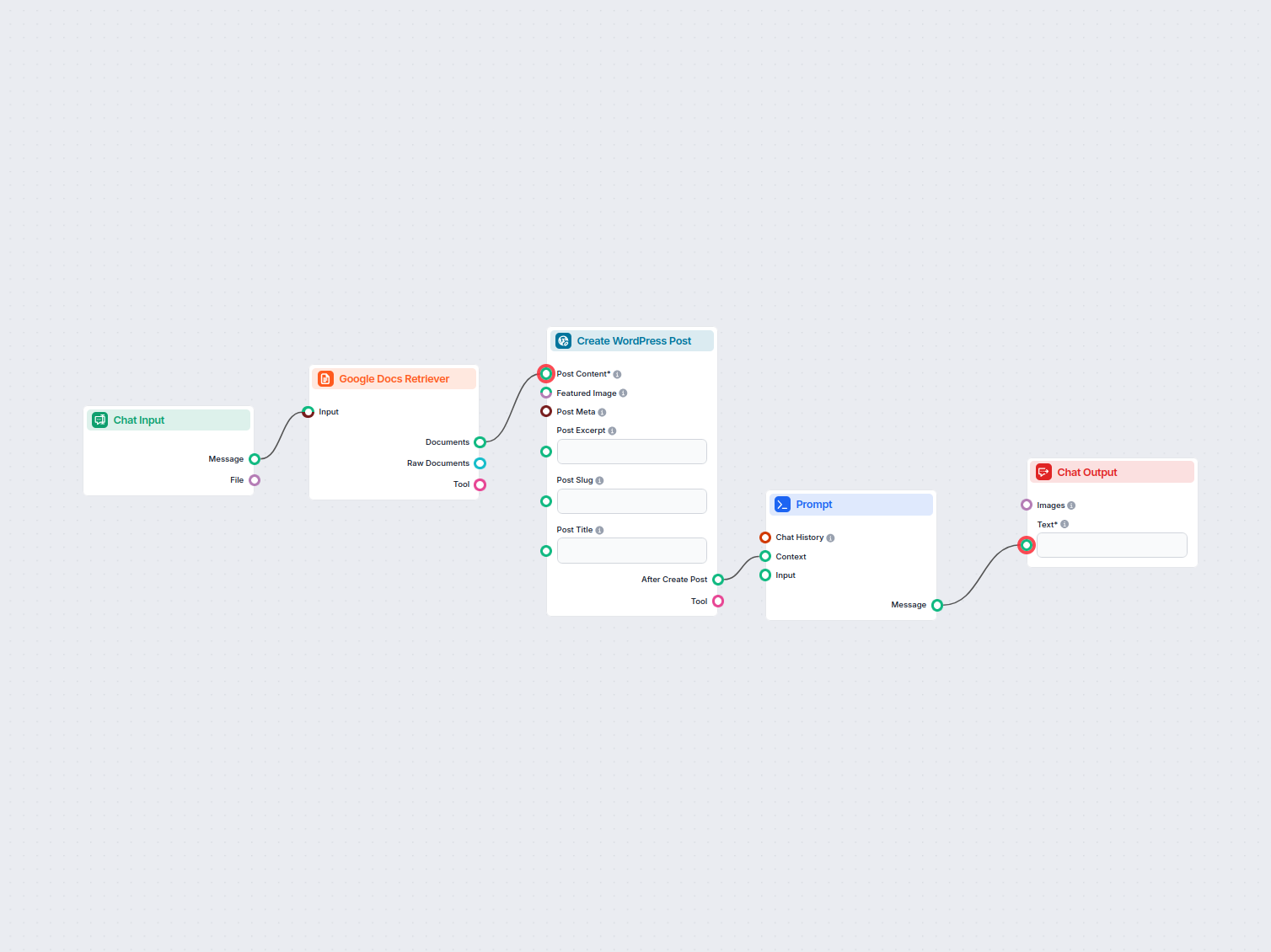

Übertragen Sie Inhalte automatisch von Google Docs auf Ihre WordPress-Seite als neue Beiträge und optimieren Sie so die Veröffentlichung von Inhalten für Blogge...

Dieser Workflow analysiert die Google-Suchergebnisse für ein bestimmtes Keyword und extrahiert Erkenntnisse über Suchintention, Wettbewerbsstrategien und Conten...

Erstellen Sie Google Sheets-Formeln sofort aus Anfragen in natürlicher Sprache. Dieser KI-gestützte Workflow hilft Nutzern, präzise Tabellenformeln zu erstellen...

Ein automatisierter, KI-gestützter Workflow zum Abrufen, Zusammenfassen und Präsentieren der Top-Geschichten von Hacker News, einschließlich Story-Details, URLs...

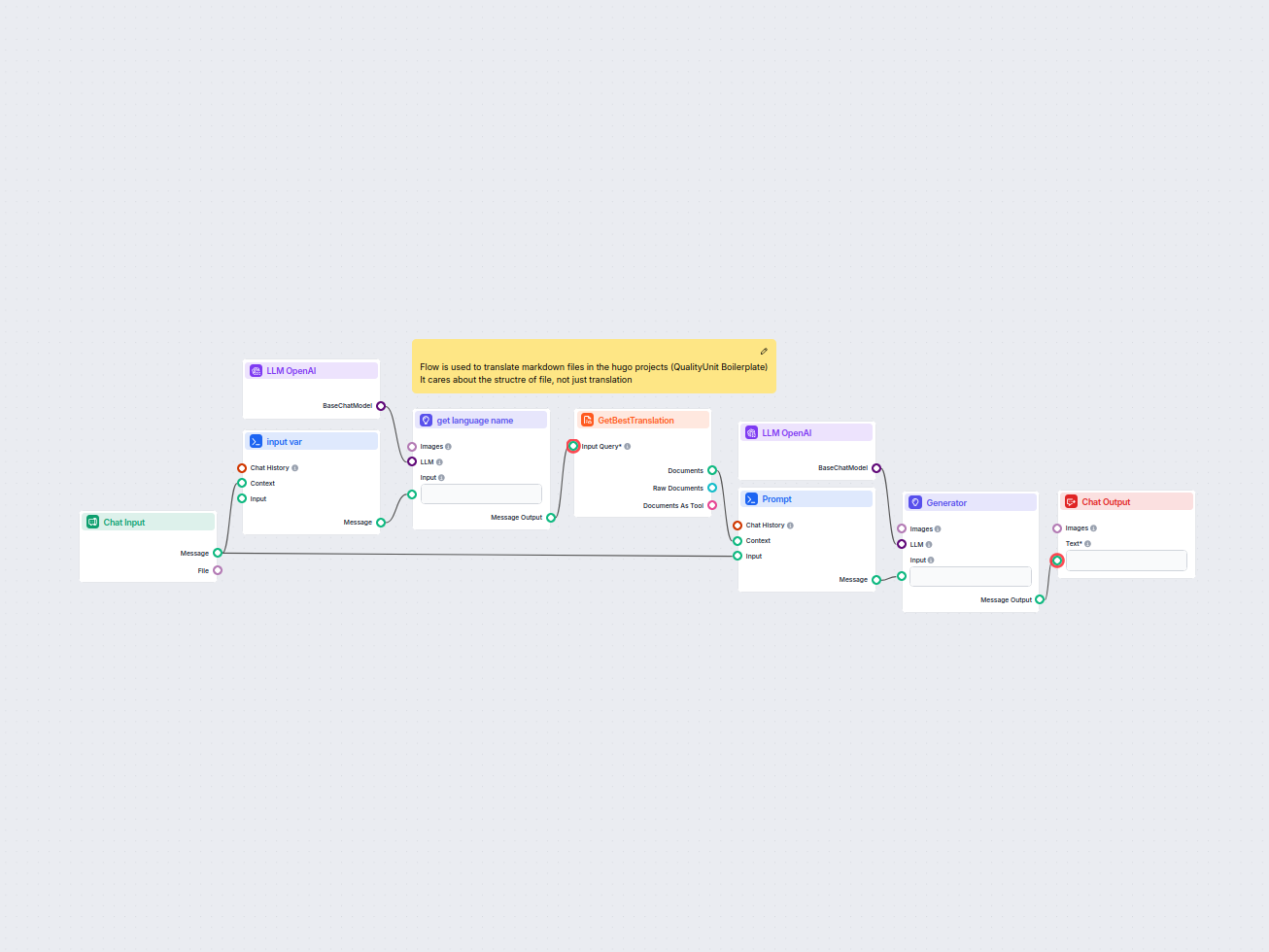

Dieser Workflow optimiert die Übersetzung von HUGO-Markdown-Dateien in Zielsprache, wobei die Dateistruktur und das Format erhalten bleiben. Durch den Einsatz v...

Erstellen Sie automatisch ansprechende Instagram-Posts, einschließlich einprägsamer Titel, kreativer Bildunterschriften und visuell ansprechender Bilder mithilf...

Erstellt automatisch eine ansprechende, SEO-freundliche Meta-Beschreibung für jede Webseite, PDF, YouTube-Video oder Dokumentenlink, indem der Inhalt analysiert...

Erstellen Sie detaillierte, SEO-optimierte Blogs mit Hilfe von KI-Agenten. Der Ablauf recherchiert die besten Google-Ergebnisse, erstellt ein SEO-Briefing, schr...

Erstellen Sie mühelos umfassende Businesspläne mit KI. Dieser Workflow sammelt Benutzereingaben, nutzt den Chatverlauf für Kontext und verwendet eine Prompt-Vor...

Generieren Sie mit KI ganz einfach kreative und relevante Firmennamen-Ideen. Nutzer geben eine kurze Beschreibung ihres Unternehmens an und erhalten sofort fünf...

Erzeuge innovative Geschäftsideen, die auf Benutzereingaben oder ausgewählten Branchen basieren, mithilfe von KI. Dieser interaktive Flow liefert Vorschläge ent...

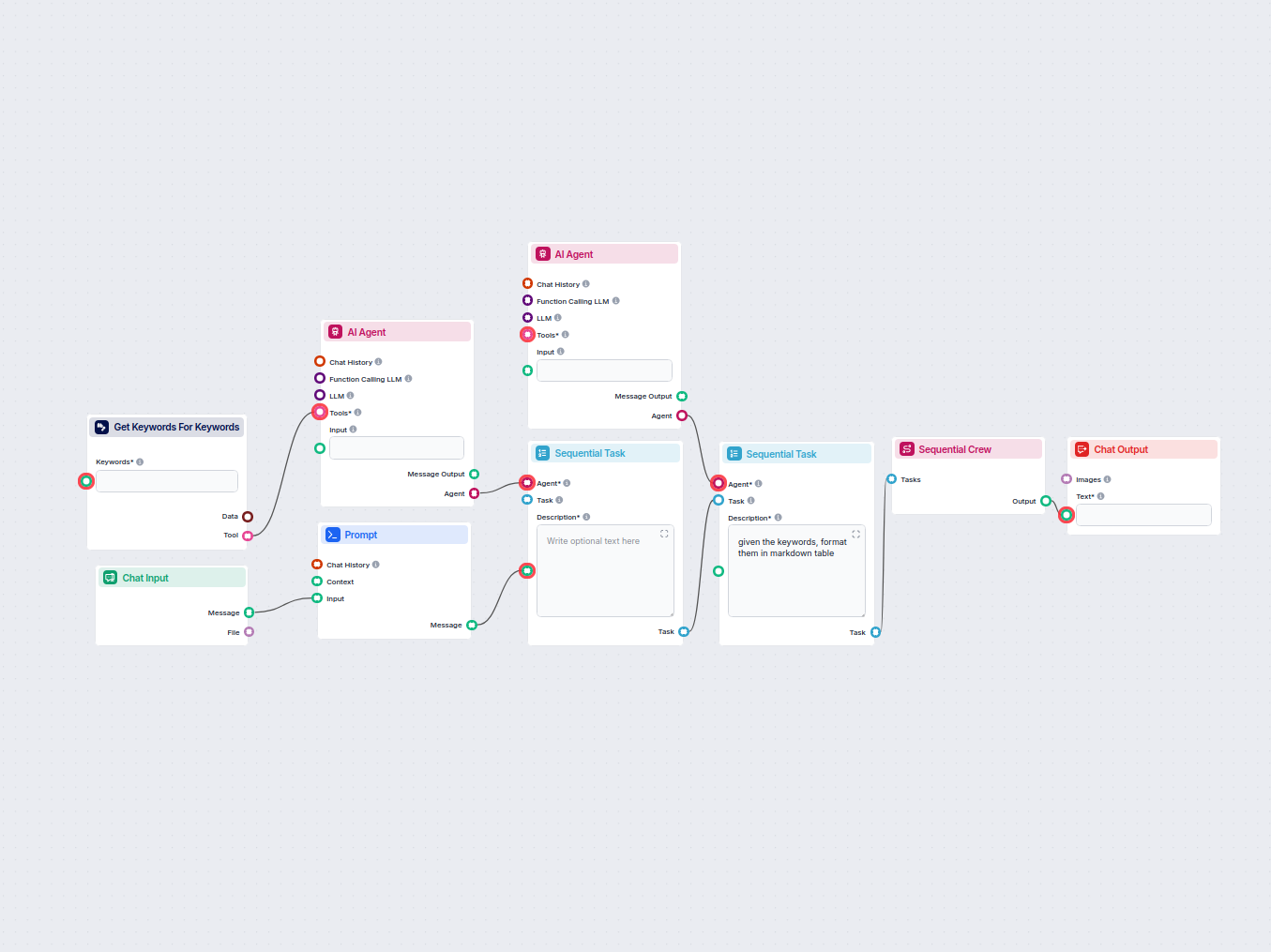

Dieser Workflow automatisiert die Keyword-Recherche, indem er eine detaillierte Tabelle mit verwandten Keywords für Ihre Zielphrase erstellt, einschließlich wic...

Erstellen Sie automatisch ansprechende und professionelle LinkedIn-Headlines mit KI. Geben Sie einfach eine kurze Beschreibung Ihrer Erfahrung an, und dieser Fl...

Analysiere automatisch die Homepage-URL deines Wettbewerbers, um dessen Top-Ranking-Keywords zu entdecken, Keyword-Daten von Google zu sammeln und umsetzbare Em...

Dieser Workflow nimmt vom Benutzer eingereichte Bildgenerierungs-Prompts entgegen und verfeinert sie mithilfe von KI-Best Practices. So wird sichergestellt, das...

Erstellen Sie mühelos formelle, informelle oder juristische Briefe, die auf Ihre Bedürfnisse zugeschnitten sind. Dieser KI-gestützte Workflow nimmt Ihre Eingabe...

Dieser KI-gestützte Workflow löst automatisch CAPTCHA-Bilder, die von Benutzern hochgeladen werden. Er führt die Nutzer mit Anweisungen, verarbeitet das hochgel...

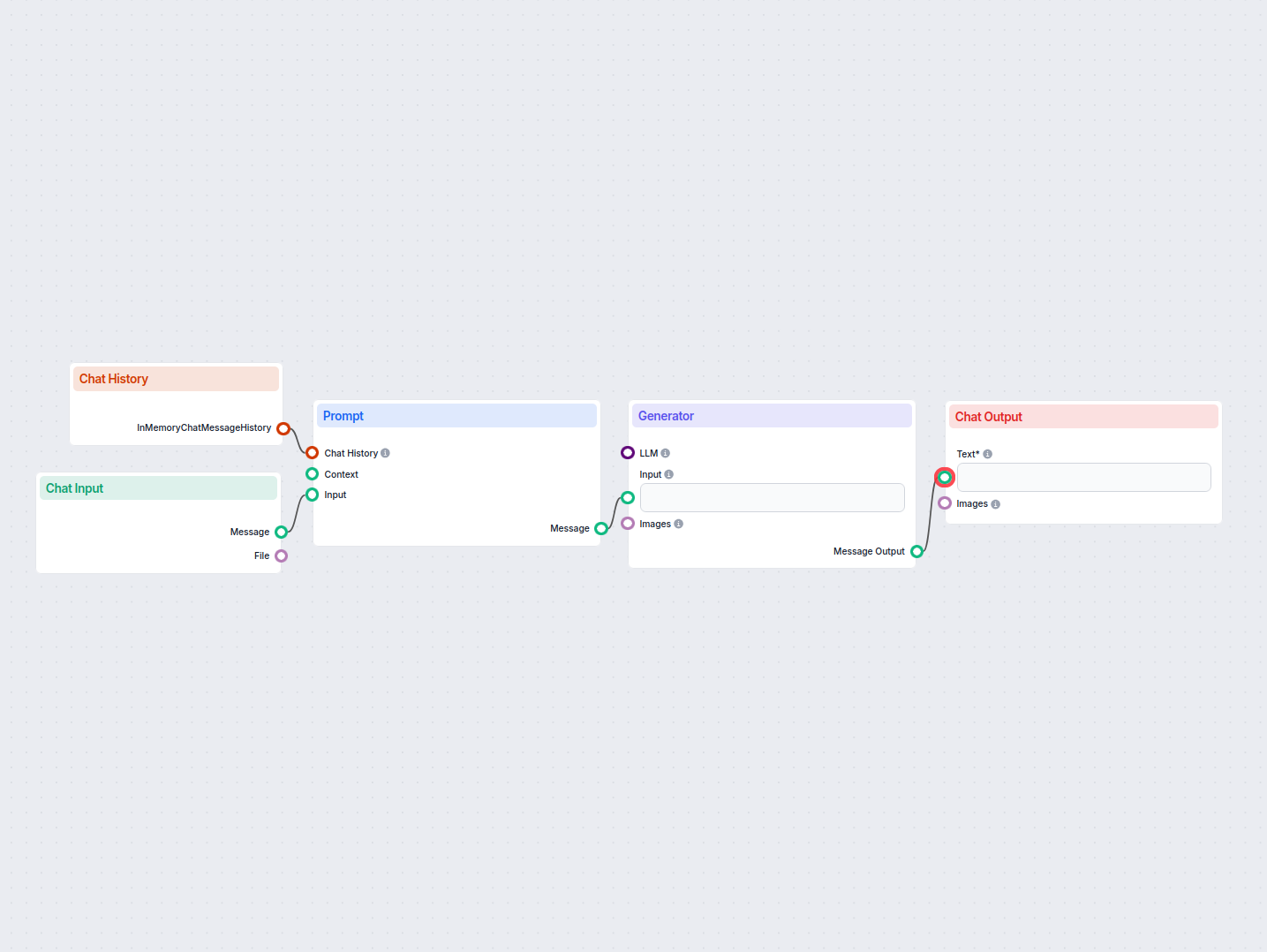

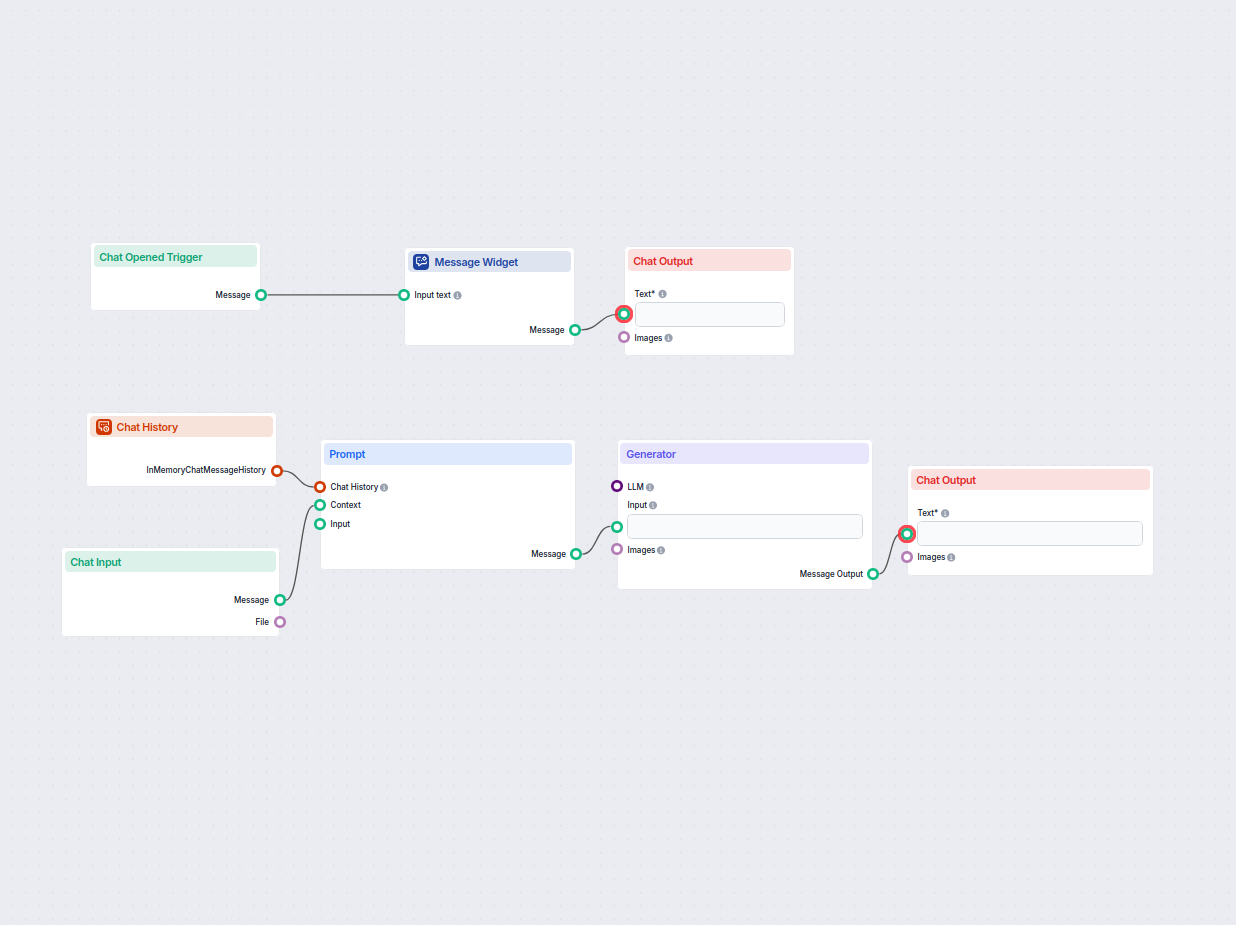

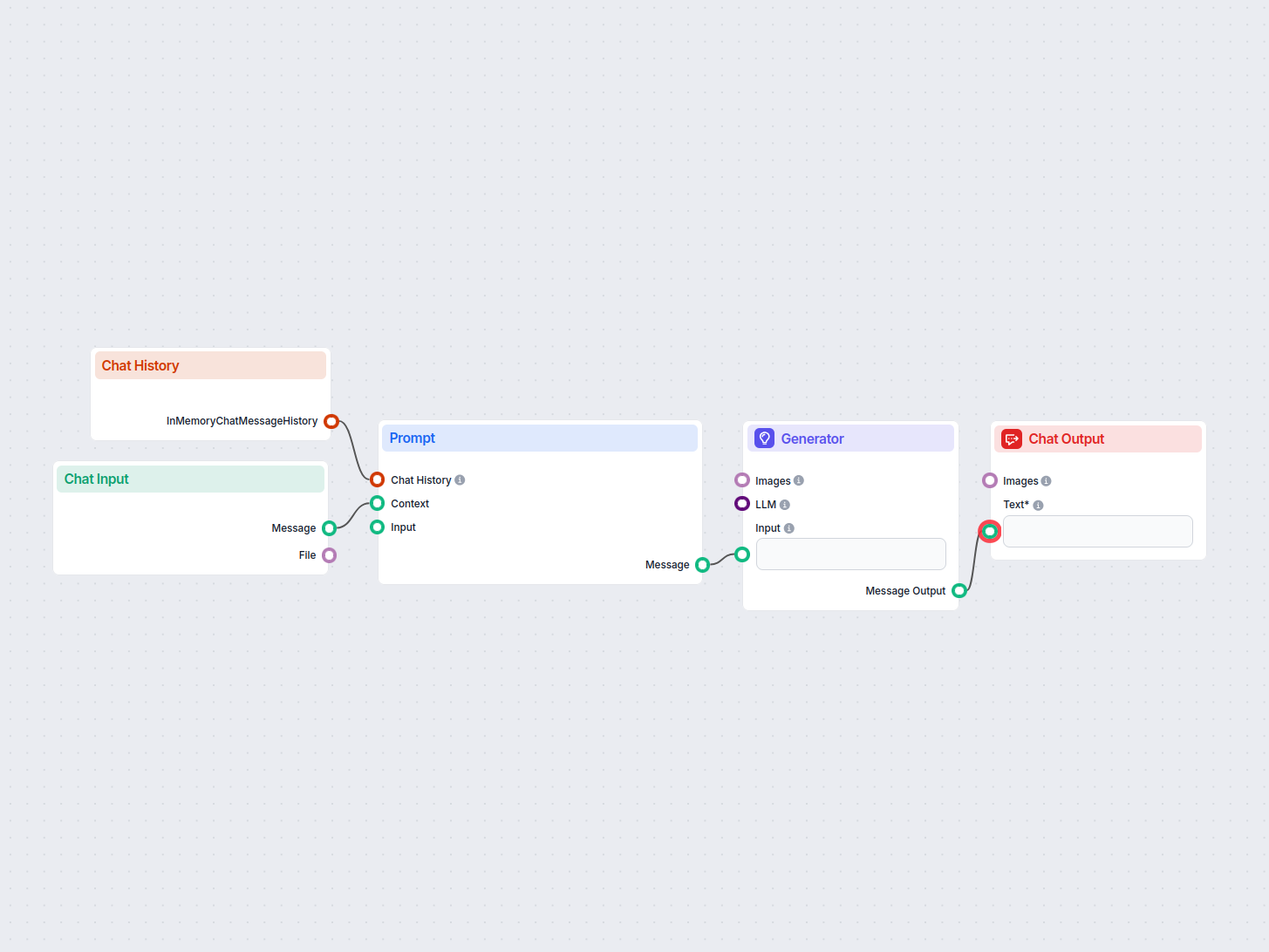

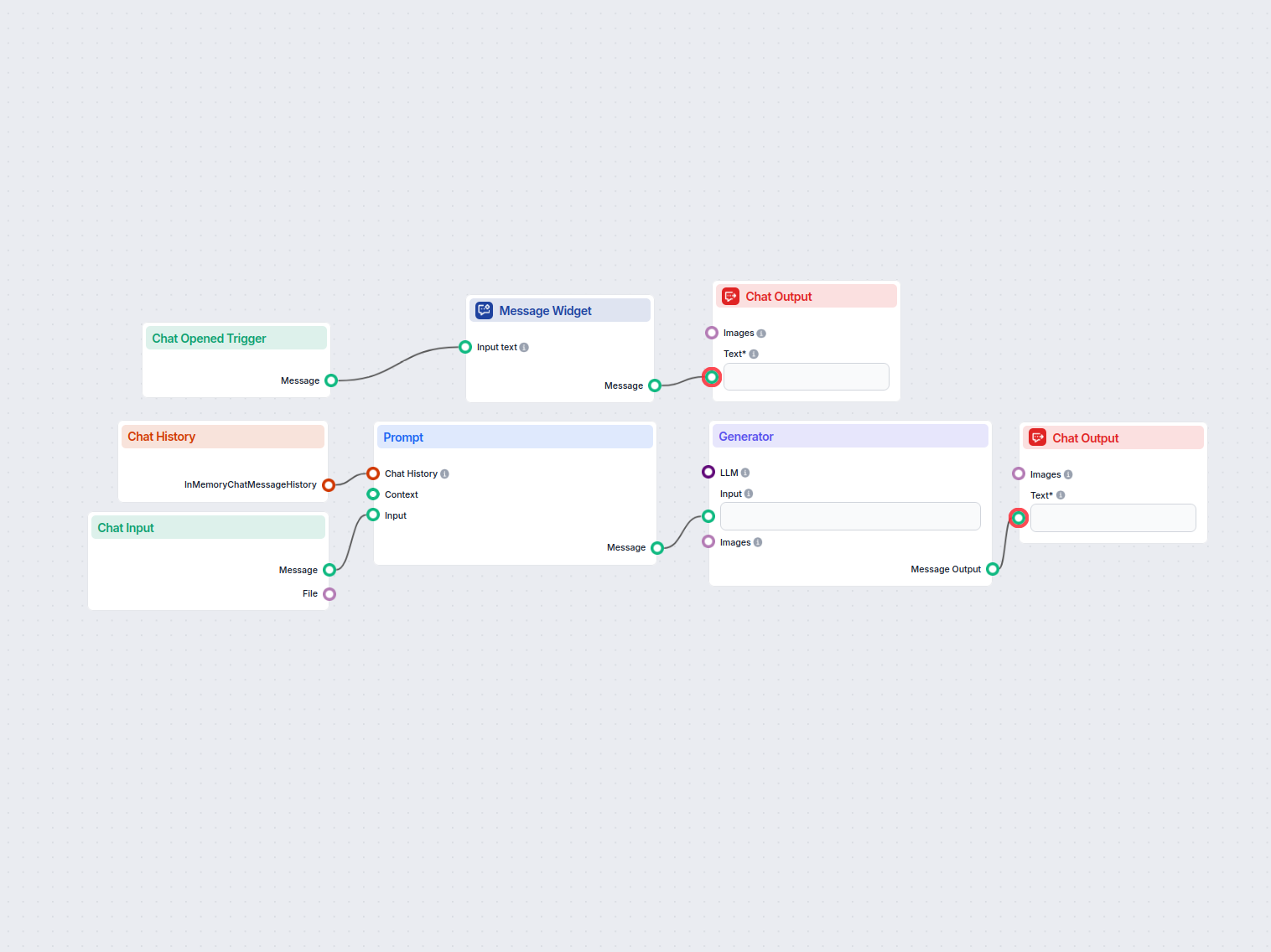

Ein einfacher Workflow für einen KI-Chat-Assistenten, der den bisherigen Gesprächsverlauf nutzt, um relevante Antworten auf Benutzereingaben zu generieren. Enth...

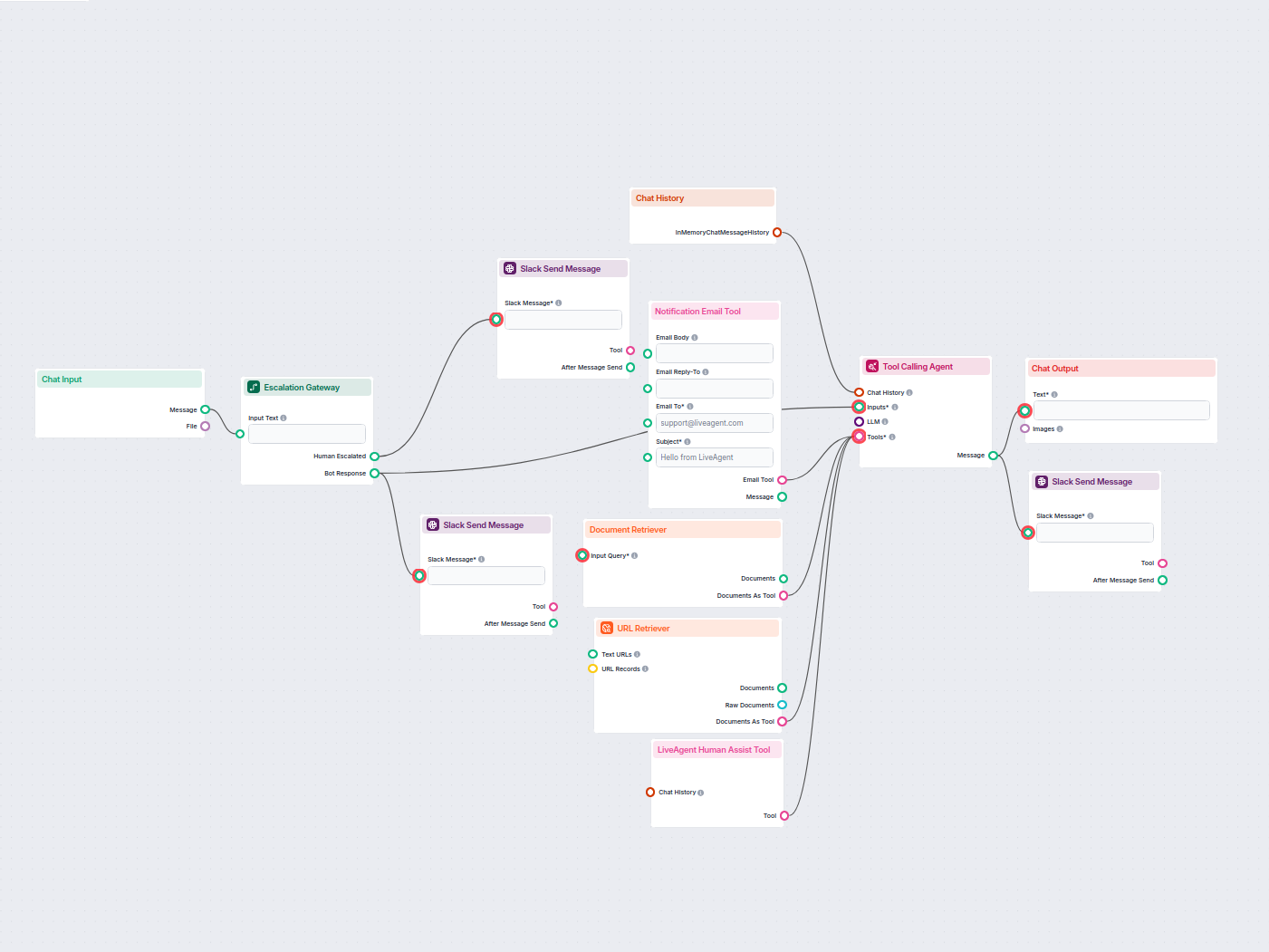

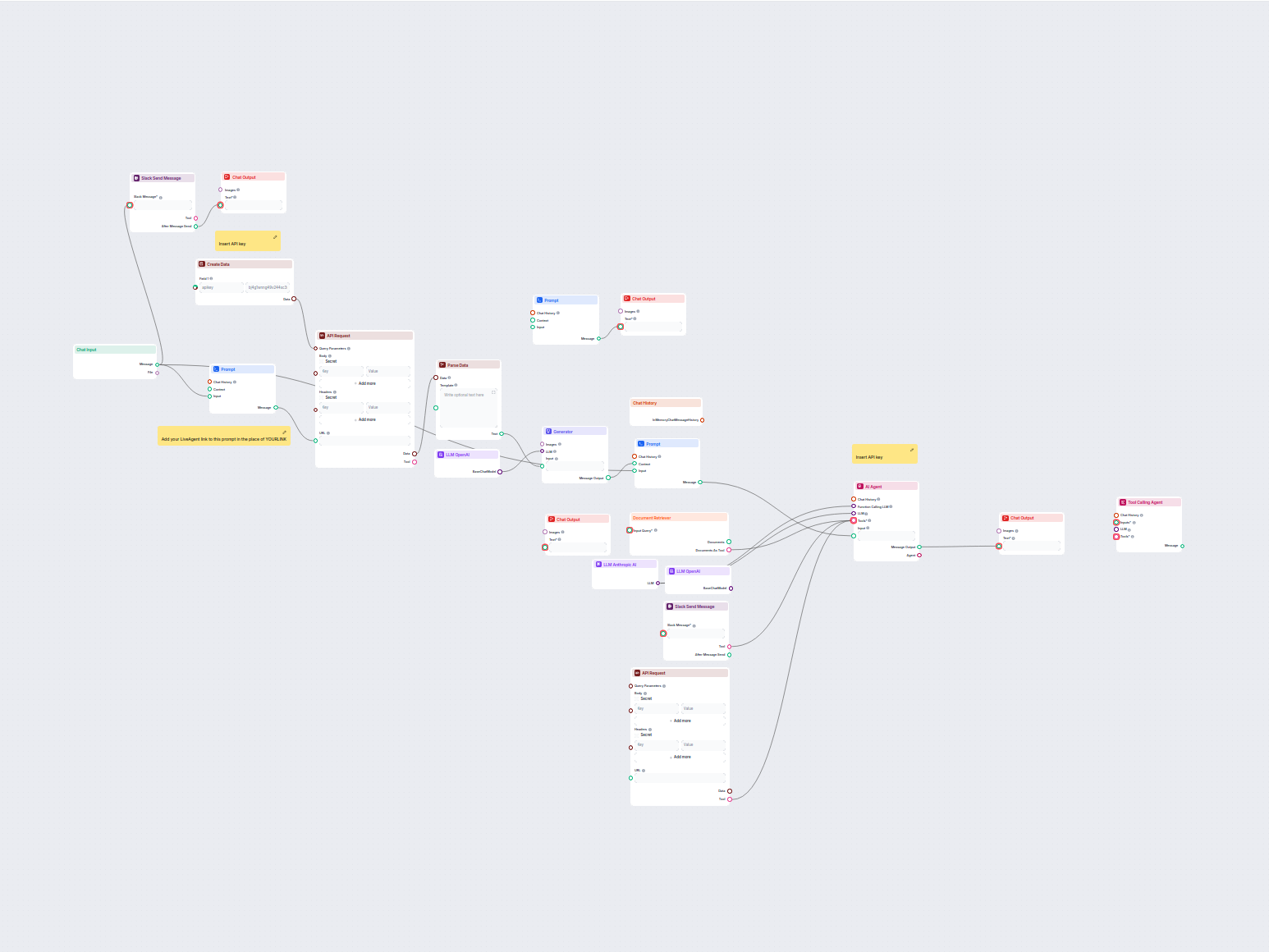

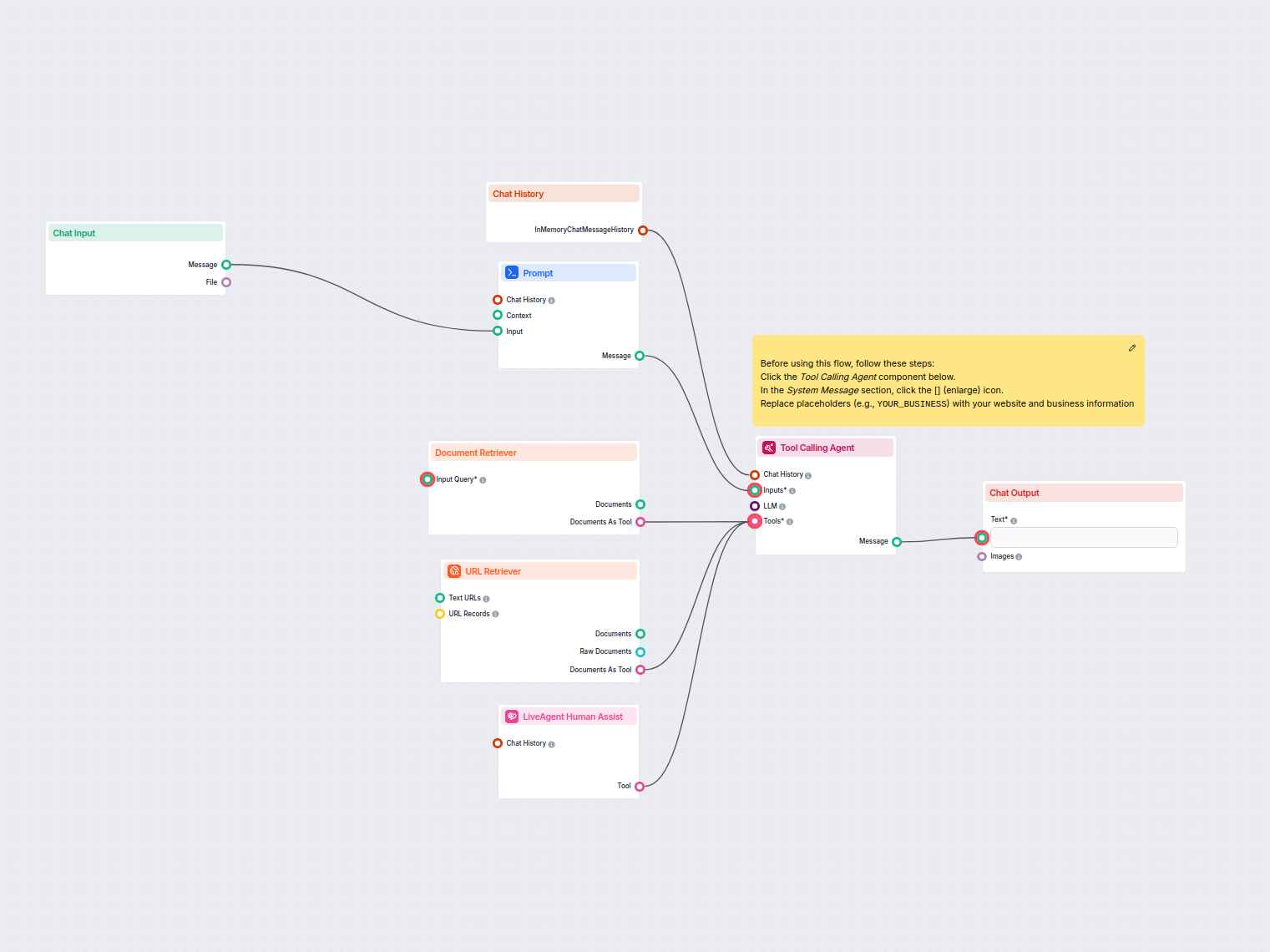

Stellen Sie einen intelligenten Kundensupport-Chatbot für LiveAgent bereit, der automatisch Besucherfragen beantwortet, Wissensdatenbankdokumente abruft und bei...

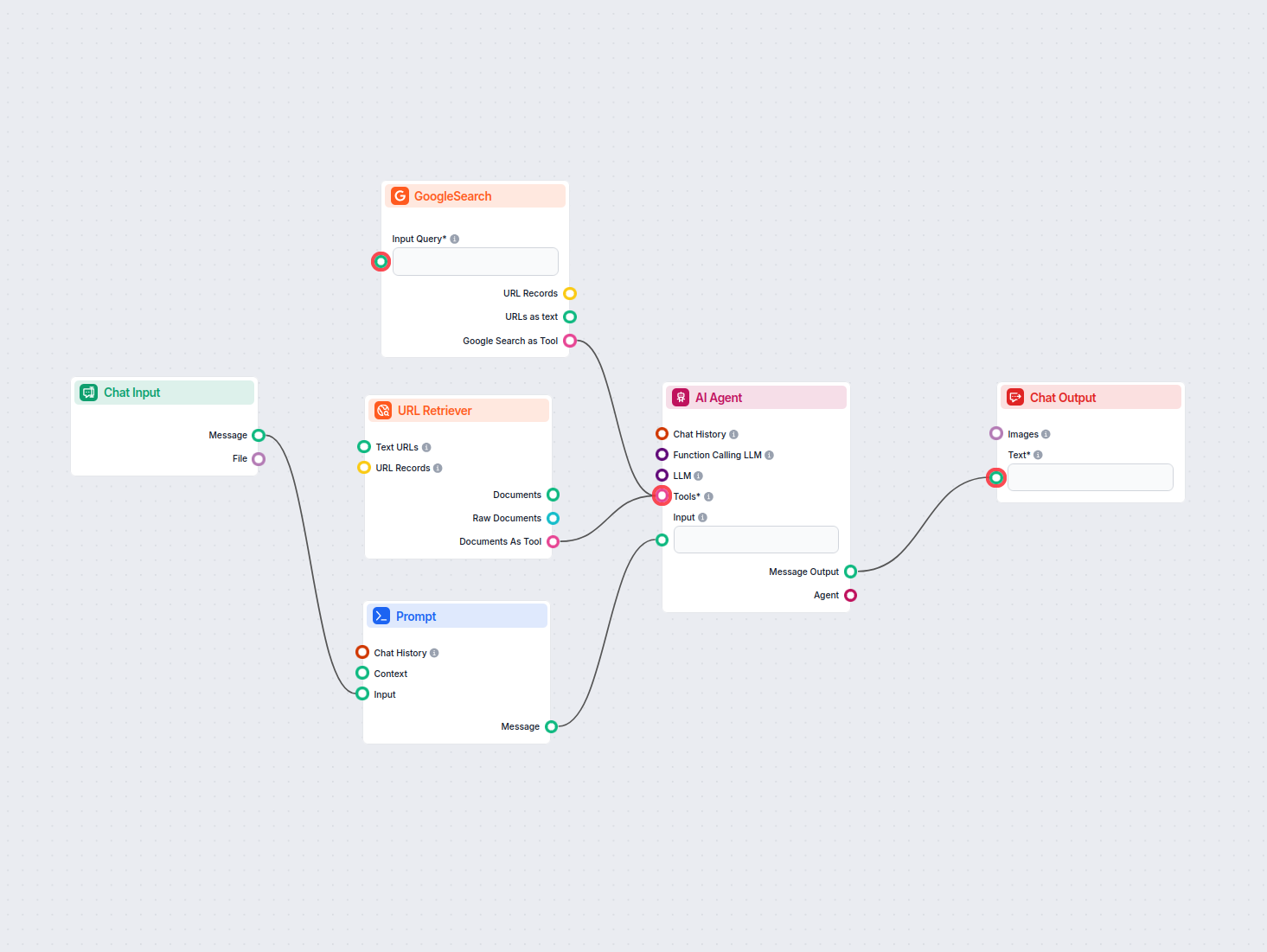

Erstellen Sie einzigartige Content-Ideen und Zusammenfassungen mithilfe von KI, indem Sie die Top-Google-Ergebnisse zu einem beliebigen Keyword recherchieren. I...

Erstellen Sie sofort strukturierte, klare E-Mails, die auf Ihren Ton und Ihre Absicht zugeschnitten sind – inklusive eines vorgeschlagenen Betreffs durch KI. Pe...

Erzeuge hochwertige KI-Bild-Prompts nach bewährten Methoden. Dieser Workflow nimmt Benutzereingaben entgegen, formatiert sie zu einem effektiven Prompt für die ...

Dieser KI-gestützte Workflow hilft Vertriebsmitarbeitern bei der Vorbereitung von Meetings, indem er ein umfassendes Vorbereitungssheet erstellt. Durch Angabe e...

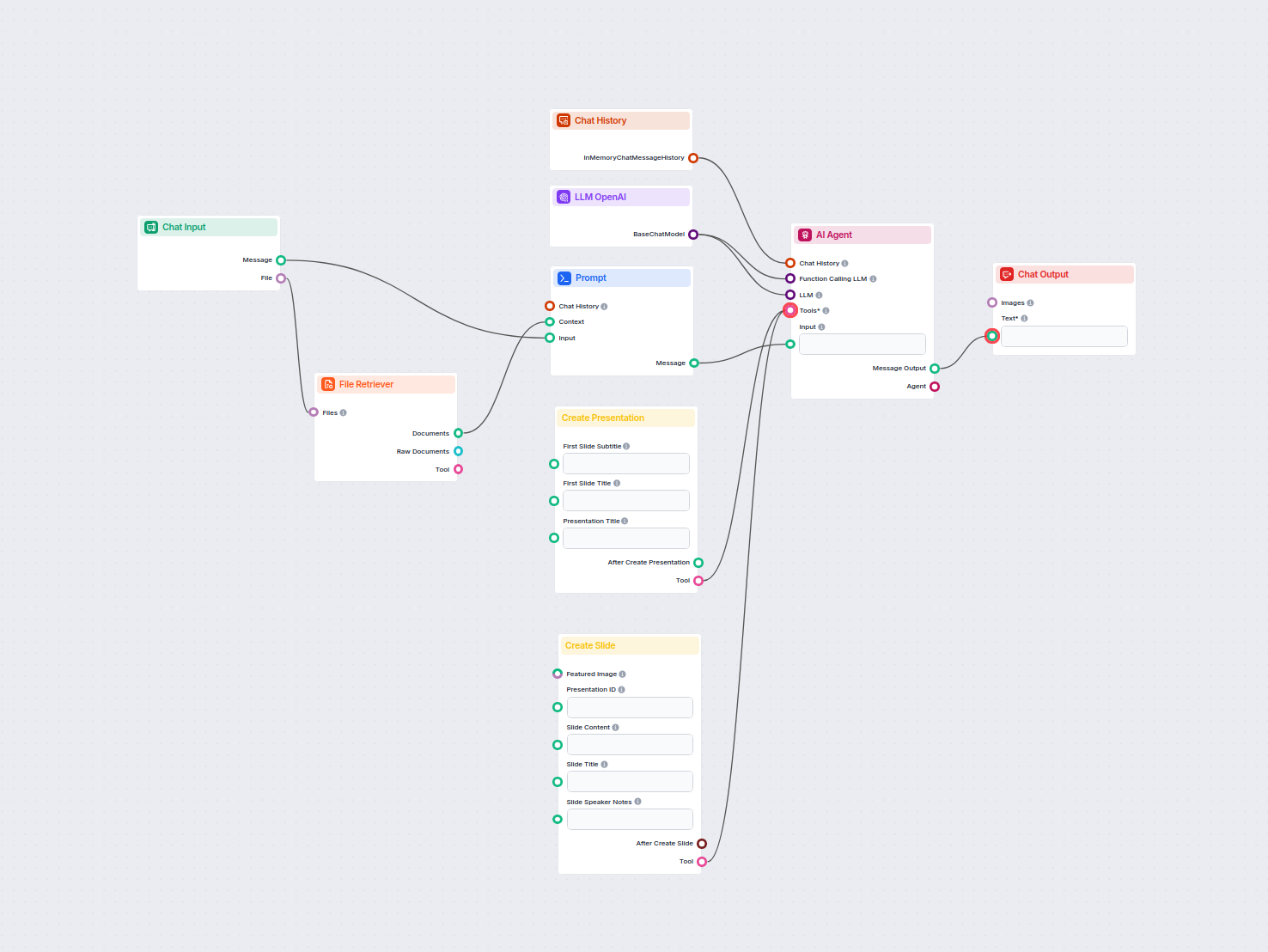

Automatisieren Sie die Erstellung professioneller Google Slides-Präsentationen aus beliebigen hochgeladenen Dokumenten mit KI. Dieser Workflow extrahiert den Do...

Dieser KI-Workflow analysiert jedes Unternehmen eingehend durch Recherche öffentlicher Daten und Dokumente und deckt Markt, Team, Produkte, Investitionen und me...

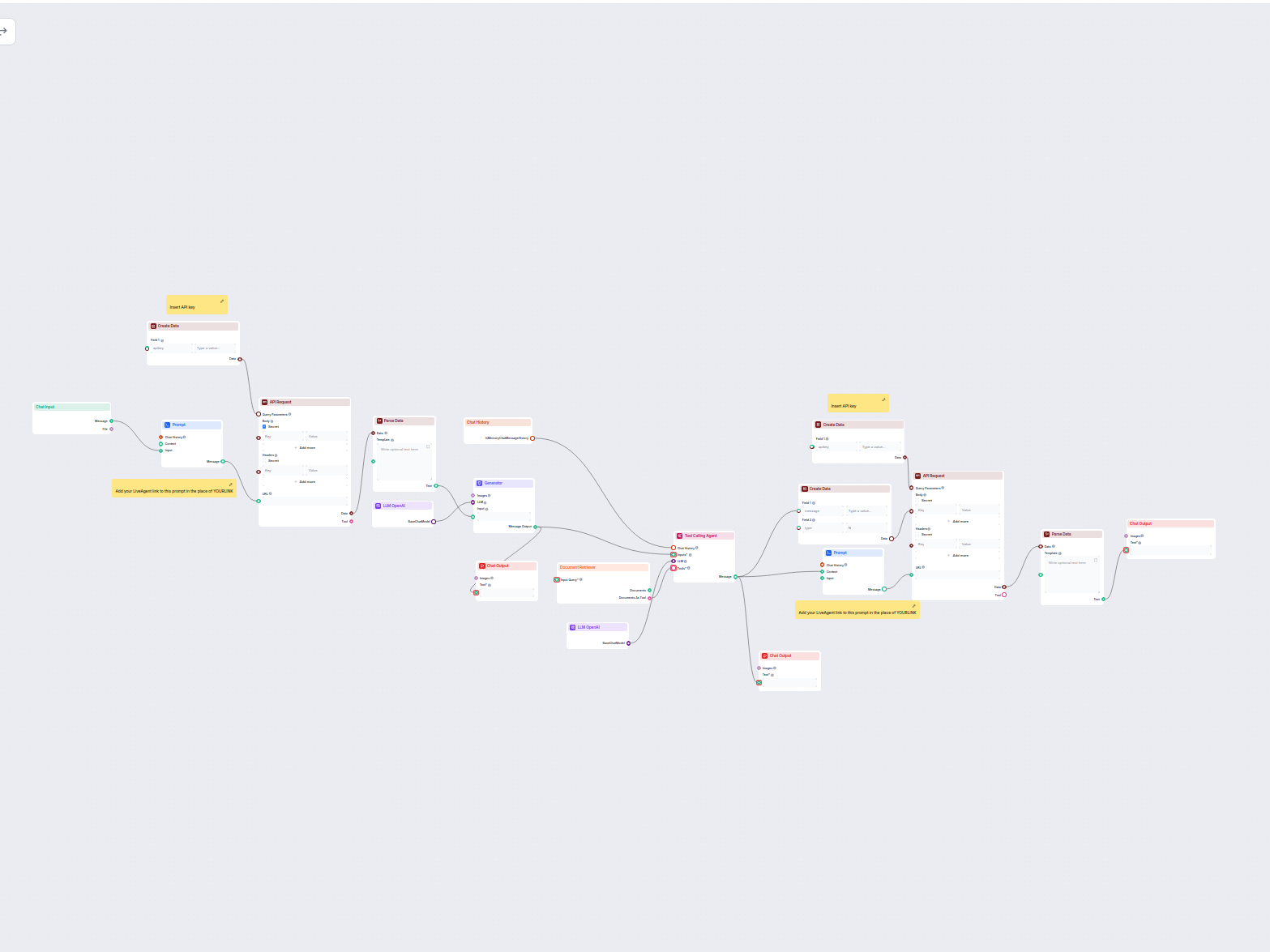

Ein KI-gestützter Kundenservice-Chatbot, der Ihre internen Wissensquellen nutzt, um sofortige, genaue und hilfreiche Antworten auf Kundenanfragen zu liefern. Er...

Dieser Workflow automatisiert den Kundensupport für Ihr Unternehmen, indem er LiveAgent-Konversationen integriert, relevante Konversationsdaten extrahiert, Antw...

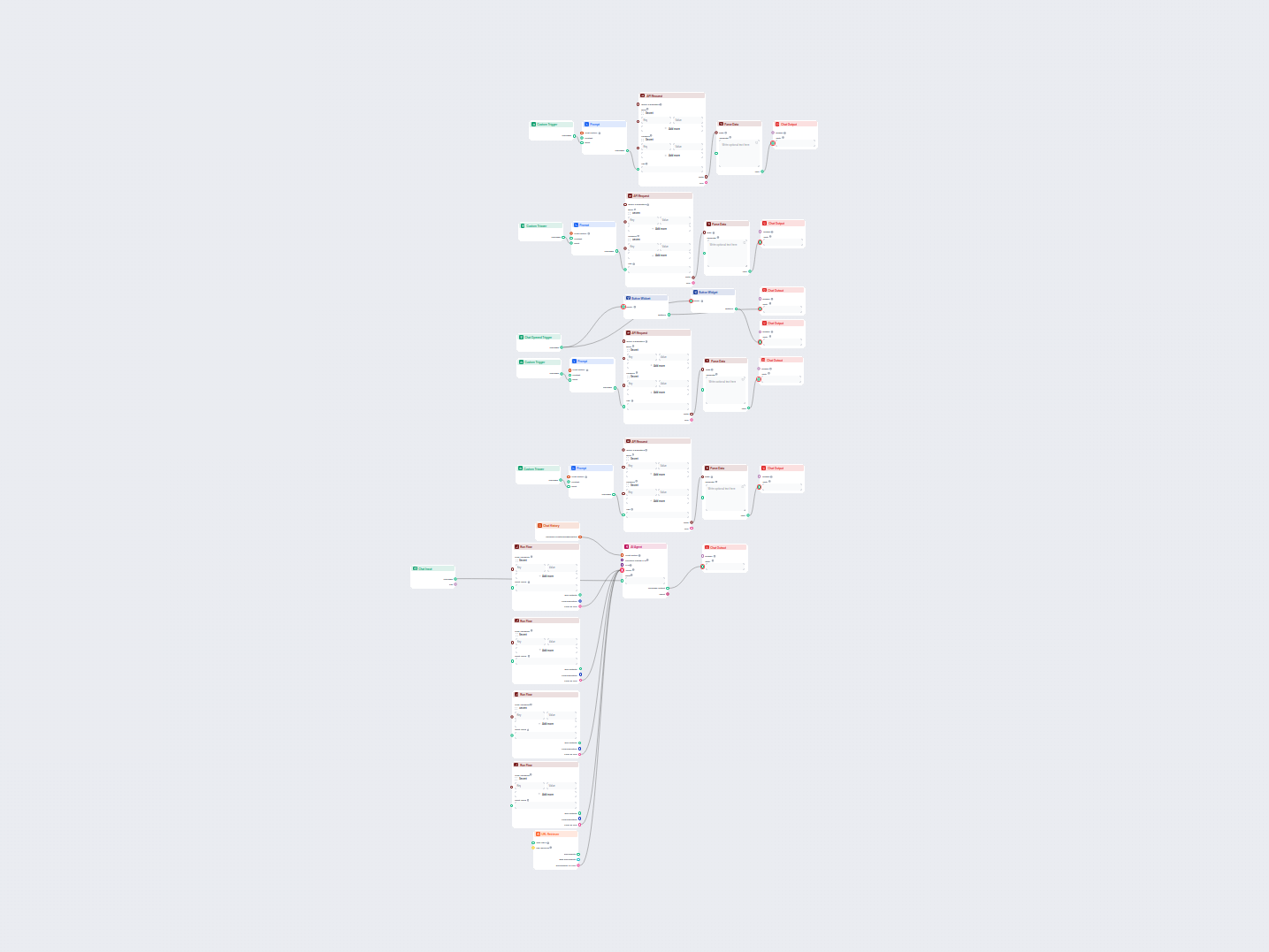

Dieser KI-gestützte Workflow automatisiert den Kundensupport, indem er Benutzeranfragen mit Wissensquellen des Unternehmens, externen APIs (wie LiveAgent) und e...

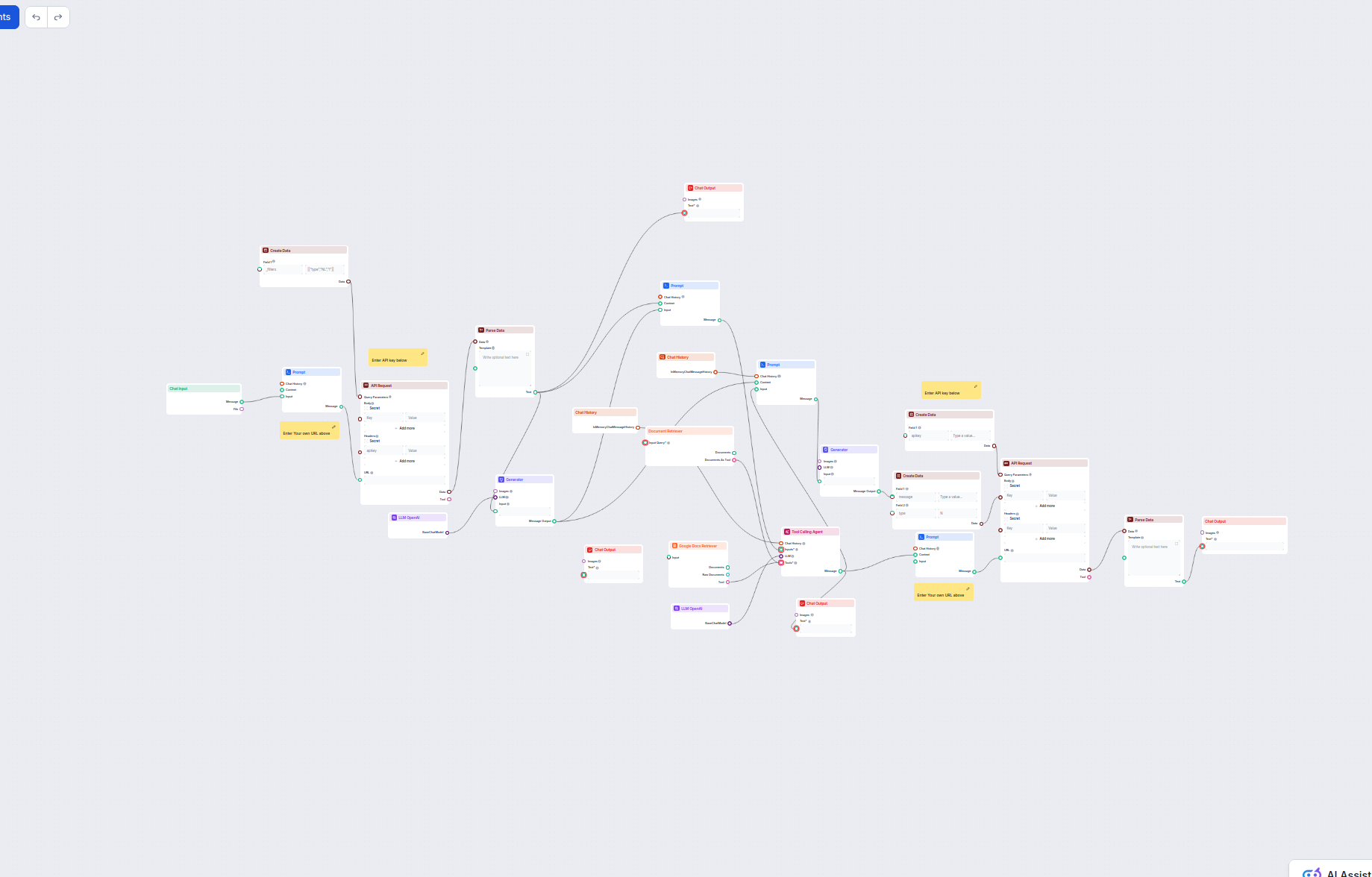

Dieser KI-gestützte Workflow automatisiert den Kundensupport durch die Kombination aus interner Wissensdatenbank-Suche, Google Docs-Wissensabruf, API-Integratio...

Erstellt automatisch ein maßgeschneidertes Mission Statement basierend auf Benutzereingaben und Chat-Kontext. Ideal für Startups, Unternehmer und Marketer, die ...

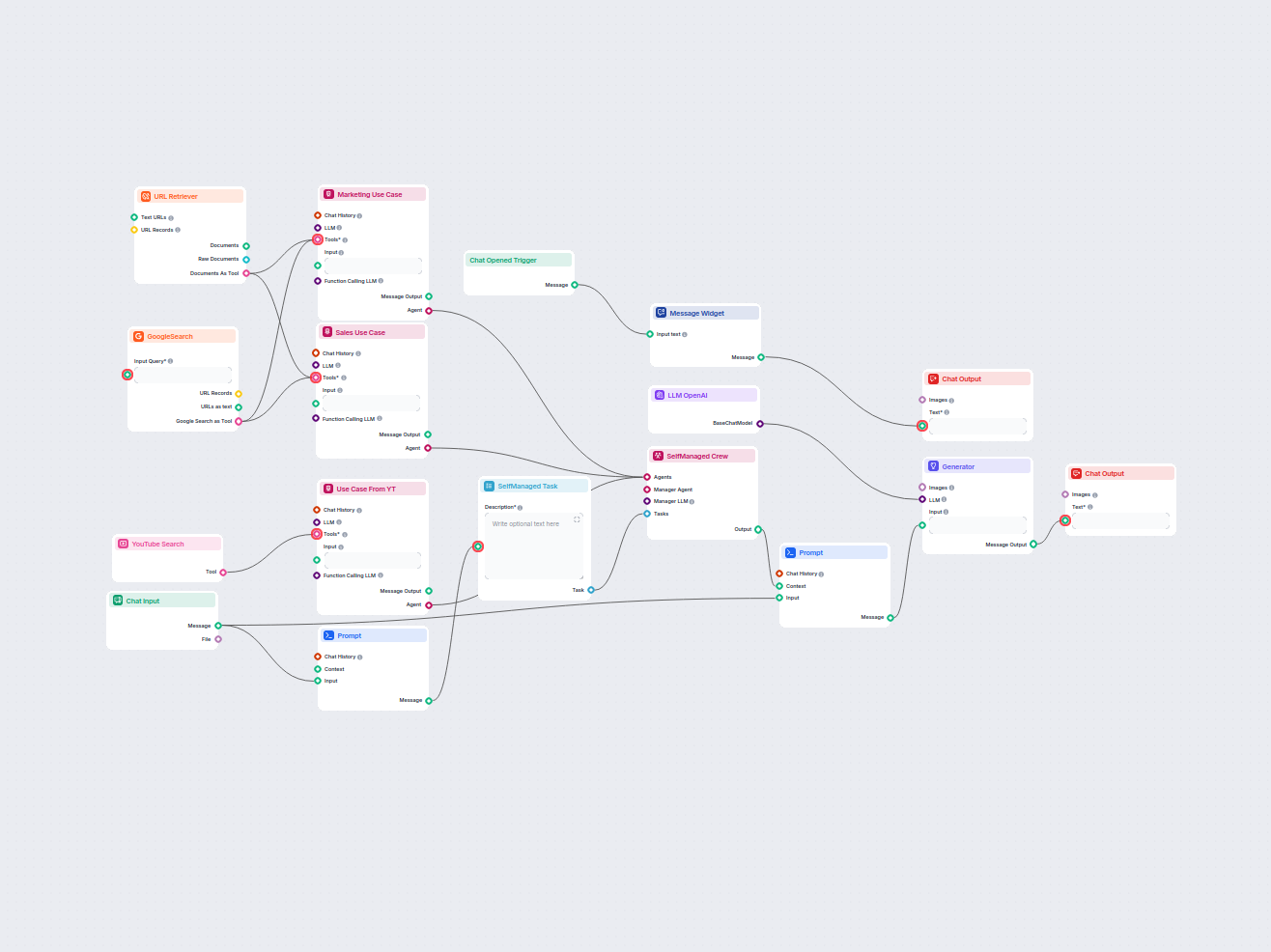

Erstellen Sie umfassende, KI-gesteuerte Berichte zu Anwendungsfällen von Softwareprodukten für Marketing und Vertrieb. Dieser Workflow recherchiert das Produkt ...

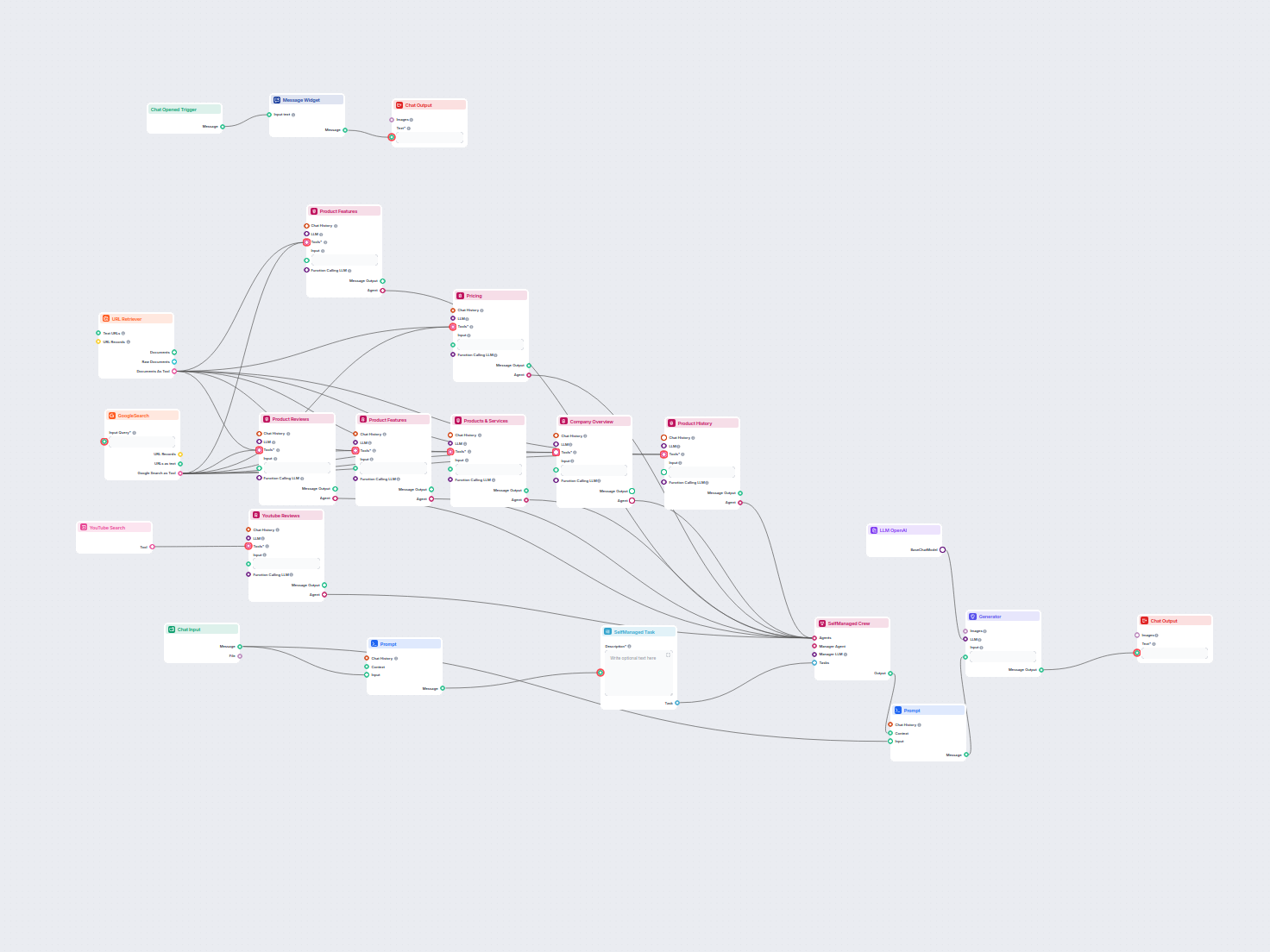

Erstellen Sie umfassende Produktanalysen mit KI-Agenten, die Produktinformationen, Preise, Funktionen, Bewertungen, Alternativen und mehr aus öffentlichen Inter...

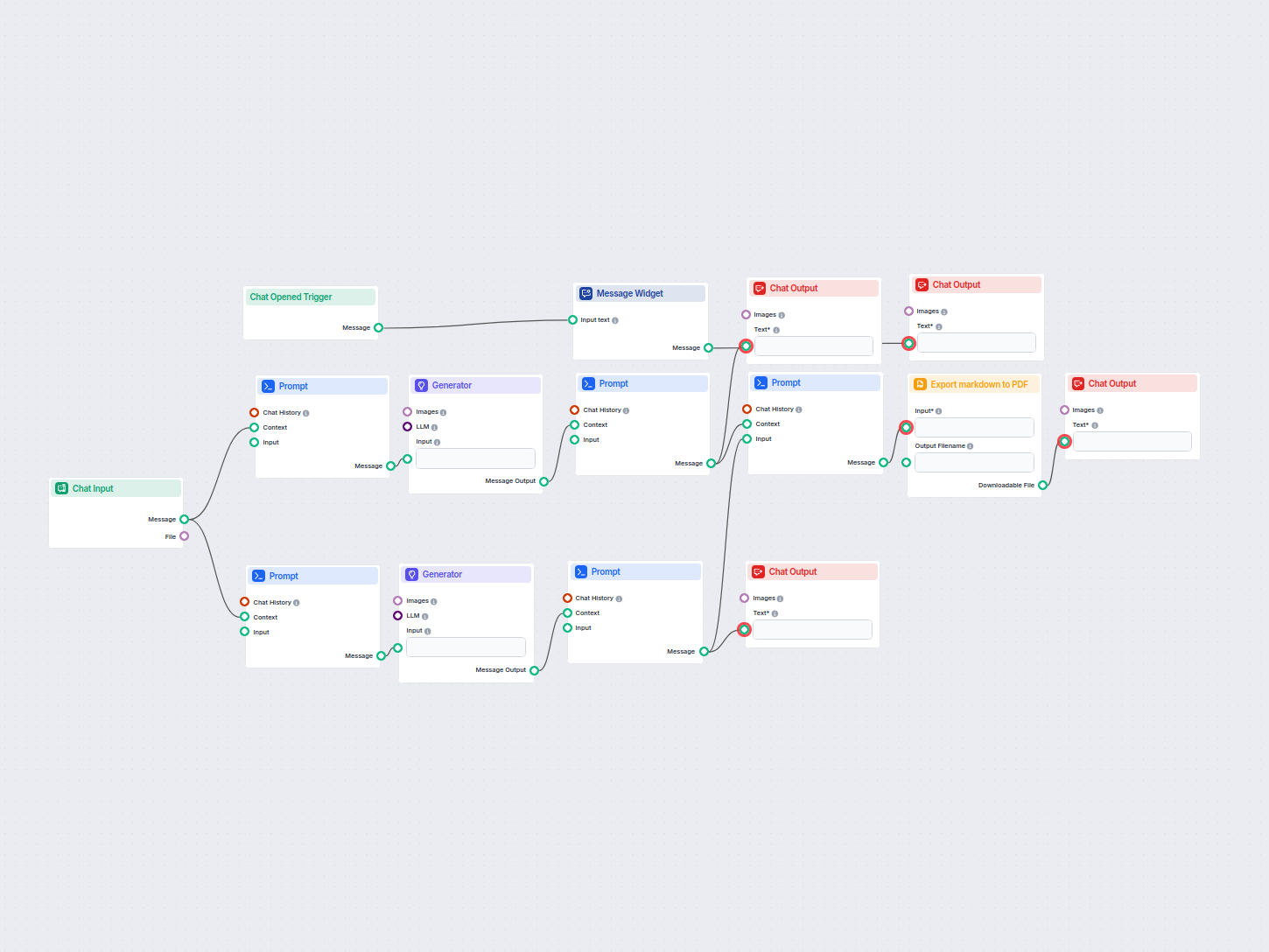

Erstellt automatisch umsetzbare Meeting-Protokolle und Follow-up-E-Mails aus Ihren Meeting-Anhängen mithilfe von KI und exportiert die Ergebnisse als PDF. Ideal...

Automatisieren Sie die Rechnungsverarbeitung, indem Sie Rechnungsbilder hochladen und die wichtigsten Rechnungsdaten extrahieren, wie Rechnungsnummer, Typ, Spra...

Erzeugen Sie einzigartige, SEO-optimierte Webseitentitel mit KI und aktuellen Google-Suchdaten. Geben Sie Ihre Ziel-Keywords ein und erhalten Sie einen auf aktu...

Erstellen Sie umfassende, SEO-optimierte Produktbewertungsartikel für Software-Tools, einschließlich detaillierter Funktionen, Preisgestaltung, Nutzerbewertunge...

Organisiert Ihre Keyword-Liste automatisch mithilfe von KI in Themen-Cluster und erstellt eine strukturierte, leicht analysierbare Tabelle für eine verbesserte ...

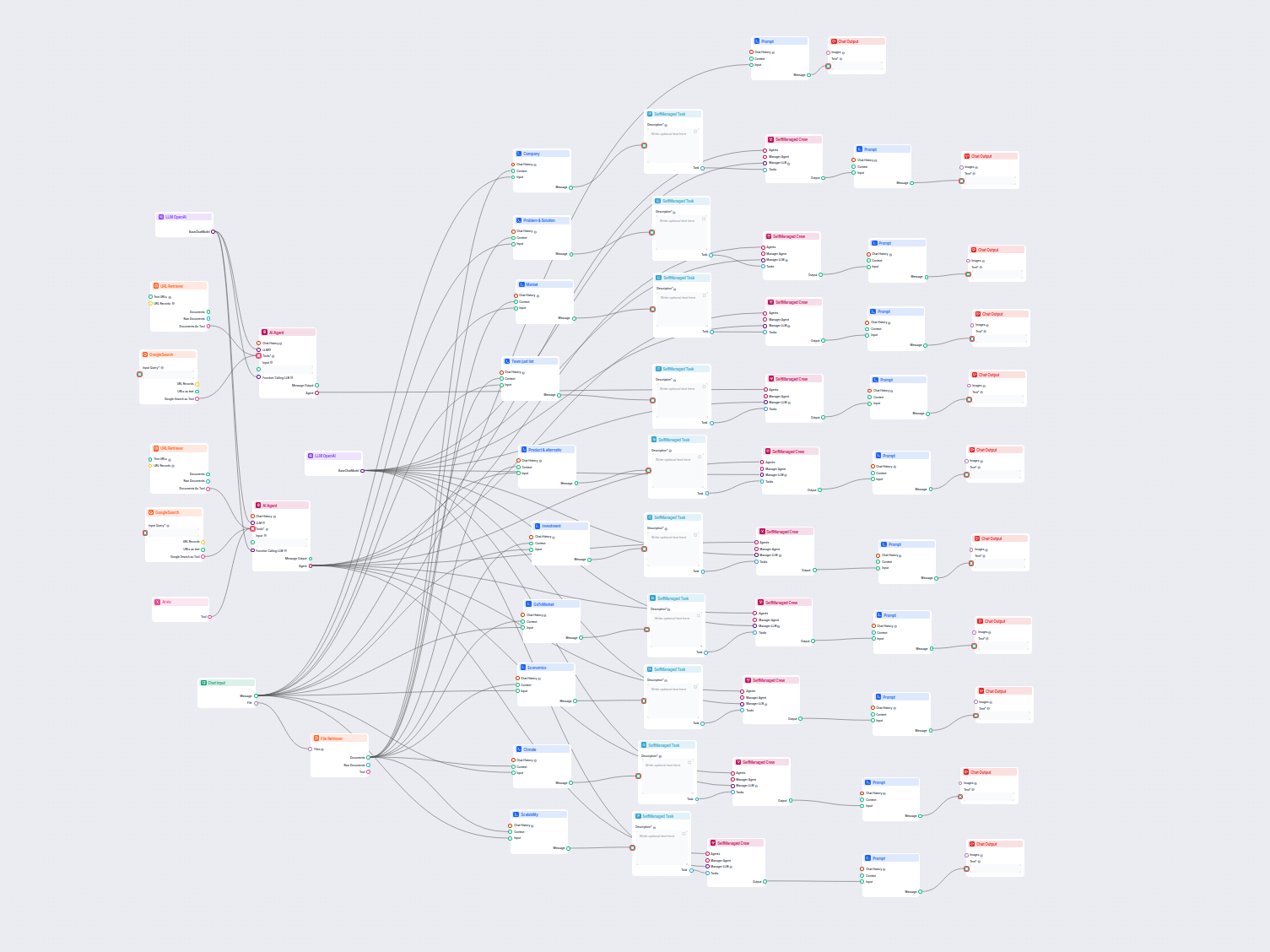

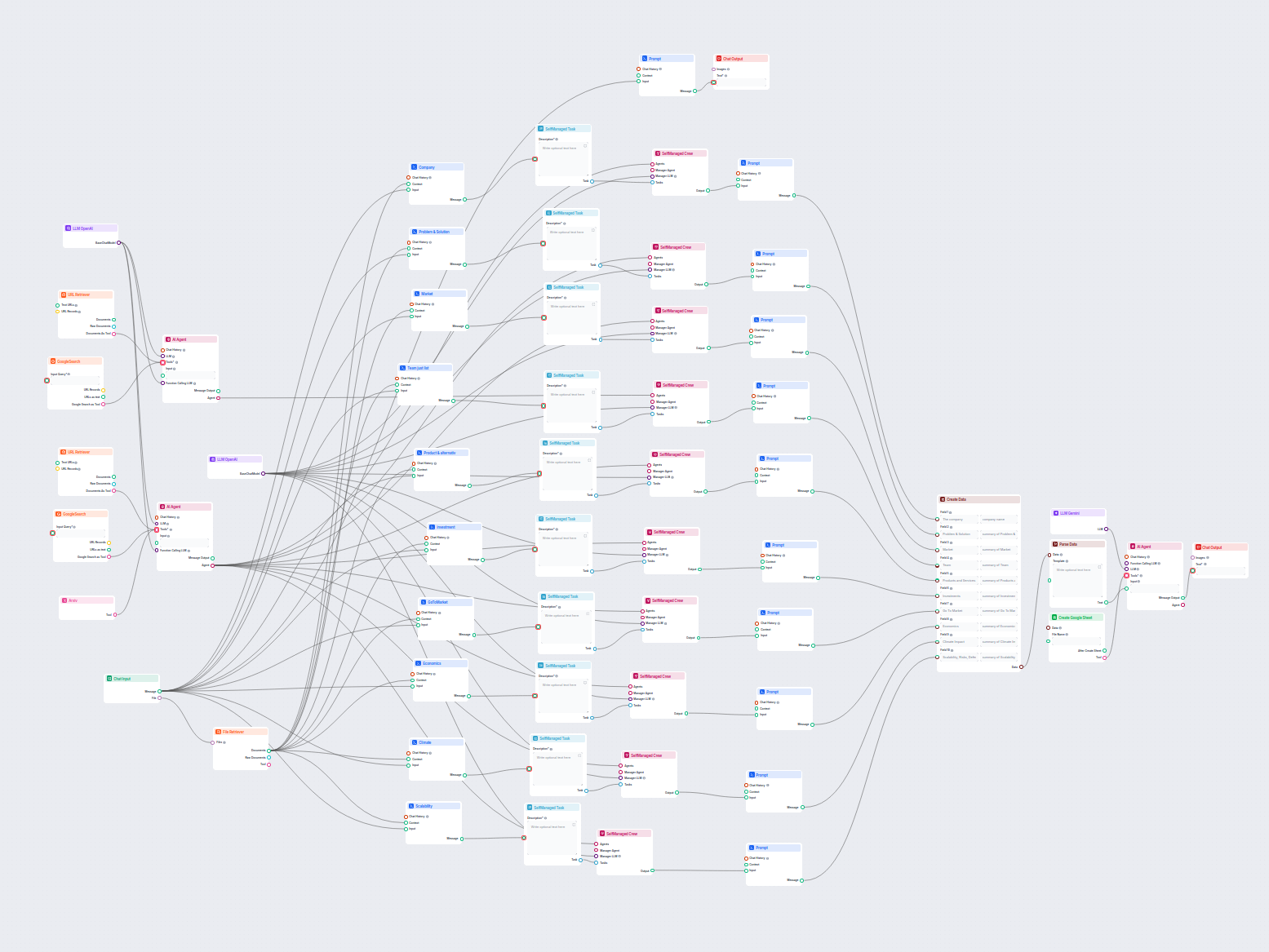

Umfassender KI-gesteuerter Workflow zur Unternehmensanalyse und Marktforschung. Sammelt und analysiert automatisch Daten zum Unternehmenshintergrund, zur Marktp...

Dieser KI-gestützte Workflow liefert eine umfassende, datenbasierte Unternehmensanalyse. Er sammelt Informationen zum Unternehmenshintergrund, Marktumfeld, Team...

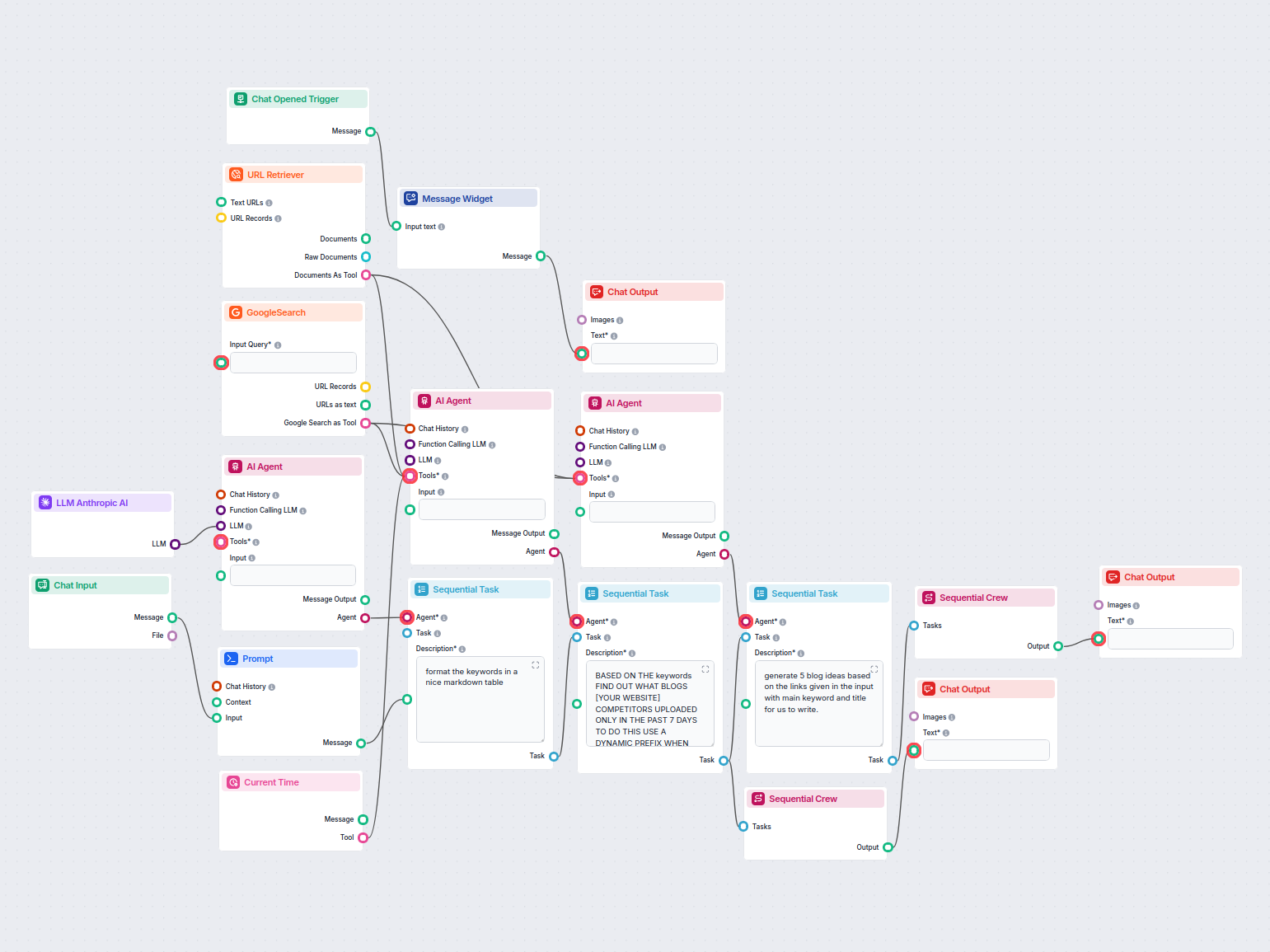

Analysieren Sie automatisch die bestplatzierten Konkurrenten-Blogs der vergangenen Woche und generieren Sie neue Blog-Ideen für Ihre Website. Dieser KI-Workflow...

Erstellen Sie einen LaTeX-formatierten Bibliographieeintrag für jeden wissenschaftlichen Artikel, indem Sie einfach dessen URL angeben. Dieser Workflow automati...

Erstellen Sie mühelos ansprechende LinkedIn-Post-Texte aus jeder Webseiten-URL. Dieser automatisierte Workflow extrahiert Inhalte von Ihrer Seite und verwandelt...

Automatisieren Sie den Kundensupport in LiveAgent mit einem KI-Chatbot, der Fragen mithilfe Ihrer internen Wissensdatenbank beantwortet, relevante Dokumente abr...

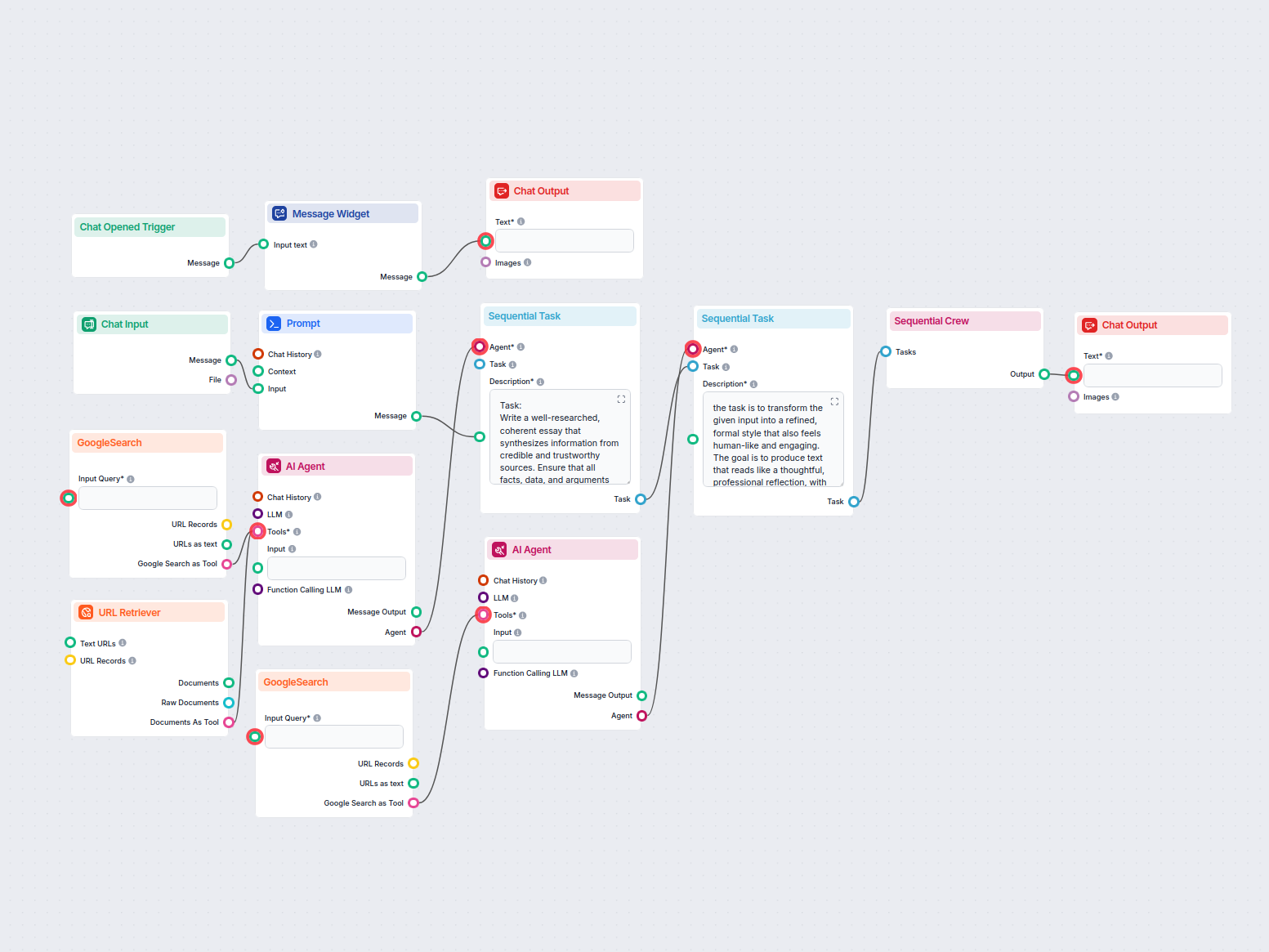

Erstellt automatisch faktenbasierte, gut strukturierte Aufsätze im MLA-Format unter Verwendung glaubwürdiger, über Google-Suche gefundener Quellen. Ideal für St...

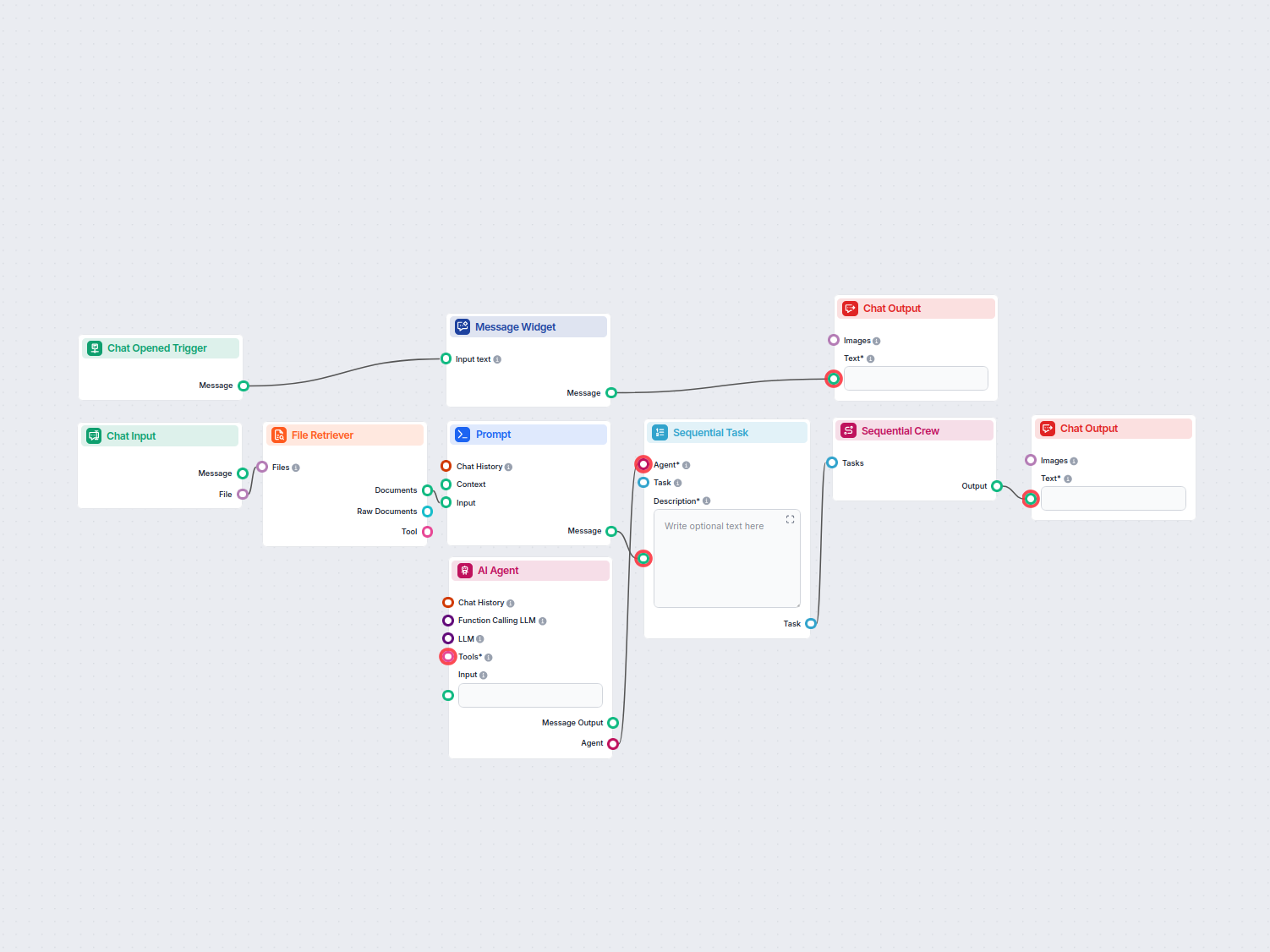

Verwandeln Sie mühelos den Inhalt Ihrer PDFs oder Präsentationsfolien mithilfe von KI in hochrangige, strukturierte Blogpost-Ideen. Laden Sie Ihr Dokument hoch ...

Anzeige 1 bis 60 von 79 Ergebnissen

Die Prompt-Komponente gibt dem Bot Anweisungen und Kontext, damit er auf die gewünschte Weise antwortet.

Für viele Anwendungsfälle ist es eine gute Idee, aber die Komponente ist optional.

Es ist ein bearbeitbares Textfeld, in dem Sie die Persönlichkeit und Rolle des Bots festlegen. Füllen Sie einfach die Vorlage aus: 'Du bist ein {role}, der {behavior}.' Zum Beispiel: 'Du bist ein hilfsbereiter Kundenservice-Bot, der wie ein mittelalterlicher Ritter spricht.'

Es ist auf jeden Fall eine gute Idee, sie für viele Anwendungsfälle einzubinden, aber die Komponente ist optional.

Beginnen Sie mit dem Aufbau personalisierter, kontextbewusster KI-Chatbots mit der intuitiven Prompt-Funktion von FlowHunt. Definieren Sie Rollen, Verhalten und steuern Sie die Ausgabe für intelligentere Automatisierungen.

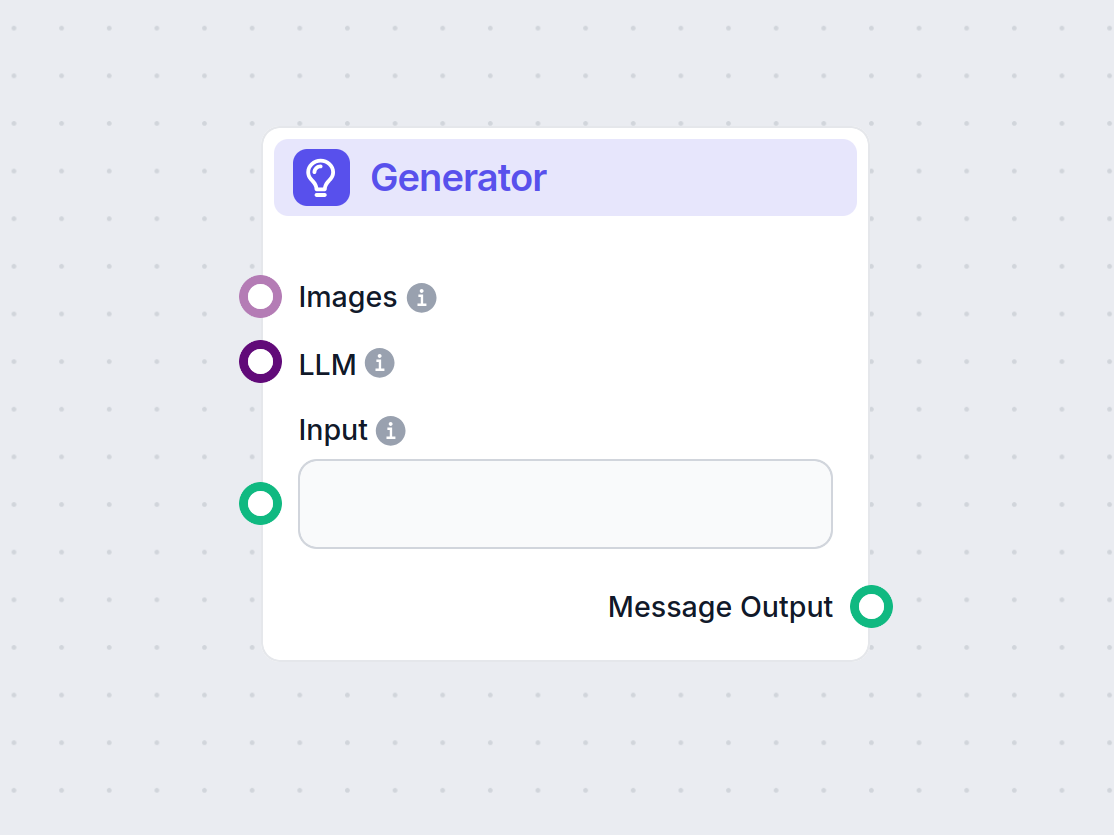

Entdecken Sie die Komponente Generator in FlowHunt – leistungsstarke, KI-gesteuerte Textgenerierung mit Ihrem gewählten LLM-Modell. Erstellen Sie mühelos dynami...

Entdecken Sie gängige Prompt-Engineering-Techniken, um Ihren E-Commerce-Chatbot effektiver auf Kundenfragen antworten zu lassen.

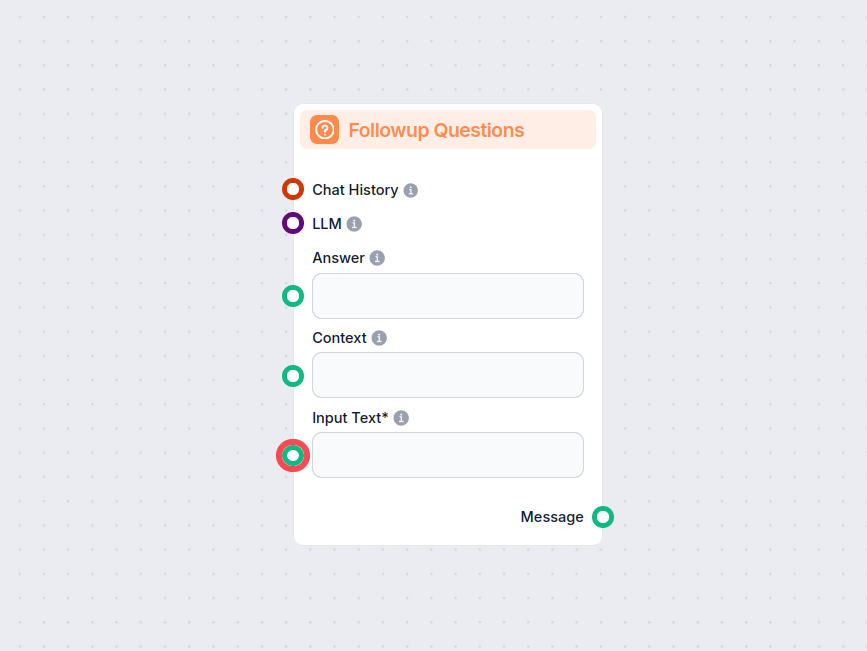

Die Komponente Folgefragen in FlowHunt generiert intelligent relevante Fragen, die Nutzer als nächstes stellen können – basierend auf dem aktuellen Gespräch, Ko...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.