Integrazione del Server ModelContextProtocol (MCP)

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

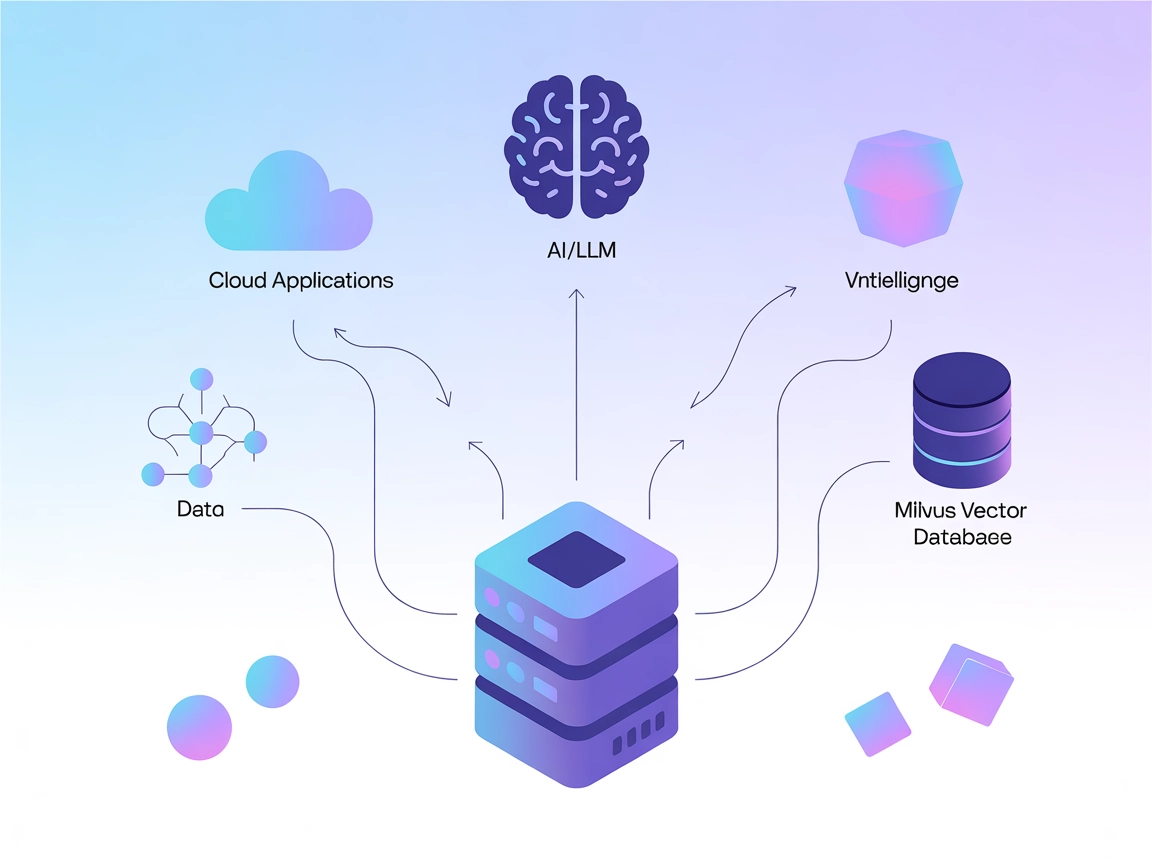

Collega LLM e agenti AI a Milvus per una potente ricerca vettoriale, memoria contestuale e raccomandazioni basate sui dati direttamente nei tuoi workflow FlowHunt.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

Il Milvus MCP (Model Context Protocol) Server collega assistenti AI e applicazioni basate su LLM con il database vettoriale Milvus. Questo permette l’interazione fluida tra modelli linguistici e dati vettoriali su larga scala, offrendo un modo standardizzato per accedere, interrogare e gestire Milvus direttamente dai workflow AI. Utilizzando il Milvus MCP Server, gli sviluppatori possono integrare ricerca, recupero e gestione dati basati su Milvus direttamente nei propri agenti AI, IDE o interfacce chat. Il server supporta molteplici modalità di comunicazione (stdio e Server-Sent Events), adattandosi così a diversi scenari di deploy e ambienti di sviluppo. Collegando LLM e Milvus, potenzia enormemente la capacità dei sistemi AI di eseguire operazioni contestuali su dati ad alta dimensionalità, sbloccando esperienze LLM molto più ricche e intelligenti.

Nessuna informazione sui template di prompt è fornita nel repository.

Nessun elenco esplicito di “risorse” Model Context Protocol è descritto nella documentazione o nel codice disponibile.

Nessun elenco esplicito di strumenti o nomi funzione è documentato nella documentazione o nei file di codice, incluso server.py.

git clone https://github.com/zilliztech/mcp-server-milvus.gituv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Protezione delle API key:

Se il server richiede dati sensibili, usa variabili d’ambiente:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

},

"inputs": {}

}

{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Proteggi le credenziali tramite variabili d’ambiente come sopra.

uv.uv run src/mcp_server_milvus/server.py --milvus-uri http://localhost:19530{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Protezione delle API key:

Usa le variabili d’ambiente come sopra.

uv.{

"mcpServers": {

"milvus-mcp": {

"command": "uv",

"args": ["run", "src/mcp_server_milvus/server.py", "--milvus-uri", "http://localhost:19530"]

}

}

}

Variabili d’ambiente:

{

"env": {

"MILVUS_URI": "http://localhost:19530"

}

}

Utilizzo di MCP in FlowHunt

Per integrare MCP server nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo MCP server utilizzando questo formato JSON:

{

"milvus-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento, con accesso a tutte le sue funzioni e capacità. Ricorda di sostituire “milvus-mcp” con il vero nome del tuo MCP server e di cambiare la URL con quella del tuo MCP server.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt documentato |

| Elenco delle Risorse | ⛔ | Nessun elenco esplicito di risorse MCP |

| Elenco degli Strumenti | ⛔ | Nessuno strumento esplicito elencato nei file disponibili |

| Gestione API Keys | ✅ | Usa variabili d’ambiente, documentato negli esempi di configurazione |

| Supporto Sampling (meno rilevante in valutazione) | ⛔ | Non menzionato |

Supporto Roots: Non menzionato

Supporto Sampling: Non menzionato

Il Milvus MCP Server è un ponte pratico e focalizzato per collegare LLM a Milvus, con guide di setup chiare per i principali strumenti di sviluppo. Tuttavia, la documentazione è carente di dettagli su risorse MCP, prompt e API degli strumenti, il che ne limita la scoperta immediata. Resta comunque una solida base per integrazioni AI basate su vettori.

| Ha una LICENSE | ✅ (Apache-2.0) |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 32 |

| Numero di Star | 139 |

Totale: 4/10

Il server è utile per la sua nicchia ma trarrebbe grande beneficio da una documentazione più esplicita su risorse, template di prompt e API degli strumenti per massima interoperabilità e facilità d’uso.

Il Milvus MCP Server fa da ponte tra assistenti AI e applicazioni LLM e il database vettoriale Milvus, abilitando ricerca vettoriale, memoria contestuale e gestione dati senza soluzione di continuità per workflow AI avanzati.

I principali casi d'uso includono ricerca vettoriale, gestione degli embedding, memoria contestuale per chatbot, raccomandazioni AI e analisi dati in tempo reale tramite Milvus in FlowHunt.

Usa variabili d'ambiente (ad es. MILVUS_URI) per memorizzare informazioni di connessione sensibili, come illustrato nelle guide di configurazione per ciascun client supportato.

Non sono documentati template di prompt o API di strumenti espliciti. Il server si concentra nel fornire un ponte per operazioni vettoriali e gestione degli embedding.

È una base solida per collegare LLM a database vettoriali, con istruzioni di setup chiare, ma beneficerebbe di maggiore documentazione su prompt e API degli strumenti per una migliore individuabilità e integrazione.

Migliora i tuoi agenti AI con accesso immediato ai database vettoriali, abilitando ricerche più intelligenti, raccomandazioni e memoria contestuale. Integra subito Milvus MCP Server con FlowHunt!

Il Server ModelContextProtocol (MCP) funge da ponte tra agenti AI e fonti dati esterne, API e servizi, consentendo agli utenti FlowHunt di costruire assistenti ...

Il Litmus MCP Server consente un'integrazione senza soluzione di continuità tra Large Language Model (LLM) e Litmus Edge per la configurazione, il monitoraggio ...

Integra DevHub CMS con assistenti AI e LLM tramite il DevHub CMS MCP Server. Abilita la gestione fluida dell’elenco delle attività, i flussi di lavoro sui conte...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.