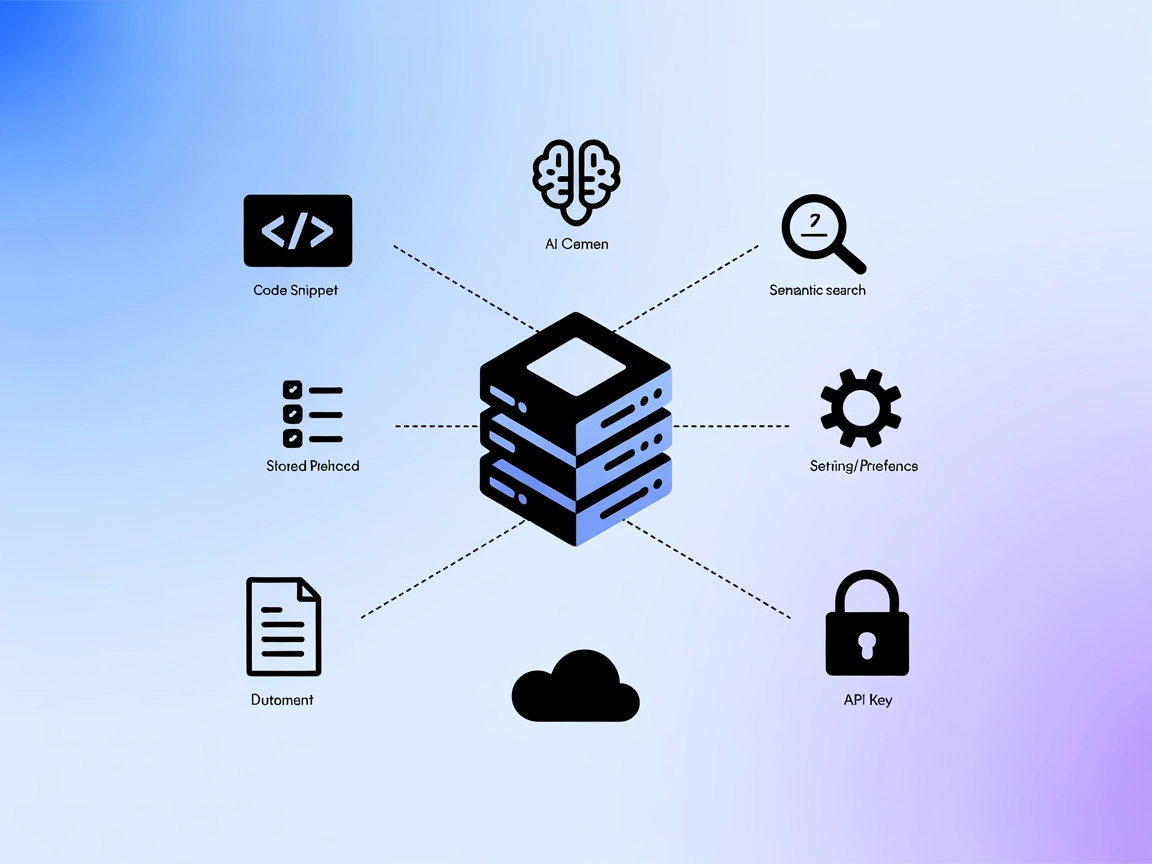

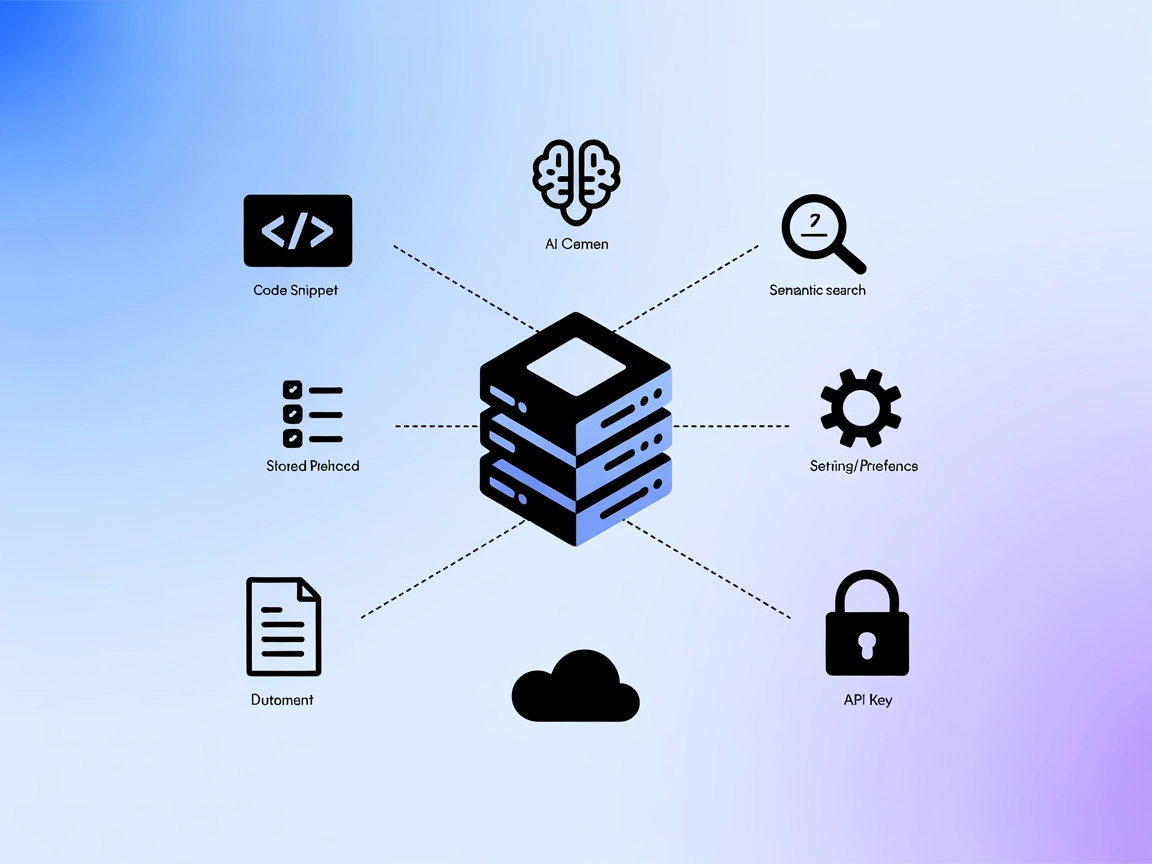

mem0 MCP Server

De mem0 MCP Server verbindt AI-assistenten met gestructureerde opslag, retrieval en semantische zoekmogelijkheden voor codefragmenten, documentatie en best prac...

Activeer veilig, persistent en multi-sessie AI-geheugen met Membase MCP Server—een gedecentraliseerde geheugen-gateway voor robuuste agentcontinuïteit en compliance.

FlowHunt biedt een extra beveiligingslaag tussen uw interne systemen en AI-tools, waardoor u granulaire controle heeft over welke tools toegankelijk zijn vanaf uw MCP-servers. MCP-servers die in onze infrastructuur worden gehost, kunnen naadloos worden geïntegreerd met FlowHunt's chatbot evenals populaire AI-platforms zoals ChatGPT, Claude en verschillende AI-editors.

De Membase MCP (Model Context Protocol) Server fungeert als een lichte, gedecentraliseerde geheugen-gateway voor AI-agenten, die hen verbindt met Membase voor veilig, persistent en verifieerbaar multi-sessie geheugen. Aangedreven door Unibase kunnen AI-assistenten gespreksgeschiedenis, interactierecords en kennis uploaden en ophalen, wat zorgt voor agentcontinuïteit, personalisatie en traceerbaarheid. Door te integreren met het Membase-protocol, maakt de server naadloze opslag en het ophalen van geheugen-data uit het Unibase-gedecentraliseerde netwerk mogelijk, wat ondersteuning biedt voor use-cases waarbij persistent, onvervalst geheugen essentieel is voor AI-gedreven workflows.

Er worden geen prompt-sjablonen genoemd in de repository.

Er worden geen expliciete MCP-bronnen beschreven in de repository.

uv runner).git clone https://github.com/unibaseio/membase-mcp.git{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "jouw account, 0x...",

"MEMBASE_CONVERSATION_ID": "jouw conversatie-id, moet uniek zijn",

"MEMBASE_ID": "jouw subaccount, willekeurige string"

}

}

}

}

Beveiliging van API-sleutels:

Gebruik omgevingsvariabelen in het env-blok om referenties veilig te houden.

uv runner en Python).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "jouw account, 0x...",

"MEMBASE_CONVERSATION_ID": "jouw conversatie-id, moet uniek zijn",

"MEMBASE_ID": "jouw subaccount, willekeurige string"

}

}

}

}

Let op: Sla gevoelige informatie als omgevingsvariabelen op.

uv).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "jouw account, 0x...",

"MEMBASE_CONVERSATION_ID": "jouw conversatie-id, moet uniek zijn",

"MEMBASE_ID": "jouw subaccount, willekeurige string"

}

}

}

}

uv, Python).{

"mcpServers": {

"membase": {

"command": "uv",

"args": [

"--directory",

"path/to/membase-mcp",

"run",

"src/membase_mcp/server.py"

],

"env": {

"MEMBASE_ACCOUNT": "jouw account, 0x...",

"MEMBASE_CONVERSATION_ID": "jouw conversatie-id, moet uniek zijn",

"MEMBASE_ID": "jouw subaccount, willekeurige string"

}

}

}

}

Beveiliging van API-sleutels:

Alle gevoelige referenties moeten in het env-object worden doorgegeven zoals hierboven, om hardcoding te vermijden.

MCP gebruiken in FlowHunt

Om MCP-servers in je FlowHunt-workflow te integreren, begin je met het toevoegen van de MCP-component aan je flow en verbind je deze met je AI-agent:

Klik op de MCP-component om het configuratiepaneel te openen. Voeg in het systeem MCP-configuratiegedeelte je MCP-servergegevens in met dit JSON-formaat:

{

"MCP-name": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Na configuratie kan de AI-agent deze MCP nu als tool gebruiken met toegang tot alle functies en mogelijkheden. Vergeet niet “MCP-name” te vervangen door de daadwerkelijke naam van je MCP-server (bijv. “github-mcp”, “weather-api”, etc.) en de URL te vervangen door je eigen MCP-server-URL.

| Sectie | Beschikbaarheid | Details/Opmerkingen |

|---|---|---|

| Overzicht | ✅ | |

| Lijst van Prompts | ⛔ | Geen herbruikbare prompt-sjablonen voorzien |

| Lijst van Bronnen | ⛔ | Geen expliciete MCP-bronnen vermeld |

| Lijst van Tools | ✅ | get_conversation_id, switch_conversation, save_message, get_messages |

| Beveiliging API-sleutels | ✅ | Gebruikt omgevingsvariabelen in configuratie |

| Sampling Support (minder belangrijk bij beoordeling) | ⛔ | Niet vermeld |

Op basis van de beschikbare informatie biedt Membase MCP Server kerngeheugentools en duidelijke installatie-instructies, maar ontbreken prompt-sjablonen, expliciete MCP-bronnen en vermelding van sampling- of roots-ondersteuning. Hierdoor is het functioneel voor geheugen-gecentreerde workflows, maar beperkt in uitbreidbaarheid en geavanceerde MCP-mogelijkheden. Al met al praktisch maar basic.

| Heeft een LICENTIE | ⛔ (Geen licentiebestand aanwezig) |

|---|---|

| Heeft minstens één tool | ✅ |

| Aantal Forks | 4 |

| Aantal Sterren | 4 |

Membase MCP Server is een lichte, gedecentraliseerde gateway voor AI-agentgeheugen, die veilige, persistente en verifieerbare multi-sessie geheugen biedt door agenten te verbinden met het door Unibase aangedreven Membase-protocol.

Het bevat tools om het huidige conversatie-id op te halen, te wisselen tussen conversaties, berichten op te slaan en conversatiegeschiedenis op te halen, waardoor robuust multi-sessie- en geheugenbeheer voor AI-agenten mogelijk is.

Alle interacties en berichten worden opgeslagen op een gedecentraliseerd netwerk voor onvervalste, controleerbare gegevens. Referenties worden via omgevingsvariabelen doorgegeven om ze veilig te houden.

Ja. Voeg de MCP-component toe in je FlowHunt-flow en configureer deze met jouw Membase MCP-gegevens. Je AI-agenten hebben dan toegang tot alle geheugenfuncties die door de server worden geleverd.

Er is geen licentiebestand aanwezig in de repository. Gebruik op eigen risico.

Geef je AI-workflows meer kracht met gedecentraliseerd, onvervalst geheugen. Zet Membase MCP Server op in FlowHunt en ontgrendel geavanceerde multi-sessie mogelijkheden.

De mem0 MCP Server verbindt AI-assistenten met gestructureerde opslag, retrieval en semantische zoekmogelijkheden voor codefragmenten, documentatie en best prac...

De MCP Database Server biedt veilige, programmatische toegang tot populaire databases zoals SQLite, SQL Server, PostgreSQL en MySQL voor AI-assistenten en autom...

De ModelContextProtocol (MCP) Server fungeert als brug tussen AI-agenten en externe databronnen, API's en services, waardoor FlowHunt-gebruikers contextbewuste,...

Cookie Toestemming

We gebruiken cookies om uw browse-ervaring te verbeteren en ons verkeer te analyseren. See our privacy policy.