Forespørselsutvidelse

Omformulerer brukerens inndata til flere alternative forespørsler for å forbedre semantisk søk i kunnskapsbasen ved bruk av en LLM-promp.

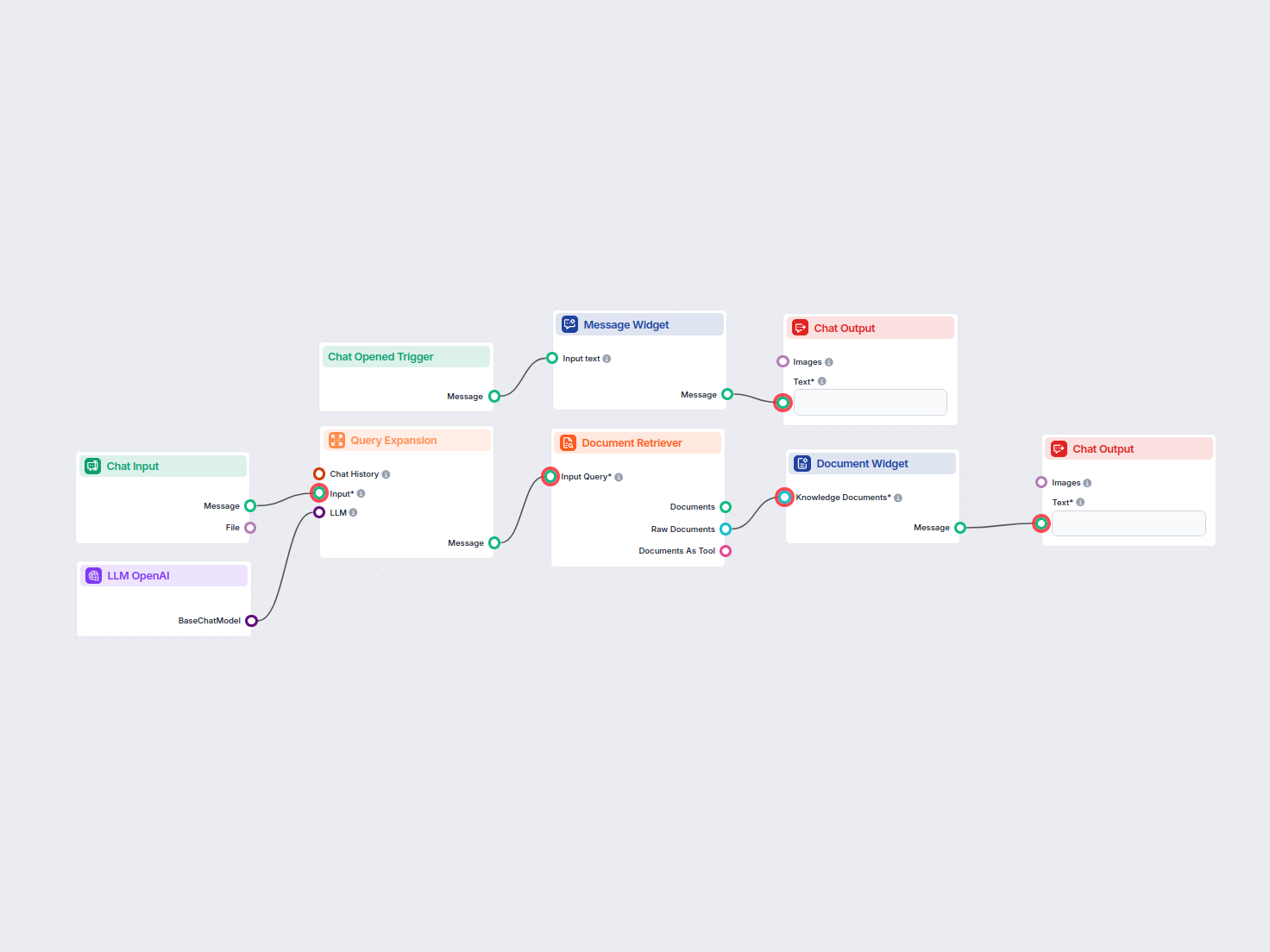

Søk enkelt og hent informasjon fra private kunnskapsbasedokumenter ved hjelp av semantisk søk drevet av AI. Flyten utvider brukerforespørsler, søker på tvers av flere kunnskapskilder, og presenterer relevante resultater i et brukervennlig chat-grensesnitt.

Flows

Omformulerer brukerens inndata til flere alternative forespørsler for å forbedre semantisk søk i kunnskapsbasen ved bruk av en LLM-promp.

Nedenfor er en komplett liste over alle komponenter som brukes i denne flowen for å oppnå dens funksjonalitet. Komponenter er byggesteinene i hver AI Flow. De lar deg lage komplekse interaksjoner og automatisere oppgaver ved å koble sammen ulike funksjoner. Hver komponent tjener et spesifikt formål, som å håndtere brukerinndata, behandle data, eller integrere med eksterne tjenester.

Chat Input-komponenten i FlowHunt initierer brukerinteraksjoner ved å fange opp meldinger fra Playground. Den fungerer som startpunktet for flyter, og gjør det mulig for arbeidsflyten å behandle både tekst- og filbaserte innspill.

Oppdag Chat Output-komponenten i FlowHunt—fullfør chatbot-svar med fleksible, flerdelte utganger. Essensielt for sømløs flytavslutning og for å lage avanserte, interaktive AI-chatboter.

Meldingswidget-komponenten viser tilpassede meldinger i arbeidsflyten din. Ideell for å ønske brukere velkommen, gi instruksjoner eller vise viktig informasjon. Den støtter Markdown-formatering og kan settes til å vises kun én gang per økt.

Komponenten Chat Åpnet Utløser oppdager når en chatøkt starter, slik at arbeidsflyter kan svare øyeblikkelig så snart en bruker åpner chatten. Den igangsetter flyter med den innledende chatmeldingen, noe som gjør den essensiell for å bygge responsive, interaktive chatboter.

Forespørselsekspansjon i FlowHunt forbedrer chatbotens forståelse ved å finne synonymer, rette stavefeil og sikre konsistente, nøyaktige svar på brukerhenvendelser.

FlowHunts Dokumentinnhenter forbedrer AI-nøyaktigheten ved å koble generative modeller til dine egne oppdaterte dokumenter og nettadresser, og sikrer pålitelige og relevante svar ved bruk av Retrieval-Augmented Generation (RAG).

Vis relevante dokumenter direkte i chatbot-svarene dine ved hjelp av Kunnskapskilde-widgeten. Denne komponenten viser utvalgte kunnskapsdokumenter som visuelt tydelige widgets, noe som gjør det enkelt for brukerne å få tilgang til og se støttende informasjon under en samtale.

FlowHunt støtter dusinvis av tekstgenereringsmodeller, inkludert modeller fra OpenAI. Her er hvordan du bruker ChatGPT i dine AI-verktøy og chatboter.

Flow-beskrivelse

Denne arbeidsflyten, med tittelen “Semantisk søk”, gjør det mulig for brukere å søke etter informasjon i sin private kunnskapsbase ved å utnytte avanserte språkmodeller og semantiske søketeknikker. Den er designet for å skanne gjennom alle planlagte domener, dokumenter og Q&A-seksjoner, og automatiserer innhentingen av den mest relevante informasjonen som svar på brukerforespørsler.

Når en bruker åpner chat-grensesnittet, utløser arbeidsflyten en velkomstmelding:

👋 Velkommen til det private kunnskapsbase-søkverktøyet!

Jeg er her for å hjelpe deg med å søke gjennom dokumenter i din private kunnskapsbase 📚. Jeg vil skanne alle planlagte domener, private dokumenter og Q&A-seksjoner for å finne informasjonen du trenger.

Skriv bare inn din forespørsel, så starter vi jakten på svarene! ✨🔍

Denne vennlige meldingen hjelper brukeren med å orientere seg og veileder dem til å skrive inn sitt søkespørsmål.

Brukerinndata:

Brukeren sender inn en forespørsel via chat-inndatafeltet.

Forespørselsutvidelse:

gpt-4o-mini), genererer denne komponenten opptil tre omformulerte eller semantisk lignende forespørsler.| Komponent | Formål |

|---|---|

| Chat-inndata | Samler inn brukerens søkespørsmål |

| OpenAI LLM (gpt-4o-mini) | Genererer alternative formuleringer av spørsmålet |

| Forespørselsutvidelse | Produserer opptil 3 varianter for søk |

<H1>-overskrifter for å maksimere kontekstrelevans.| Steg | Komponent | Utdata-type |

|---|---|---|

| Hent dokumenter | Dokumenthenter | Rå-dokumenter |

| Formater resultater | Dokument-widget | Melding |

| Vises til bruker | Chat-utdata | Chat-melding |

flowchart LR

A[Chat Opened] --> B[Welcome Message]

B --> C[User Query Input]

C --> D[Query Expansion\n(OpenAI LLM)]

D --> E[Document Retriever]

E --> F[Document Widget]

F --> G[Chat Output]

Typiske brukstilfeller:

Ved å integrere semantisk søk med LLM-drevet forespørselsutvidelse sikrer denne arbeidsflyten at brukere effektivt får tilgang til relevant kunnskap, noe som øker produktivitet og informasjonsinnhenting.

Vi hjelper bedrifter som din med å utvikle smarte chatboter, MCP-servere, AI-verktøy eller andre typer AI-automatisering for å erstatte mennesker i repeterende oppgaver i organisasjonen din.

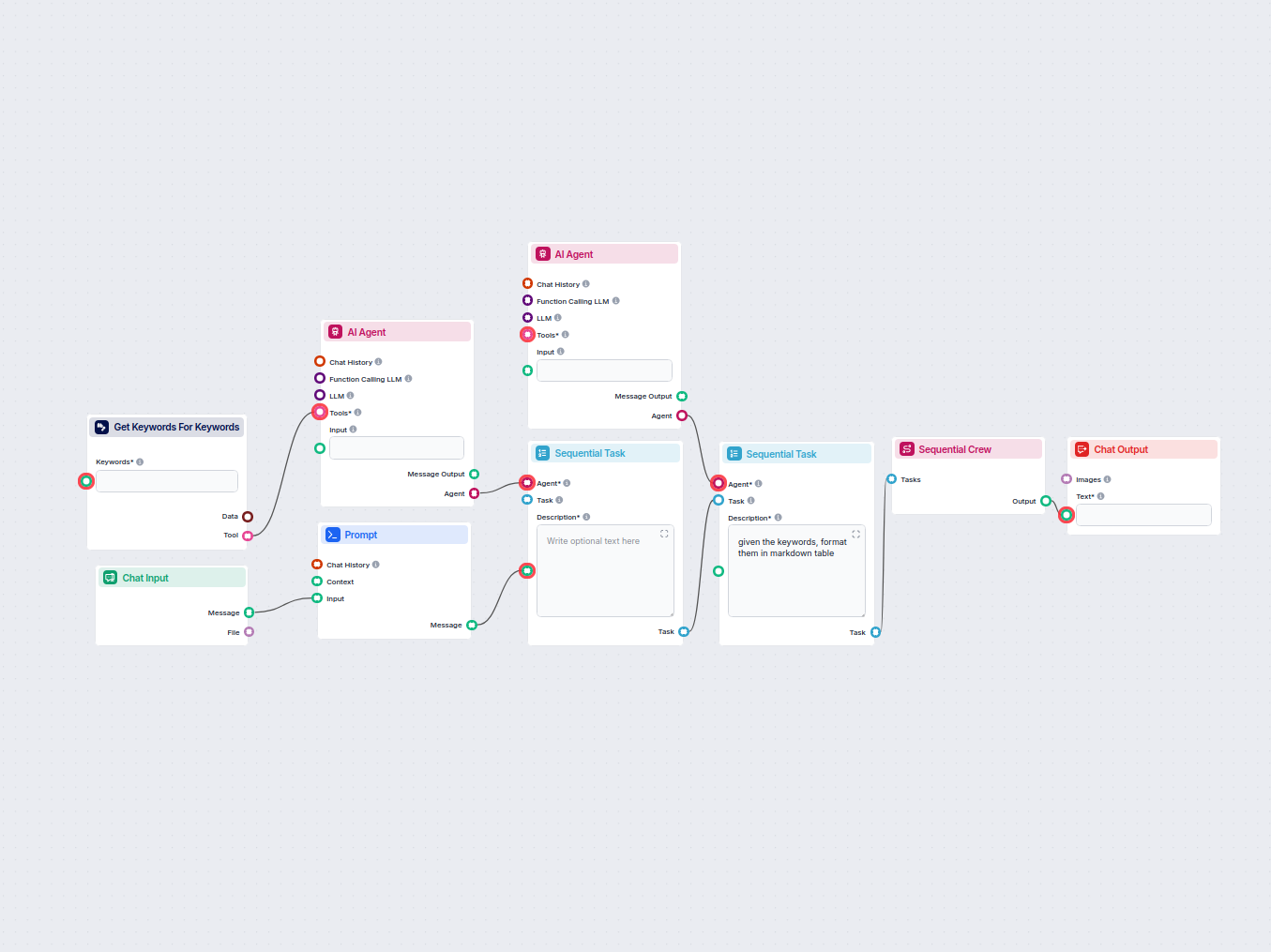

Oppdag hva folk snakker om på nettet rundt ditt valgte nøkkelord. Denne AI-drevne arbeidsflyten undersøker trendende eller relaterte temaer fra nylige diskusjon...

Denne arbeidsflyten automatiserer nøkkelordforskning ved å generere en detaljert tabell over relaterte nøkkelord for din målfrase, inkludert viktige SEO-målinge...

Informasjonskapselsamtykke

Vi bruker informasjonskapsler for å forbedre din surfeopplevelse og analysere vår trafikk. See our privacy policy.