Langflow-DOC-QA-SERVER MCP Server

Langflow-DOC-QA-SERVER är en MCP-server för dokumentfrågor och -svar, som möjliggör för AI-assistenter att fråga dokument via en Langflow-backend. Integrera dok...

Integrera Langfuse MCP Server med FlowHunt för att centralt hantera, hämta och kompilera AI-prompts från Langfuse, vilket möjliggör dynamiska och standardiserade LLM-arbetsflöden.

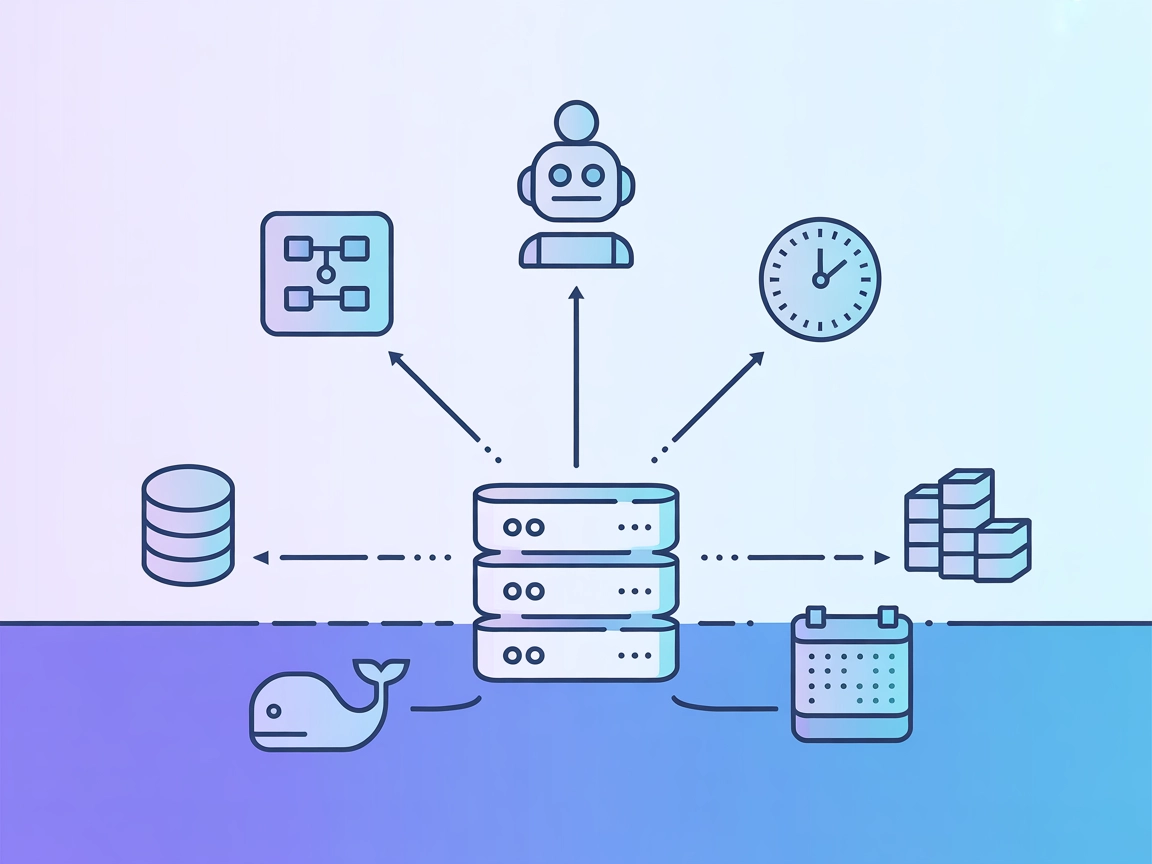

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

Langfuse MCP Server är en Model Context Protocol (MCP)-server utformad för Langfuse Prompt-hantering. Den gör det möjligt för AI-assistenter och utvecklare att komma åt och hantera prompts som lagras i Langfuse via det standardiserade MCP-gränssnittet. Genom att koppla AI-klienter till externa prompt-repositorier via MCP förenklar denna server hämtning, listning och kompilering av prompts, vilket förbättrar utvecklingsflödet för stora språkmodeller (LLM). Langfuse MCP Server stöder prompt-upptäckt, hämtning och kompilering, vilket möjliggör uppgifter som dynamiskt promptval och variabelsubstitution. Denna integration förenklar prompt-hanteringen och standardiserar interaktionen mellan LLM:er och prompt-databaser, vilket är särskilt användbart i miljöer där konsekvent användning och delning av prompts krävs över team eller plattformar.

prompts/list: Listar alla tillgängliga prompts i Langfuse-repositoriet. Stöder valfri cursor-baserad paginering och ger prompt-namn med tillhörande argument. Alla argument antas vara valfria.prompts/get: Hämtar en specifik prompt via namn och kompilerar den med angivna variabler. Stöder både text- och chat-prompts och omvandlar dem till MCP prompt-objekt.production i Langfuse för upptäckt och hämtning av AI-klienter.get-prompts: Listar tillgängliga prompts med deras argument. Stöder valfri cursor-parameter för paginering och returnerar en lista med prompt-namn och argument.get-prompt: Hämtar och kompilerar en specifik prompt. Kräver en name-parameter och tar eventuellt ett JSON-objekt med variabler för att fylla i prompten.Inga specifika instruktioner för Windsurf hittades i repositoriet.

npm install

npm run build

claude_desktop_config.json för att lägga till MCP-servern:{

"mcpServers": {

"langfuse": {

"command": "node",

"args": ["<absolute-path>/build/index.js"],

"env": {

"LANGFUSE_PUBLIC_KEY": "your-public-key",

"LANGFUSE_SECRET_KEY": "your-secret-key",

"LANGFUSE_BASEURL": "https://cloud.langfuse.com"

}

}

}

}

npm install

npm run build

LANGFUSE_PUBLIC_KEY="your-public-key" LANGFUSE_SECRET_KEY="your-secret-key" LANGFUSE_BASEURL="https://cloud.langfuse.com" node absolute-path/build/index.js

Inga specifika instruktioner för Cline hittades i repositoriet.

Det rekommenderas att skydda dina API-nycklar med hjälp av miljövariabler. Här är ett exempel på JSON-snutt för MCP-serverkonfiguration:

{

"mcpServers": {

"langfuse": {

"command": "node",

"args": ["<absolute-path>/build/index.js"],

"env": {

"LANGFUSE_PUBLIC_KEY": "your-public-key",

"LANGFUSE_SECRET_KEY": "your-secret-key",

"LANGFUSE_BASEURL": "https://cloud.langfuse.com"

}

}

}

}

Byt ut värdena mot dina riktiga API-uppgifter.

Använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, ange dina MCP-serverdetaljer med detta JSON-format:

{

"langfuse": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och kapaciteter. Kom ihåg att ändra "langfuse" till det faktiska namnet på din MCP-server och ersätt URL:en med din egen MCP-serveradress.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | Langfuse MCP för prompt-hantering |

| Lista över Prompts | ✅ | prompts/list, prompts/get |

| Lista över Resurser | ✅ | Prompt-listning, prompt-variabler, paginerade resurser |

| Lista över Verktyg | ✅ | get-prompts, get-prompt |

| Skydda API-nycklar | ✅ | Via miljövariabler i MCP-konfig |

| Stöd för sampling (mindre viktigt vid utvärdering) | ⛔ | Ej nämnt |

Baserat på tillgängliga sektioner och funktioner är Langfuse MCP Server väl dokumenterad och täcker de flesta viktiga MCP-funktionerna, särskilt för prompt-hantering. Brist på explicit sampling eller roots-stöd minskar utbyggbarheten något. Sammantaget är det en stark implementation för sitt fokusområde.

| Har en LICENSE | ✅ (MIT) |

|---|---|

| Har minst ett verktyg | ✅ |

| Antal Forks | 22 |

| Antal Stars | 98 |

Langfuse MCP Server är en Model Context Protocol-server som kopplar AI-klienter som FlowHunt till Langfuses prompt-hanteringsplattform. Den möjliggör upptäckt, hämtning och dynamisk kompilering av prompts och förenklar prompt-arbetsflöden för LLM:er och agenter.

Den stöder listning av alla tillgängliga prompts, hämtning och kompilering av prompts med variabler, paginerad upptäckt av prompts och exponering av prompt-argument. Alla argument antas vara valfria, och servern är framtagen för produktionshantering av prompts i LLMOps-sammanhang.

Du bör lagra API-nycklar som miljövariabler i din MCP-serverkonfiguration för att hålla dem säkra. Se de tillhandahållna konfigurationsexemplen för detaljer om miljövariabler.

Ja! Lägg till MCP-komponenten i ditt FlowHunt-flöde, konfigurera den att peka mot din Langfuse MCP-server, och dina agenter kan dynamiskt komma åt, upptäcka och kompilera prompts från Langfuse.

Centraliserad prompt-hantering, standardiserad hämtning för LLM-arbetsflöden, dynamisk prompt-kompilering med runtime-variabler, driva promptvalgränssnitt samt integration med LLMOps-verktyg för bättre styrning och granskning.

Centralisera och standardisera dina AI prompt-arbetsflöden genom att integrera Langfuse MCP Server med FlowHunt. Lås upp effektiv upptäckt, hämtning och dynamisk kompilering av prompts för avancerade LLM-operationer.

Langflow-DOC-QA-SERVER är en MCP-server för dokumentfrågor och -svar, som möjliggör för AI-assistenter att fråga dokument via en Langflow-backend. Integrera dok...

Prefect MCP-servern fungerar som en brygga mellan AI-assistenter och plattformen Prefect för arbetsflödesorkestrering, vilket möjliggör hantering av flöden, dri...

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.