Integración del Servidor ModelContextProtocol (MCP)

El Servidor ModelContextProtocol (MCP) actúa como un puente entre agentes de IA y fuentes de datos externas, APIs y servicios, permitiendo a los usuarios de Flo...

El Servidor MCP Multi-Model Advisor de FlowHunt permite que tus agentes de IA consulten múltiples modelos de Ollama a la vez, combinando sus respuestas para lograr contestaciones más completas y una toma de decisiones colaborativa avanzada.

FlowHunt proporciona una capa de seguridad adicional entre tus sistemas internos y las herramientas de IA, dándote control granular sobre qué herramientas son accesibles desde tus servidores MCP. Los servidores MCP alojados en nuestra infraestructura pueden integrarse perfectamente con el chatbot de FlowHunt, así como con plataformas de IA populares como ChatGPT, Claude y varios editores de IA.

El Servidor MCP Multi-Model Advisor es un servidor Model Context Protocol (MCP) diseñado para conectar asistentes de IA con múltiples modelos locales de Ollama, permitiendo consultarlos de manera simultánea y combinar sus respuestas. Este enfoque, descrito como un “consejo de asesores”, permite que sistemas de IA como Claude sinteticen puntos de vista diversos de diferentes modelos, resultando en respuestas más completas y matizadas a las consultas de los usuarios. El servidor permite asignar diferentes roles o personalidades a cada modelo, personalizar los prompts del sistema y se integra perfectamente con entornos como Claude para escritorio. Mejora los flujos de trabajo de desarrollo facilitando tareas como la agregación de opiniones de modelos, apoyando la toma de decisiones avanzada y proporcionando información contextual más rica desde múltiples fuentes de IA.

server.py o similar, ni se documentan interfaces de herramientas explícitamente en el README o la estructura de archivos visible.mcpServers:{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

npx -y @smithery/cli install @YuChenSSR/multi-ai-advisor-mcp --client claude

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

Protegiendo Claves API

Para proteger claves API o variables de entorno sensibles, utiliza el campo env en tu configuración:

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

}

}

}

Define las variables de entorno en tu sistema operativo o pipeline CI/CD para evitar poner secretos en el código fuente.

Uso de MCP en FlowHunt

Para integrar servidores MCP en tu flujo de trabajo con FlowHunt, comienza agregando el componente MCP a tu flujo y conectándolo a tu agente de IA:

Haz clic en el componente MCP para abrir el panel de configuración. En la sección de configuración MCP del sistema, inserta los detalles de tu servidor MCP usando este formato JSON:

{

"multi-ai-advisor-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una vez configurado, el agente de IA podrá usar este MCP como herramienta, con acceso a todas sus funciones y capacidades. Recuerda cambiar “multi-ai-advisor-mcp” por el nombre real de tu servidor MCP y reemplazar la URL por la de tu propio servidor MCP.

| Sección | Disponibilidad | Detalles/Notas |

|---|---|---|

| Resumen | ✅ | README.md, página principal |

| Lista de Prompts | ⛔ | No se encontraron plantillas de prompts |

| Lista de Recursos | ⛔ | No se listan recursos explícitamente |

| Lista de Herramientas | ⛔ | No se encontró lista de herramientas |

| Protección de Claves API | ✅ | Ejemplos en .env y configuración JSON |

| Soporte de Sampling (menos relevante) | ⛔ | No mencionado |

Multi-Model Advisor MCP está bien documentado para su configuración y ofrece un enfoque único de “consejo de asesores”, pero carece de transparencia sobre prompts, recursos y herramientas. Su valor es alto para flujos de trabajo de decisión multi-modelo, aunque más detalle técnico lo mejoraría. Calificaría este MCP con un 6/10 basándome en las dos tablas, ya que cubre lo esencial y ofrece un caso de uso interesante, pero carece de profundidad en documentación técnica.

| ¿Tiene LICENCIA? | ✅ (MIT) |

|---|---|

| ¿Tiene al menos una herramienta? | ⛔ |

| Número de Forks | 15 |

| Número de Stars | 49 |

Es un servidor MCP que conecta asistentes de IA con múltiples modelos de Ollama de manera simultánea, permitiendo combinar respuestas de varios modelos ('consejo de asesores') para obtener respuestas más completas y matizadas.

Los casos de uso incluyen agregar opiniones de modelos para decisiones equilibradas, consultas basadas en roles para análisis de escenarios, toma de decisiones colaborativa de IA y flujos de trabajo de desarrollo mejorados con ideas multi-modelo.

Debes utilizar el campo 'env' en tu configuración MCP para las credenciales, y definir las variables en tu sistema operativo o entorno CI/CD, evitando ponerlas directamente en el código o archivos de configuración.

Sí, puedes asignar distintos prompts de sistema o roles a cada modelo Ollama, habilitando simulaciones de escenarios con múltiples perspectivas de expertos.

Agrega el componente MCP a tu flujo y usa el panel de configuración MCP del sistema para insertar los detalles de tu servidor. Esto permite que tus agentes de IA accedan a todas las funciones del servidor.

Desata el poder de un consejo de asesores de IA. Agrega perspectivas de múltiples modelos y mejora tu flujo de trabajo con ideas más profundas utilizando el Multi-Model Advisor MCP de FlowHunt.

El Servidor ModelContextProtocol (MCP) actúa como un puente entre agentes de IA y fuentes de datos externas, APIs y servicios, permitiendo a los usuarios de Flo...

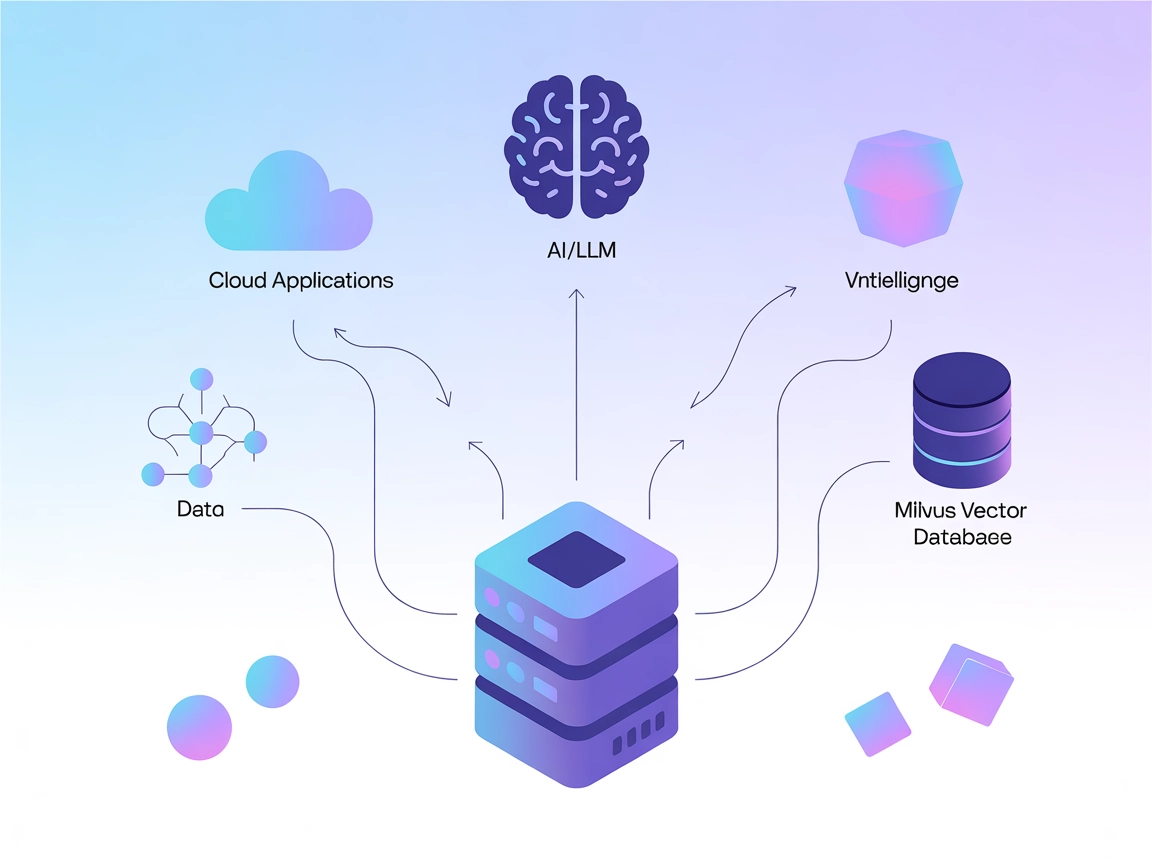

El Servidor Milvus MCP conecta asistentes de IA y aplicaciones potenciadas por LLM con la base de datos vectorial Milvus, permitiendo búsquedas vectoriales avan...

El Servidor MCP de Atlassian conecta asistentes de IA con herramientas de Atlassian como Jira y Confluence, permitiendo la gestión automatizada de proyectos, re...

Consentimiento de Cookies

Usamos cookies para mejorar tu experiencia de navegación y analizar nuestro tráfico. See our privacy policy.