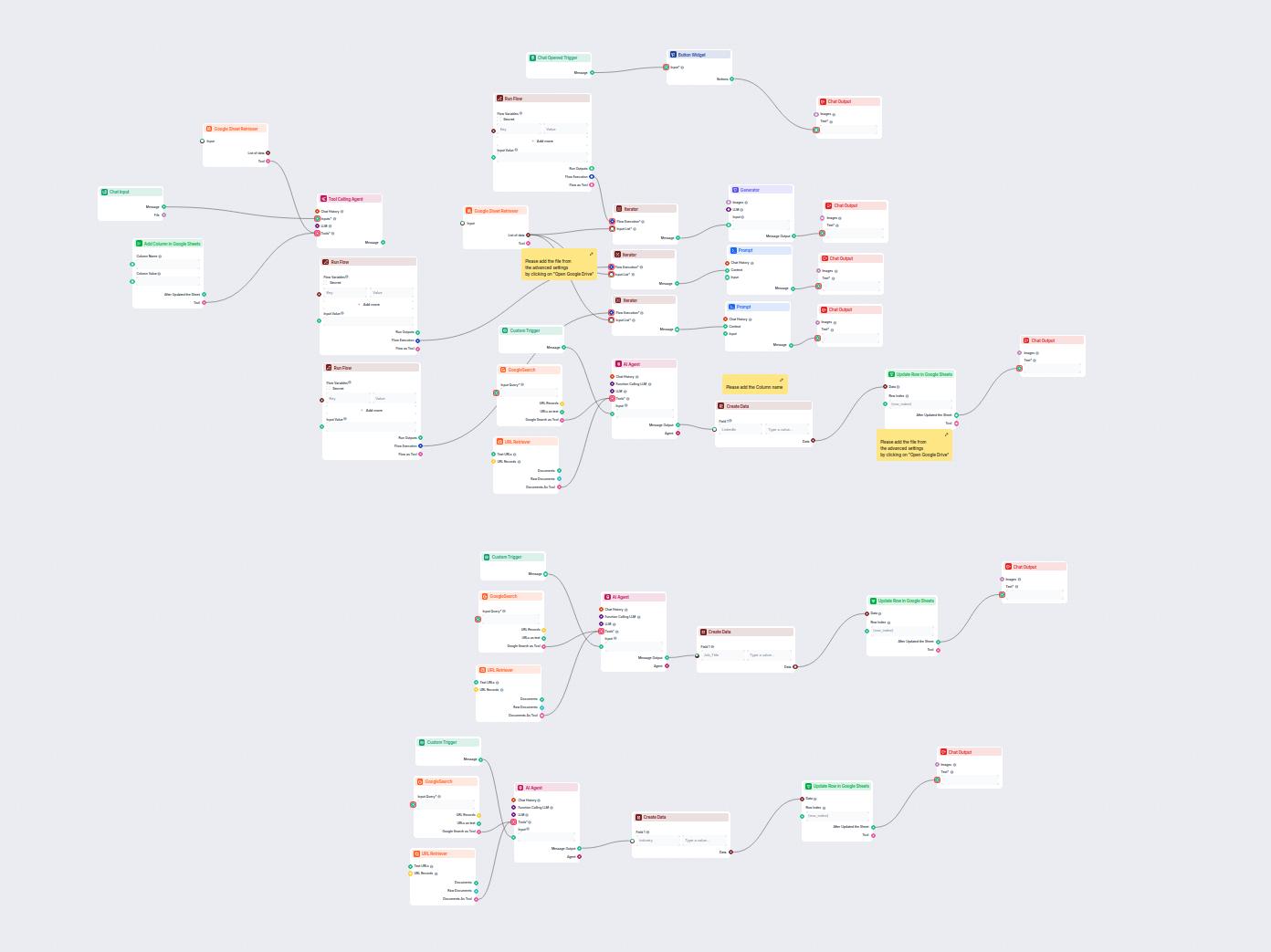

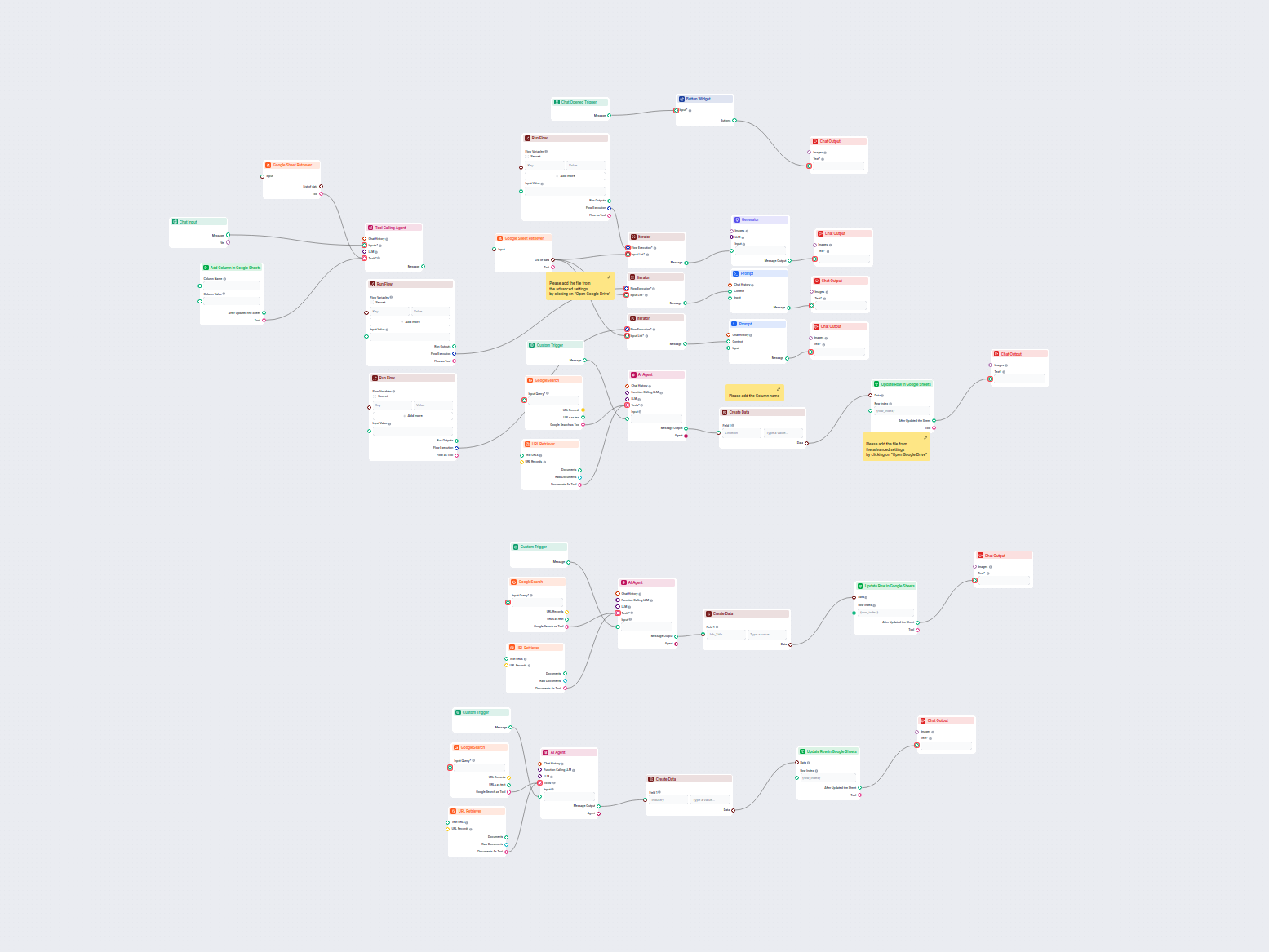

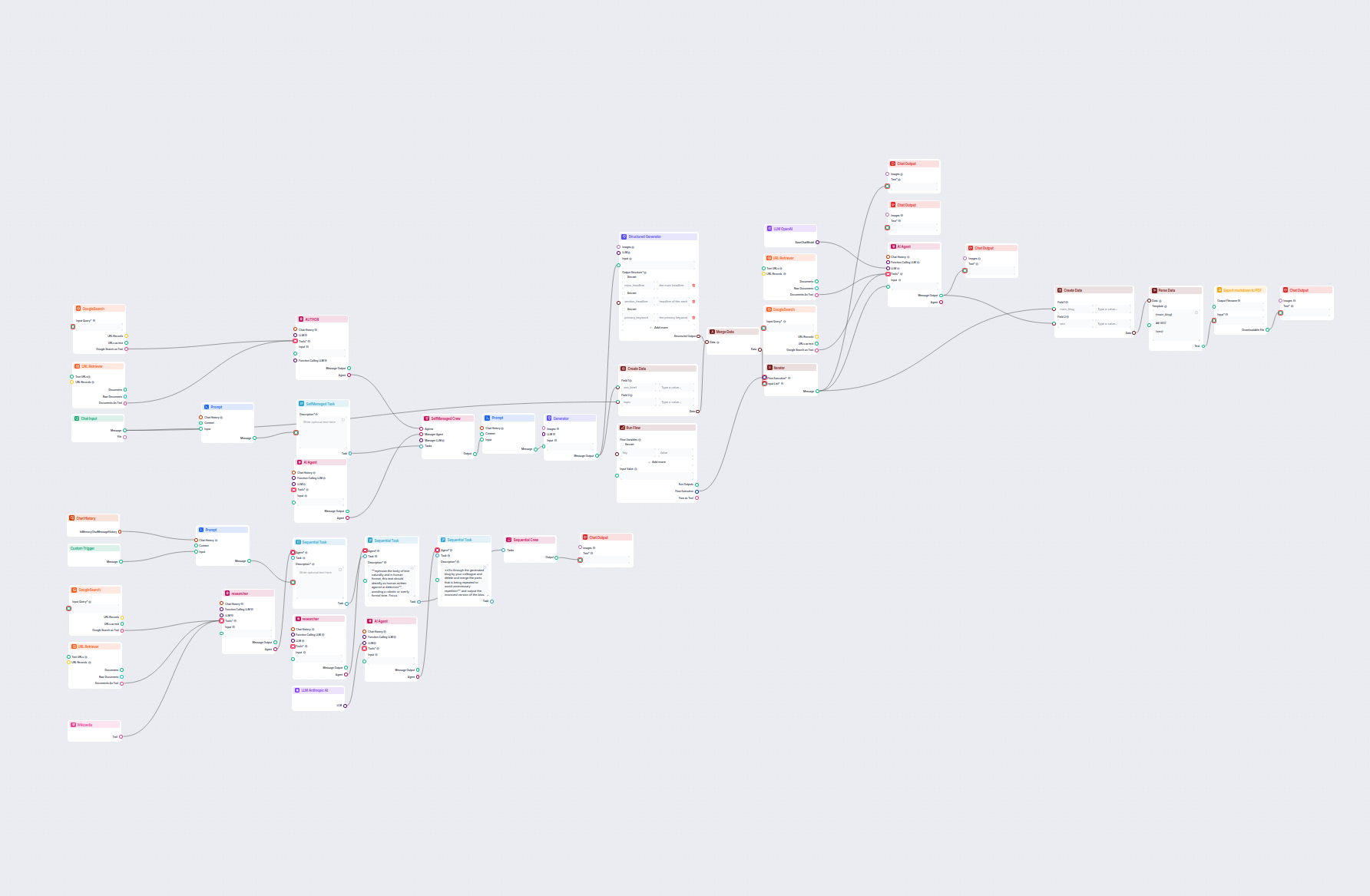

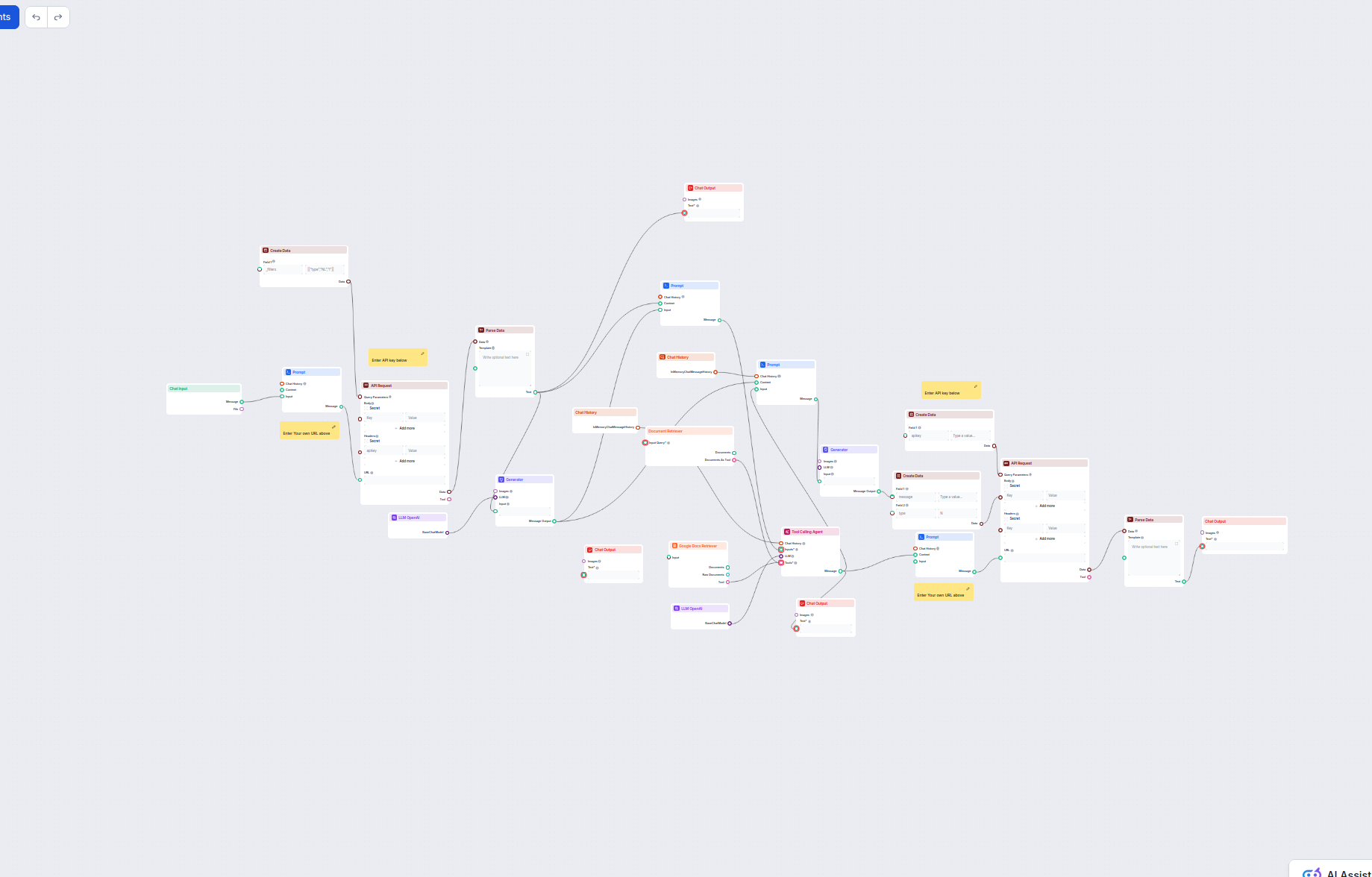

Agent d’assistance client IA avec base de connaissances et enrichissement API

Ce workflow alimenté par l’IA automatise l’assistance client en combinant la recherche dans la base de connaissances interne, la récupération de connaissances d...

Description du composant

Without a good prompt, all bots would act the same way and often miss the mark with their answers. Prompts give instructions and context to the language model, helping it to understand what kind of text it should produce.

The Prompt component is designed to generate flexible prompt templates for use in AI workflows, allowing dynamic insertion of variables and context. This component is particularly useful in conversational AI scenarios, such as chatbots or virtual assistants, where creating adaptable and context-aware prompts is essential.

The Prompt component creates a prompt template that can incorporate various dynamic variables, such as user input, chat history, system instructions, and context messages. By leveraging these variables, the component helps you structure rich and context-sensitive prompts that enhance the performance and relevance of downstream AI models or agents.

{input}, {human_input}, {context}, {chat_history}, {system_message}, and {all_input_variables} directly into the prompt template.The following inputs can be provided to the Prompt component:

| Input Name | Type | Required | Description |

|---|---|---|---|

| Chat History | InMemoryChatMessageHistory | No | Previous conversation messages. Useful for maintaining context or generating alternative queries. |

| Context | Message | No | Additional context information to be included in the prompt. |

| Input | Message | No | The main user input or message. |

| System Message | String (multiline) | No | System-level instructions to guide the AI’s behavior. |

| Template | Prompt (multiline) | No | The actual template for the prompt, supporting dynamic variables for customization. |

| Output Name | Type | Description |

|---|---|---|

| Message | Message | The generated prompt, ready for use in downstream AI components. |

| Feature | Benefit |

|---|---|

| Dynamic variable injection | Context-aware, adaptable prompts |

| Support for chat history | Maintains continuity in multi-turn interactions |

| System message integration | Fine-tunes AI personality or instructions |

| Easy integration in workflows | Streamlines prompt creation for downstream AI |

This component is a foundational tool for anyone building sophisticated, context-sensitive AI workflows where prompt construction is key to achieving high-quality results.

This is an advanced optional setting. You can create prompt templates with specified variables to control the chat output fully. For example:

As a skilled SEO, analyze the content of the URL and come up with a title up to 65 characters long.— Content of the URL —{input}Task: Generate a Title similar to others using {human_input} query. Don’t change {human_input} in the new title. NEW TITLE:

The default prompt template looks like this:

You are an AI language model assistant.

Your task is to generate answer based on the input query.

If context is provided, use it to generate the answer to INPUT and HUMAN_INPUT query.

Format answer with markdown.

ANSWER IN LANGUAGE: {lang}

VARIABLES:

{"session_start_time": "2025-06-03 07:35:22", "current_page_url": "https://app.flowhunt.io/aistudio/flows/de6c2e2c-d817-4b2f-af2c-12dba3f46870?ws=74be5f74-d7c5-4076-839d-8ac1771a3b75"}

INPUT: {input}

ANSWER:

The default prompt copies the same structure as the component’s settings. You can override the settings by altering and using the variables in the template field. Creating your own templates gives you greater control over the output.

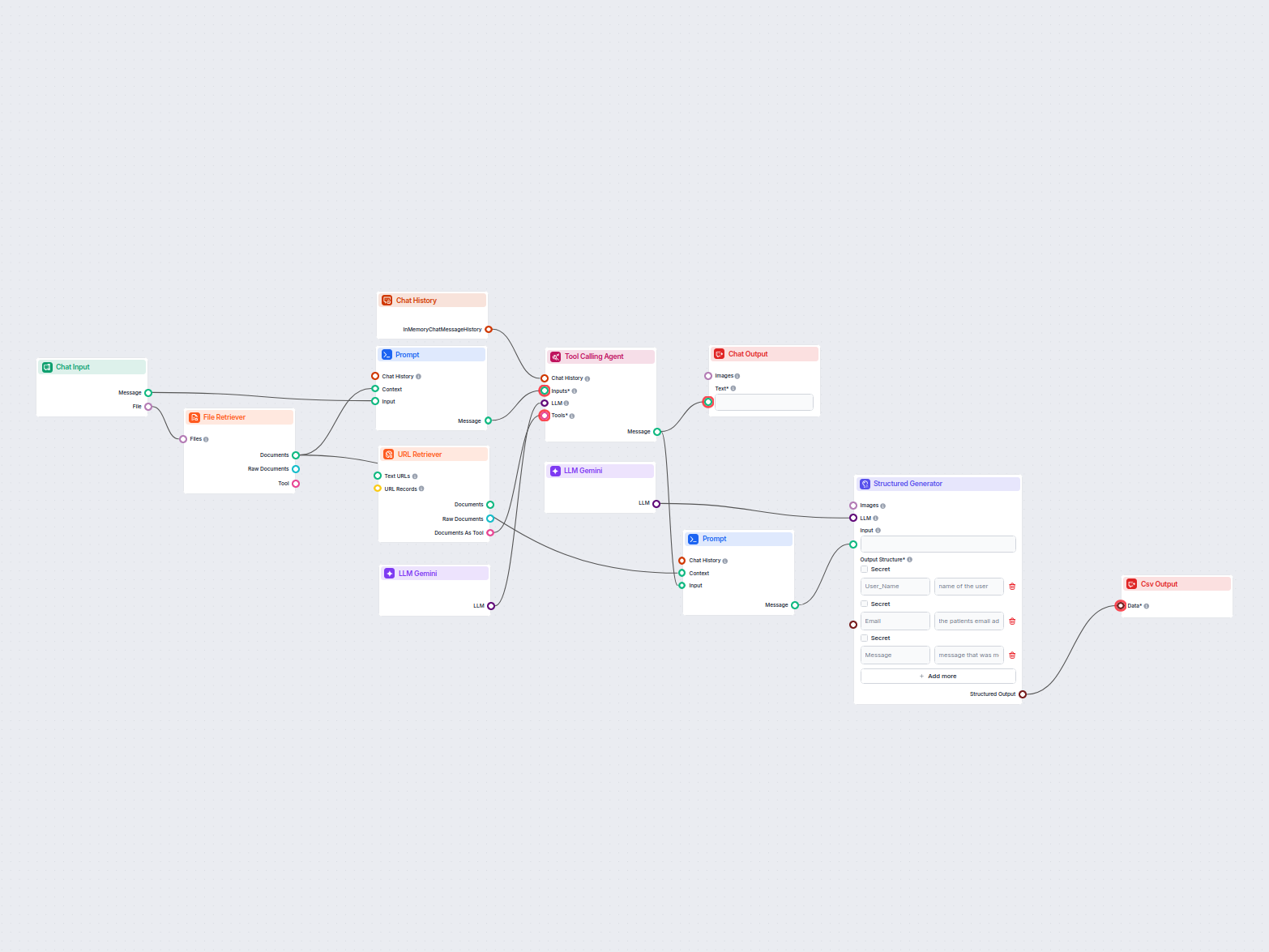

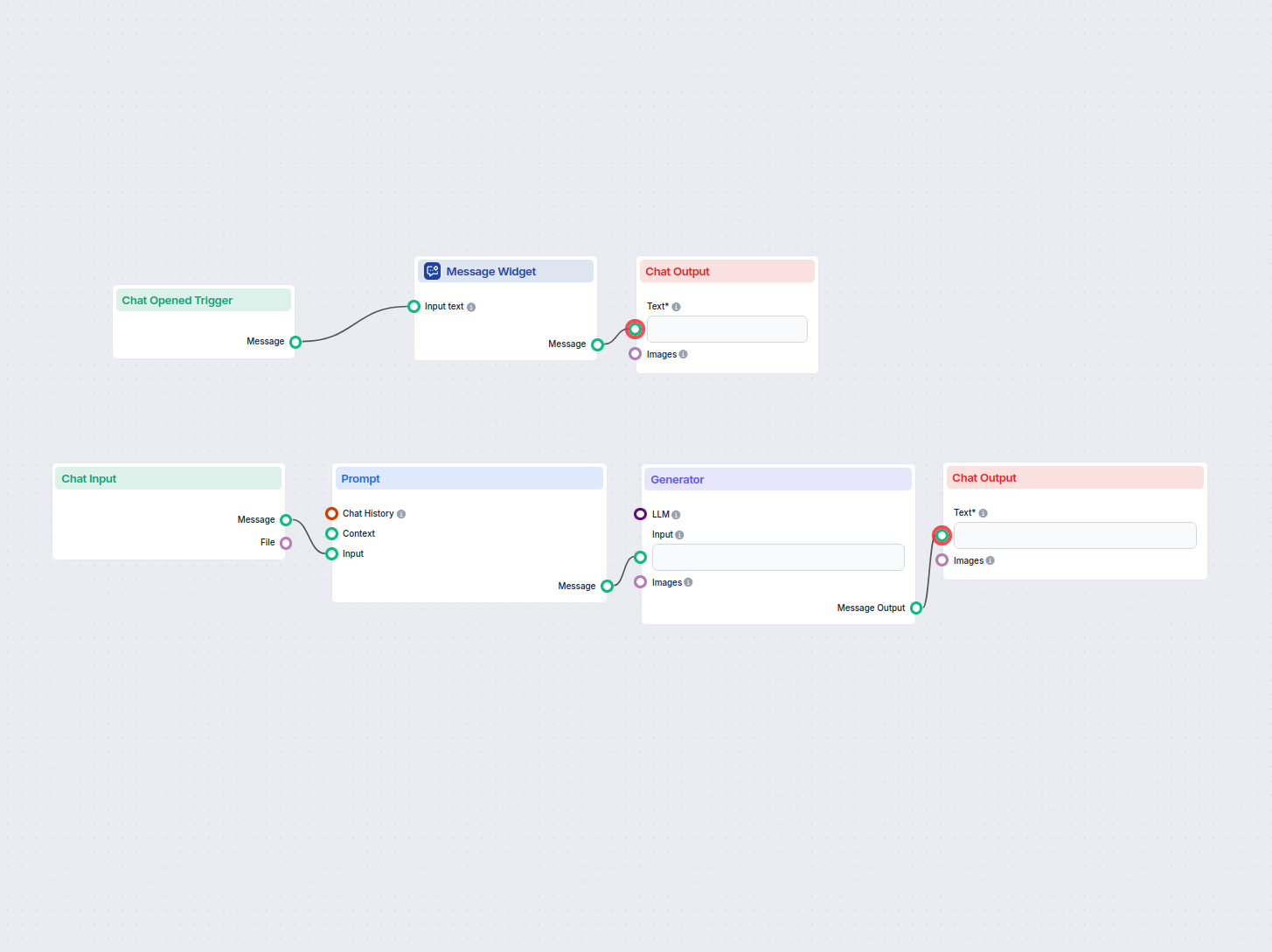

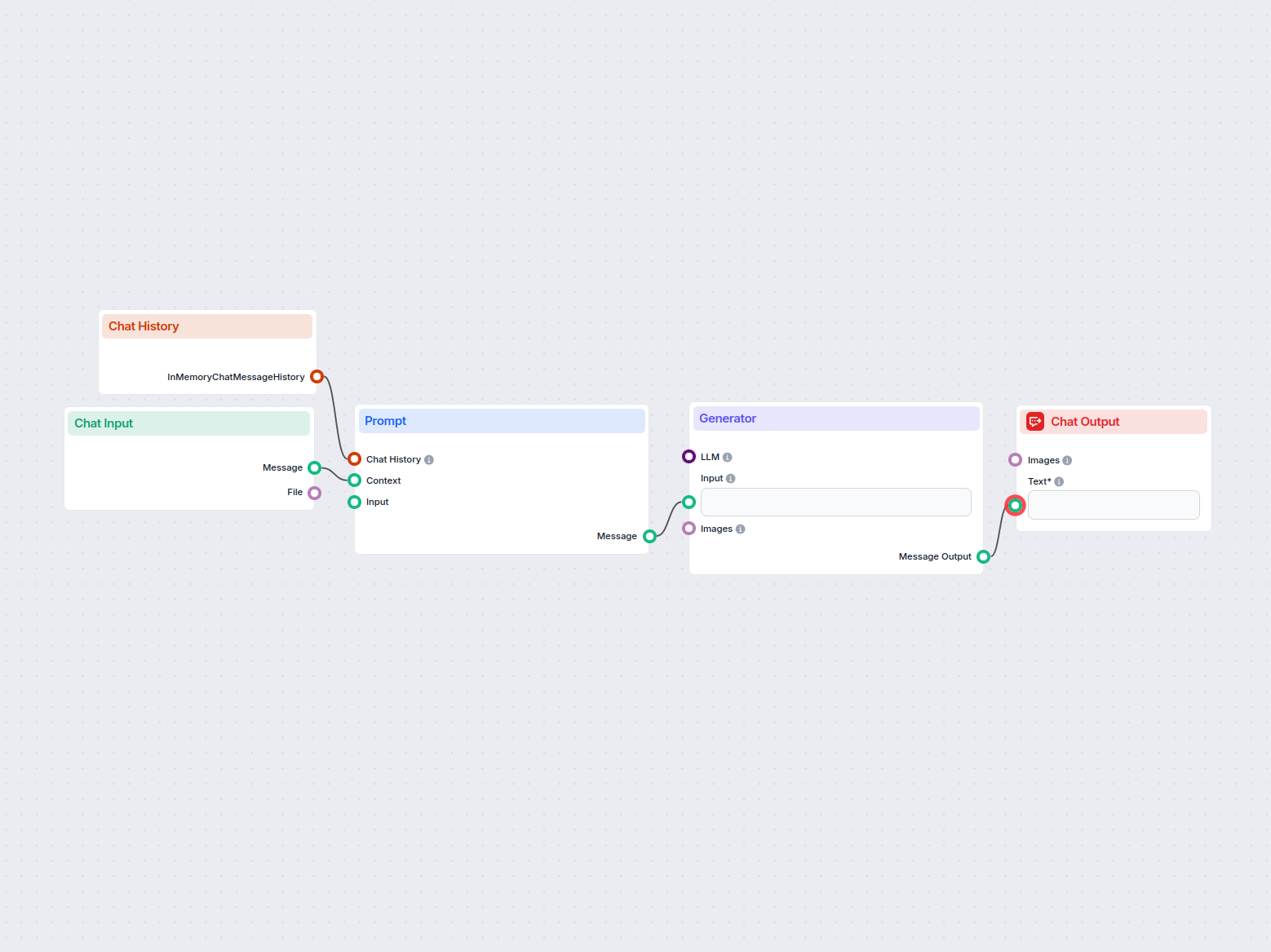

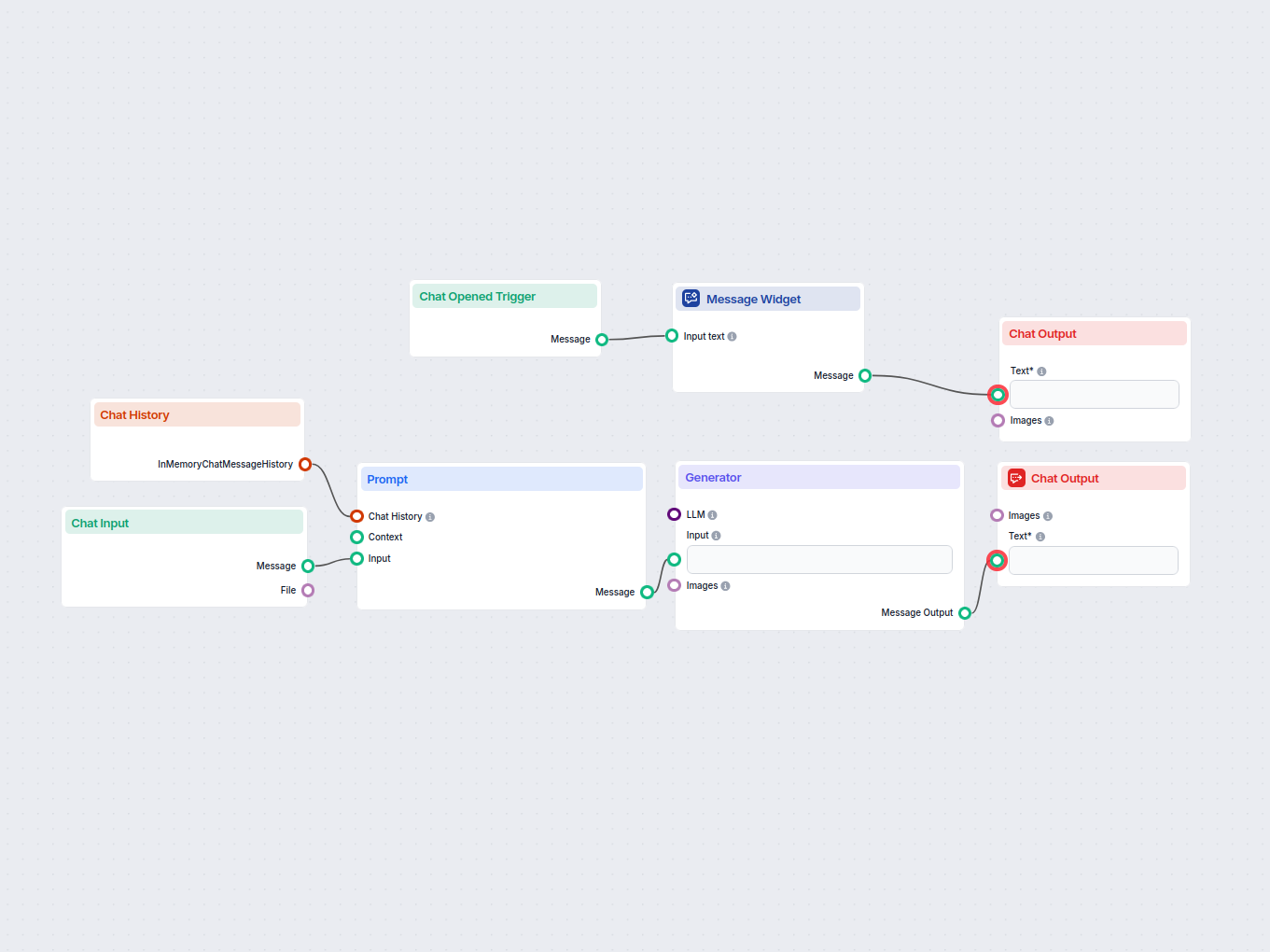

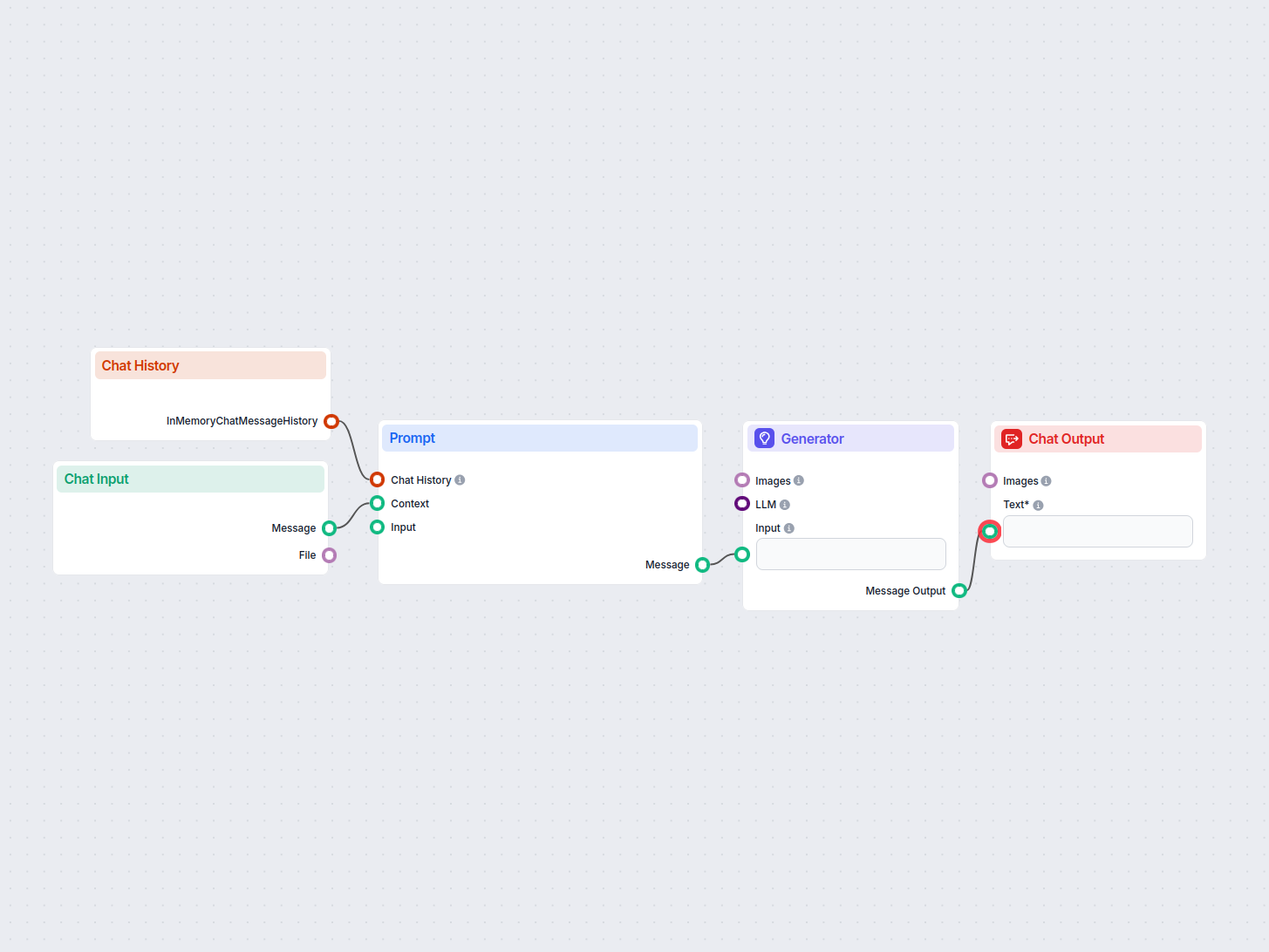

The prompt is an optional component that further modifies and specifies the final output. It needs several components to be connected:

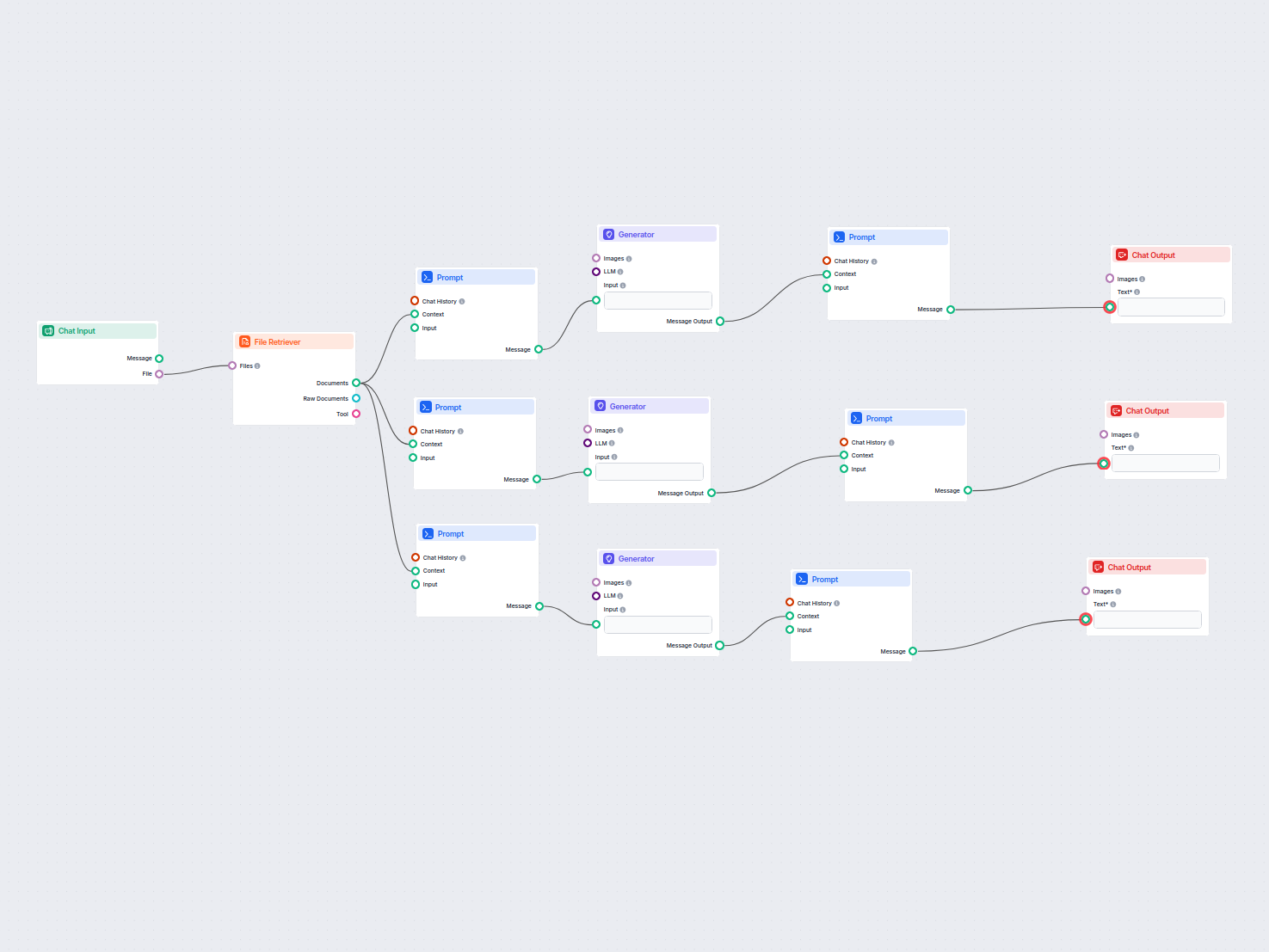

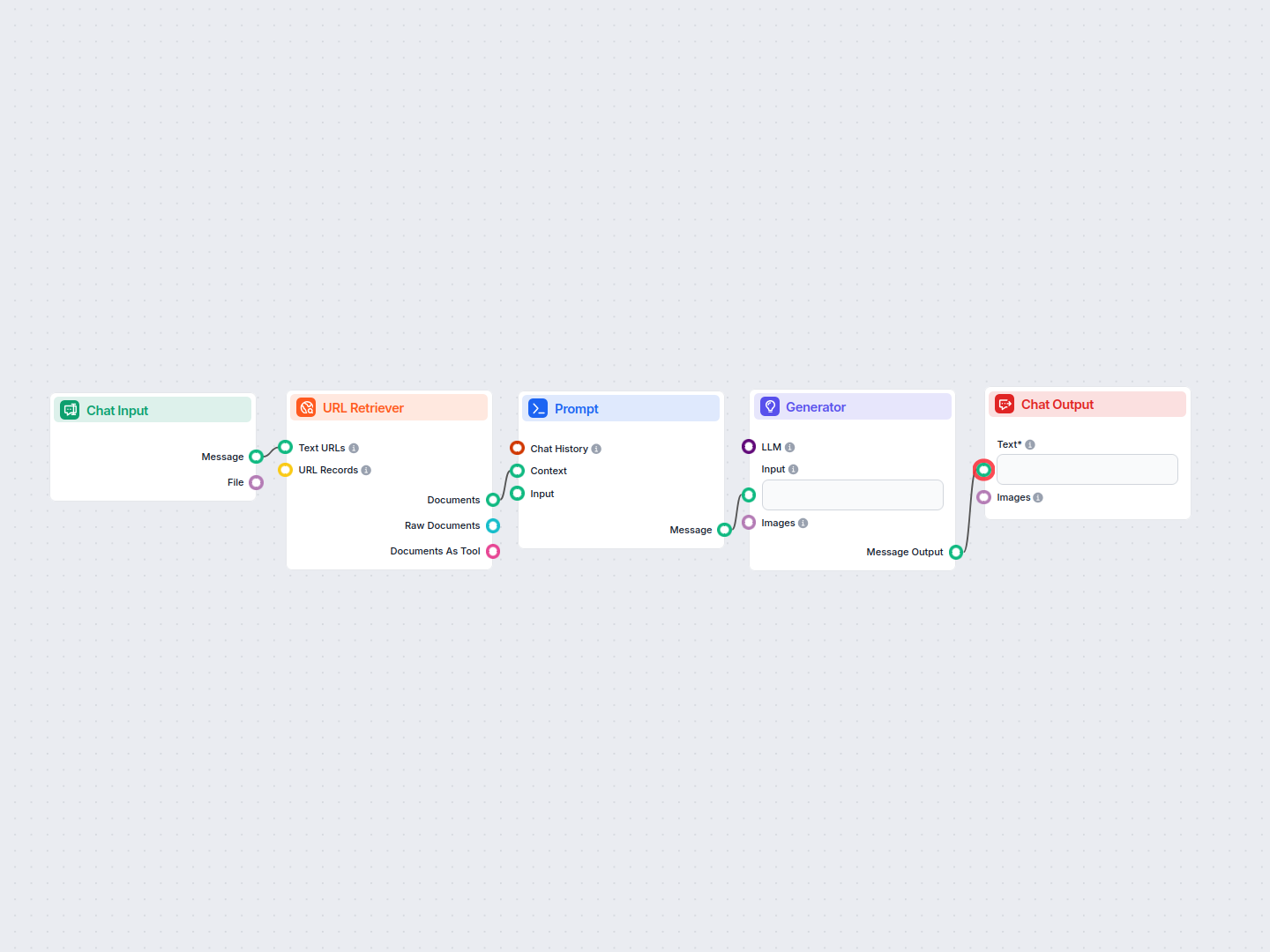

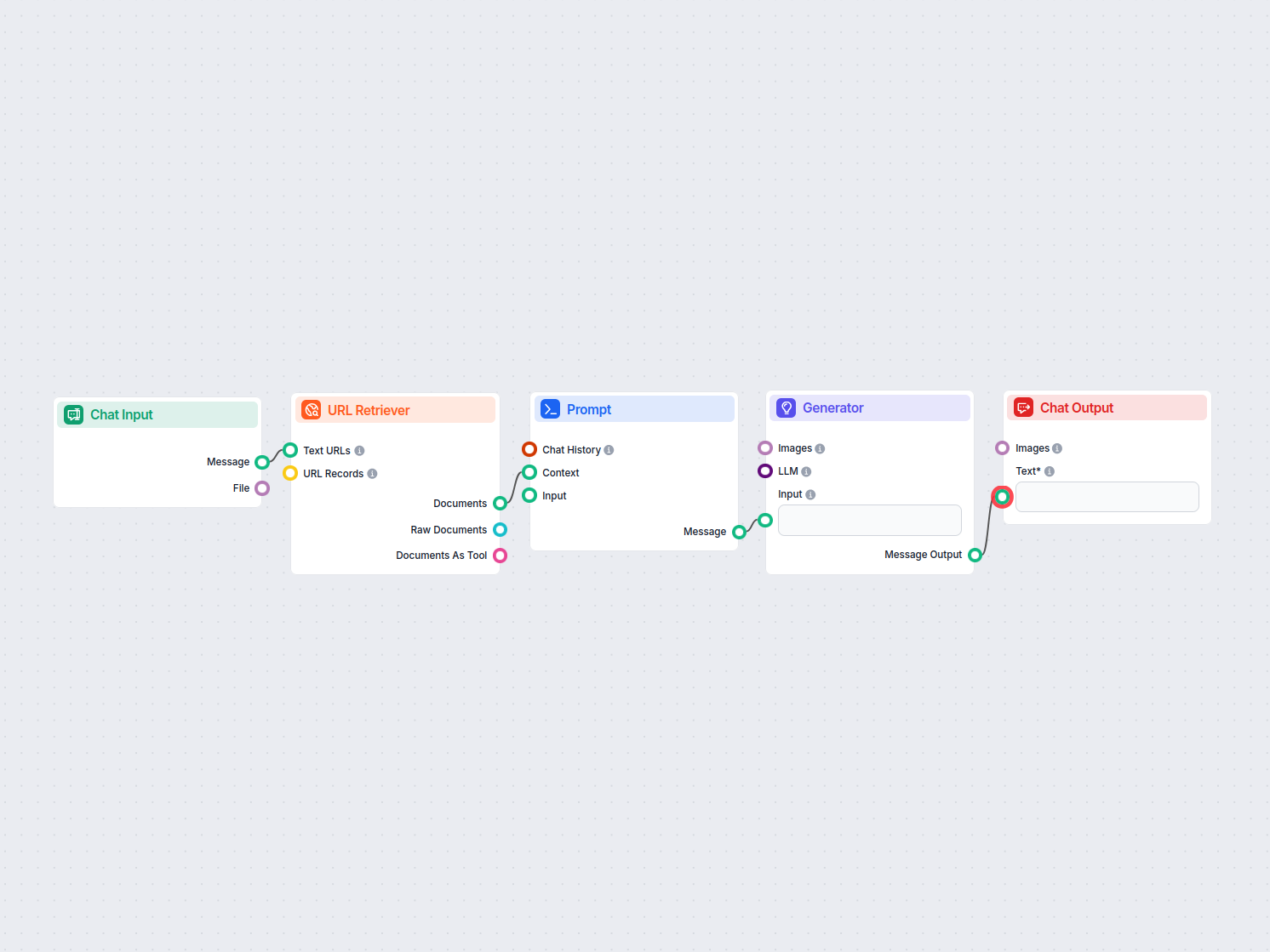

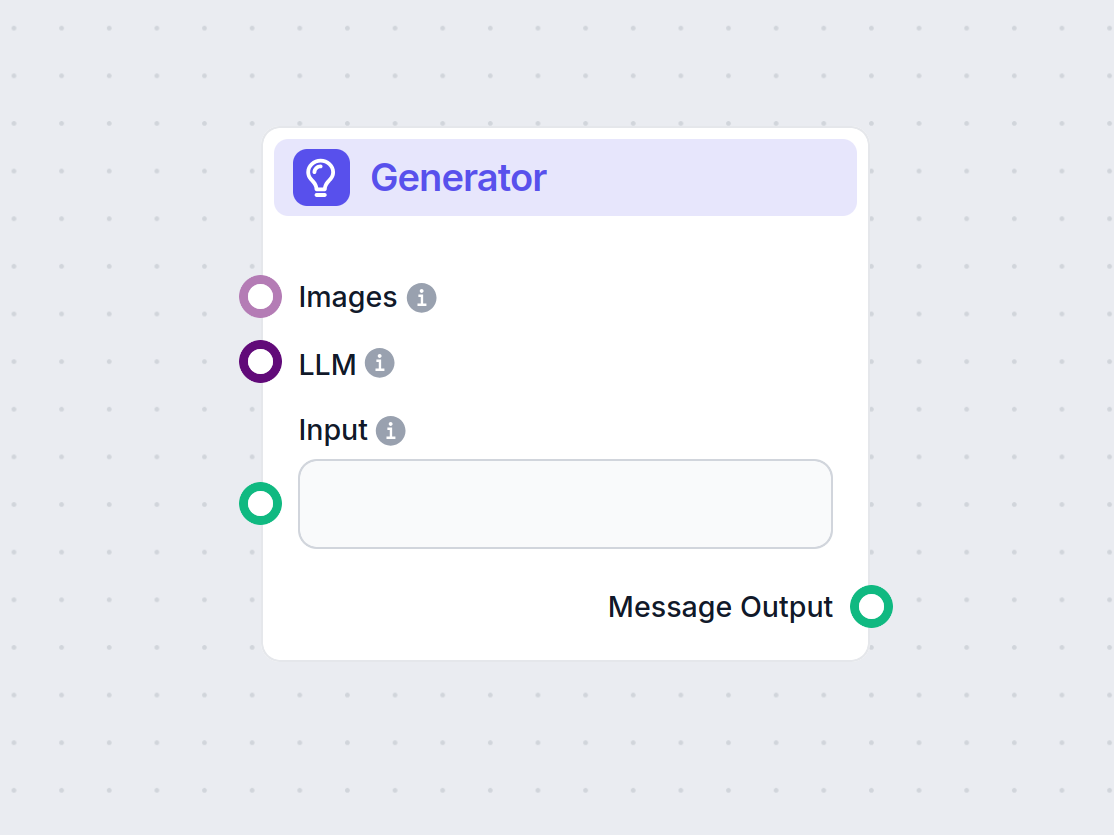

This component’s output is text that can be connected to various components. Most of the time, you immediately follow up with the Generator component to connect the prompt to an LLM.

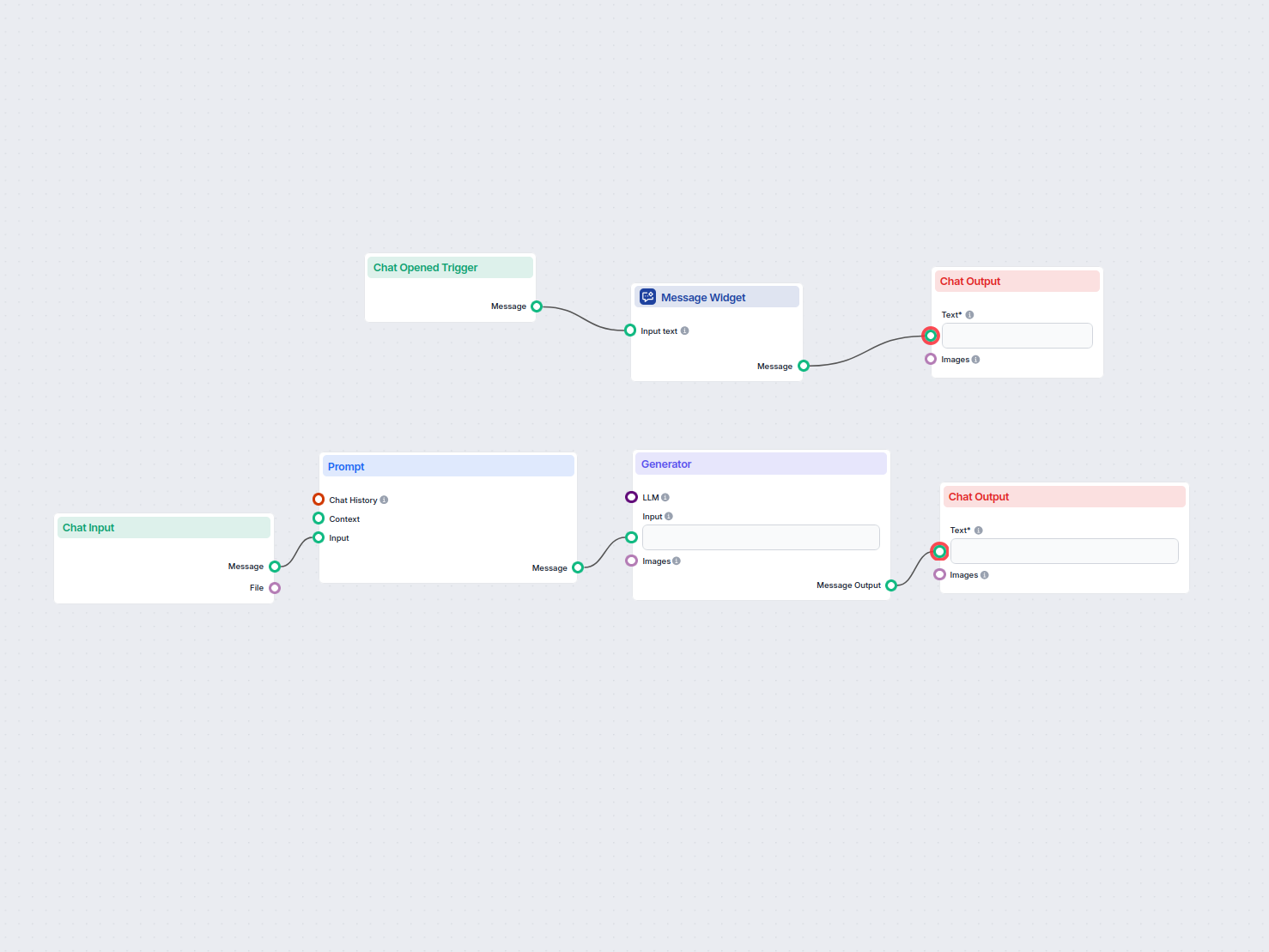

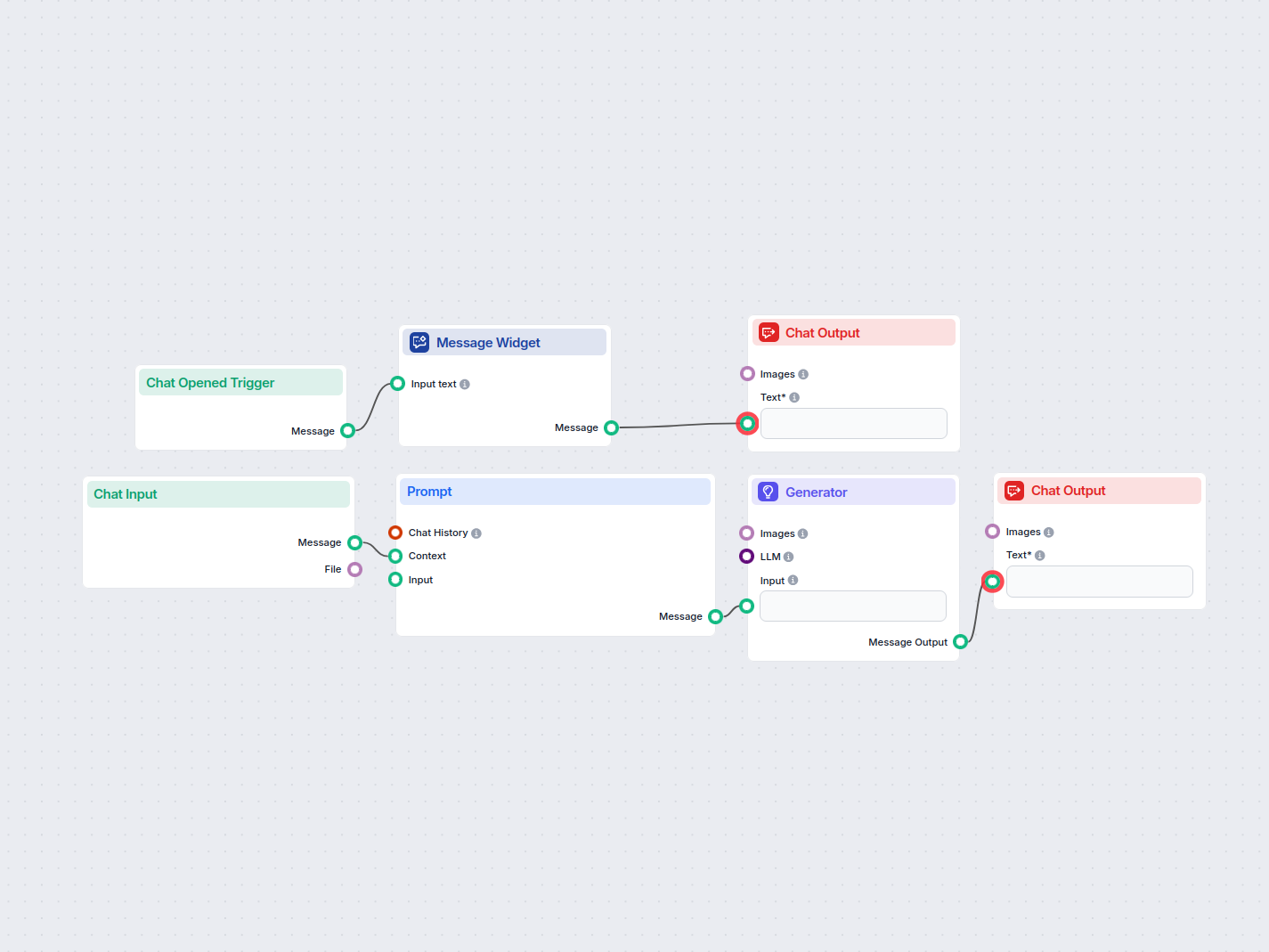

Let’s create a very simple bot. We’ll expand on the medieval knight bot example from earlier. While it talks funny, its main mission is to be a helpful customer service bot, and we want it to provide relevant information.

Let’s ask our bot a typical customer service question. We’ll ask about the pricing of URLsLab. To get a successful answer, we need to:

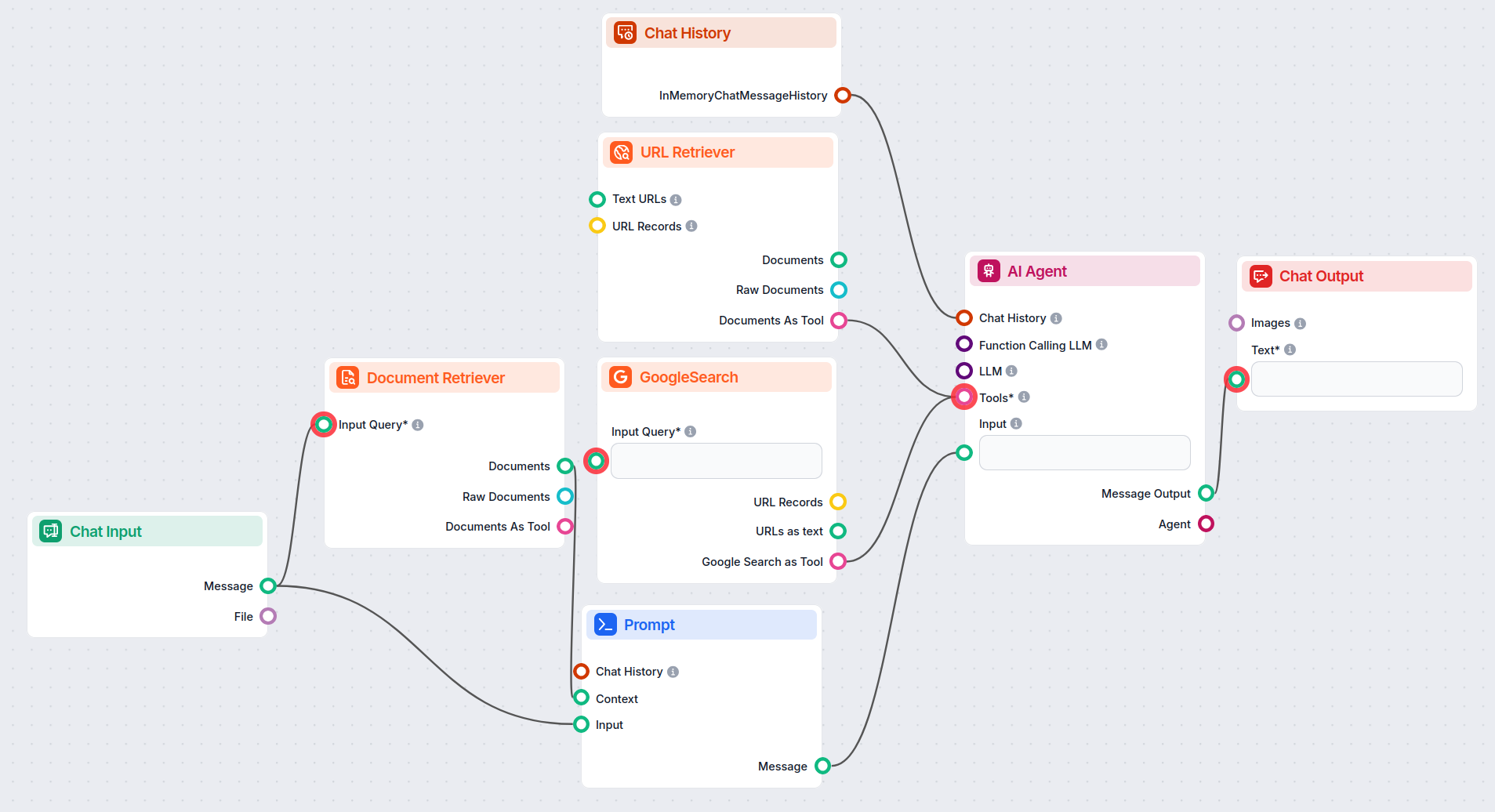

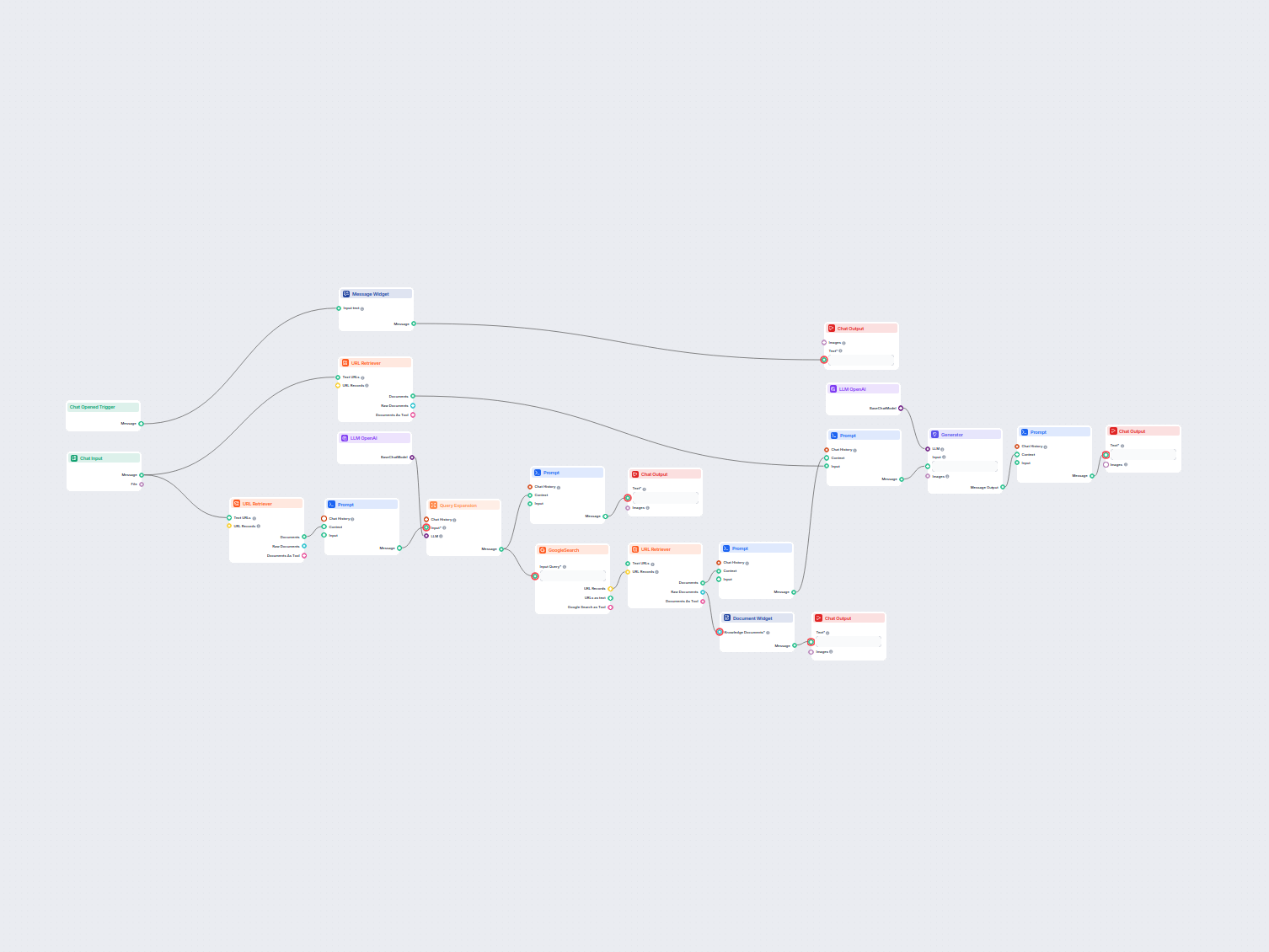

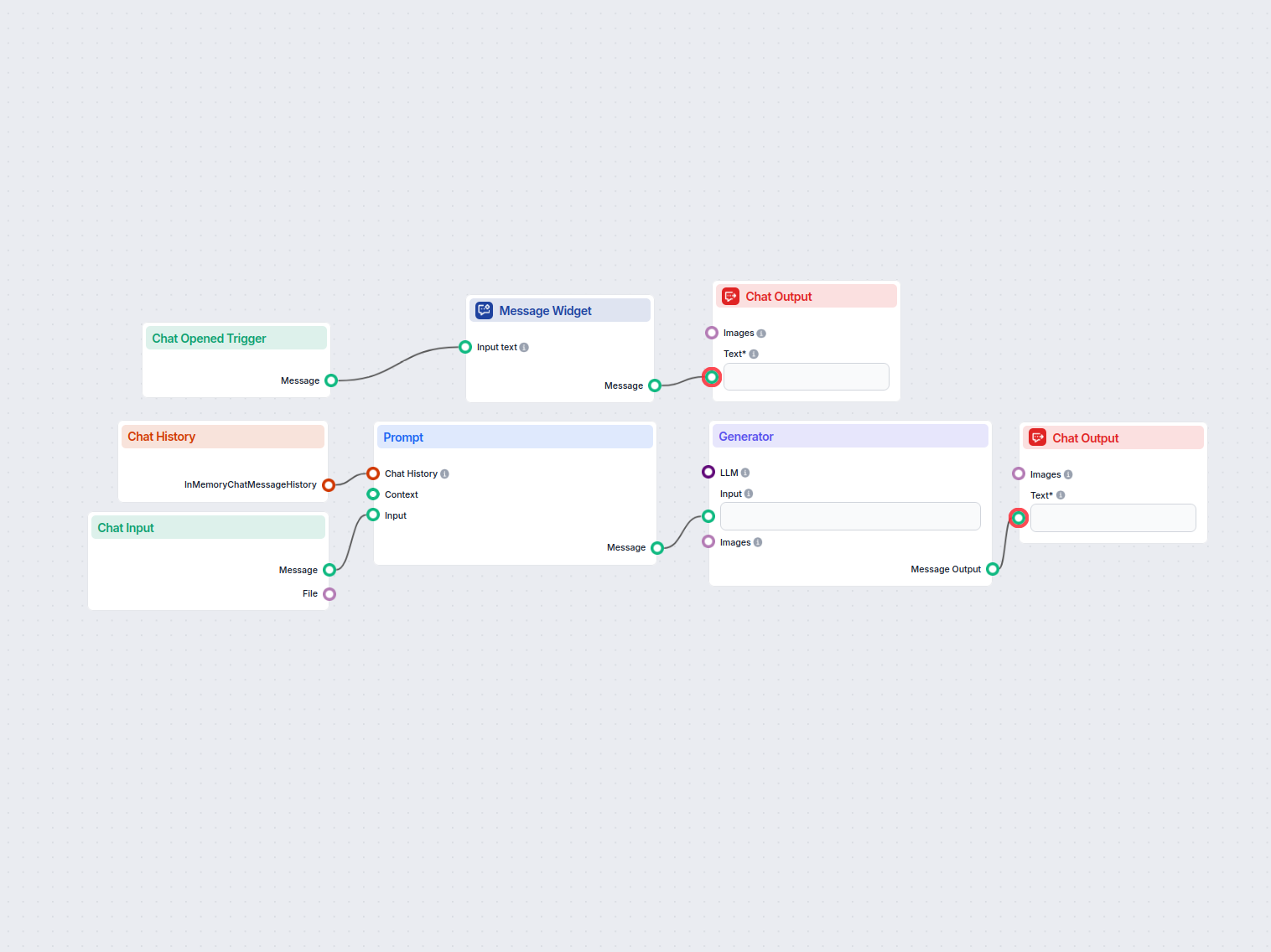

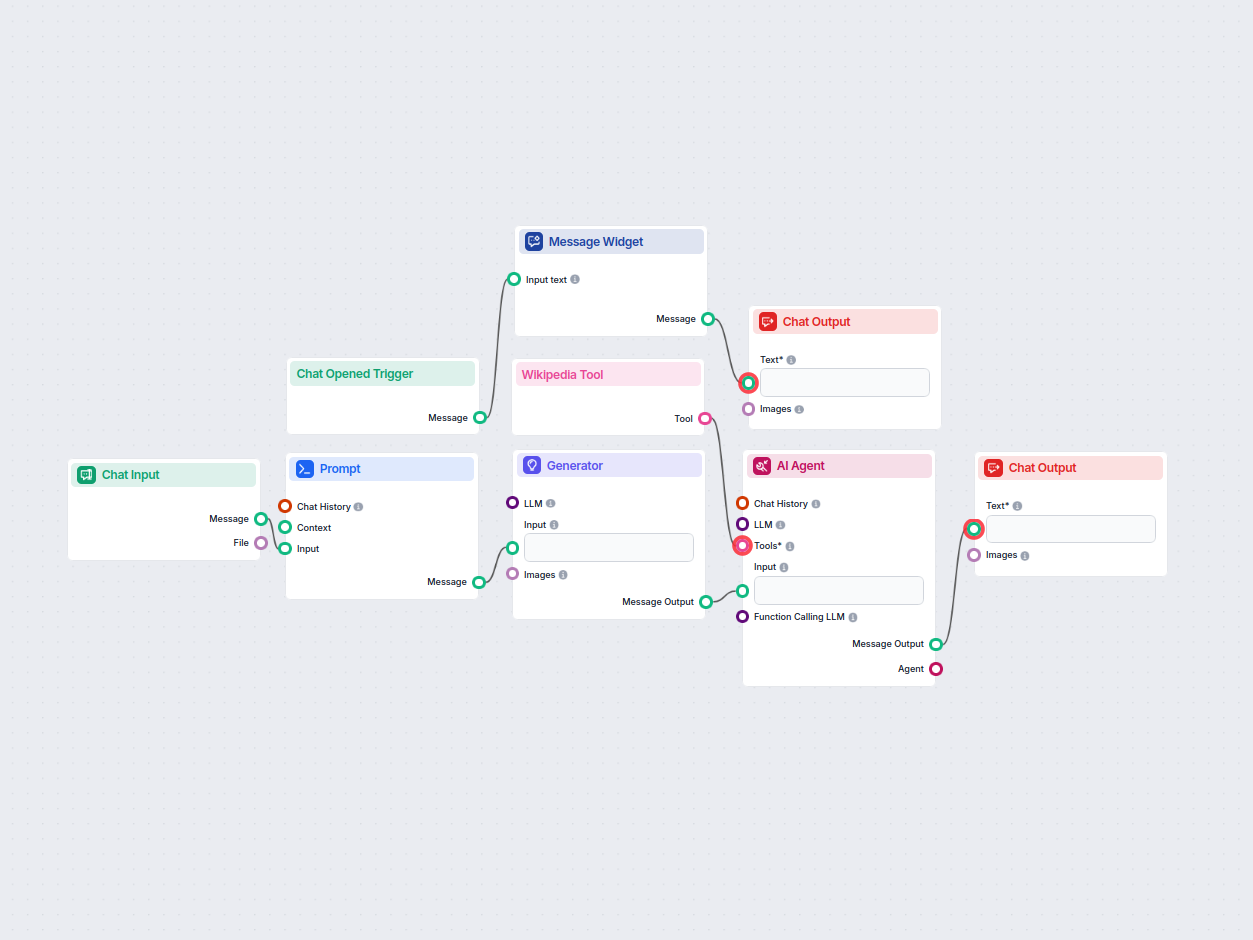

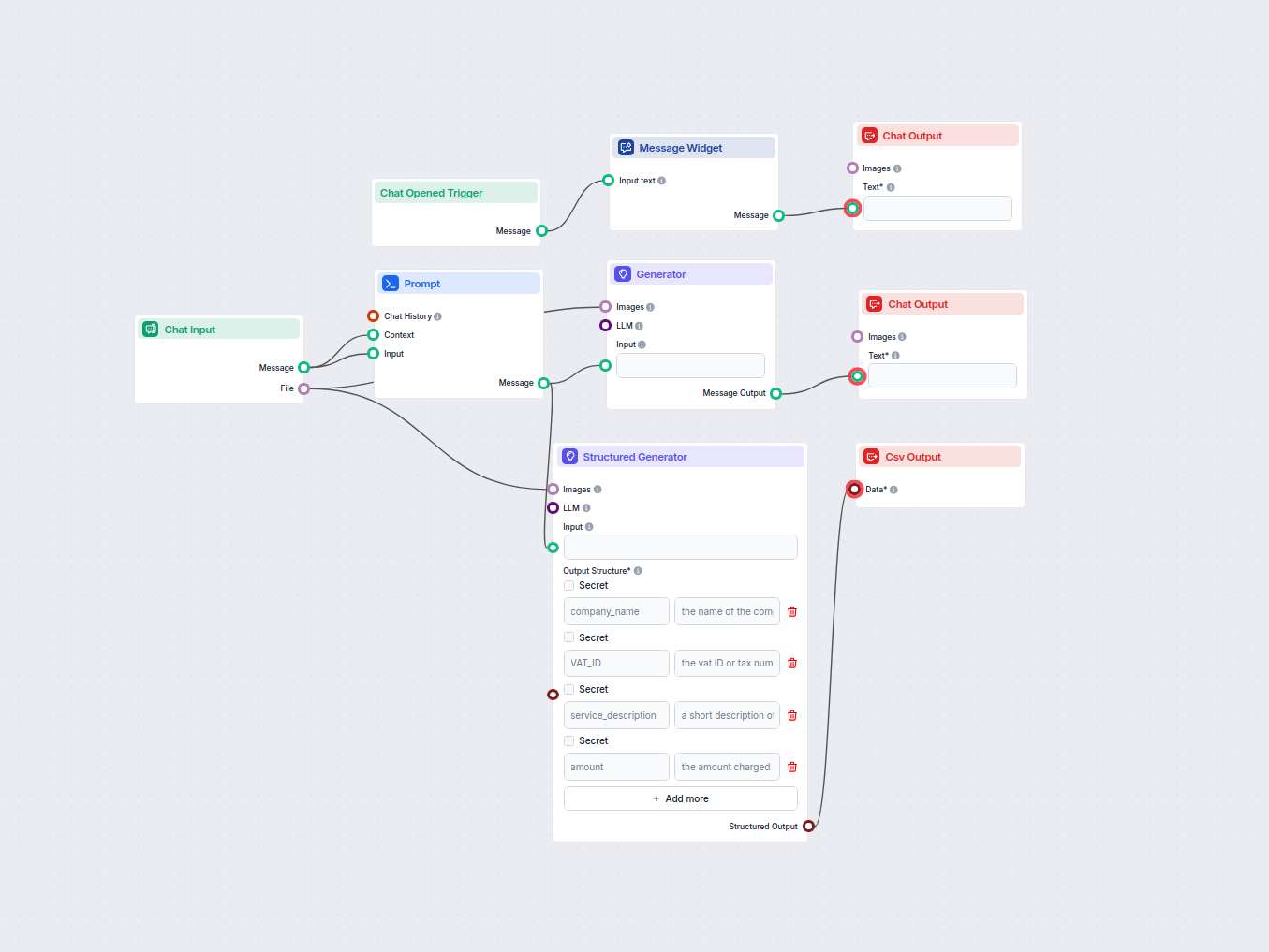

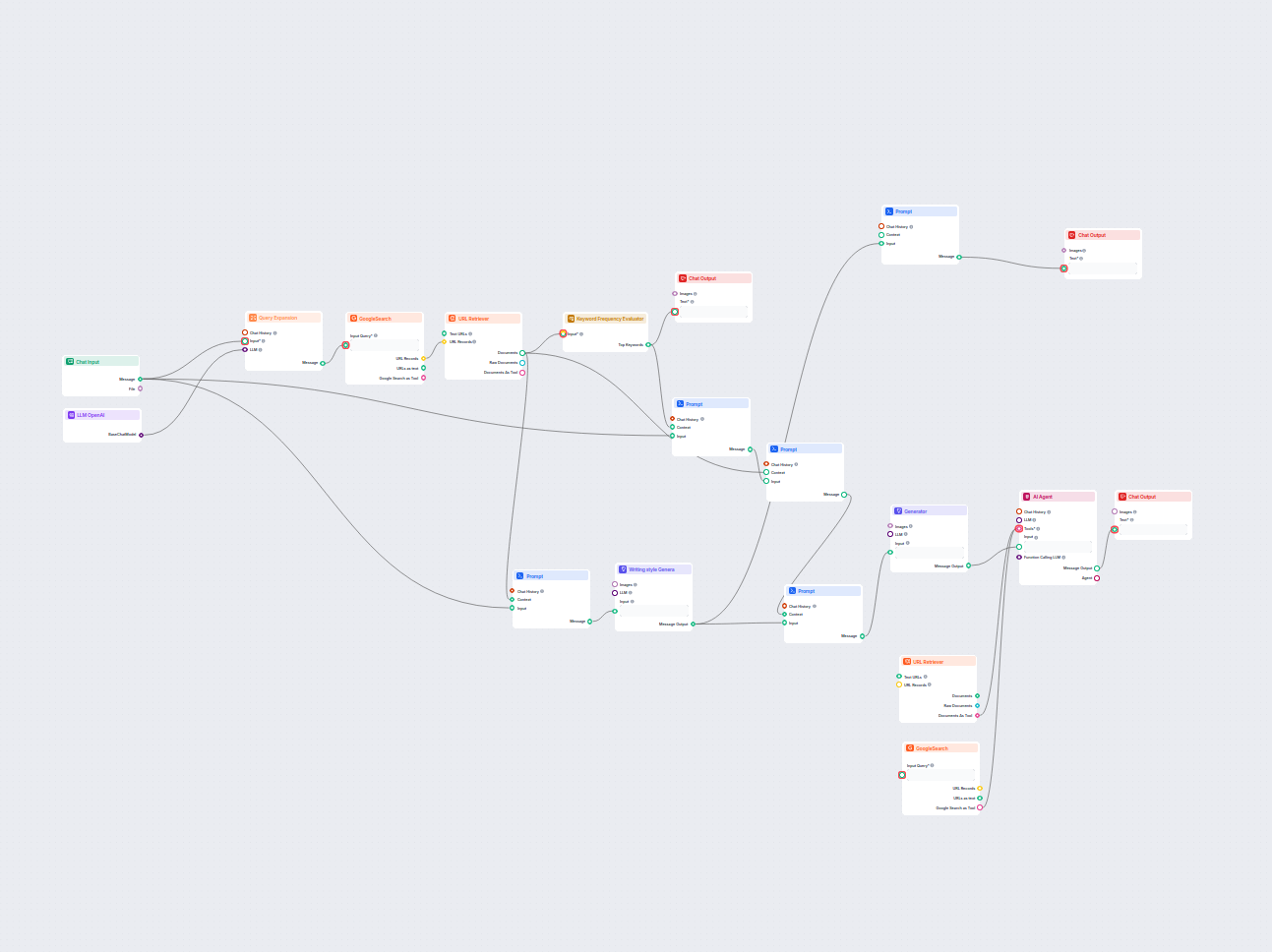

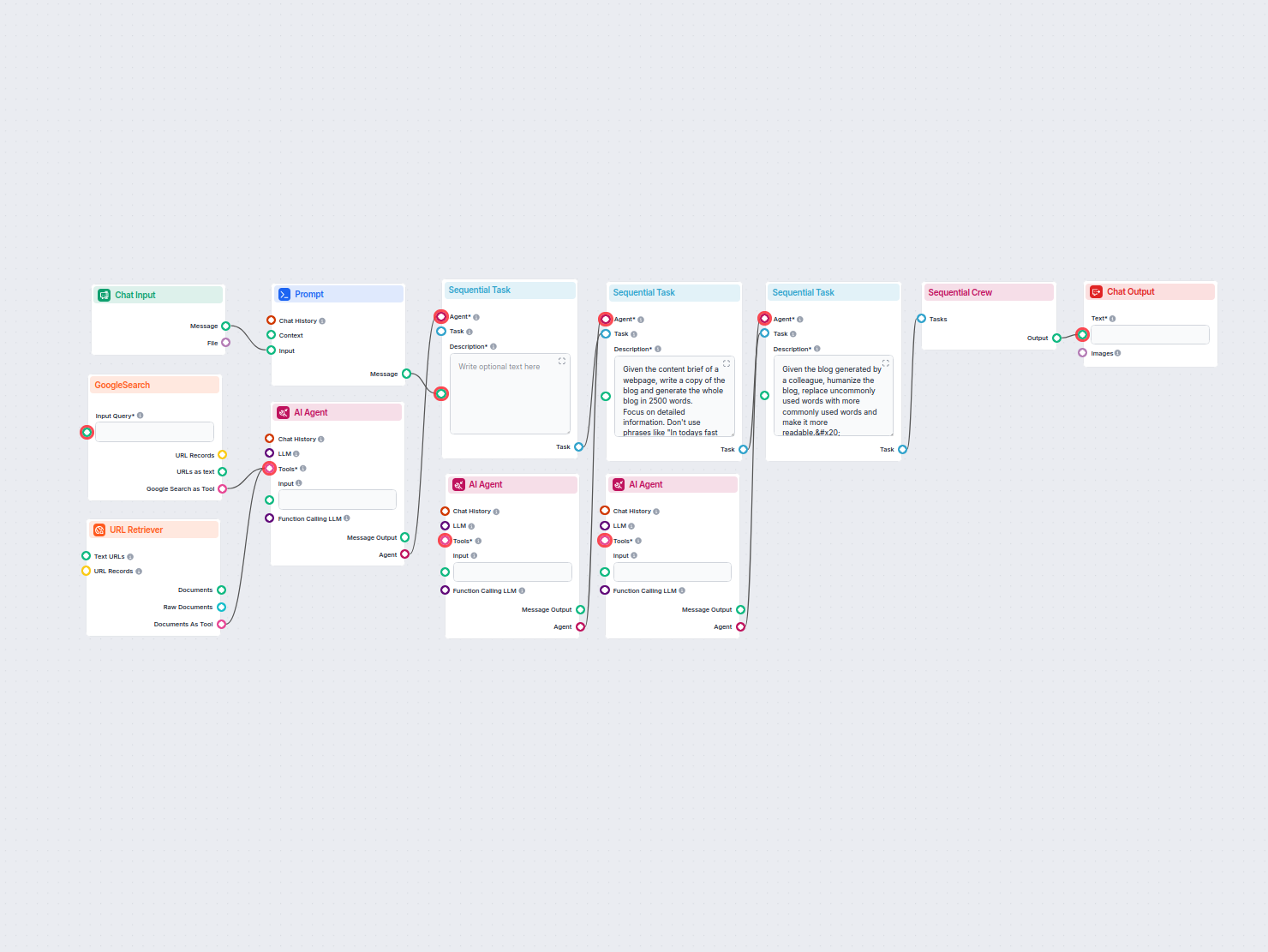

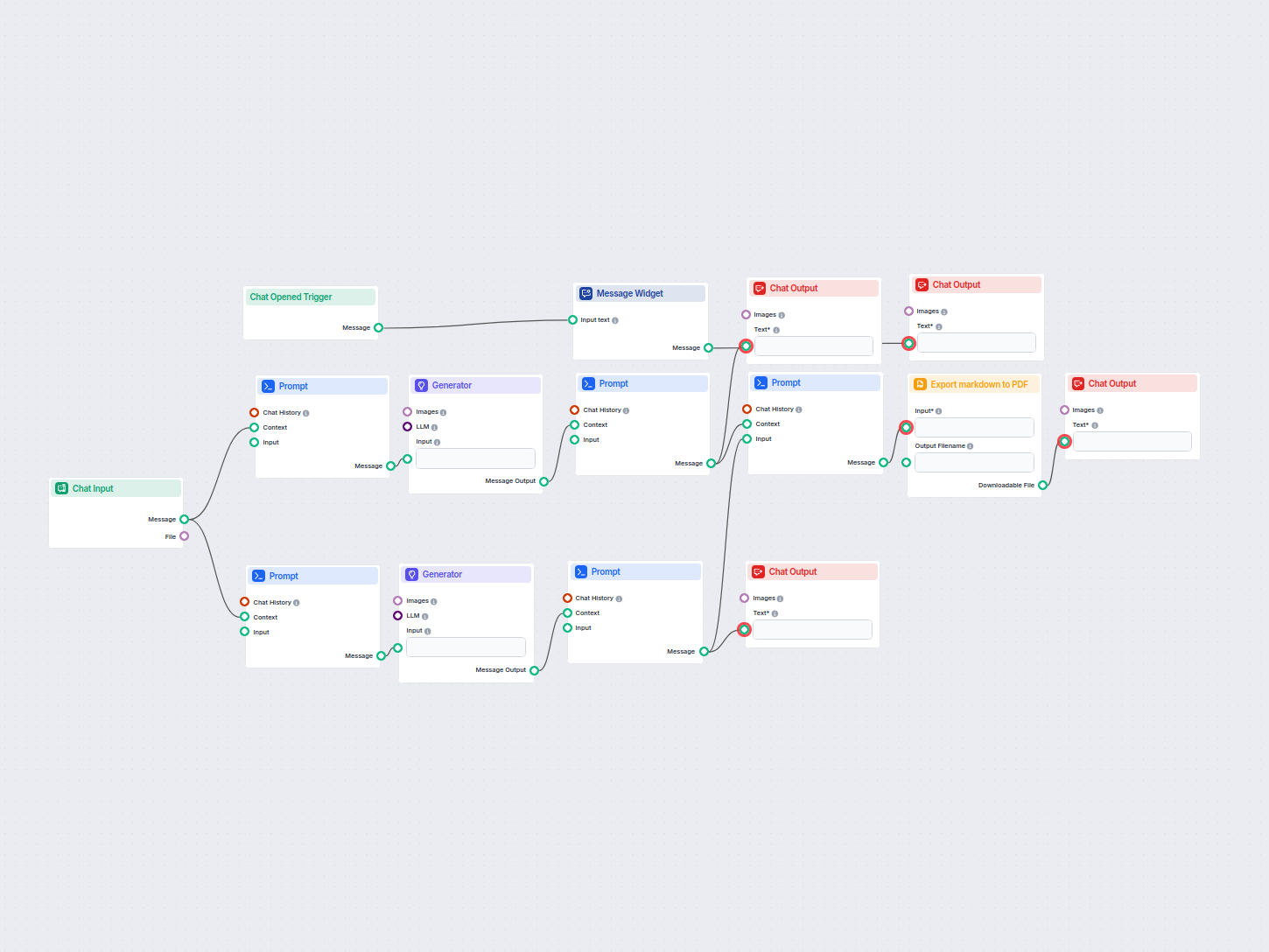

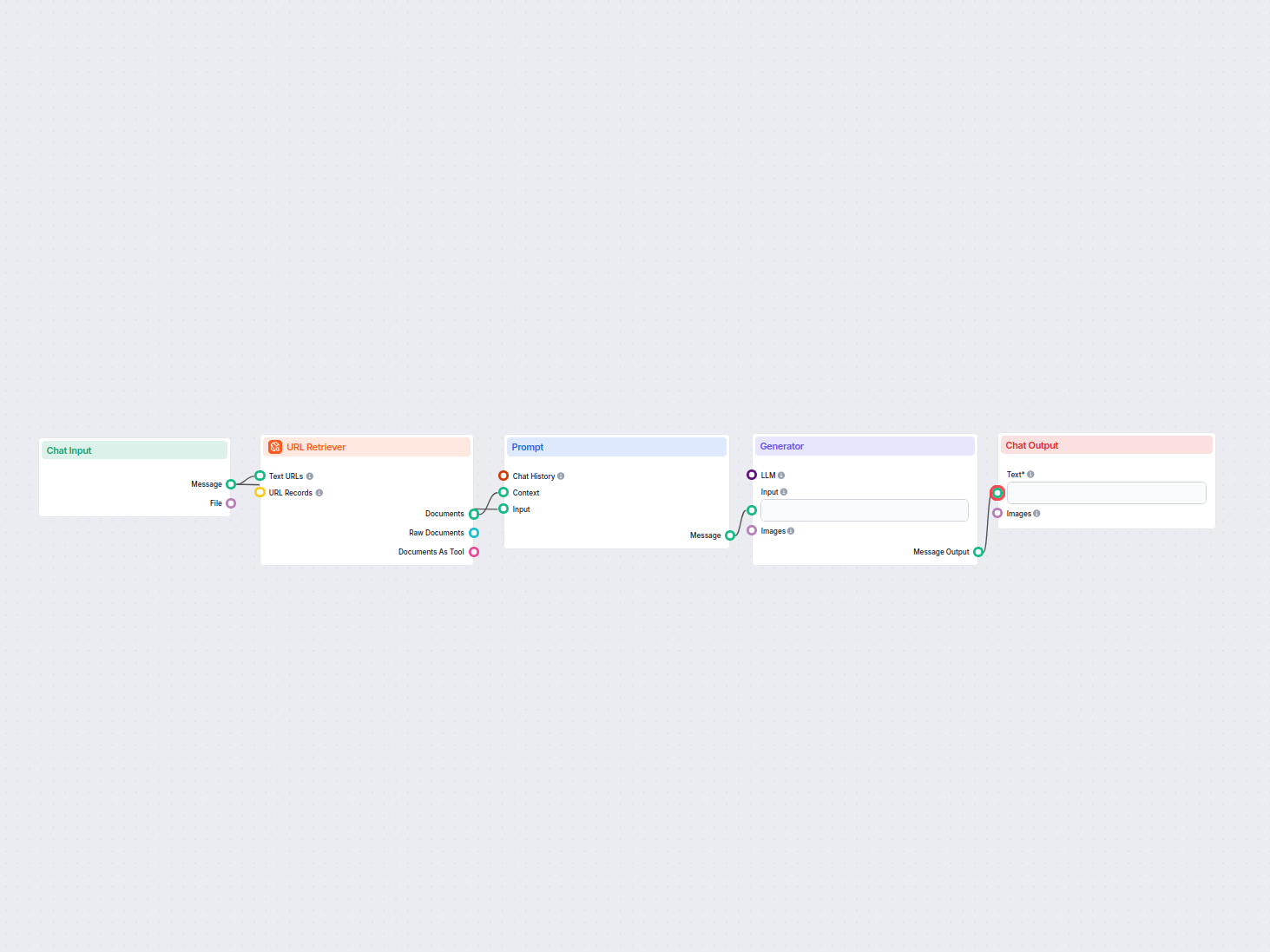

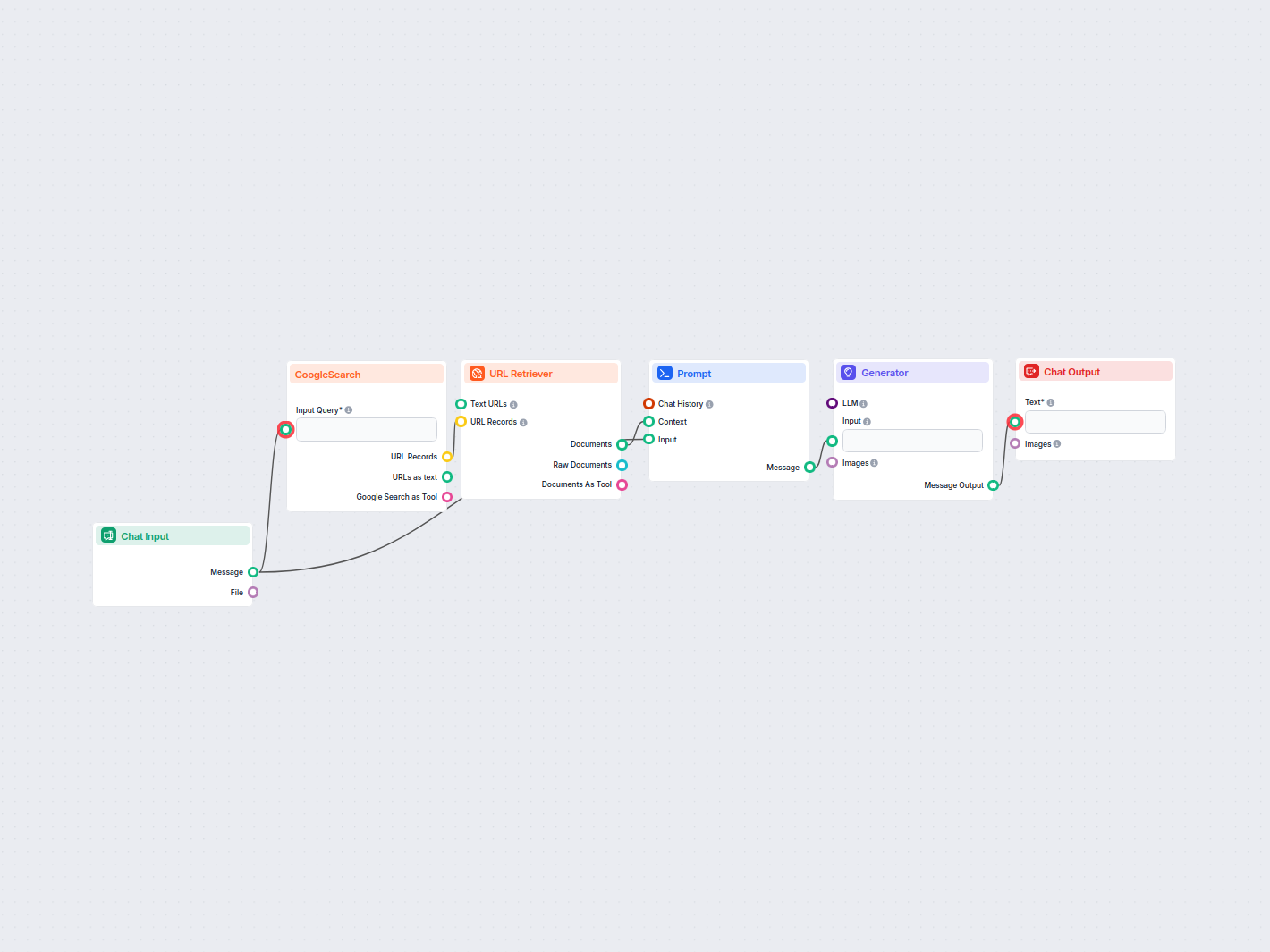

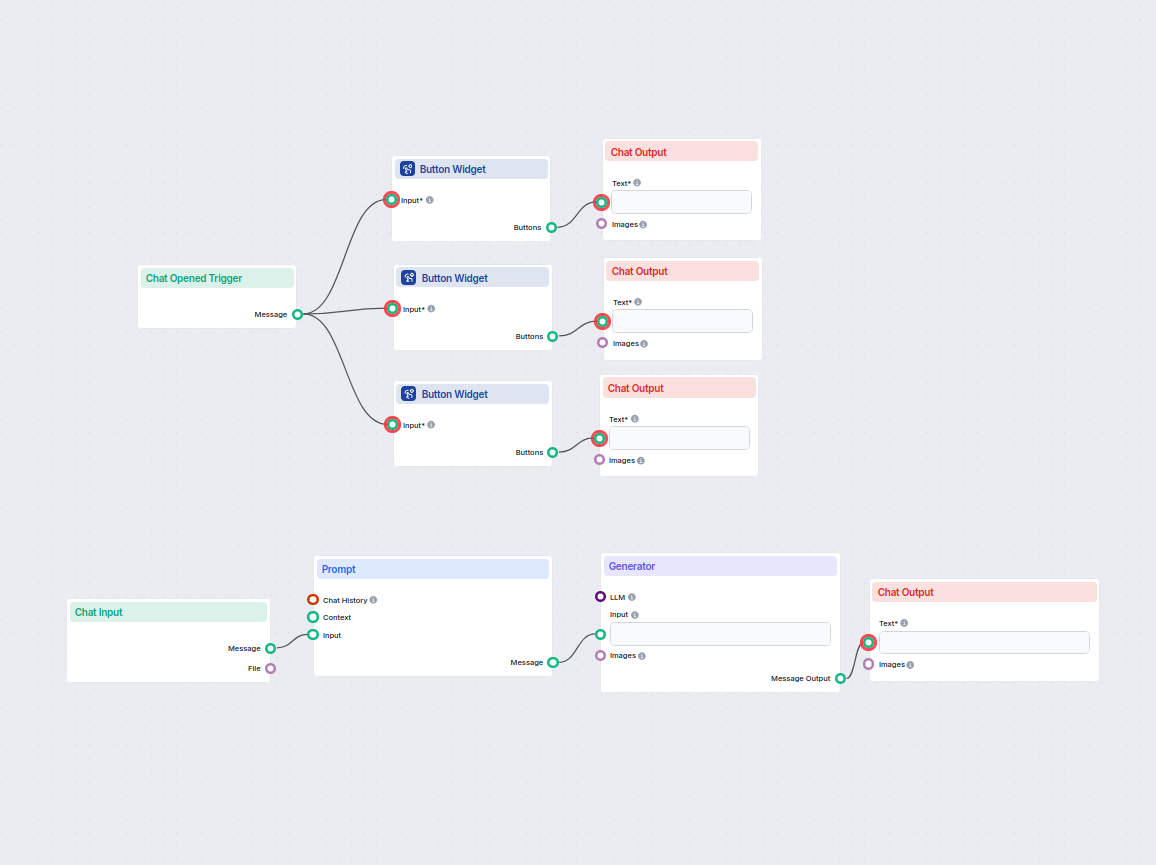

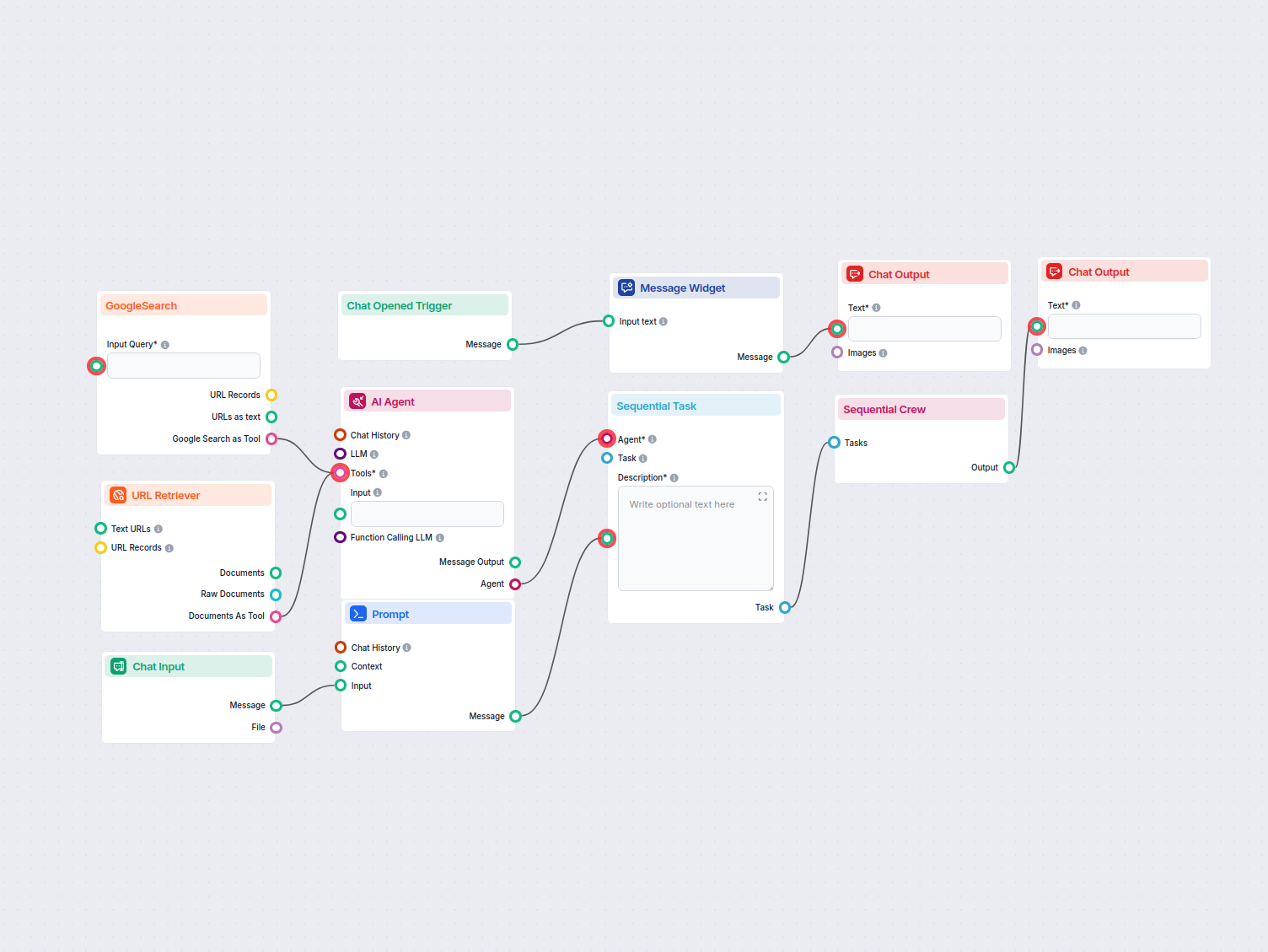

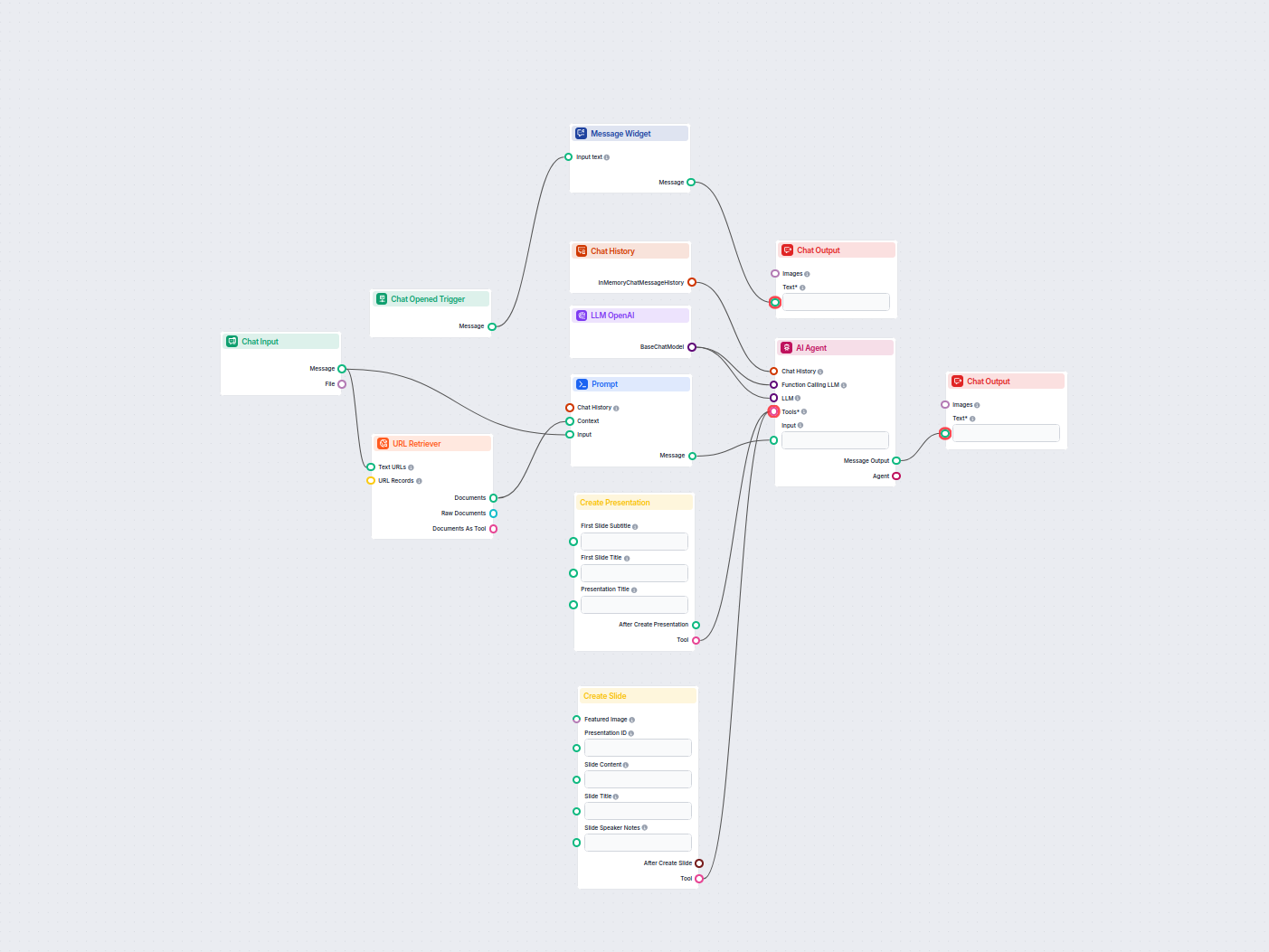

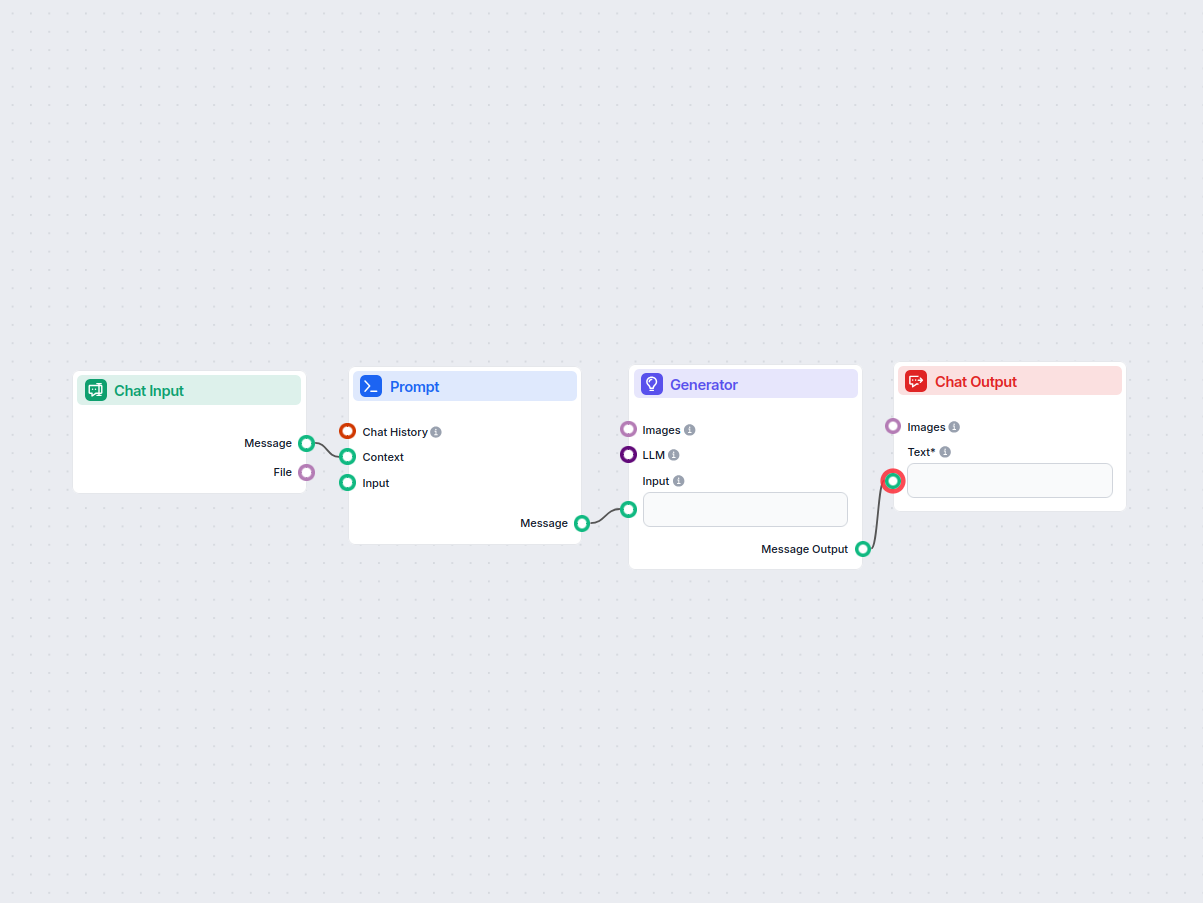

The resulting flow will look something like this:

It’s time to test the knowledge of our medieval knight bot. The URL we gave it is the pricing for URLsLab. So let’s ask about it:

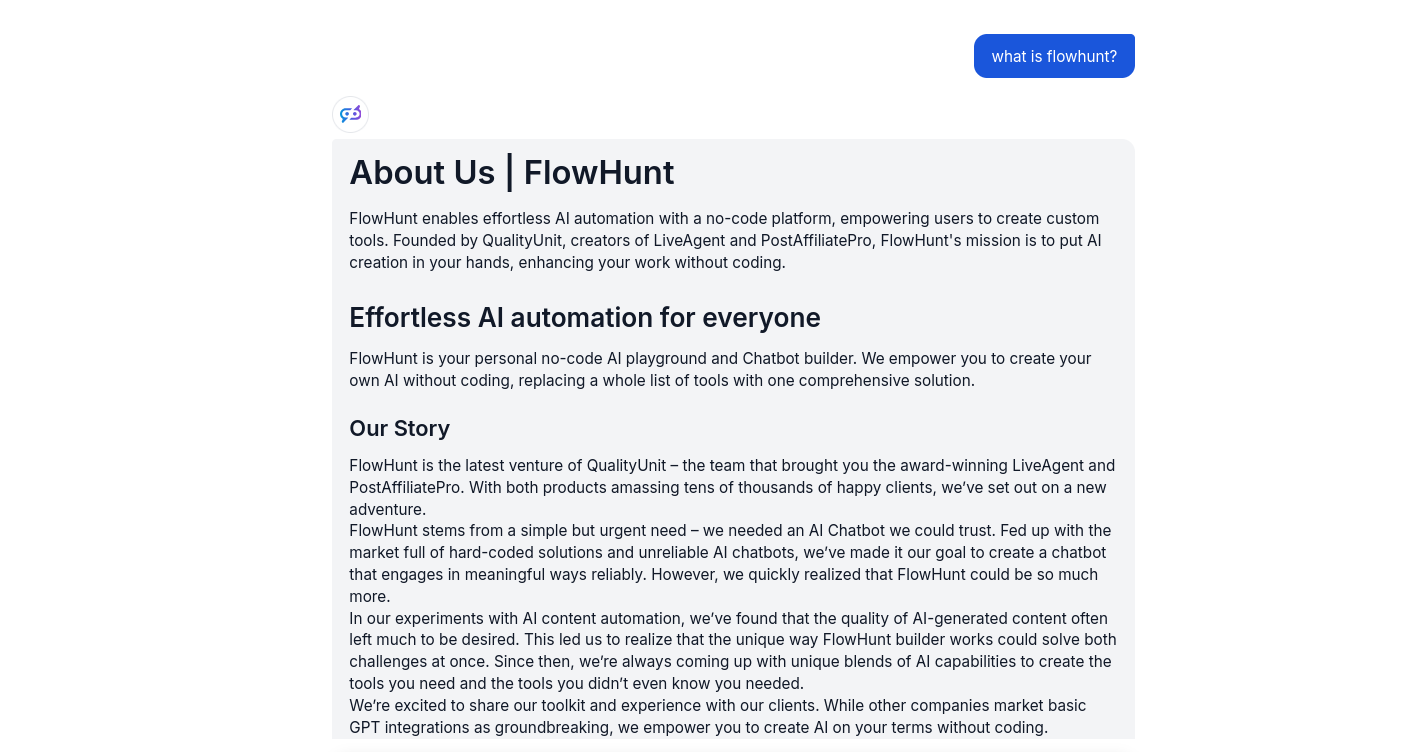

Our bot now uses pompous old-timey language to answer basic queries. But more importantly, notice how the bot adheres to its central role as a helpful customer service bot. Lastly, it successfully uses the information from the specified URL.

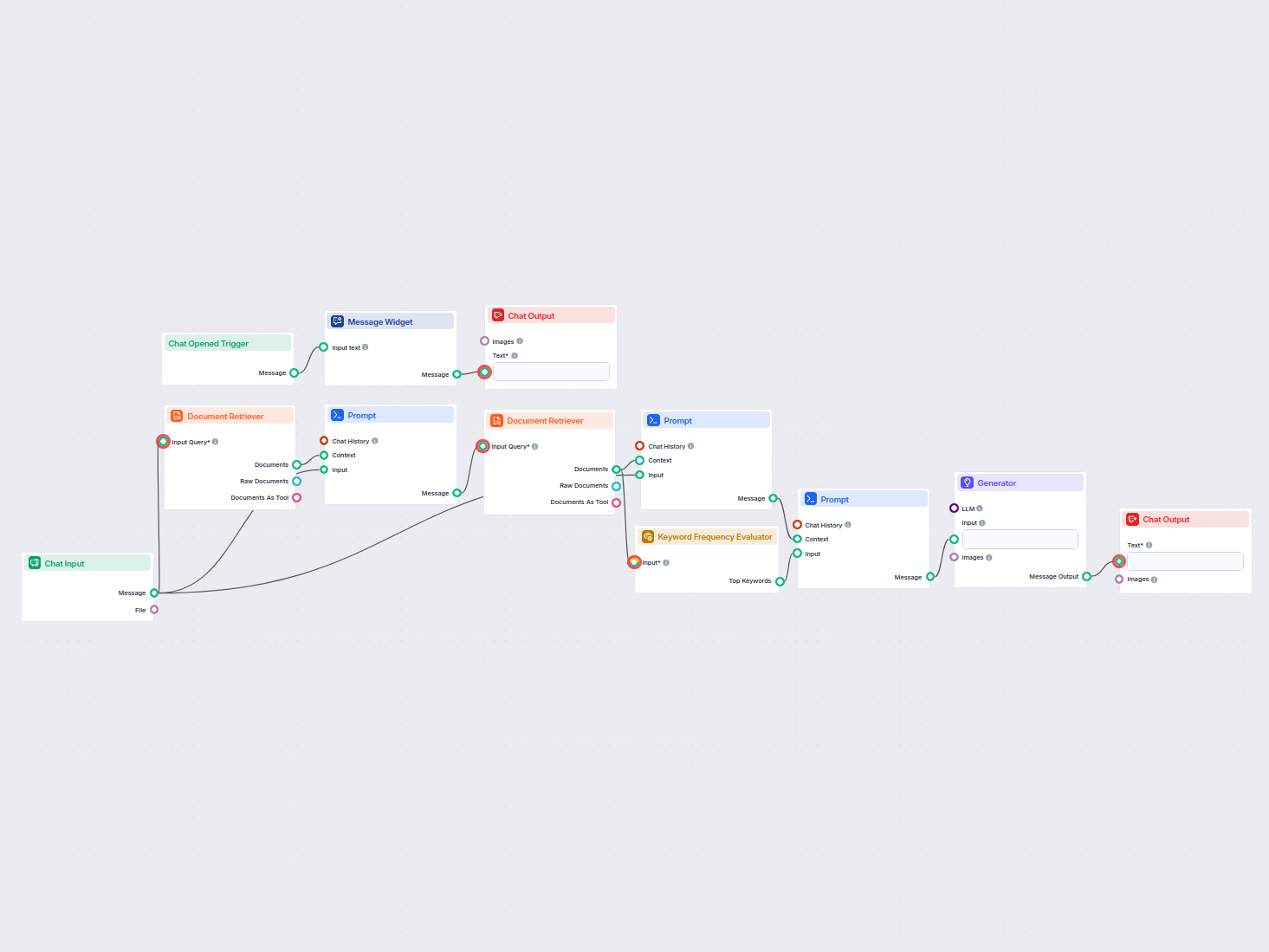

Pour vous aider à démarrer rapidement, nous avons préparé plusieurs exemples de modèles de flux qui démontrent comment utiliser efficacement le composant Composant Prompt dans FlowHunt. Ces modèles présentent différents cas d'utilisation et meilleures pratiques, facilitant votre compréhension et l'implémentation du composant dans vos propres projets.

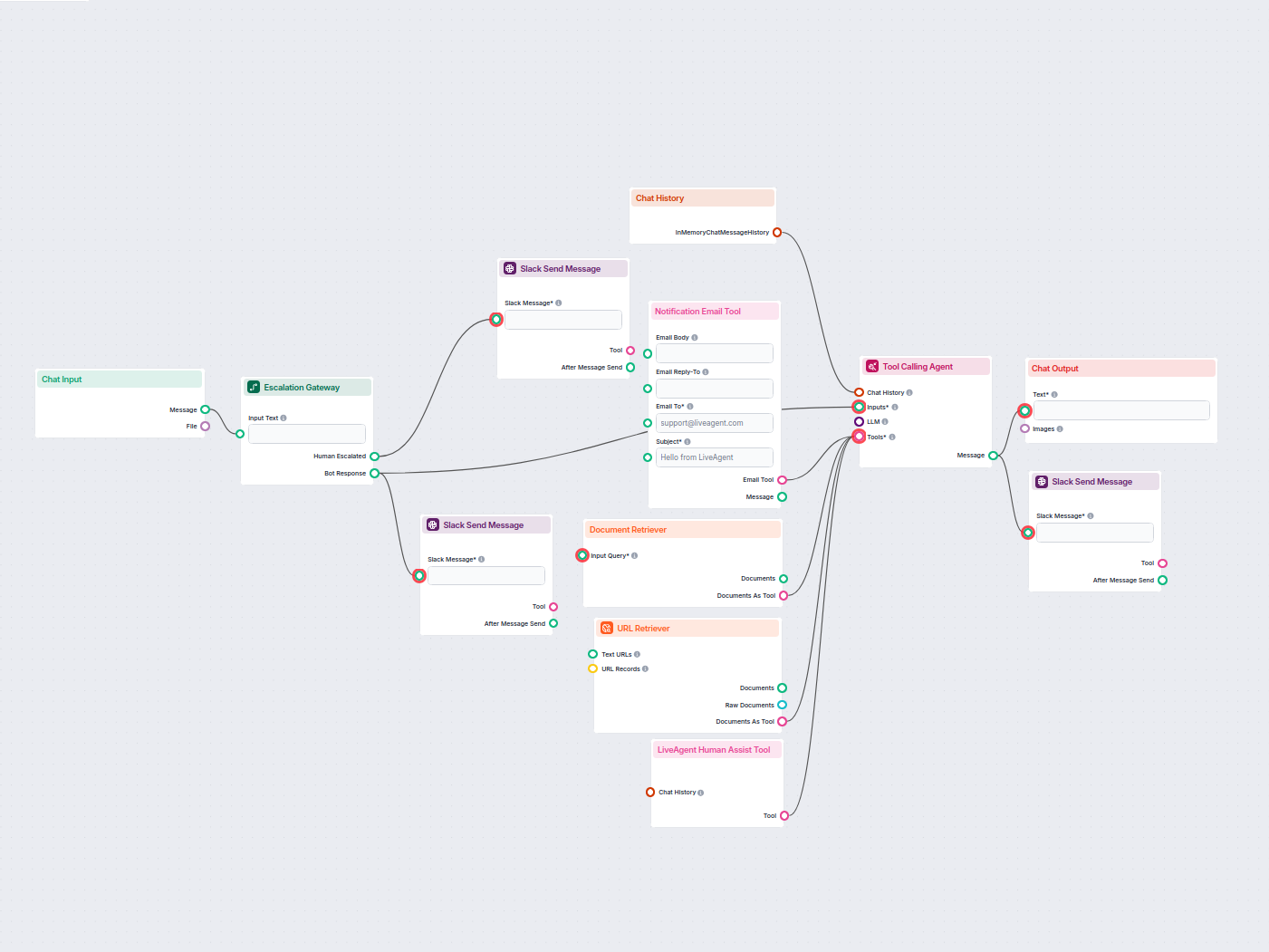

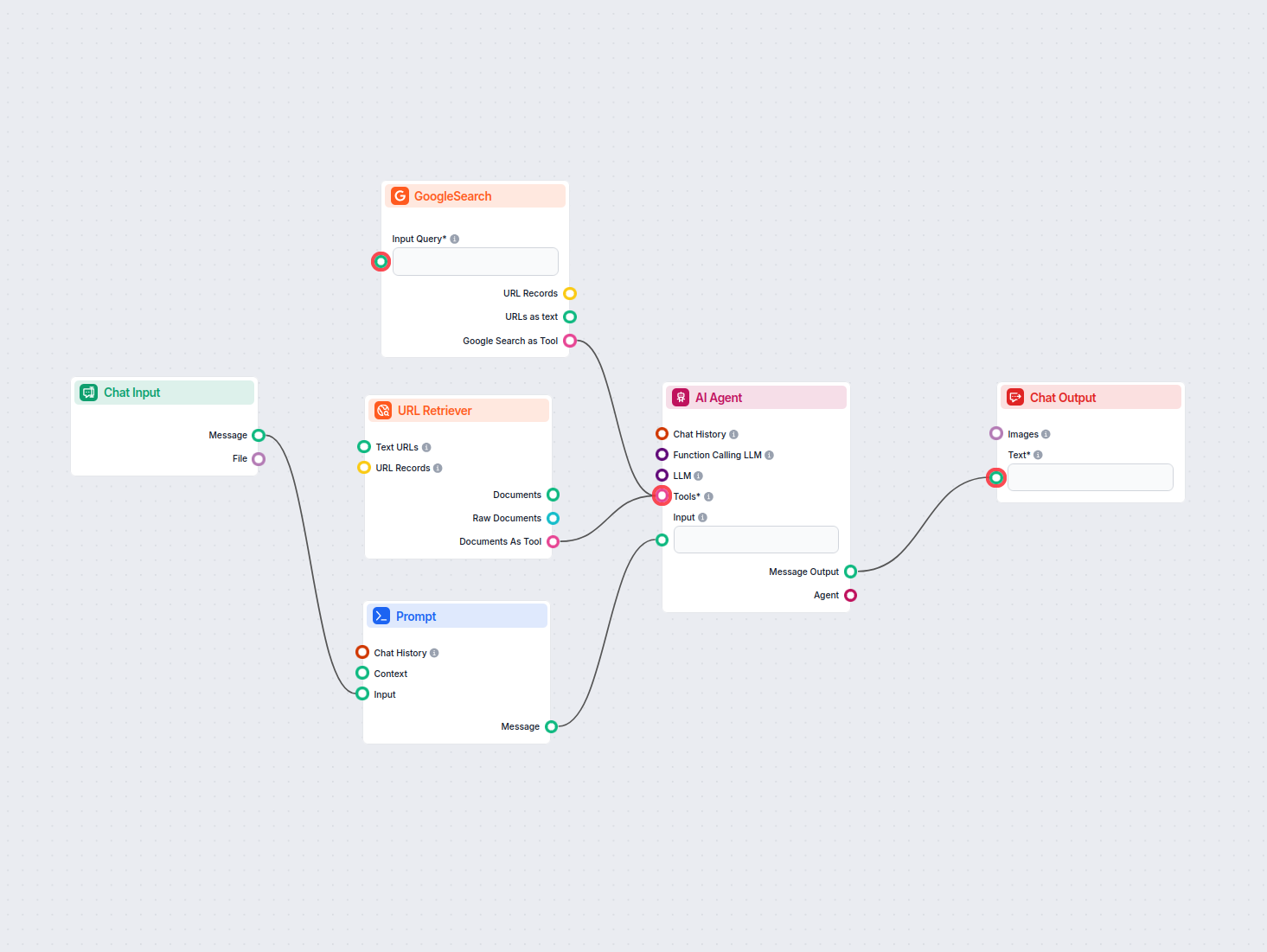

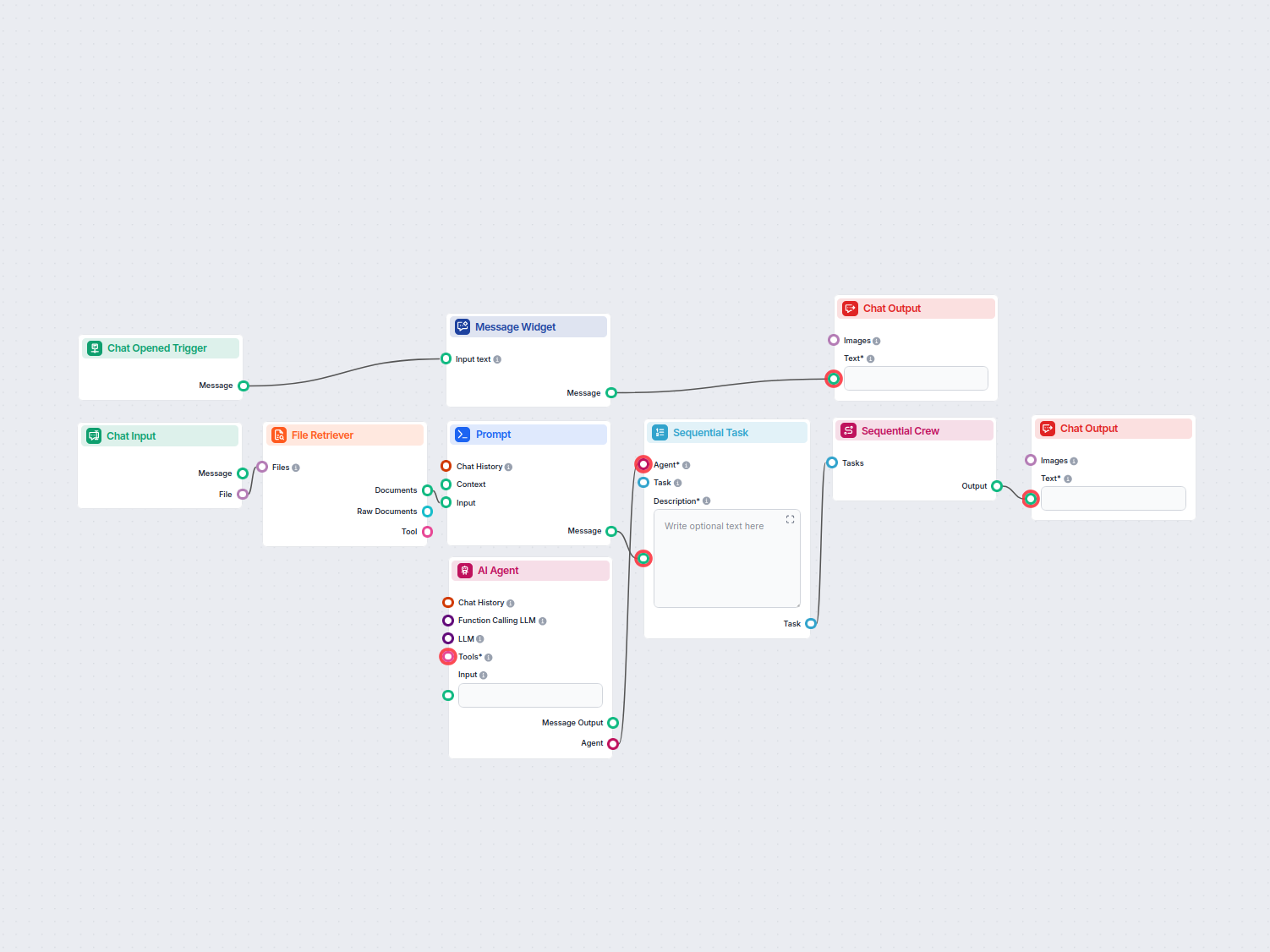

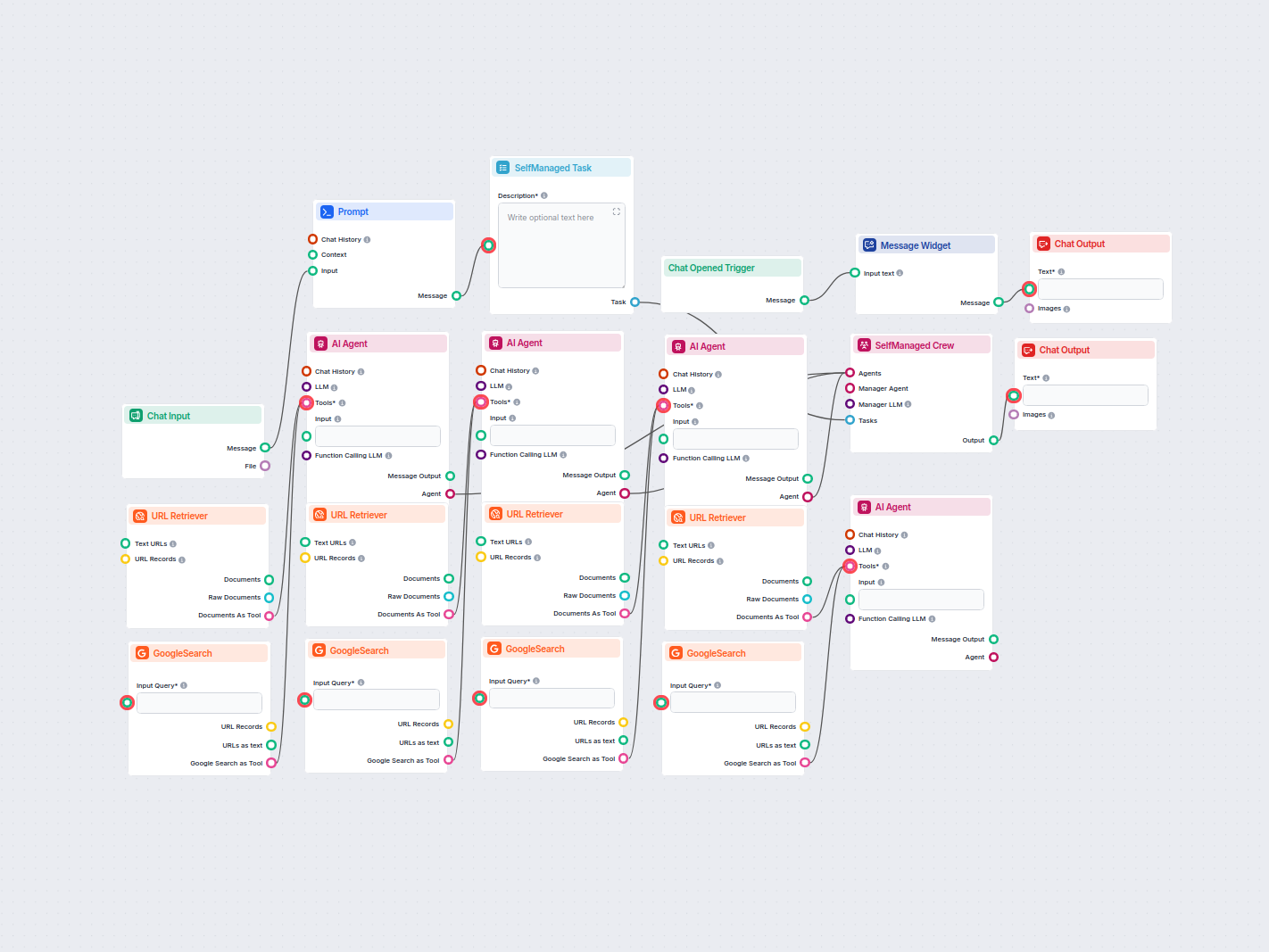

Ce workflow alimenté par l’IA automatise l’assistance client en combinant la recherche dans la base de connaissances interne, la récupération de connaissances d...

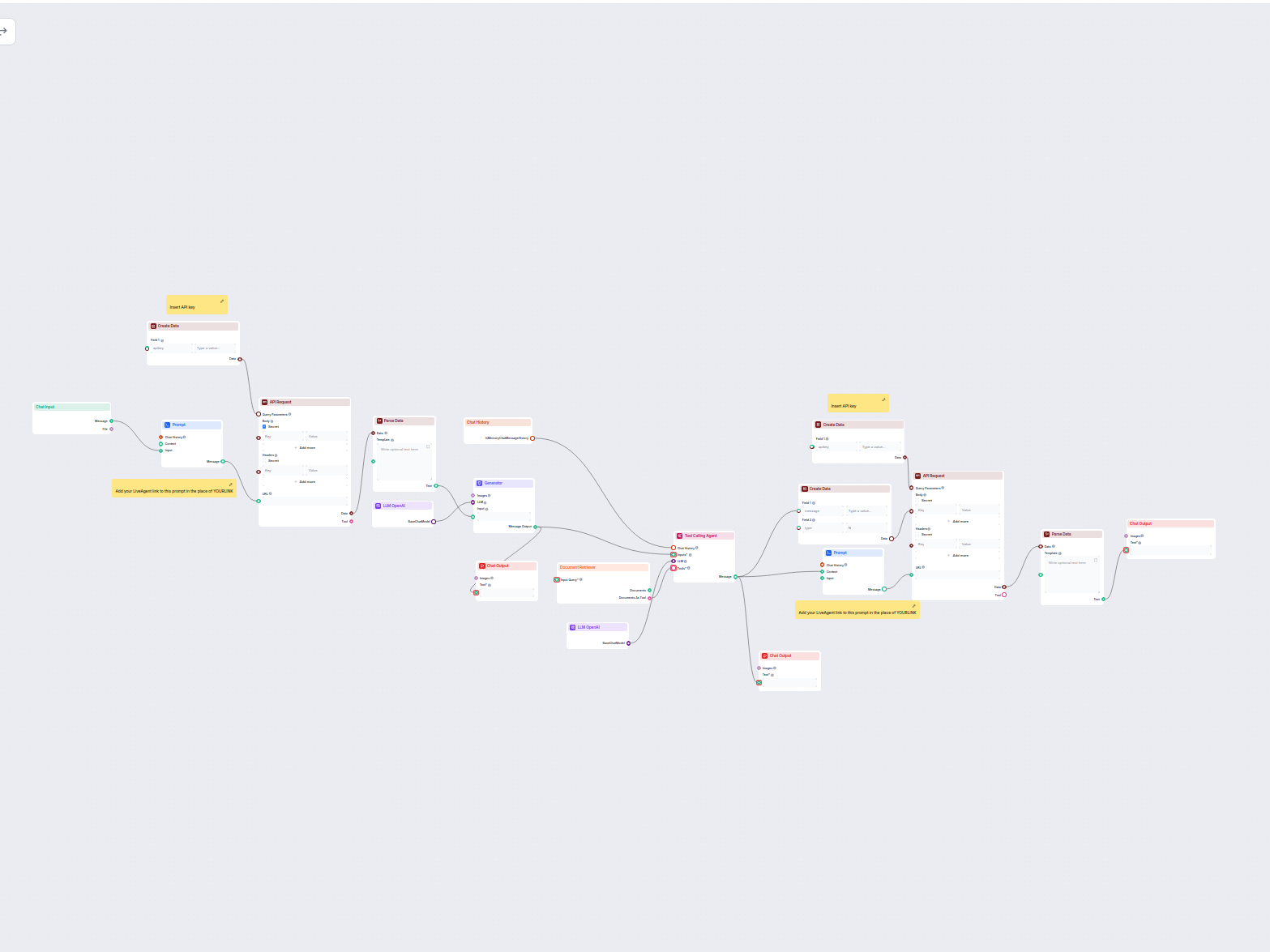

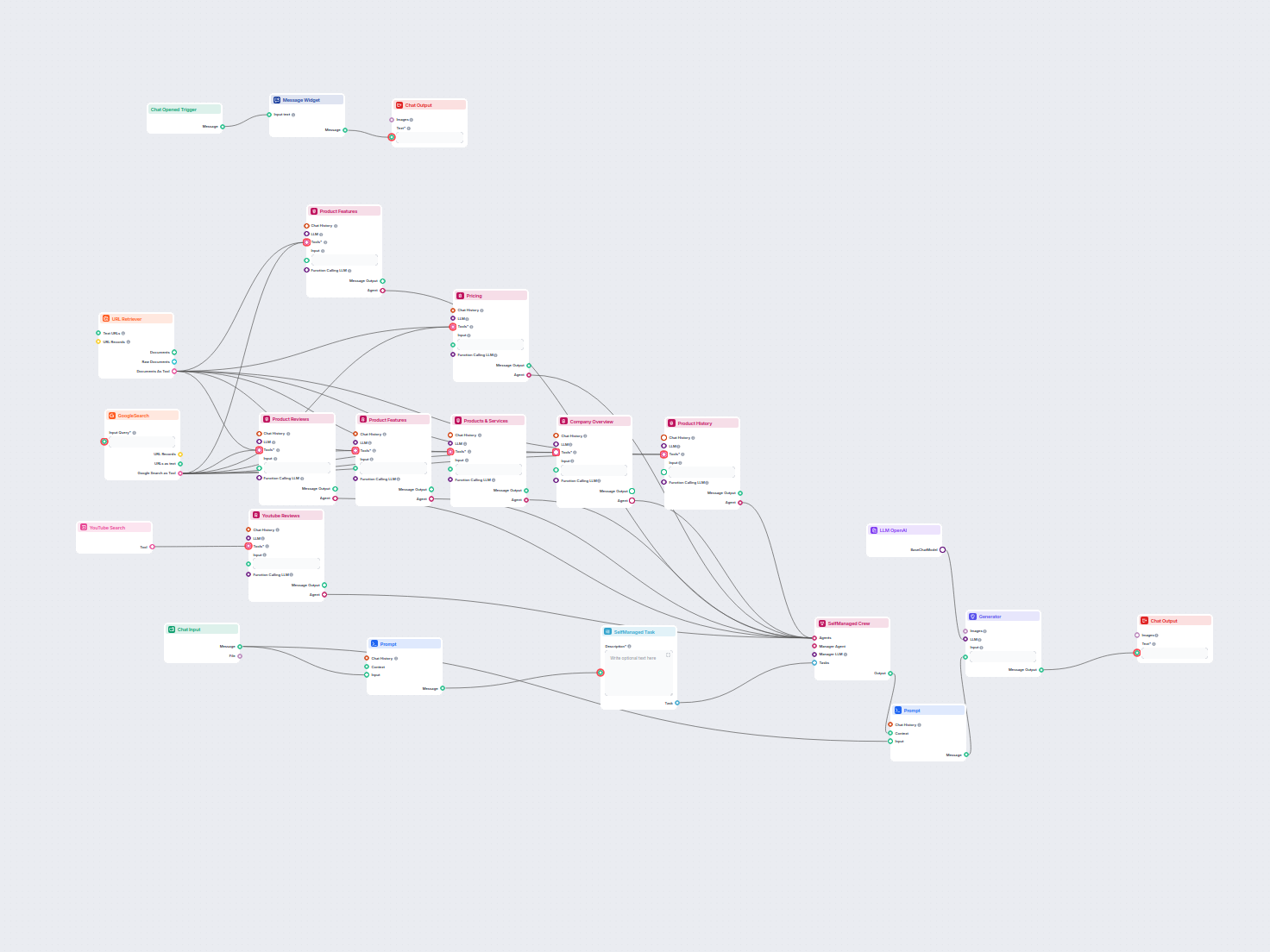

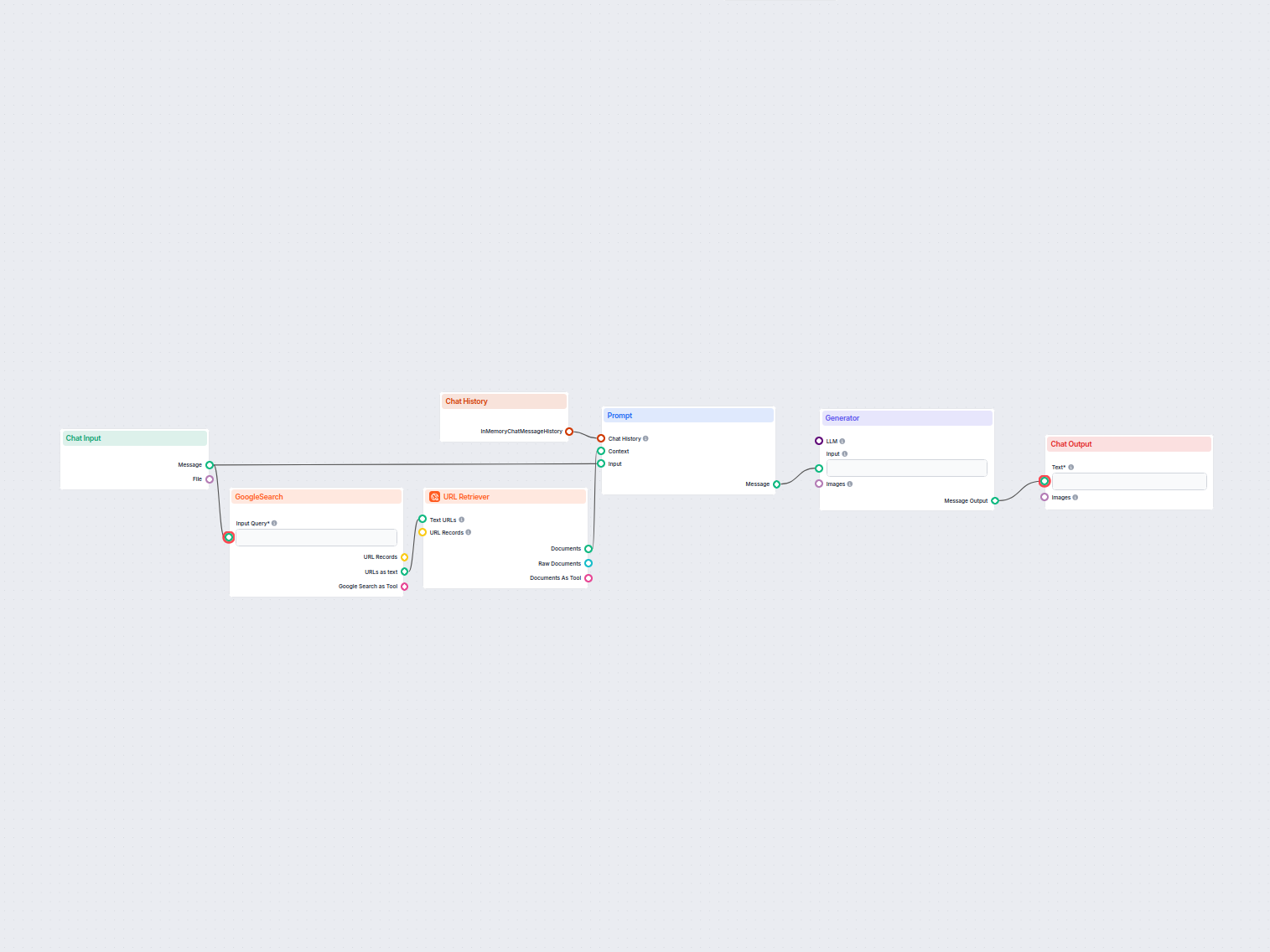

Ce workflow alimenté par l’IA automatise le support client en connectant les demandes des utilisateurs aux sources de connaissances de l'entreprise, à des API e...

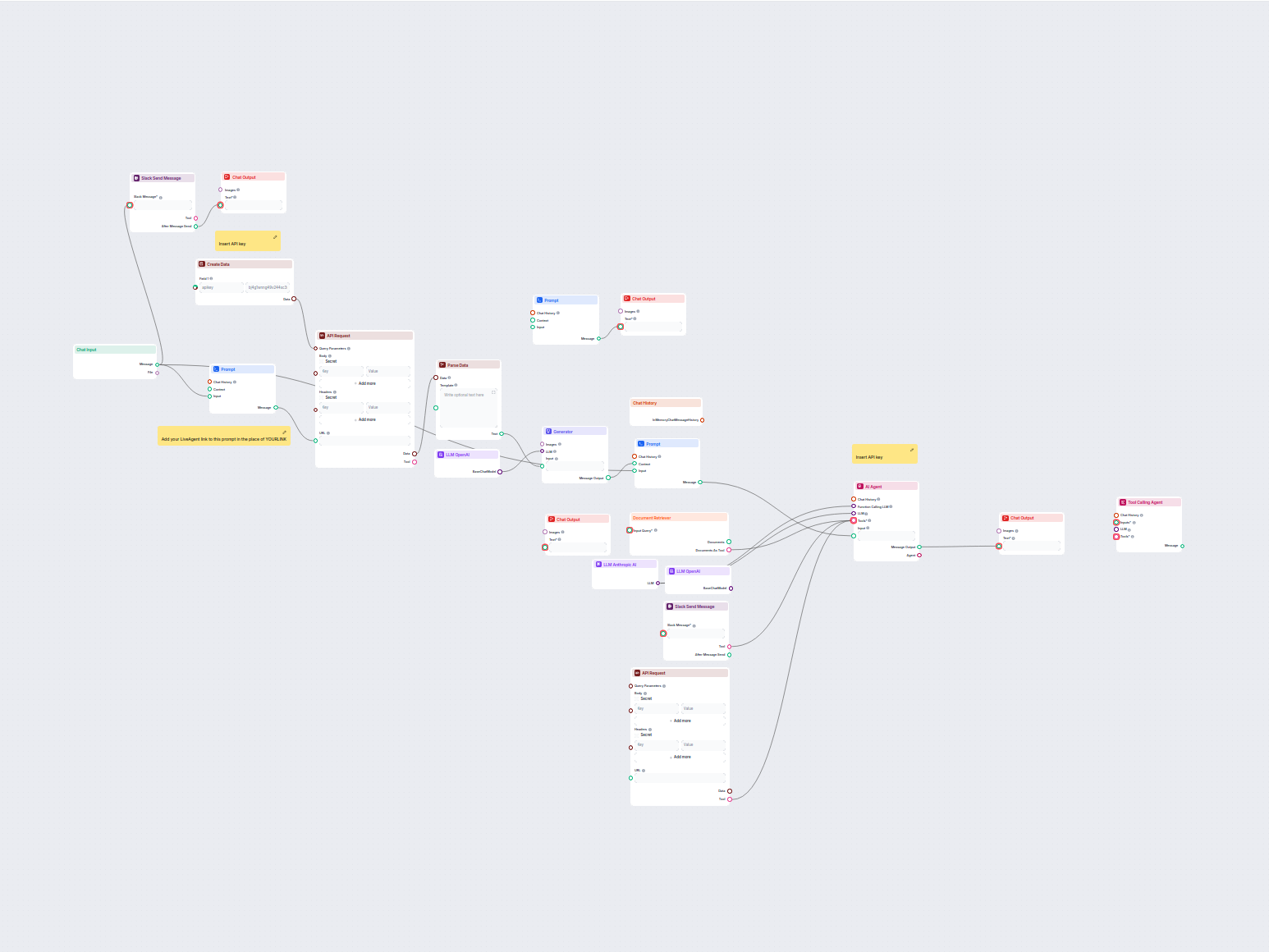

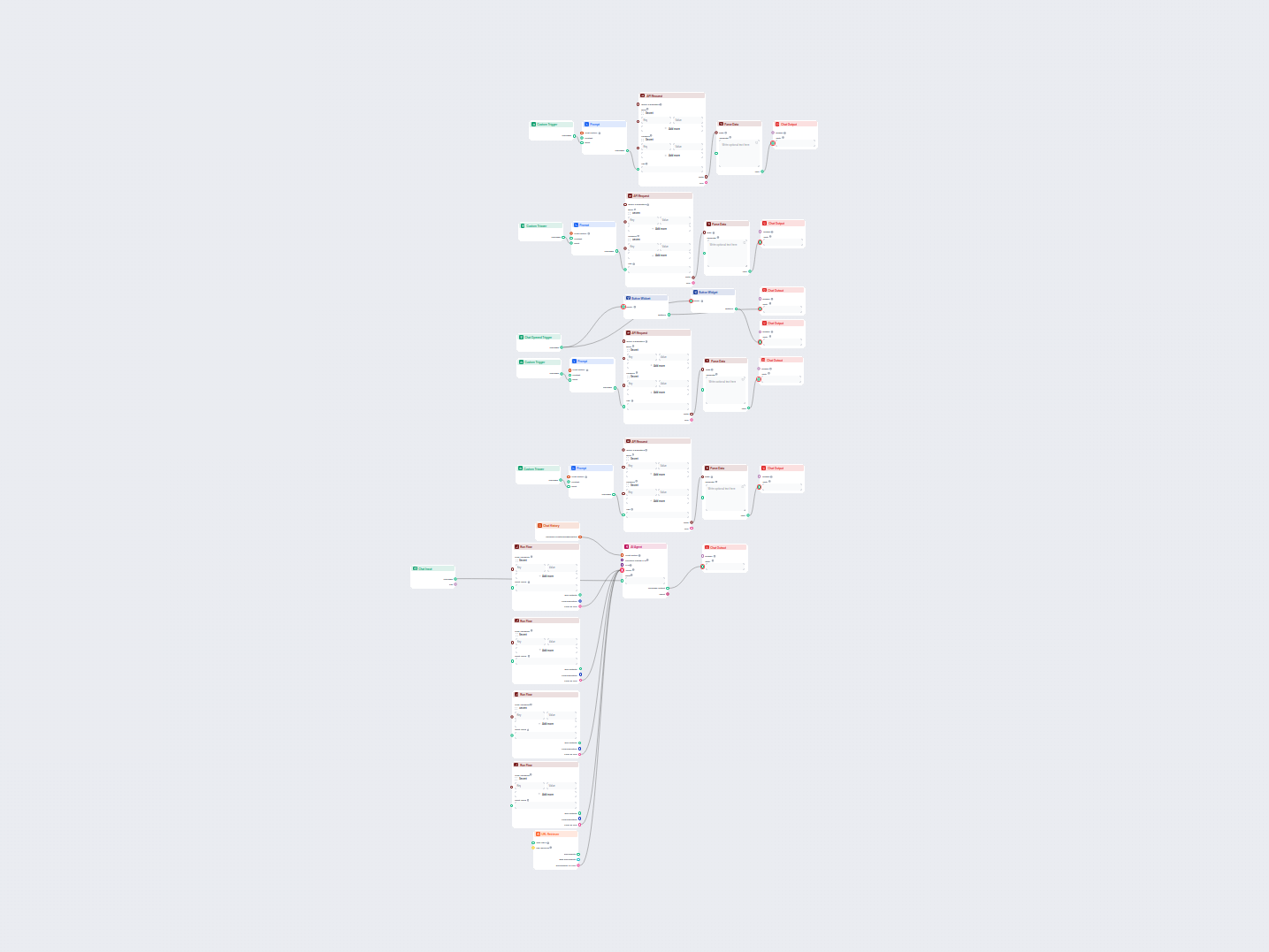

Ce flux de travail automatise le support client pour votre entreprise en intégrant les conversations LiveAgent, en extrayant les données pertinentes des convers...

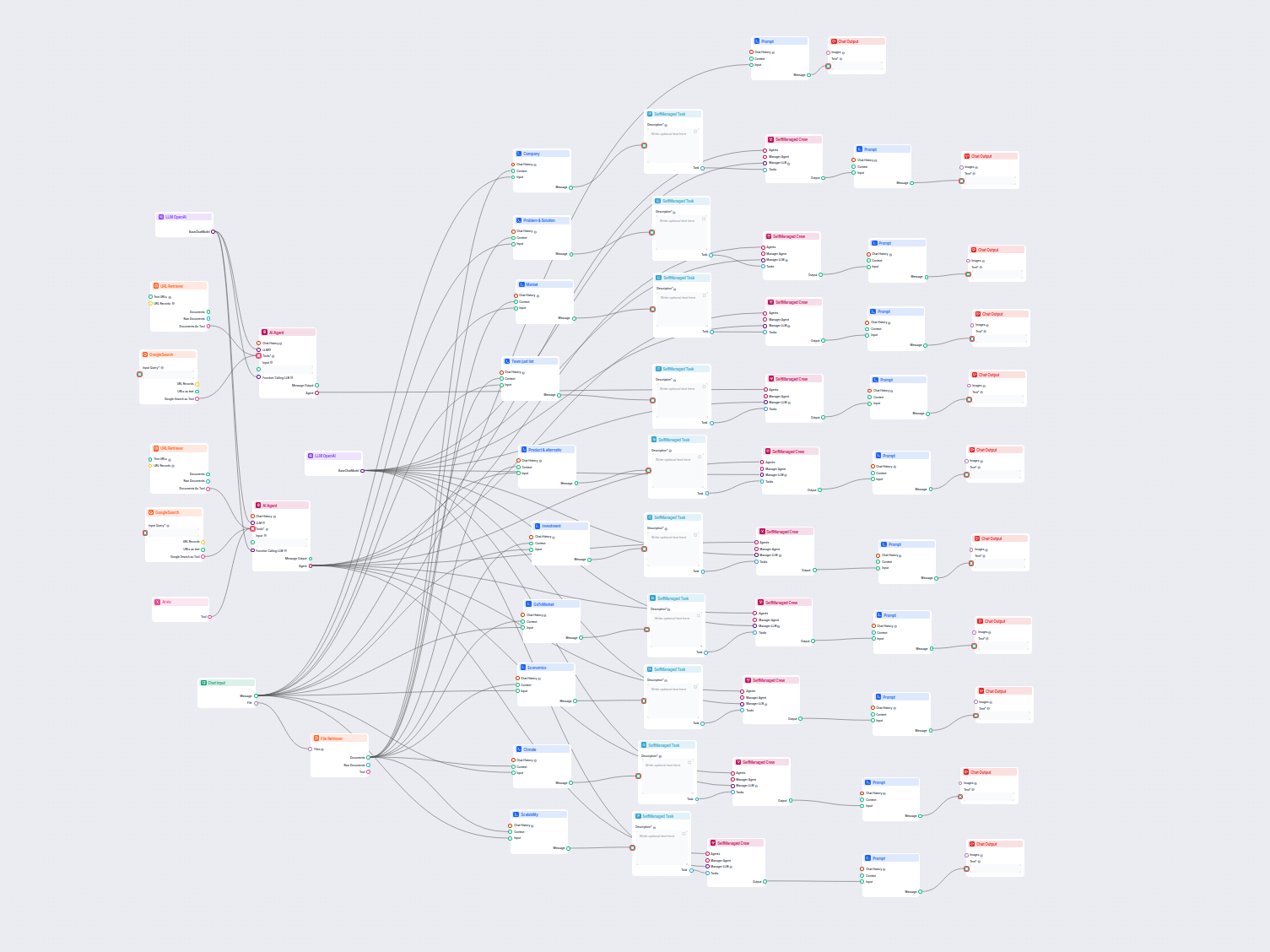

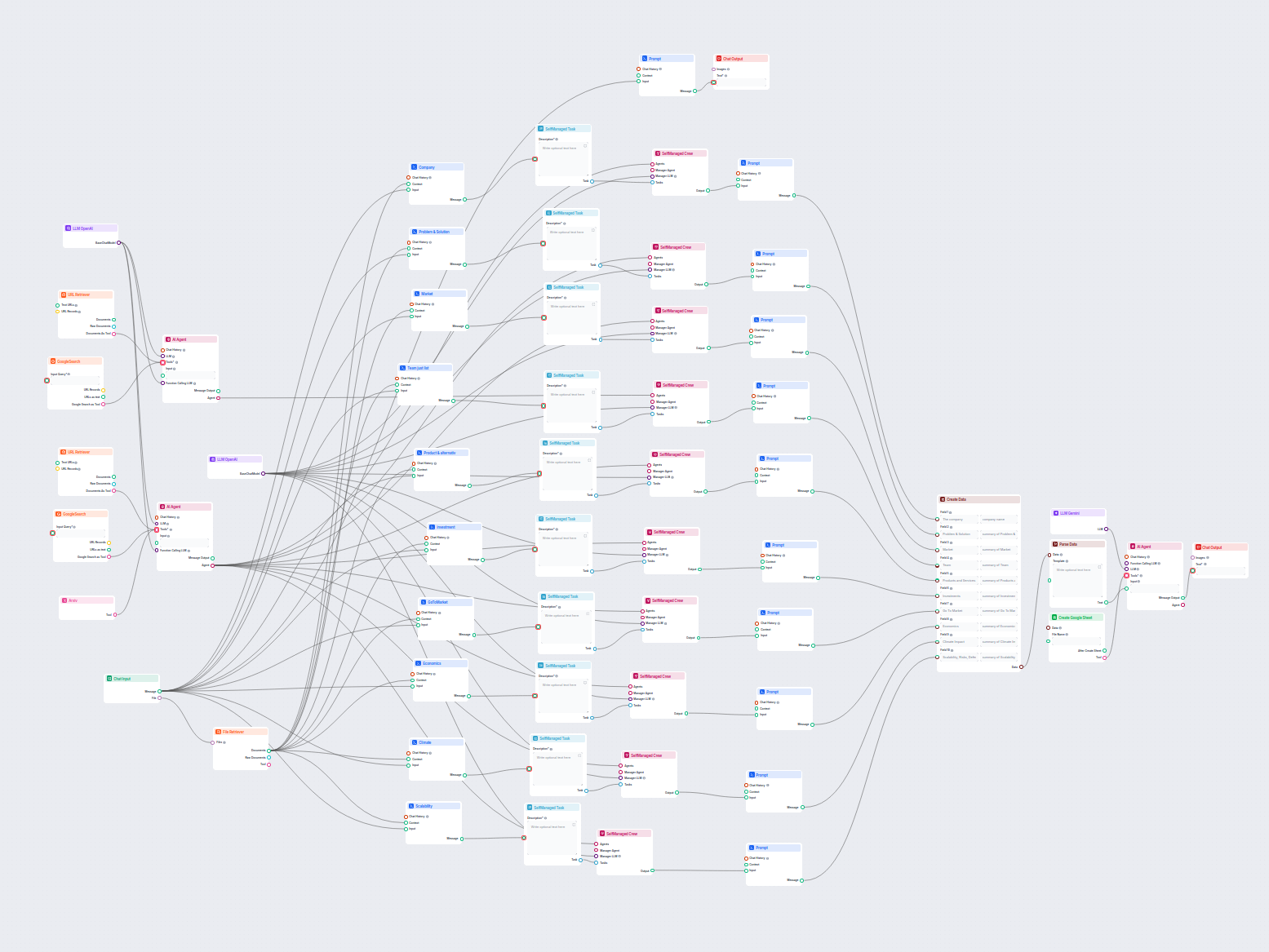

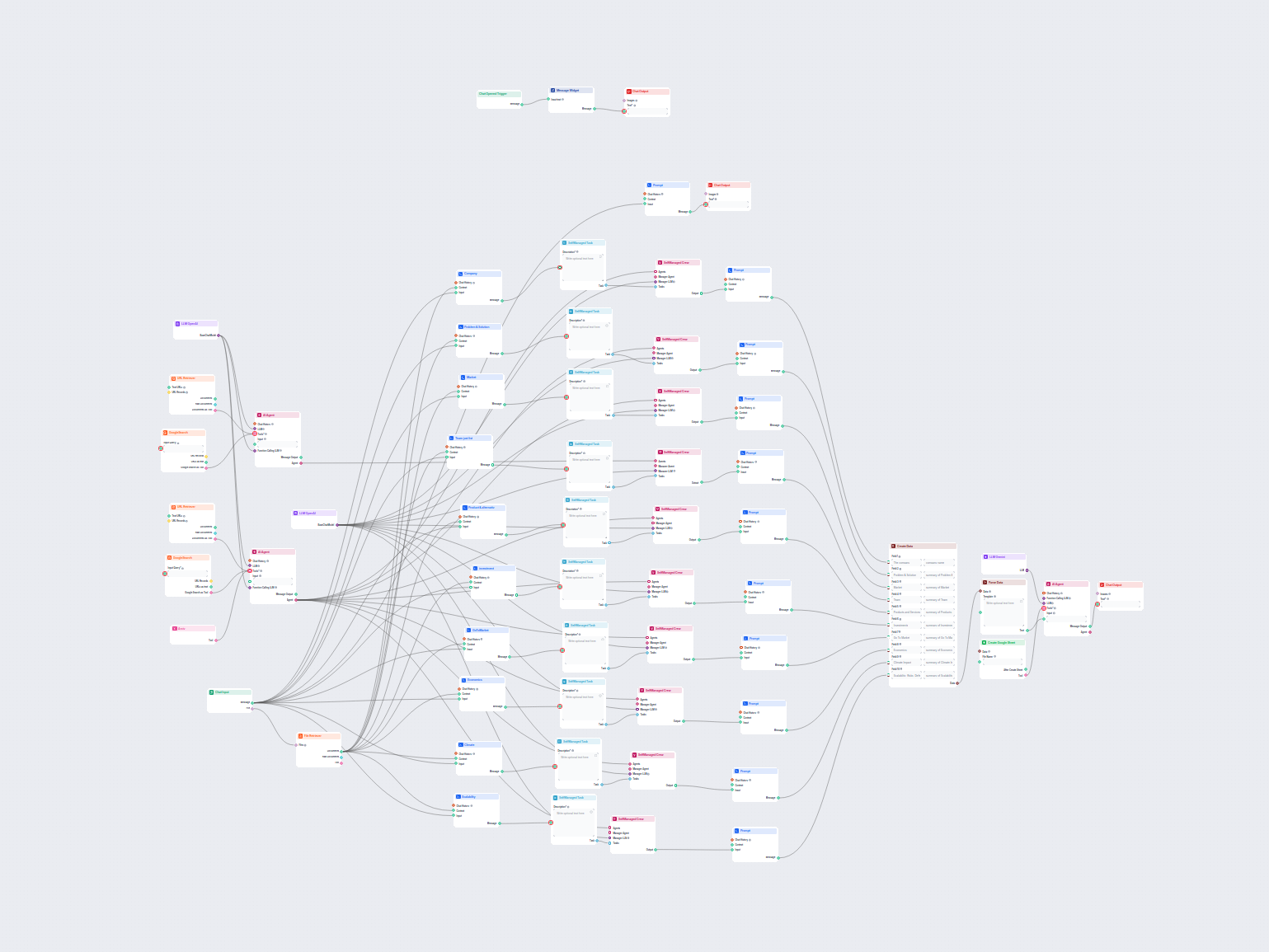

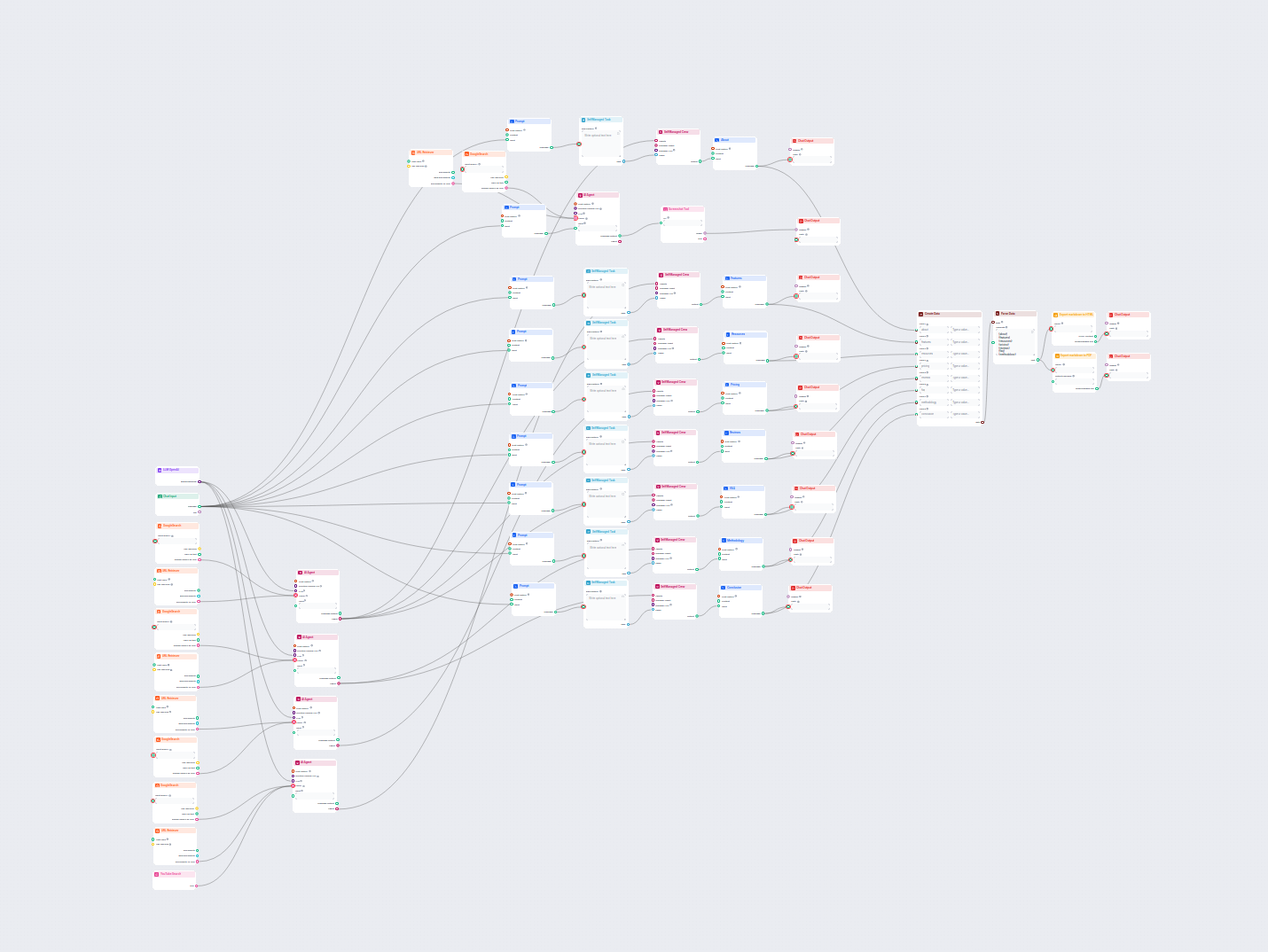

Flux de travail complet piloté par l'IA pour l'analyse d'entreprise et l'étude de marché. Rassemble et analyse automatiquement des données sur l'historique de l...

Ce workflow alimenté par l'IA fournit une analyse d'entreprise complète et fondée sur les données. Il rassemble des informations sur l'historique de l'entrepris...

Ce flux de travail IA analyse en profondeur toute entreprise en recherchant des données et documents publics, couvrant marché, équipe, produits, investissements...

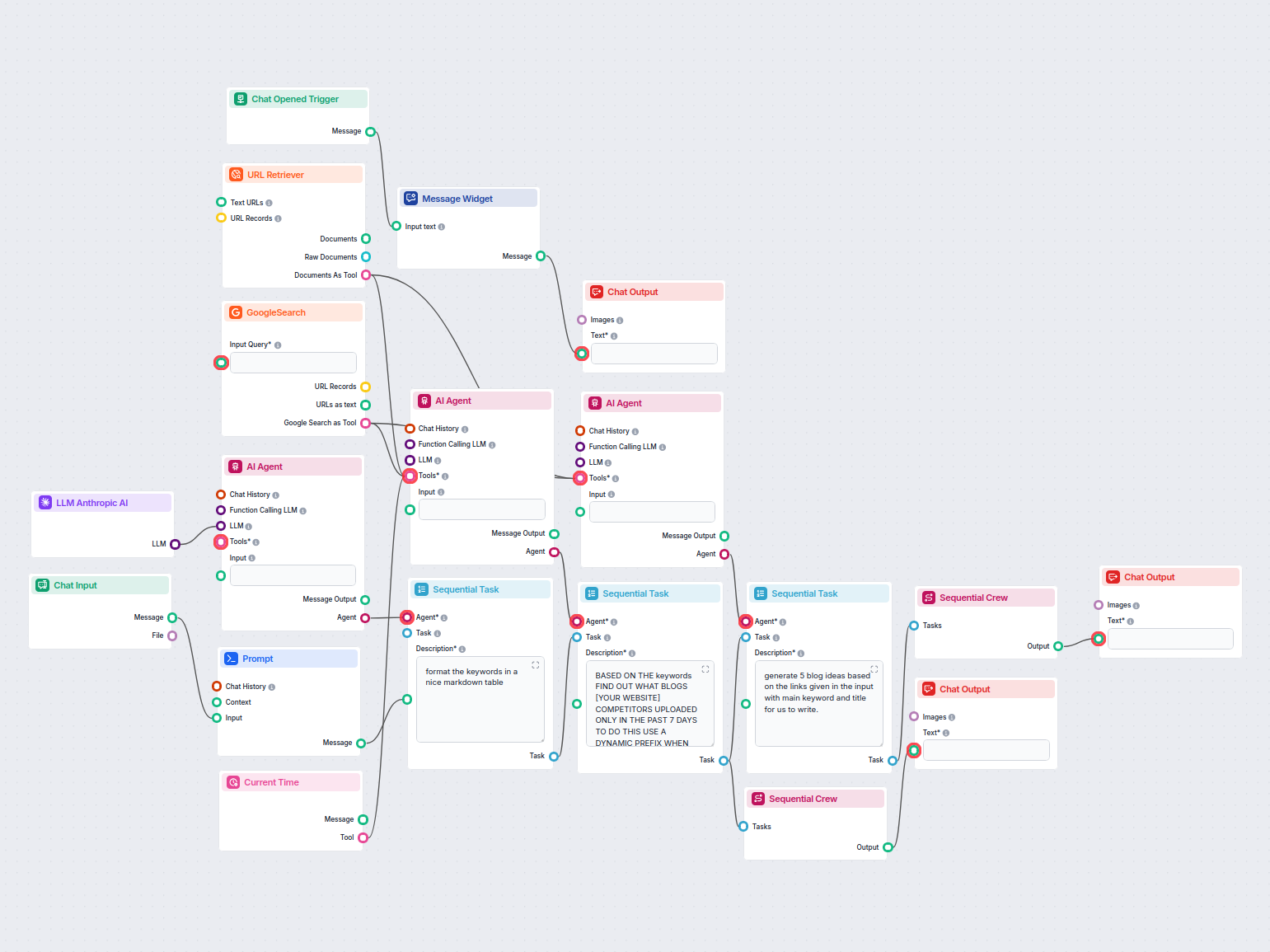

Analysez automatiquement les blogs concurrents les mieux classés de la semaine passée et générez de nouvelles idées d’articles pour votre site web. Ce flux de t...

Ce flux de travail alimenté par l'IA analyse la structure de contenu de votre page web, la compare avec les pages concurrentes les mieux classées et fournit des...

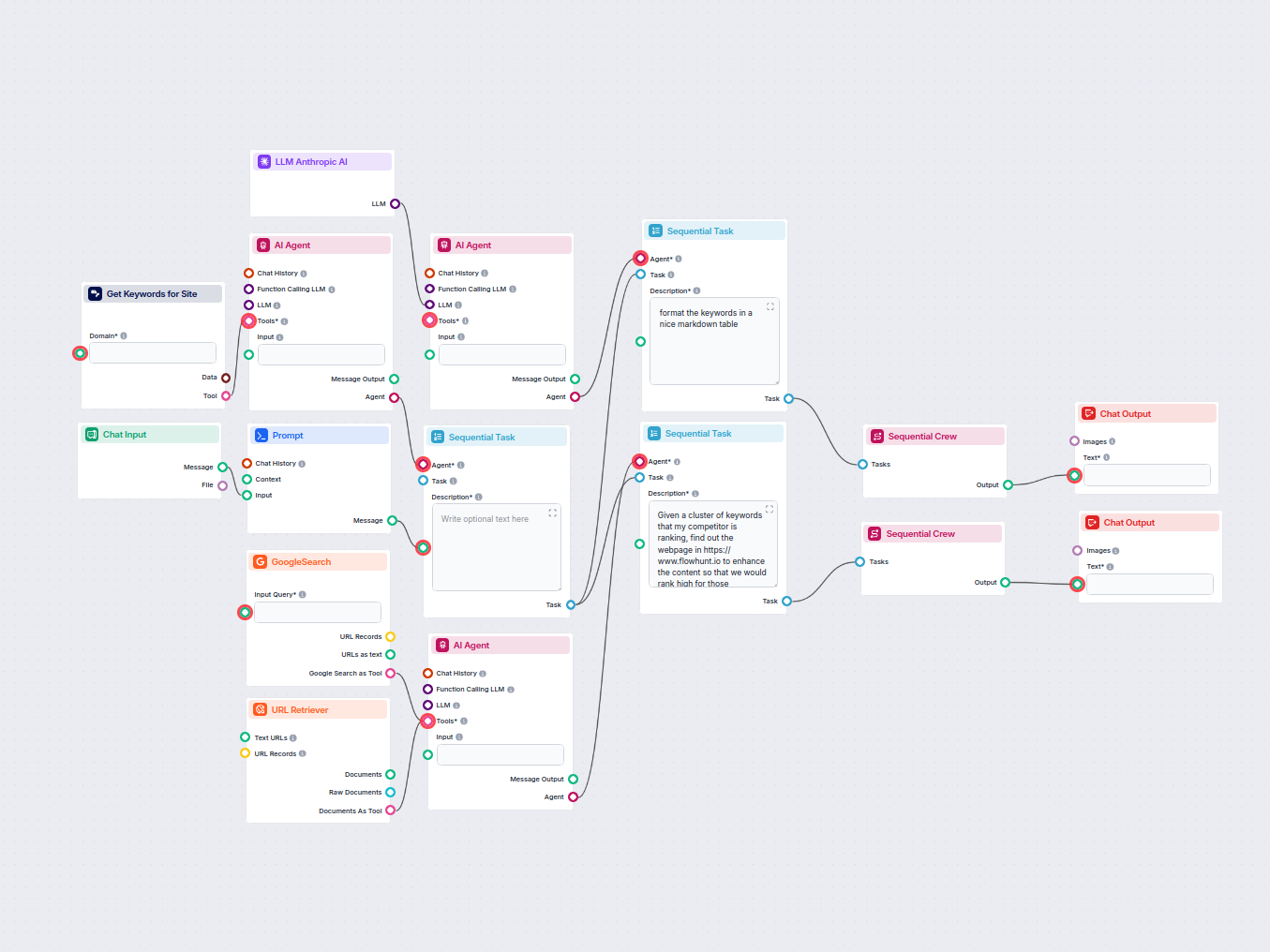

Analysez automatiquement l’URL de la page d’accueil de votre concurrent pour découvrir ses mots-clés les mieux classés, collectez les données de mots-clés depui...

Ce workflow analyse les résultats de recherche Google pour un mot-clé donné, en extrayant des informations sur l’intention de recherche, les stratégies des conc...

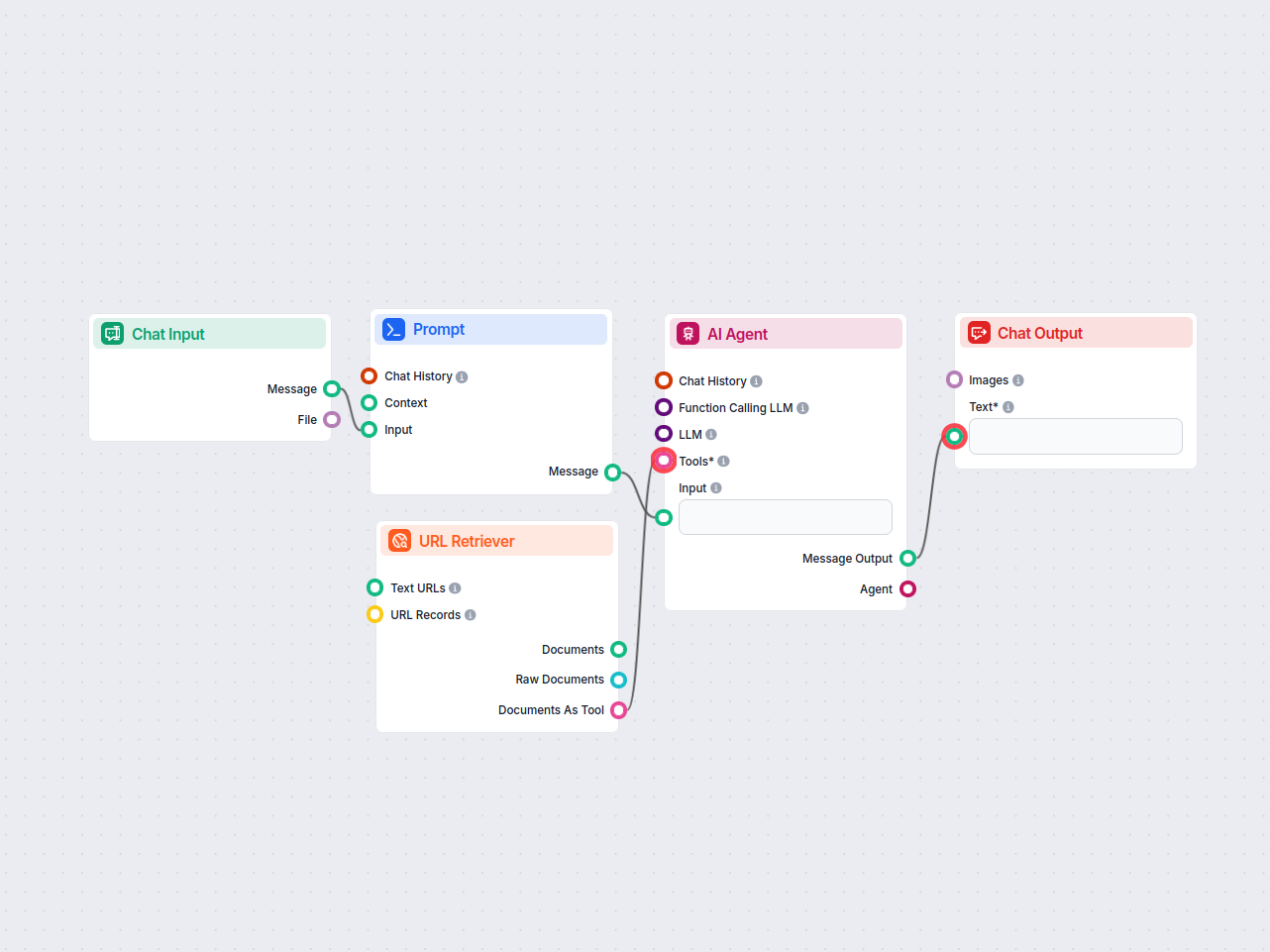

Assistant chatbot IA propulsé par OpenAI GPT-4o qui recherche automatiquement et exploite les documents internes de l'entreprise pour répondre aux questions des...

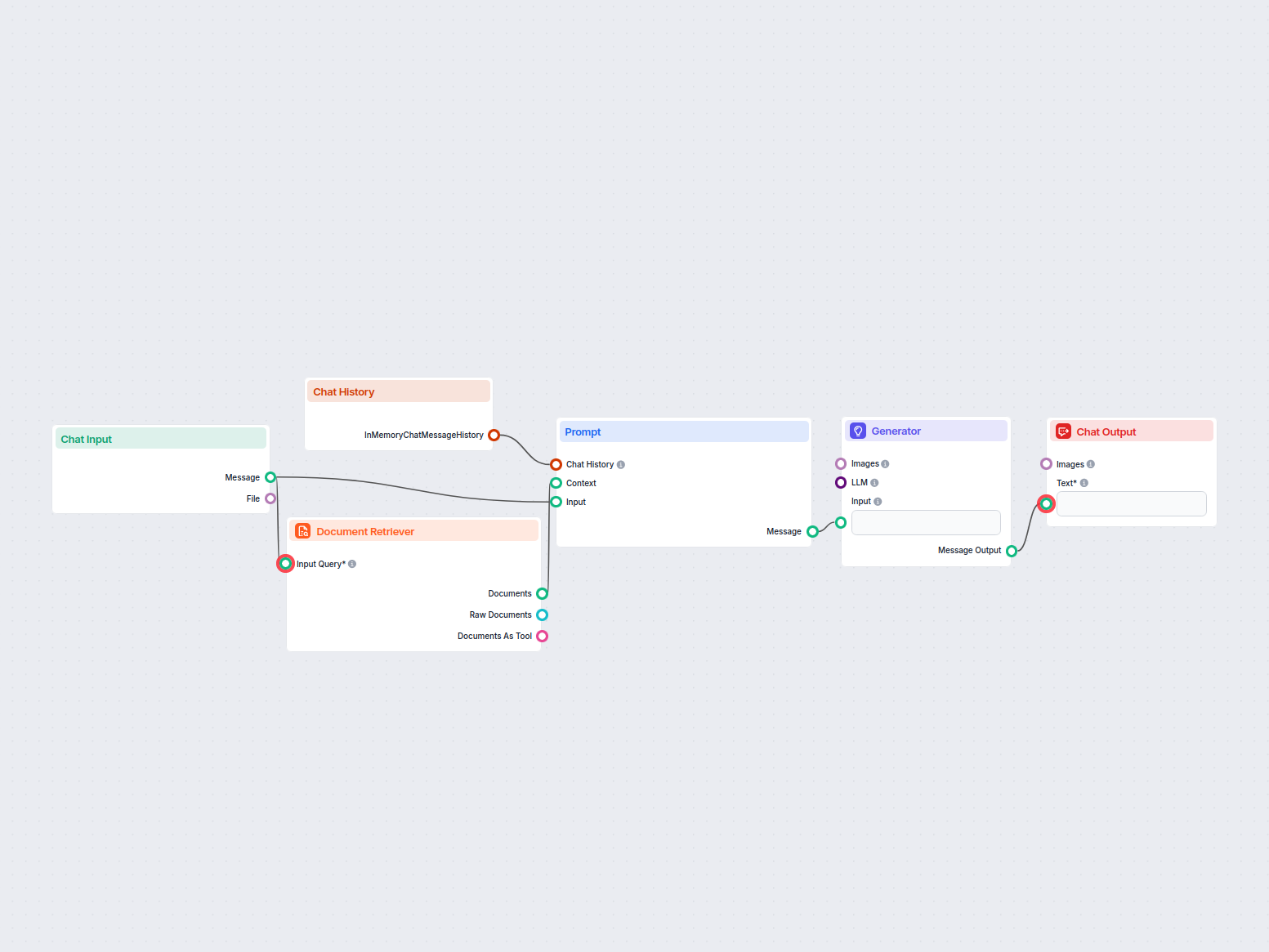

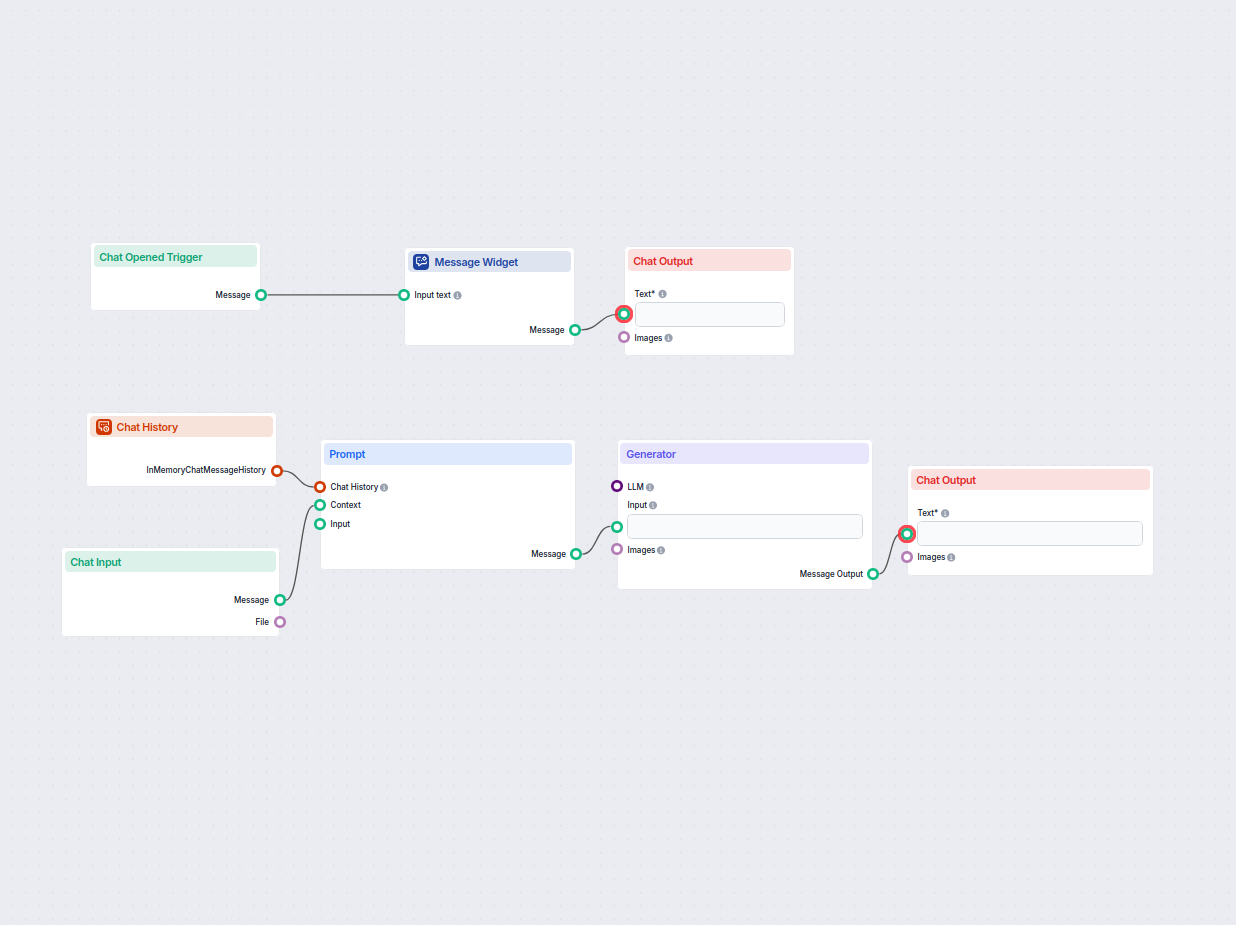

Un flux de travail simple pour un assistant de chat IA qui exploite l’historique des conversations précédentes afin de générer des réponses pertinentes aux entr...

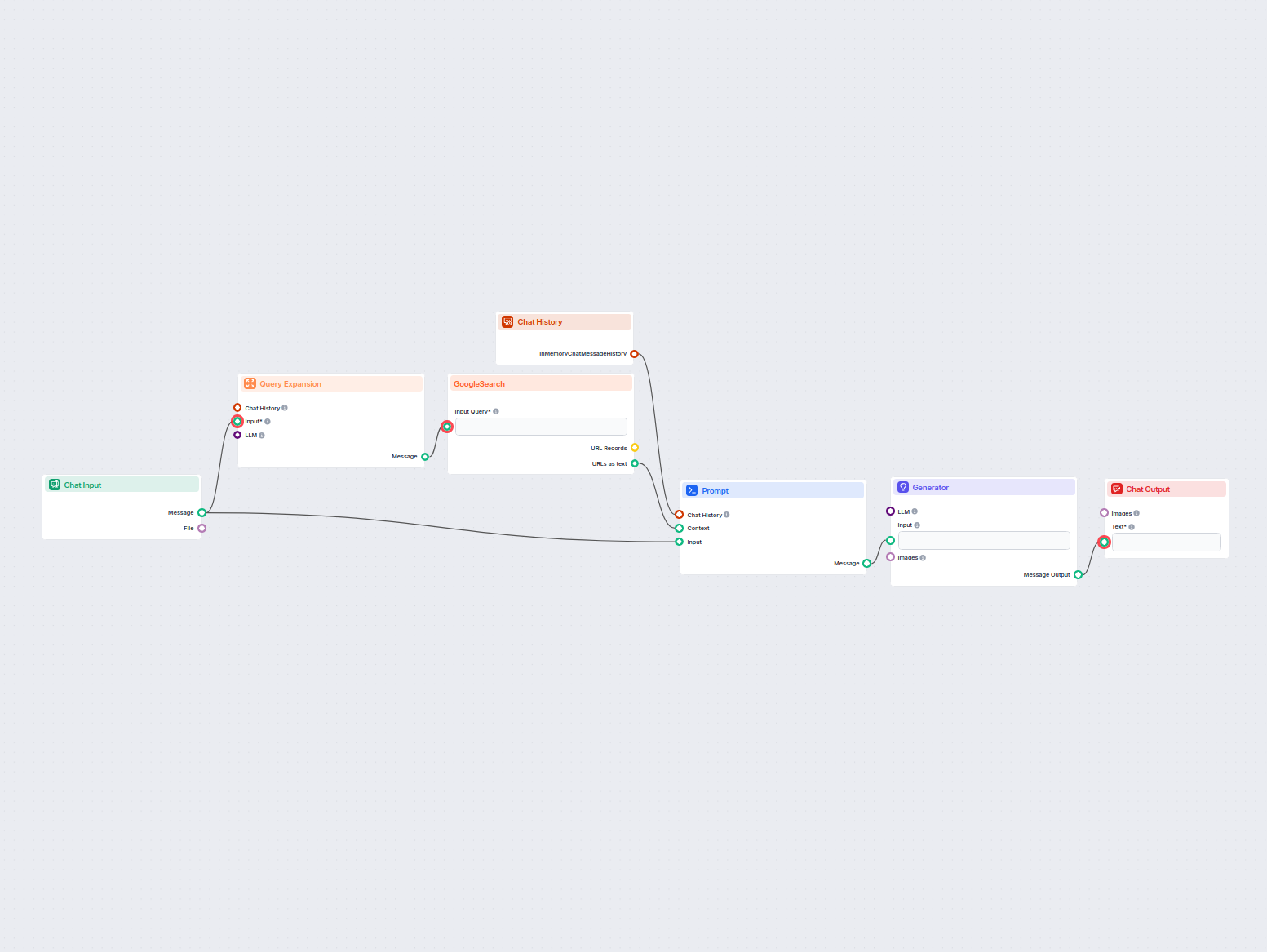

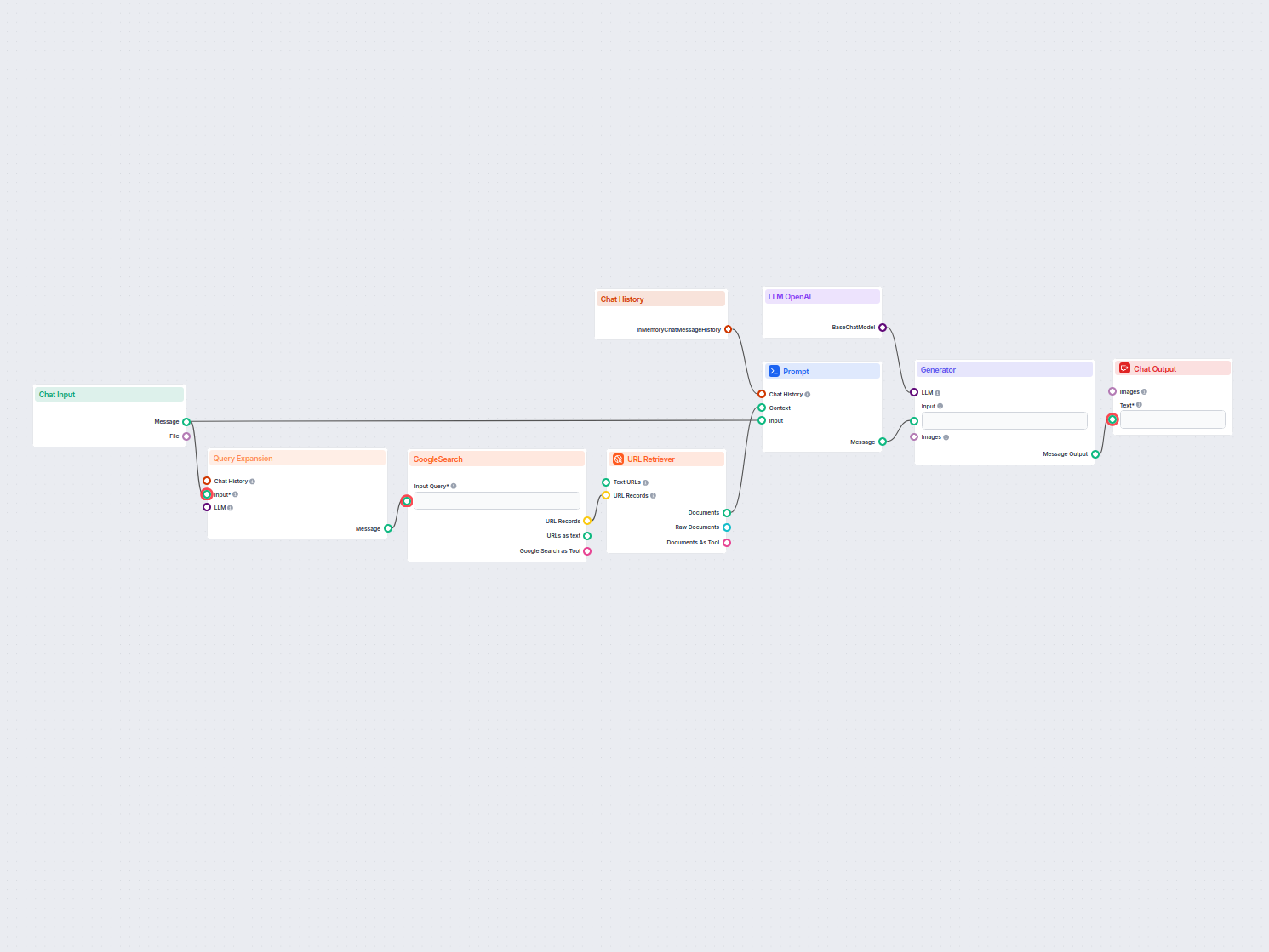

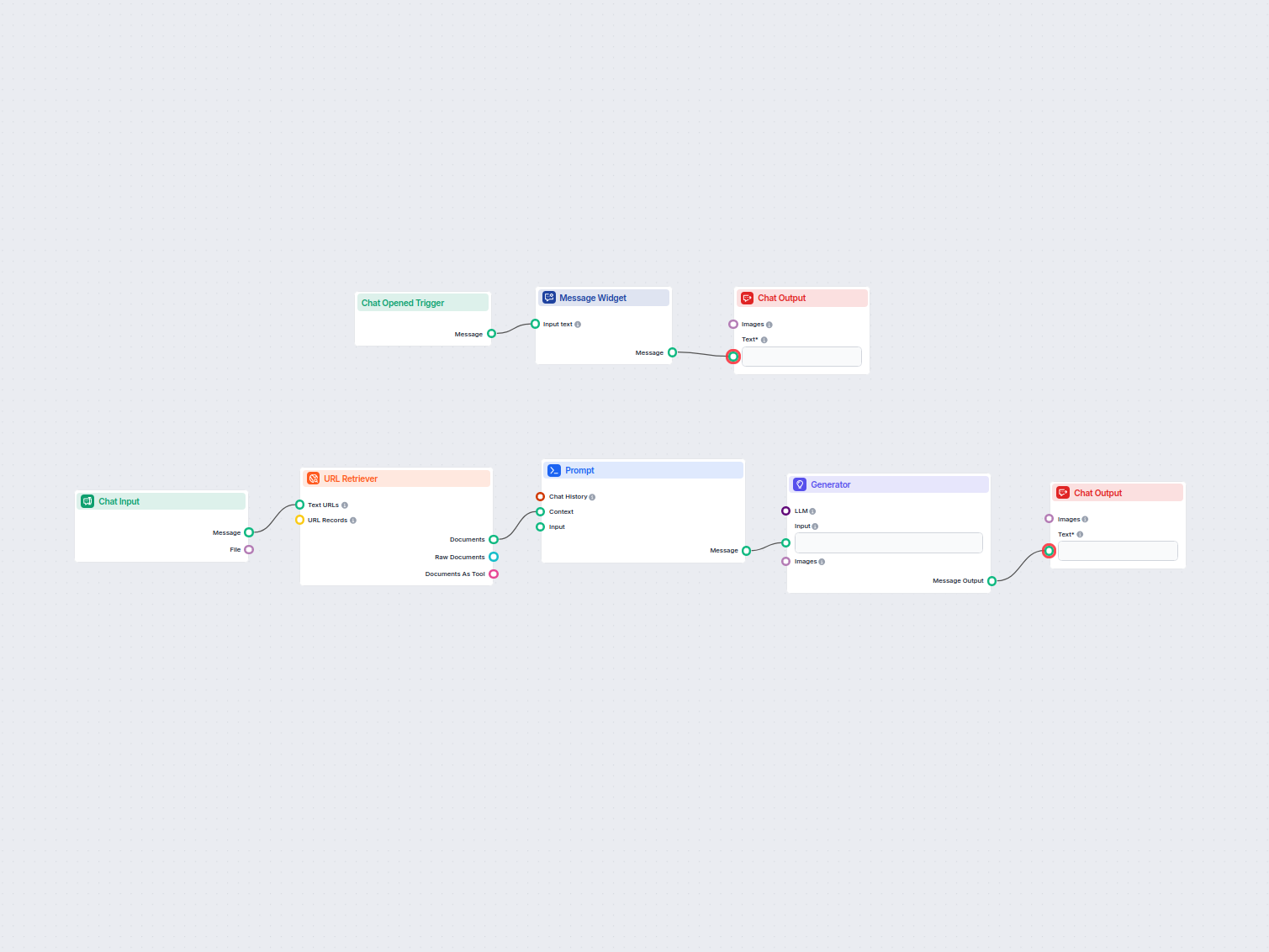

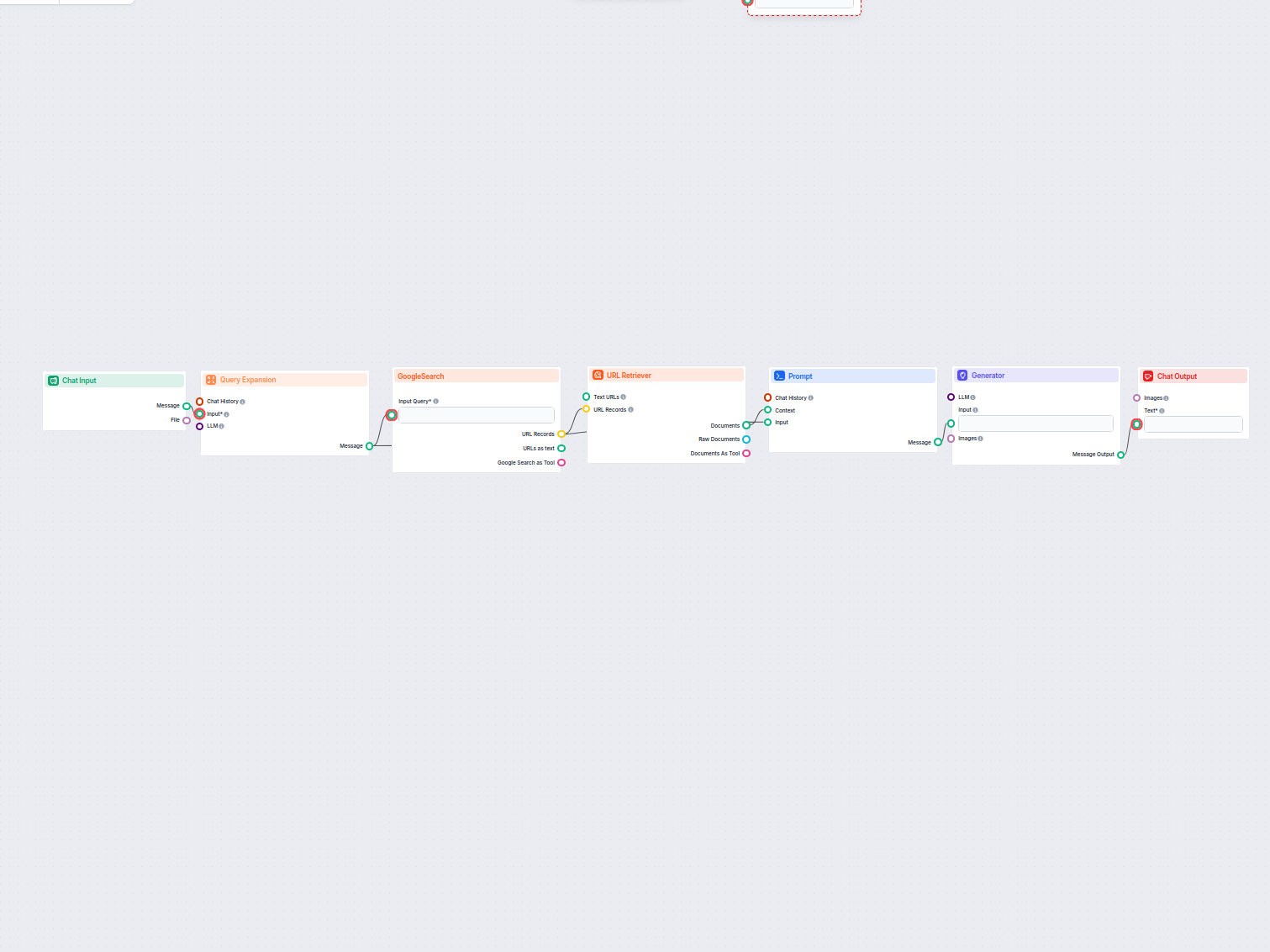

Un assistant IA qui répond aux questions des utilisateurs avec des informations factuelles et bien documentées, en utilisant l'approche RIG pour ancrer les répo...

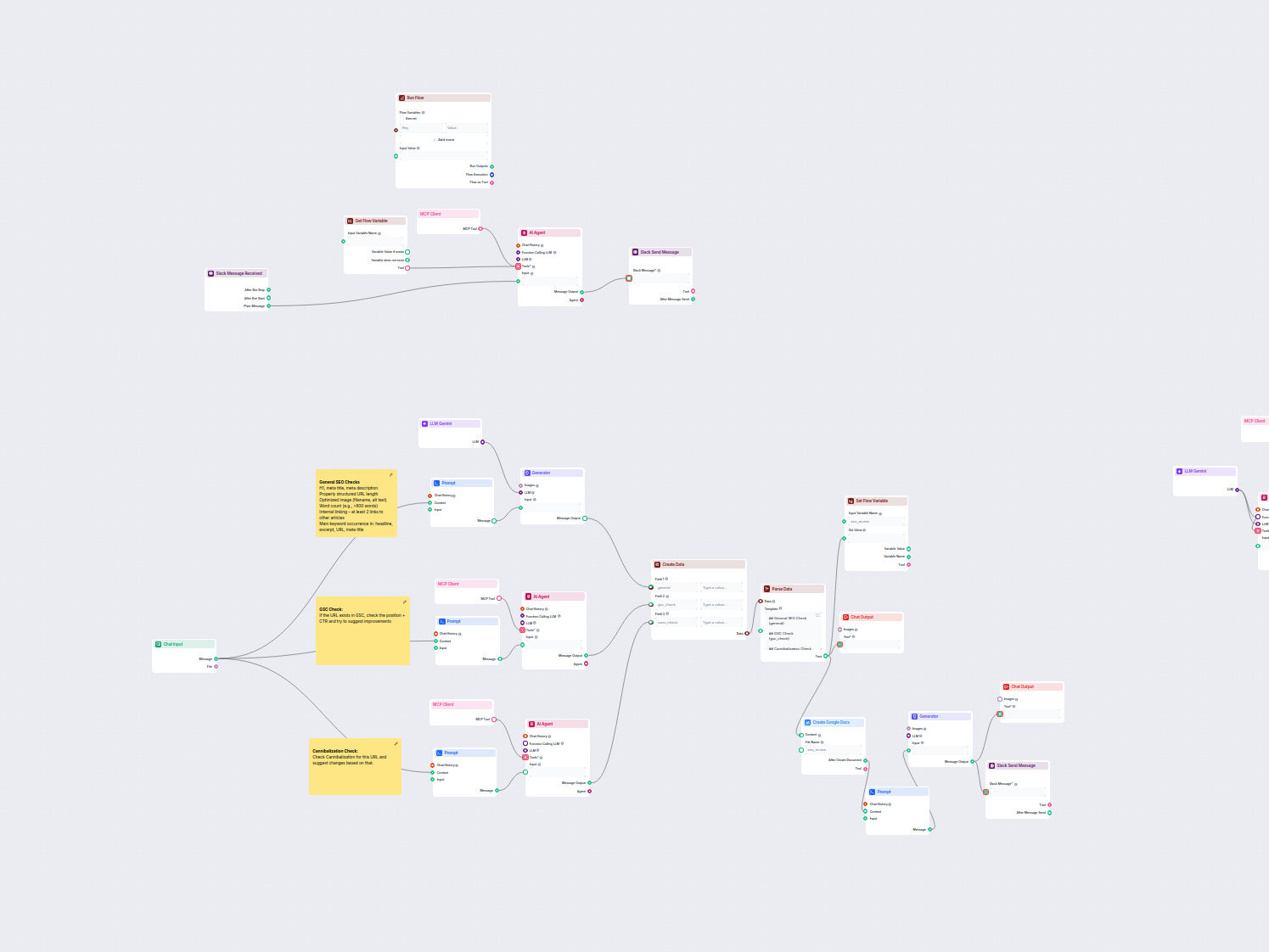

Ce flux de travail automatise le processus de revue et d'audit SEO des pages web. Il analyse le contenu des pages selon les meilleures pratiques SEO, réalise de...

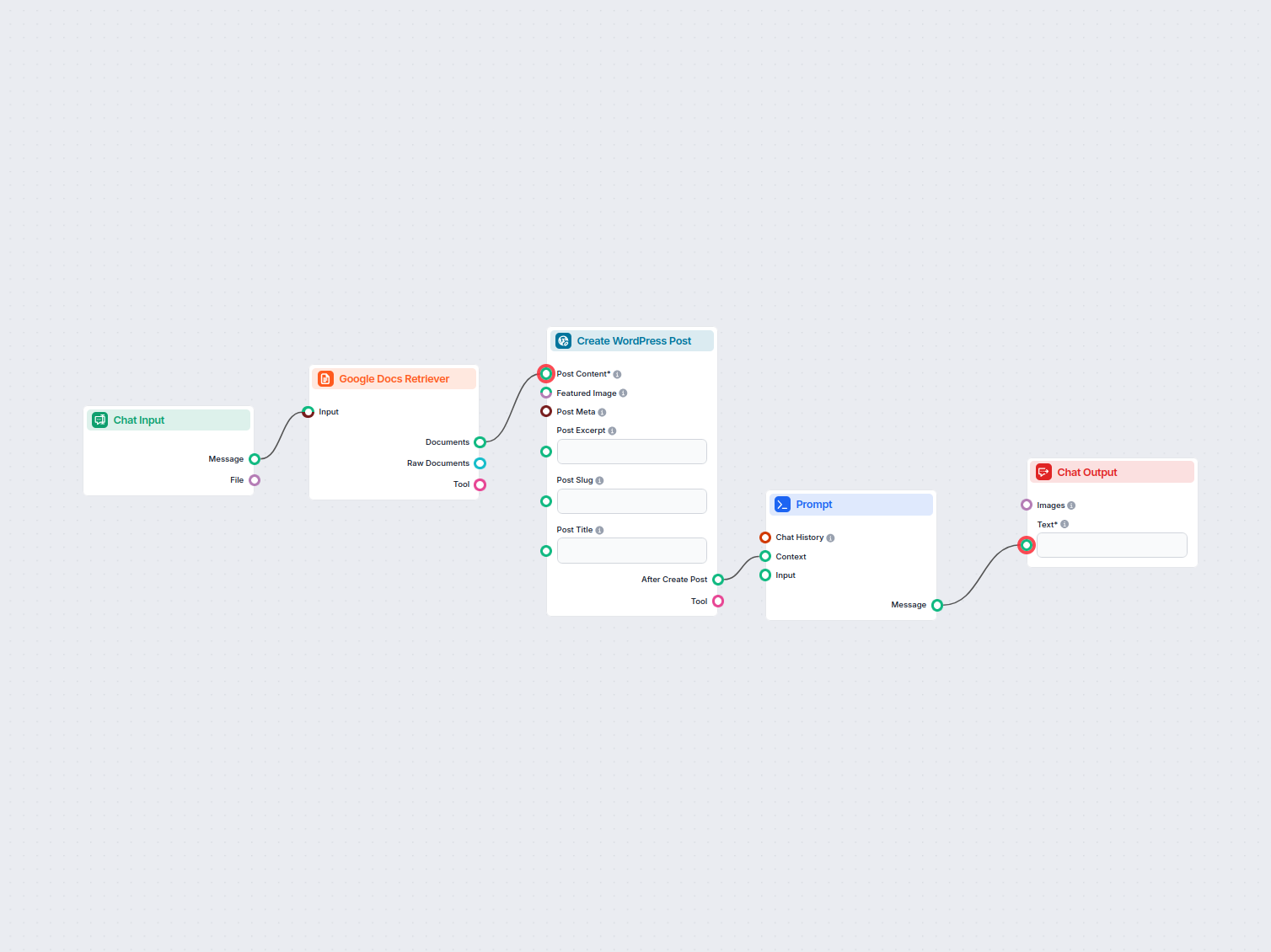

Transférez automatiquement le contenu de Google Docs vers votre site WordPress en tant que nouveaux articles, simplifiant ainsi la publication de contenu pour l...

Automatisez le traitement des factures en téléchargeant des images de factures et en extrayant les données clés, telles que le numéro de facture, le type, la la...

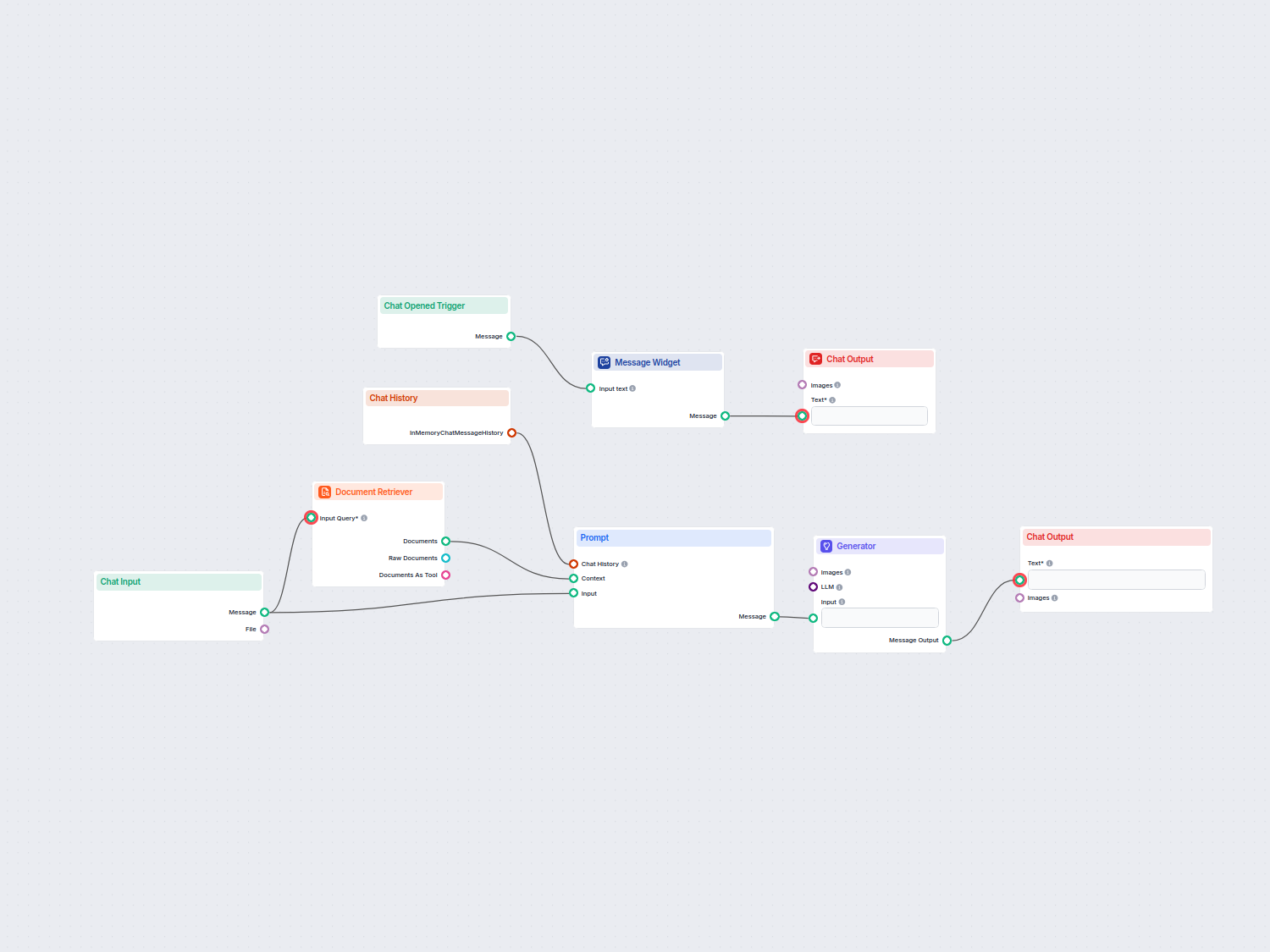

Un chatbot de service client alimenté par l'IA qui utilise vos sources de connaissances internes pour fournir des réponses instantanées, précises et utiles aux ...

Déployez un chatbot de support client intelligent pour LiveAgent qui répond automatiquement aux questions des visiteurs, récupère des documents de la base de co...

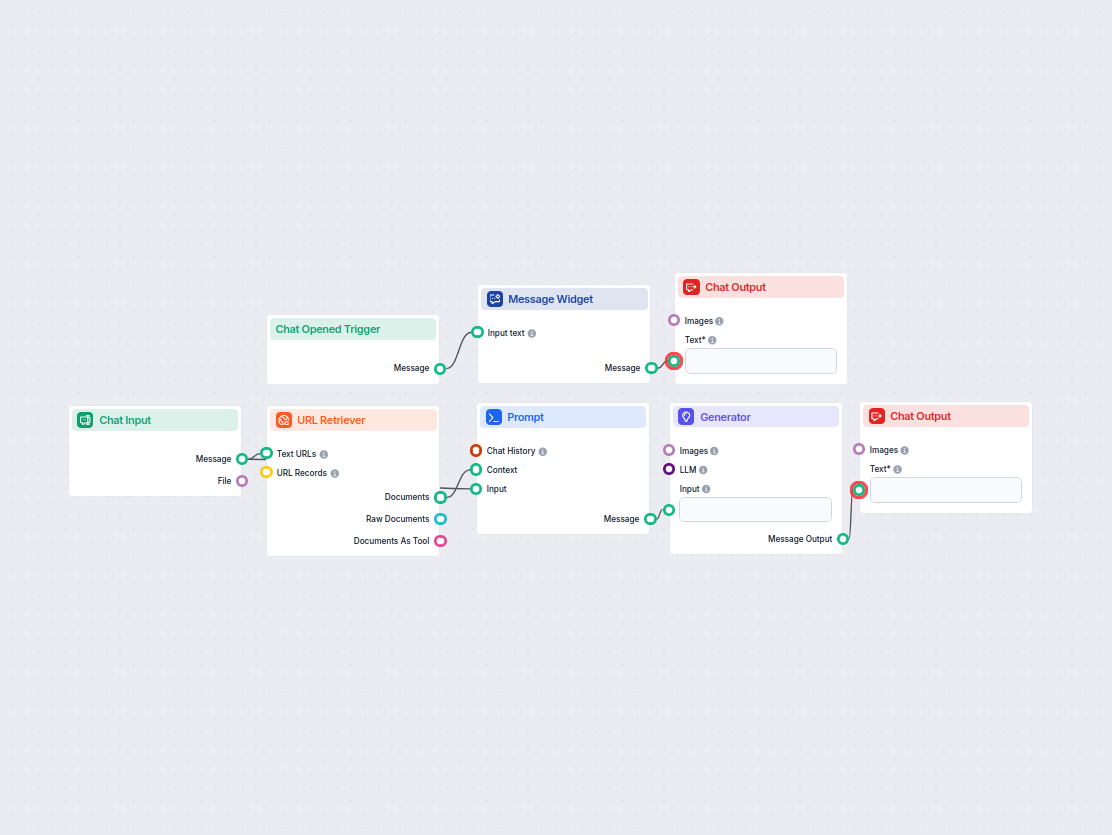

Un chatbot en temps réel qui utilise la recherche Google restreinte à votre propre domaine, récupère le contenu web pertinent et exploite OpenAI LLM pour répond...

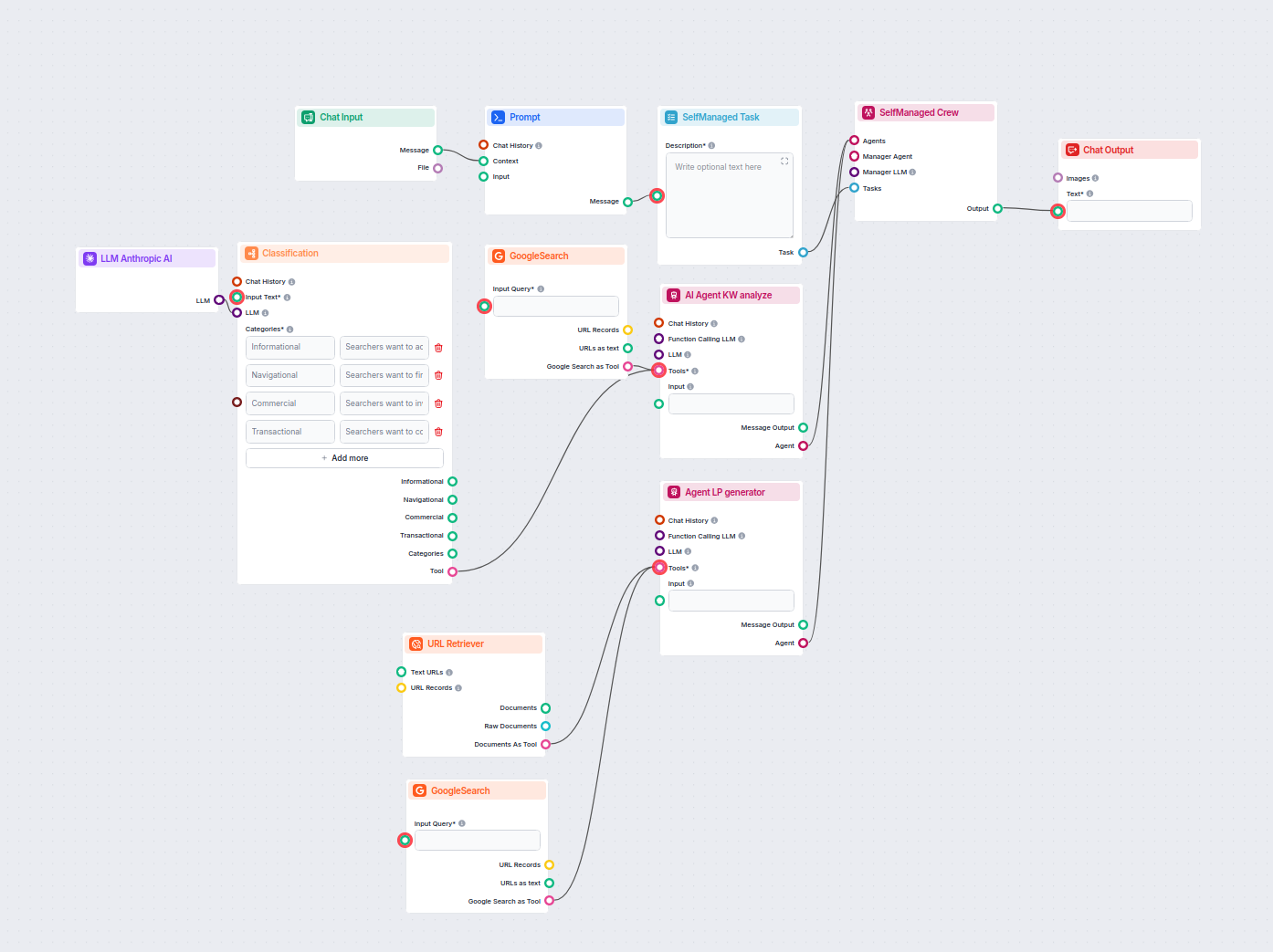

Ce workflow alimenté par l’IA classe les requêtes de recherche selon leur intention, recherche les URLs les mieux positionnées, et génère une page d’atterrissag...

Transformez la documentation technique d'une URL en un article captivant et optimisé SEO pour votre site web. Ce flux analyse le contenu des concurrents les mie...

Générez sans effort des tableaux markdown entièrement formatés à partir de vos données, idéal pour la documentation, les présentations et la prise de notes. Ce ...

Un workflow automatisé propulsé par l’IA pour récupérer, résumer et présenter les meilleures actualités de Hacker News, incluant les détails, les URL et les mei...

Ce workflow piloté par l'IA enrichit les données de leads dans Google Sheets en récupérant automatiquement les profils LinkedIn manquants, les intitulés de post...

Ce flux de travail enrichit automatiquement les données de contacts dans Google Sheets en trouvant les profils LinkedIn, en extrayant les intitulés de poste et ...

Ce workflow extrait et organise les informations clés provenant d'e-mails et de fichiers joints, utilise l'IA pour traiter et structurer les données, puis expor...

Résumez facilement n'importe quel texte en points clés concis grâce à l'IA. Ce flux de travail prend la saisie de l'utilisateur, génère un résumé court et le pr...

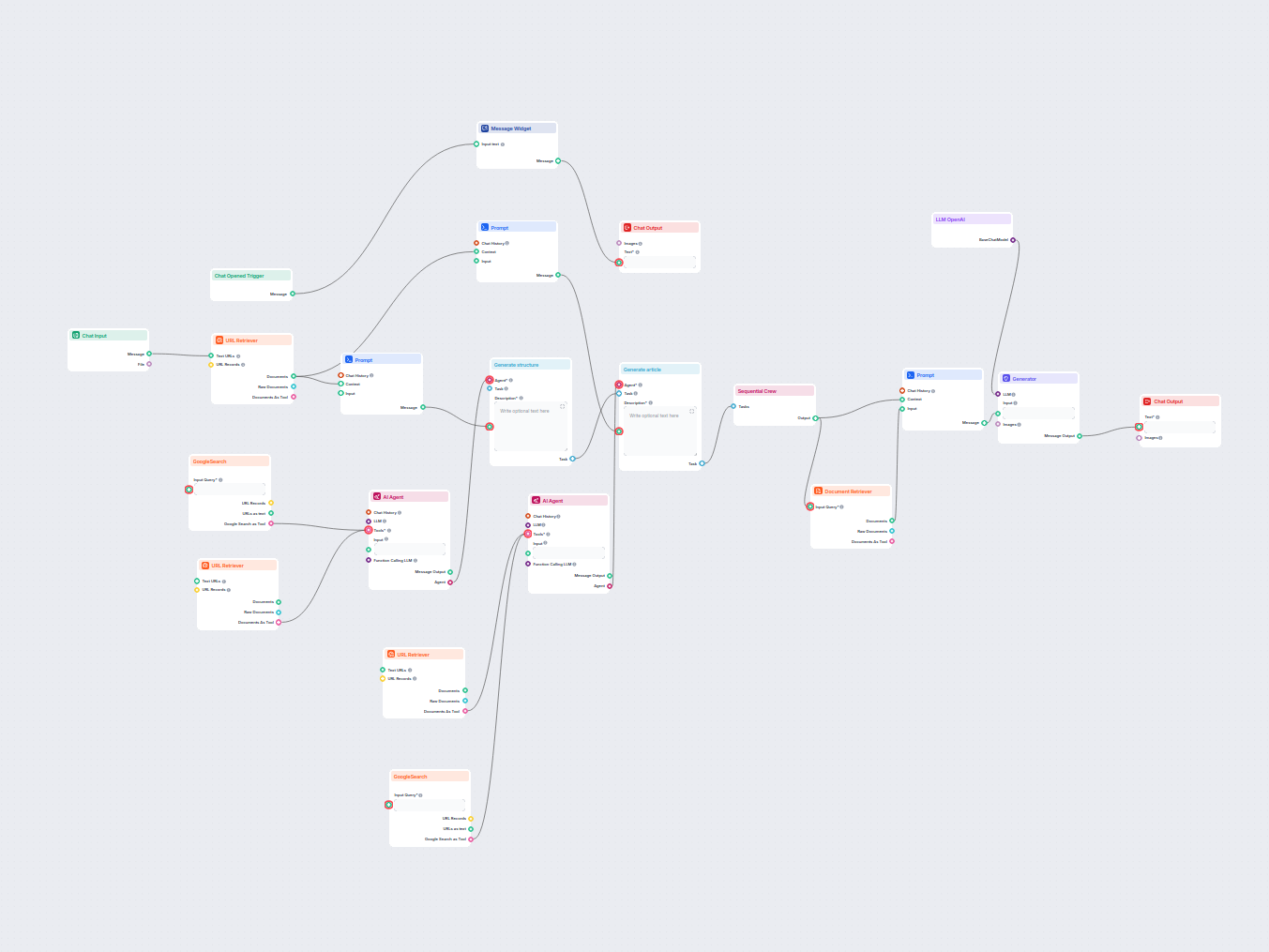

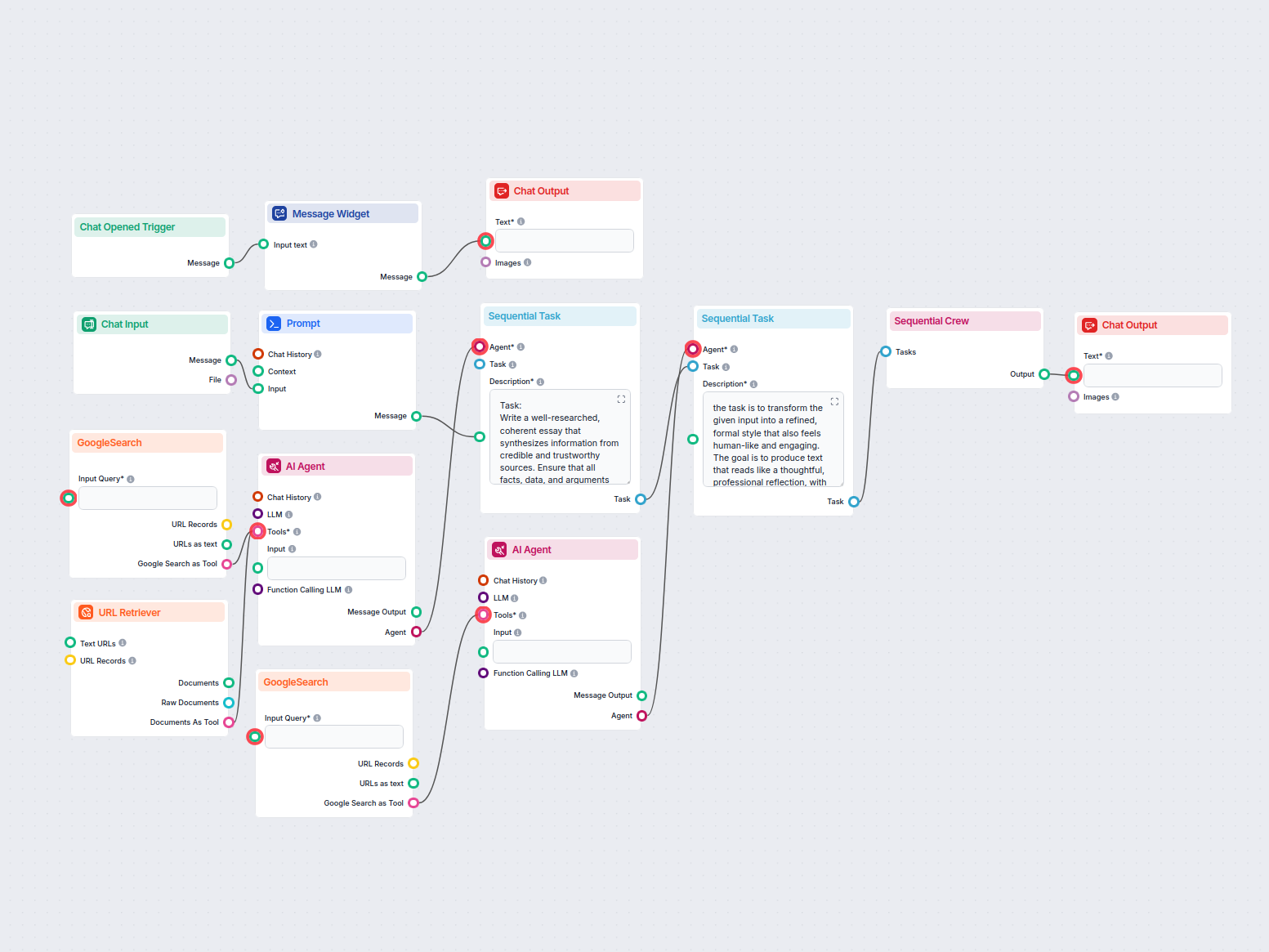

Générez des articles de blog complets, optimisés pour le SEO, avec une structure avancée et un nombre de mots élevé grâce à plusieurs agents IA. Le workflow inc...

Créez automatiquement des accroches LinkedIn engageantes et professionnelles grâce à l'IA. Fournissez simplement une brève description de votre expérience, et c...

Générez des analyses complètes de produits à l'aide d'agents IA qui collectent et résument des informations sur les produits, les prix, les fonctionnalités, les...

Générez automatiquement plusieurs variantes d'annonces Google Ads pour n'importe quelle URL. Collez le lien de votre site web et recevez des titres et descripti...

Générez des articles de glossaire approfondis et optimisés pour le SEO grâce à l’IA et à la recherche web en temps réel. Ce flux analyse les contenus les mieux ...

Générez des articles de revue de produits logiciels complets et optimisés SEO, incluant des descriptions détaillées des fonctionnalités, tarifs, avis d'utilisat...

Générez instantanément des e-mails structurés et clairs, adaptés à votre ton et à votre intention, avec une ligne d'objet suggérée grâce à l'IA. Parfait pour le...

Génère automatiquement des essais factuels et bien structurés au format MLA en utilisant des sources crédibles trouvées via la recherche Google. Idéal pour les ...

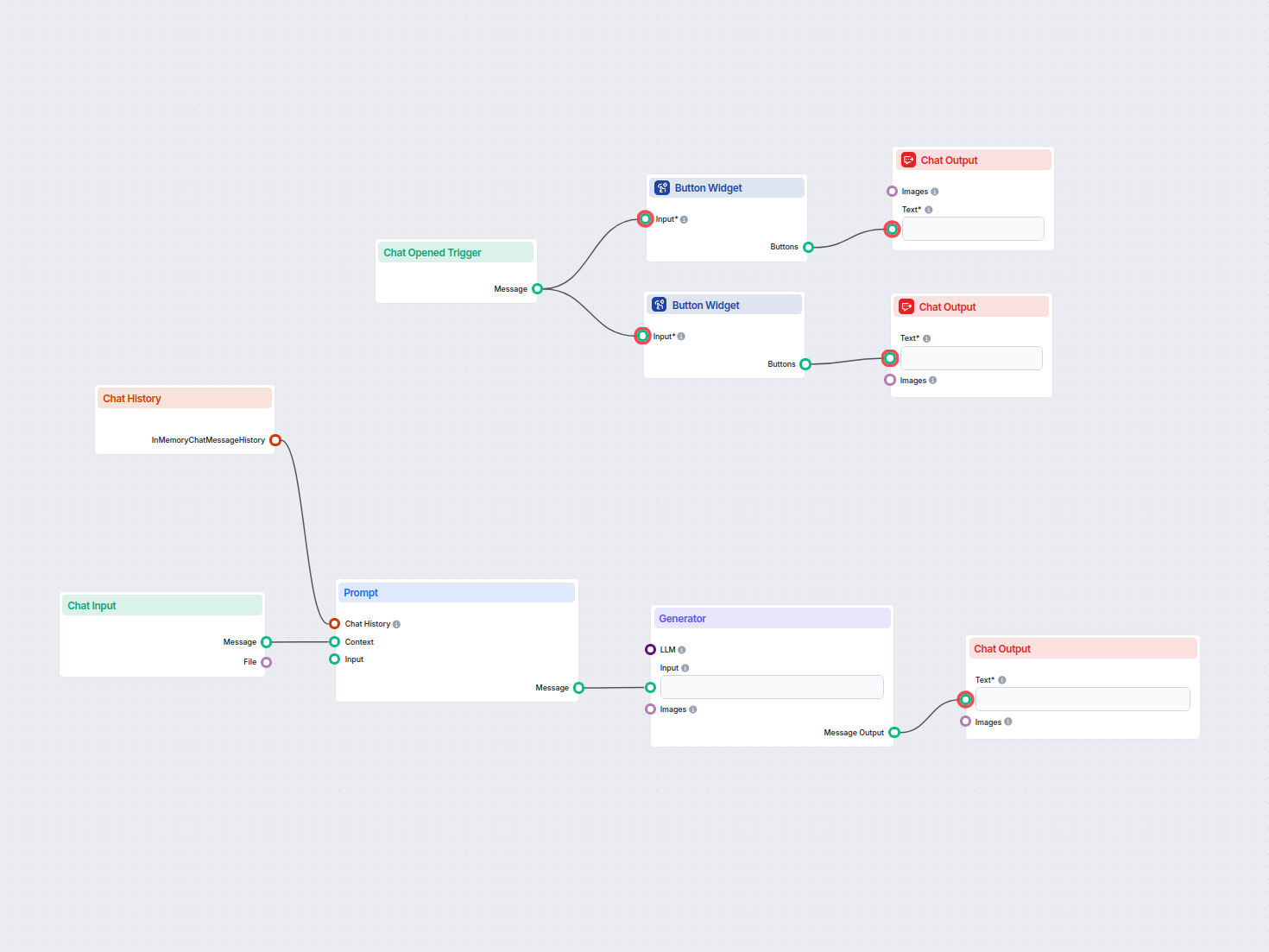

Générez des idées d'entreprise innovantes adaptées aux saisies des utilisateurs ou à des industries sélectionnées grâce à l'IA. Ce flux interactif propose des s...

Transformez sans effort le contenu de vos PDF ou de vos présentations en idées de blogs structurées et performantes grâce à l'IA. Téléchargez votre document et ...

Générez des idées de contenu uniques et des résumés à l'aide de l'IA en recherchant les meilleurs résultats Google pour n'importe quel mot-clé. Idéal pour les m...

Générez une entrée de bibliographie au format LaTeX pour tout article académique en fournissant simplement son URL. Ce workflow automatise l'extraction des déta...

Générez des blogs détaillés et optimisés pour le SEO avec l'aide d'agents IA. Le flux effectue des recherches sur les meilleurs résultats Google, crée un brief ...

Générez automatiquement des articles de blog SEO performants à partir de vidéos YouTube. Ce workflow extrait les transcriptions vidéo, analyse les meilleurs mot...

Générez des rapports complets et pilotés par l’IA sur les cas d’utilisation d’un produit logiciel pour le marketing et la vente. Ce workflow recherche le produi...

Transformez vos pièces jointes de réunion en synthèses exploitables, emails de suivi et articles de blog grâce à l’IA. Ce flux de travail automatise la création...

Génère automatiquement des comptes rendus de réunion exploitables et des e-mails de suivi à partir de vos pièces jointes de réunion à l'aide de l'IA, et exporte...

Générez du contenu de page web bien structuré basé sur l'analyse des pages Google les mieux classées pour n'importe quel mot-clé. Ce flux automatise la recherch...

Rédige automatiquement une déclaration de mission personnalisée en fonction des informations fournies par l'utilisateur et du contexte de la discussion. Idéal p...

Générez automatiquement des titres, descriptions et hashtags YouTube optimisés pour le SEO à partir de n’importe quelle URL de page web. Parfait pour les market...

Génère automatiquement des données structurées Schema.org au format JSON pour n'importe quelle URL de site web, facilitant ainsi la compréhension et l'indexatio...

Ce flux de travail alimenté par l'IA génère des réponses FAQ concises et de haute qualité pour toute question donnée en recherchant sur le web, en extrayant le ...

Ce flux de travail alimenté par l’IA aide les professionnels de la vente à préparer leurs réunions en générant une fiche de préparation complète. En fournissant...

Générez instantanément des formules Google Sheets à partir de demandes en langage naturel. Ce flux de travail alimenté par l’IA aide les utilisateurs à créer de...

Générez facilement des lettres formelles, informelles ou juridiques adaptées à vos besoins. Ce workflow alimenté par l'IA prend vos indications et crée un broui...

Générez facilement des idées de noms d'entreprise créatifs et pertinents grâce à l'IA. Les utilisateurs fournissent une brève description de leur entreprise et ...

Génère automatiquement un court paragraphe attrayant pour votre site web, incluant des liens vers les articles connexes les plus pertinents. Ce flux de travail ...

Générez facilement des plans d'affaires complets grâce à l'IA. Ce workflow collecte les informations de l'utilisateur, utilise l'historique du chat pour le cont...

Générez un plan de contenu optimisé pour le SEO en analysant les premiers résultats de recherche Google pour un mot-clé donné. Ce flux de travail utilise l'IA e...

Créez facilement un texte de post LinkedIn attrayant à partir de n'importe quelle URL de page web. Ce flux de travail automatisé extrait le contenu de votre sit...

Transformez n'importe quelle vidéo YouTube en une présentation Google Slides professionnelle en quelques minutes. Ce workflow alimenté par l'IA extrait le conte...

Transformez n'importe quel article ou page web en un prompt créatif et détaillé pour les modèles texte-vers-image. Ce workflow récupère le contenu d'une URL, l'...

Générez des prompts d'image IA de haute qualité en utilisant les meilleures pratiques. Ce flux de travail prend les informations de l'utilisateur, les formate e...

Affichage 1 à 60 de 79 résultats

Le composant Prompt donne des instructions et du contexte au bot, garantissant qu'il répond de la façon souhaitée.

L'inclure pour de nombreux cas d'usage est une excellente idée, mais le composant est optionnel.

C'est un champ de texte modifiable où vous définissez la personnalité et le rôle du bot. Il suffit de remplir le modèle : 'Vous êtes un {role} qui {behavior}.' Par exemple, 'Vous êtes un bot d'assistance client serviable qui parle comme un chevalier médiéval.'

C'est certainement une très bonne idée de l'inclure pour de nombreux cas d'usage, mais le composant est optionnel.

Commencez à créer des chatbots IA personnalisés et contextuels grâce à la fonctionnalité Prompt intuitive de FlowHunt. Définissez des rôles, des comportements et contrôlez la sortie pour des automatisations plus intelligentes.

Découvrez le composant Générateur dans FlowHunt : une génération de texte puissante pilotée par l’IA utilisant le modèle LLM de votre choix. Créez facilement de...

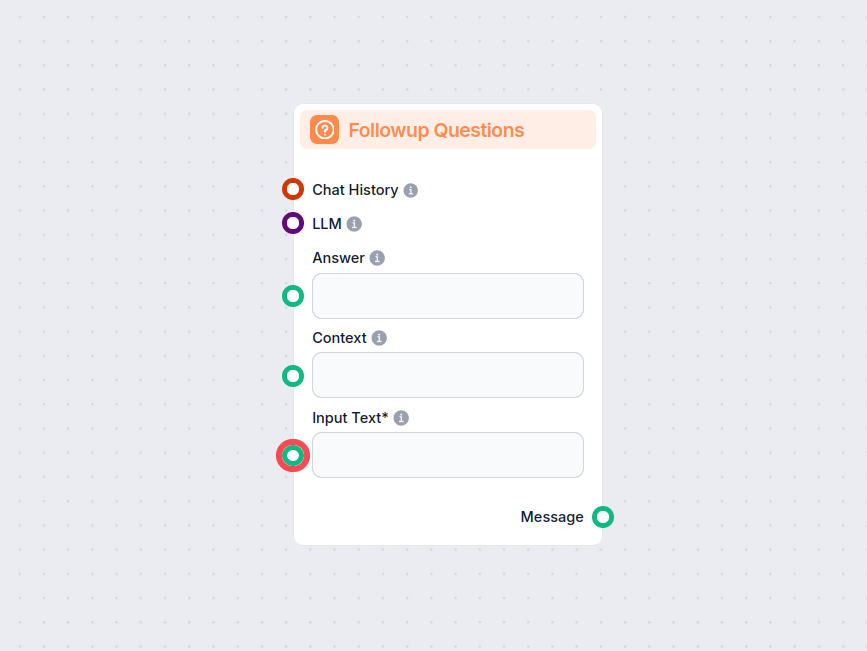

Le composant Questions de suivi dans FlowHunt génère intelligemment des questions pertinentes que les utilisateurs peuvent poser ensuite, en fonction de la conv...

Découvrez les techniques courantes de prompt engineering pour que votre chatbot e-commerce réponde plus efficacement aux questions de vos clients.

Consentement aux Cookies

Nous utilisons des cookies pour améliorer votre expérience de navigation et analyser notre trafic. See our privacy policy.