mcp-server-docker MCP Server

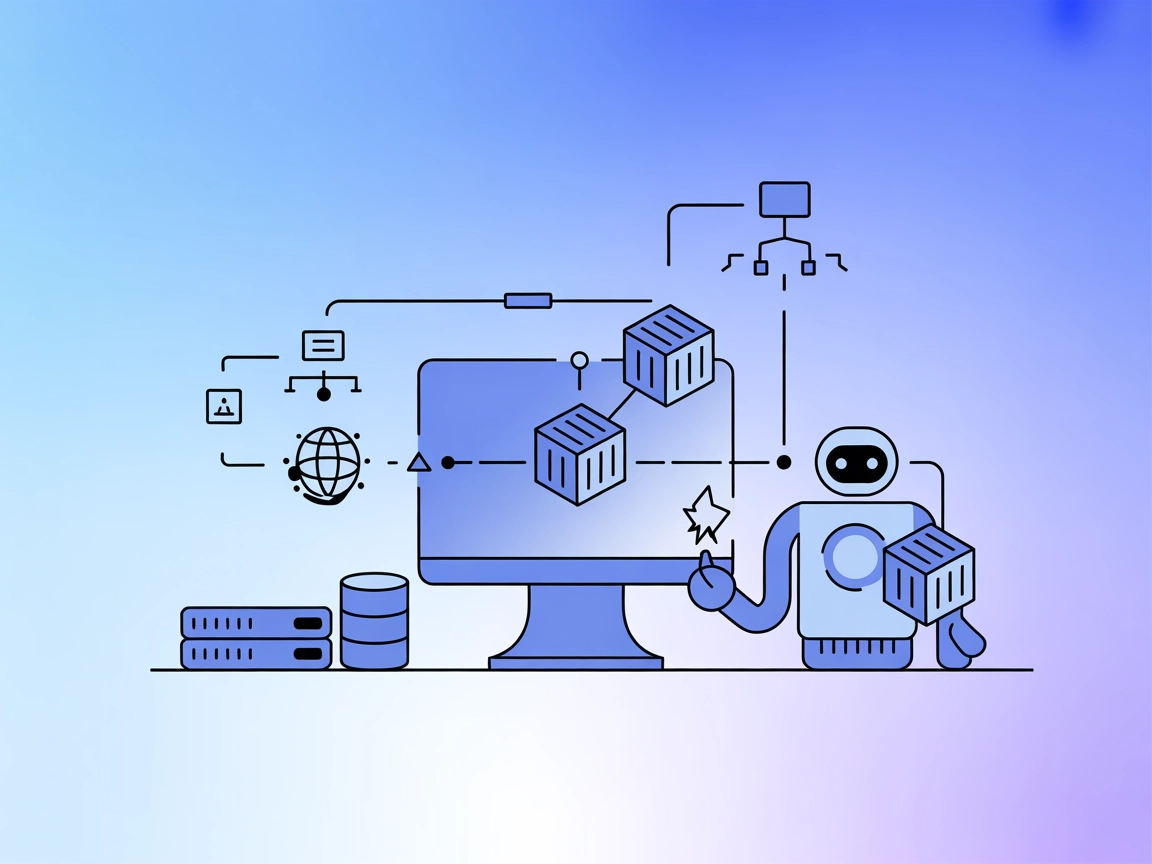

Il server mcp-server-docker MCP consente agli assistenti AI di gestire i container Docker tramite linguaggio naturale. Integra questo MCP con FlowHunt e altri c...

Potenzia i tuoi assistenti AI con una memoria specifica di progetto. ConPort memorizza e recupera il contesto strutturato del progetto, abilitando flussi di lavoro AI più intelligenti e contestuali in FlowHunt e IDE.

FlowHunt fornisce un livello di sicurezza aggiuntivo tra i tuoi sistemi interni e gli strumenti AI, dandoti controllo granulare su quali strumenti sono accessibili dai tuoi server MCP. I server MCP ospitati nella nostra infrastruttura possono essere integrati perfettamente con il chatbot di FlowHunt così come con le piattaforme AI popolari come ChatGPT, Claude e vari editor AI.

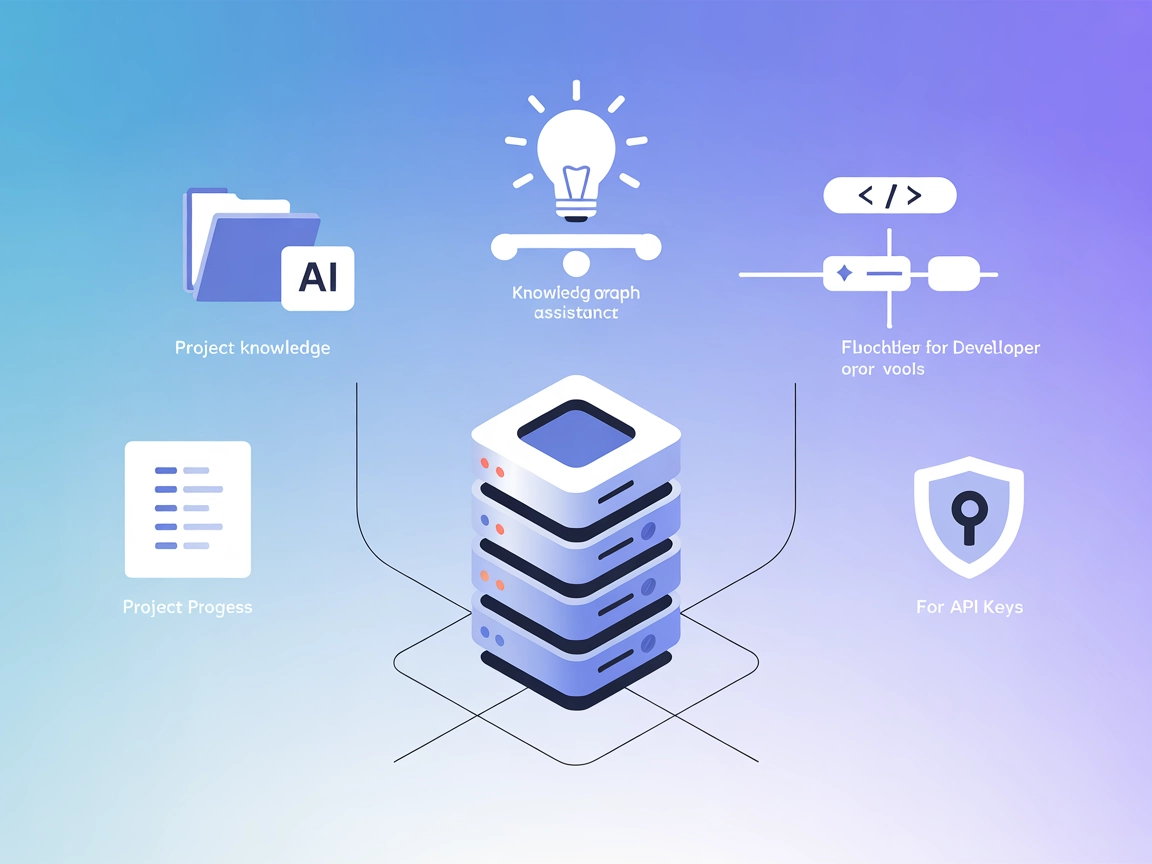

Context Portal (ConPort) è un server MCP memory bank progettato per potenziare assistenti AI e strumenti di sviluppo negli IDE gestendo il contesto strutturato di progetto. Agendo come un grafo della conoscenza specifico di progetto, ConPort abilita una potente Retrieval Augmented Generation (RAG), consentendo all’AI di accedere e utilizzare rapidamente informazioni rilevanti sul progetto. Conserva dati importanti come decisioni, task, progressi, pattern architetturali, glossari e specifiche in modo strutturato. Questo aiuta gli assistenti AI a fornire risposte più accurate e contestuali, migliorando i flussi di lavoro di sviluppo rendendo la conoscenza di progetto facilmente ricercabile e fruibile.

Nei file del repository e nella documentazione disponibili non sono menzionati template di prompt.

Nei file del repository e nella documentazione disponibili non sono elencate risorse MCP esplicite.

Nei file del repository disponibili e nella logica del server non sono descritti o elencati strumenti specifici da server.py o altro.

Gestione della conoscenza di progetto

Archivia e recupera decisioni chiave di progetto, glossari, specifiche e pattern architetturali, permettendo agli assistenti AI di fornire guida e contesto specifici per il progetto.

Assistenza alla programmazione AI contestuale

Permetti agli assistenti AI negli IDE di accedere alla memoria strutturata del progetto, migliorando suggerimenti di codice e spiegazioni grazie alla storia e alla terminologia del progetto.

Retrieval Augmented Generation (RAG)

Migliora gli assistenti basati su LLM fornendo loro dati di progetto aggiornati e rilevanti per risposte più accurate e ricche di contesto.

Monitoraggio dell’avanzamento di progetto

Mantieni una traccia strutturata delle attività completate, dei problemi in sospeso e del lavoro in corso, così che gli agenti AI possano riassumere o riportare lo stato del progetto.

{

"mcpServers": {

"context-portal": {

"command": "npx",

"args": ["@context-portal/mcp-server@latest"]

}

}

}

{

"mcpServers": {

"context-portal": {

"command": "npx",

"args": ["@context-portal/mcp-server@latest"]

}

}

}

{

"mcpServers": {

"context-portal": {

"command": "npx",

"args": ["@context-portal/mcp-server@latest"]

}

}

}

{

"mcpServers": {

"context-portal": {

"command": "npx",

"args": ["@context-portal/mcp-server@latest"]

}

}

}

Protezione delle chiavi API:

Per fornire in modo sicuro le chiavi API, usa variabili di ambiente. Ecco un esempio di come includerle nella configurazione:

{

"mcpServers": {

"context-portal": {

"command": "npx",

"args": ["@context-portal/mcp-server@latest"],

"env": {

"CONPORT_API_KEY": "${CONPORT_API_KEY}"

},

"inputs": {

"apiKey": "${CONPORT_API_KEY}"

}

}

}

}

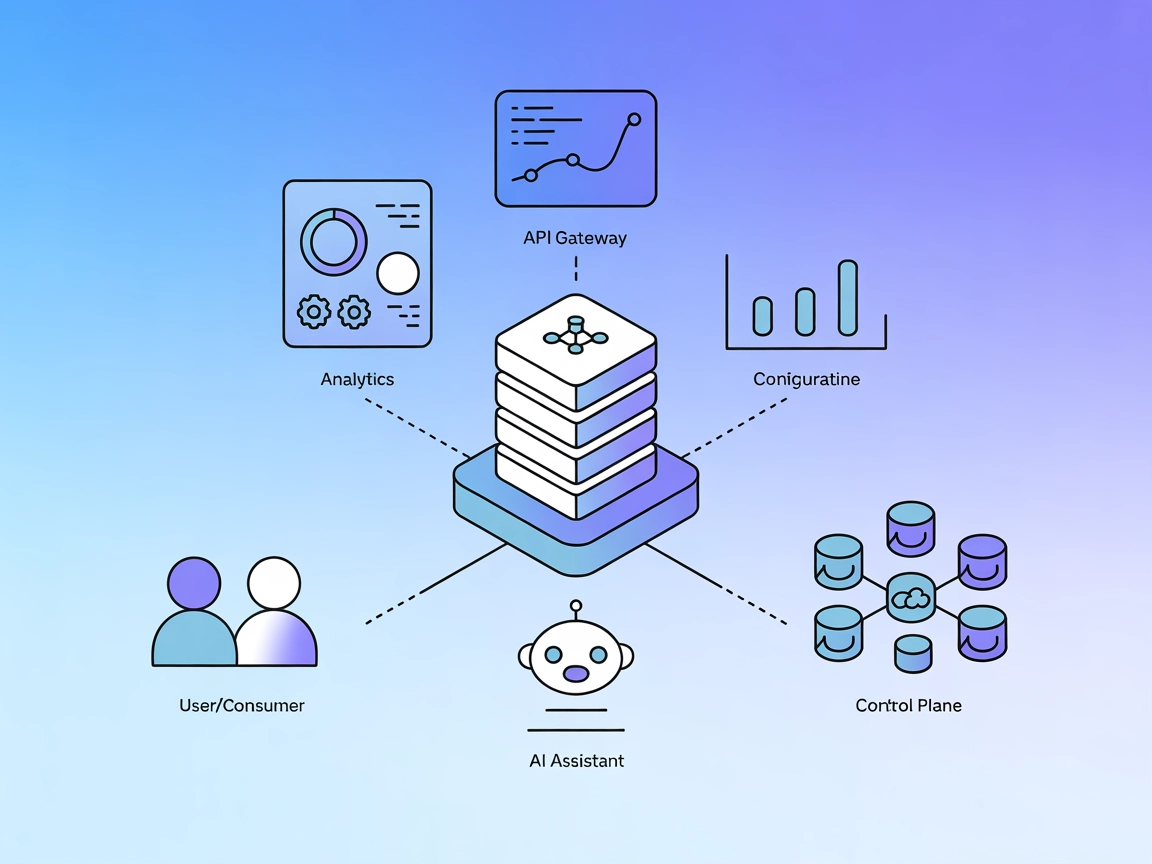

Utilizzo di MCP in FlowHunt

Per integrare i server MCP nel tuo workflow FlowHunt, inizia aggiungendo il componente MCP al tuo flow e collegandolo al tuo agente AI:

Clicca sul componente MCP per aprire il pannello di configurazione. Nella sezione di configurazione MCP di sistema, inserisci i dettagli del tuo server MCP usando questo formato JSON:

{

"context-portal": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

Una volta configurato, l’agente AI potrà utilizzare questo MCP come strumento con accesso a tutte le sue funzioni e capacità. Ricorda di cambiare “context-portal” con il vero nome del tuo server MCP e sostituire l’URL con quello del tuo server MCP.

| Sezione | Disponibilità | Dettagli/Note |

|---|---|---|

| Panoramica | ✅ | |

| Elenco dei Prompt | ⛔ | Nessun template di prompt trovato |

| Elenco delle Risorse | ⛔ | Nessuna risorsa esplicita elencata |

| Elenco degli Strumenti | ⛔ | Nessuno strumento elencato |

| Protezione chiavi API | ✅ | Esempio per variabili d’ambiente |

| Supporto Roots | ⛔ | Non specificato |

| Supporto Sampling (meno rilevante in valutaz.) | ⛔ | Non specificato |

Context Portal MCP (ConPort) offre una panoramica chiara e una buona articolazione dei casi d’uso, ma manca di documentazione tecnica esplicita per prompt, strumenti e risorse nei file pubblici disponibili. Le istruzioni di setup e le indicazioni sulle chiavi API sono utili. Nel complesso, la sua utilità è evidente, ma dettagli server più approfonditi ne migliorerebbero la valutazione.

Valutazione tabella MCP: 6/10

| Ha una LICENSE | ✅ (Apache-2.0) |

|---|---|

| Ha almeno uno strumento | ⛔ |

| Numero di Fork | 47 |

| Numero di Stelle | 352 |

Context Portal è un server MCP memory bank che gestisce il contesto strutturato del progetto per assistenti AI e strumenti di sviluppo. Funziona come un grafo della conoscenza specifico del progetto, abilitando la Retrieval Augmented Generation (RAG) e funzionalità AI contestuali.

ConPort viene utilizzato per la gestione della conoscenza di progetto, assistenza alla programmazione AI contestuale, Retrieval Augmented Generation (RAG) e monitoraggio dell’avanzamento di progetto nei flussi di sviluppo.

Utilizza variabili di ambiente per fornire in modo sicuro le chiavi API nella configurazione del server MCP. Ad esempio: { "env": { "CONPORT_API_KEY": "${CONPORT_API_KEY}" }, "inputs": { "apiKey": "${CONPORT_API_KEY}" } }

Aggiungi il componente MCP al tuo flow di FlowHunt, connettilo al tuo agente AI e specifica i dettagli del server MCP ConPort nel pannello di configurazione utilizzando il formato JSON fornito. Questo consente all’agente AI di accedere al contesto strutturato e alla memoria di progetto.

Nessun template di prompt o strumento integrato è elencato nella documentazione o nella logica del server disponibile. La sua funzione principale è l’archiviazione strutturata del contesto e il recupero per l’AI di progetto.

Dai potere al tuo team di sviluppo con AI contestuale integrando il Server MCP Context Portal. Semplifica la gestione della conoscenza di progetto e migliora i flussi di lavoro di programmazione guidati dall’AI.

Il server mcp-server-docker MCP consente agli assistenti AI di gestire i container Docker tramite linguaggio naturale. Integra questo MCP con FlowHunt e altri c...

Il Kong Konnect MCP Server integra assistenti AI con l'API Gateway di Kong Konnect, abilitando query in linguaggio naturale per analytics, configurazione e gest...

Integra e automatizza dashboard, sorgenti dati e strumenti di monitoraggio di Grafana nei flussi di lavoro di sviluppo guidati dall’AI utilizzando il Grafana MC...

Consenso Cookie

Usiamo i cookie per migliorare la tua esperienza di navigazione e analizzare il nostro traffico. See our privacy policy.