ModelContextProtocol (MCP) サーバー統合

ModelContextProtocol (MCP) サーバーは、AIエージェントと外部データソース、API、サービスをつなぐ橋渡しとして機能し、FlowHuntユーザーがコンテキスト認識型でワークフロー自動化が可能なAIアシスタントを構築できるようにします。本ガイドでは、セットアップ、構成、および安全な統合のためのベ...

FlowHunt のマルチモデルアドバイザー MCP サーバーは、AI エージェントが複数の Ollama モデルを同時に参照し、それらの出力を統合して、より包括的な回答や高度な共同意思決定を実現します。

FlowHuntは、お客様の内部システムとAIツールの間に追加のセキュリティレイヤーを提供し、MCPサーバーからアクセス可能なツールをきめ細かく制御できます。私たちのインフラストラクチャーでホストされているMCPサーバーは、FlowHuntのチャットボットや、ChatGPT、Claude、さまざまなAIエディターなどの人気のAIプラットフォームとシームレスに統合できます。

マルチモデルアドバイザー MCP サーバーは、AI アシスタントを複数のローカル Ollama モデルに接続し、同時に複数モデルへ照会し、応答を統合できる Model Context Protocol (MCP) サーバーです。この「アドバイザー協議会」的アプローチにより、Claude などの AI システムが異なるモデルから多様な視点を統合し、より深くニュアンスのある回答を実現します。各モデルごとに異なる役割やキャラクター設定(システムプロンプト)の割り当ても可能で、Claude for Desktop などの環境とシームレスに統合されます。開発ワークフローを強化し、モデル意見の集約、高度な意思決定、複数 AI ソースからの豊かな文脈情報の取得などに役立ちます。

server.py などのファイルや README、ファイルツリーにも明示的なツール一覧はありません。mcpServers セクションに以下の JSON スニペットを追加します:{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

npx -y @smithery/cli install @YuChenSSR/multi-ai-advisor-mcp --client claude

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

API キーの保護について

API キーや機密性の高い環境変数は、設定ファイル内の env フィールドを利用して保護できます:

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

}

}

}

秘密情報は OS や CI/CD パイプラインで環境変数として設定し、ハードコーディングを避けてください。

FlowHunt での MCP 利用

MCP サーバーを FlowHunt のワークフローに統合するには、まず MCP コンポーネントをフローに追加し、AI エージェントと接続します。

MCP コンポーネントをクリックして設定パネルを開き、システム MCP 設定セクションで下記 JSON 形式でサーバー情報を入力します:

{

"multi-ai-advisor-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

設定後、AI エージェントはこの MCP の全機能をツールとして利用できるようになります。“multi-ai-advisor-mcp” 部分は実際の MCP サーバー名に、URL は自身の MCP サーバー URL に置き換えてください。

| セクション | 利用可否 | 詳細・備考 |

|---|---|---|

| 概要 | ✅ | README.md、ホームページ |

| プロンプト一覧 | ⛔ | テンプレートなし |

| リソース一覧 | ⛔ | 明示的なリソースなし |

| ツール一覧 | ⛔ | コード・ドキュメントにツール記載なし |

| API キー保護 | ✅ | .env & JSON 設定例 |

| サンプリングサポート(評価に重要度低) | ⛔ | 記載なし |

マルチモデルアドバイザー MCP はセットアップ手順がよくまとまっており、「アドバイザー協議会」アプローチが独自性を持ちますが、プロンプト・リソース・ツールの透明性には欠けています。マルチモデル意思決定ワークフローには高い価値がありますが、技術的な詳細がもっとあるとさらに良いでしょう。2つの表をもとにこの MCP を 6/10 と評価します。基本は網羅され、魅力的なユースケースですが、技術ドキュメントの深みが不足しています。

| ライセンスあり | ✅ (MIT) |

|---|---|

| ツールが少なくとも1つ | ⛔ |

| フォーク数 | 15 |

| スター数 | 49 |

これは、AI アシスタントを複数の Ollama モデルに同時接続できる MCP サーバーです。複数モデルからの応答(「アドバイザー協議会」)を統合し、より包括的でニュアンスのある回答を可能にします。

モデルの意見を集約したバランスの良い意思決定、シナリオ分析のための役割別照会、AI による協調的意思決定、マルチモデルによる高度な開発ワークフローが含まれます。

'env' フィールドを MCP の設定で使用し、OS や CI/CD 環境で変数を設定してください。コードや設定ファイル内へのハードコーディングは避けましょう。

はい、各 Ollama モデルに異なるシステムプロンプトや役割を割り当てて、複数の専門家視点を持つシナリオシミュレーションが可能です。

フローに MCP コンポーネントを追加し、システム MCP 設定パネルでサーバー情報を入力してください。これにより AI エージェントが全機能へアクセス可能となります。

AI アドバイザーの協議会の力を引き出しましょう。複数モデルからの視点を集約し、FlowHunt のマルチモデルアドバイザー MCP でより深いインサイトをワークフローに追加しましょう。

ModelContextProtocol (MCP) サーバーは、AIエージェントと外部データソース、API、サービスをつなぐ橋渡しとして機能し、FlowHuntユーザーがコンテキスト認識型でワークフロー自動化が可能なAIアシスタントを構築できるようにします。本ガイドでは、セットアップ、構成、および安全な統合のためのベ...

EVM MCPサーバーは、複数のEVM互換ネットワークにわたるAIおよび開発ワークフロー向けに、シームレスなブロックチェーン統合を提供します。スマートコントラクト操作、ブロックチェーンのクエリ、およびトランザクション管理を、統一されたAIフレンドリーなインターフェースから実現します。...

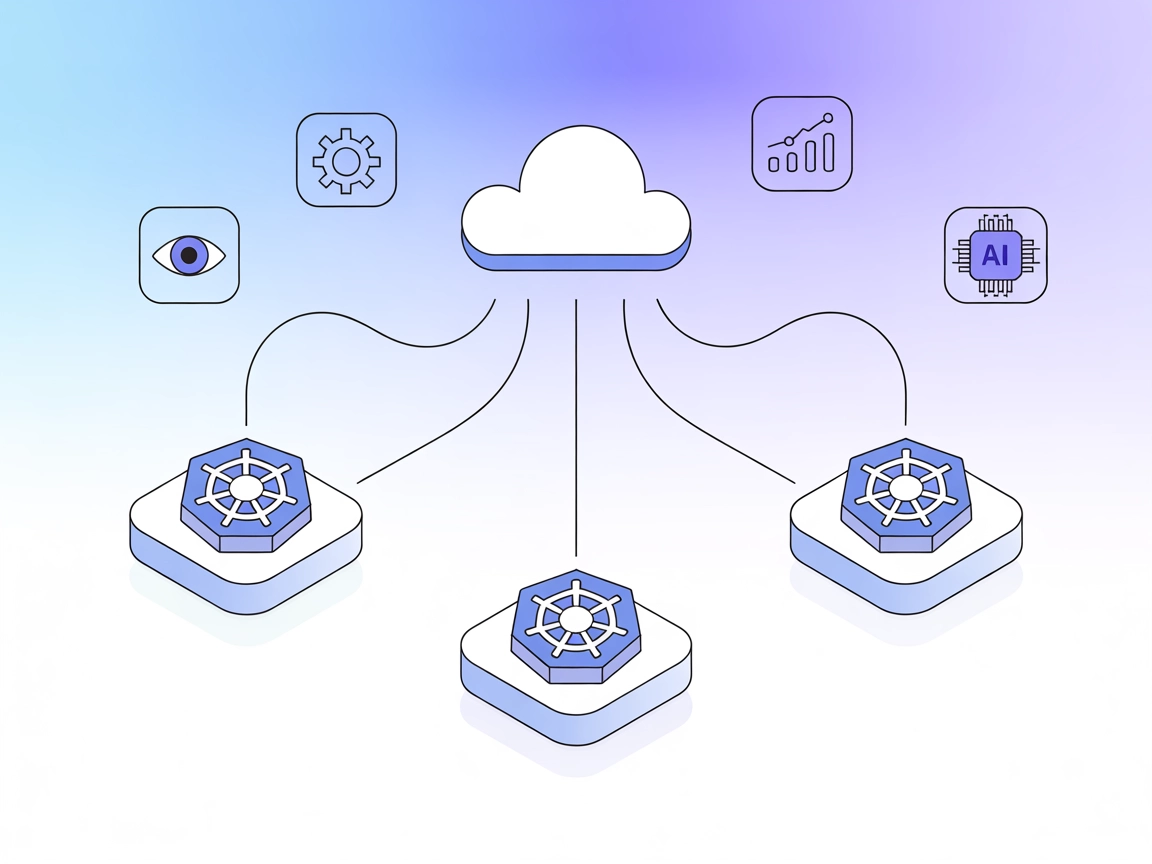

マルチクラスター MCP サーバーは、GenAI システムや開発者ツールが、Model Context Protocol (MCP) を通じて複数の Kubernetes クラスターのリソースを管理・監視・オーケストレーションできるようにし、インテリジェントな自動化や効率的な DevOps ワークフローを実現します。...

クッキーの同意

閲覧体験を向上させ、トラフィックを分析するためにクッキーを使用します。 See our privacy policy.