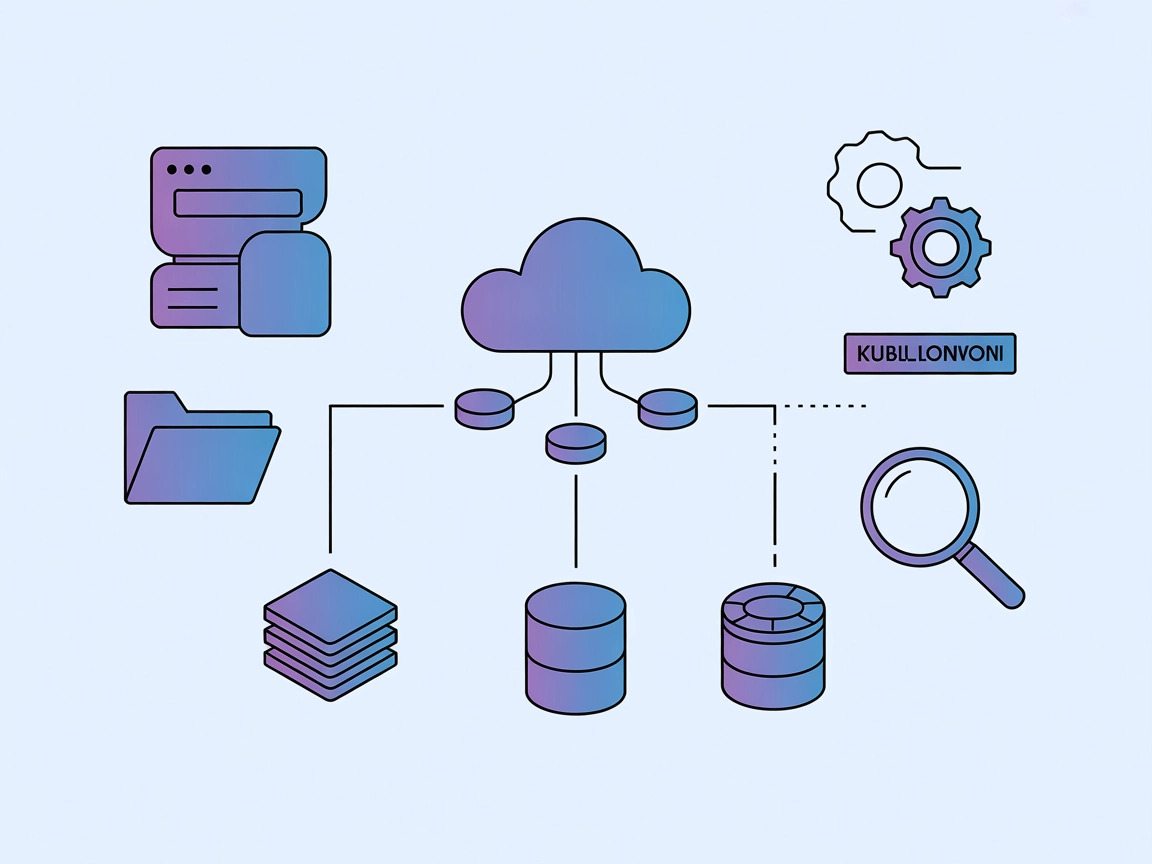

Integrarea serverului ModelContextProtocol (MCP)

Serverul ModelContextProtocol (MCP) acționează ca o punte între agenții AI și sursele externe de date, API-uri și servicii, permițând utilizatorilor FlowHunt să...

Serverul MCP Multi-Model Advisor al FlowHunt permite agenților AI să consulte mai multe modele Ollama simultan, combinând rezultatele lor pentru răspunsuri mai cuprinzătoare și decizii colaborative avansate.

FlowHunt oferă un strat suplimentar de securitate între sistemele dvs. interne și instrumentele AI, oferindu-vă control granular asupra instrumentelor care sunt accesibile de la serverele dvs. MCP. Serverele MCP găzduite în infrastructura noastră pot fi integrate fără probleme cu chatbotul FlowHunt, precum și cu platforme AI populare precum ChatGPT, Claude și diverși editori AI.

Serverul Multi-Model Advisor MCP este un server Model Context Protocol (MCP) proiectat pentru a conecta asistenți AI cu mai multe modele Ollama locale, permițându-le să interogheze mai multe modele simultan și să combine răspunsurile acestora. Această abordare, descrisă ca un „consiliu de consilieri”, permite sistemelor AI precum Claude să sintetizeze perspective diverse din diferite modele, rezultând răspunsuri mai cuprinzătoare și nuanțate la întrebările utilizatorilor. Serverul suportă atribuirea de roluri sau personalități diferite fiecărui model, personalizarea prompturilor de sistem și se integrează perfect cu medii precum Claude pentru Desktop. Acesta îmbunătățește fluxurile de lucru de dezvoltare prin facilitarea unor sarcini precum agregarea opiniilor modelelor, susținerea deciziilor avansate și furnizarea de informații contextuale mai bogate din mai multe surse AI.

server.py sau similar, și nici interfețe de unelte documentate explicit în README sau arborele de fișiere vizibil.mcpServers:{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

npx -y @smithery/cli install @YuChenSSR/multi-ai-advisor-mcp --client claude

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

Securizarea cheilor API

Pentru a securiza cheile API sau variabilele de mediu sensibile, folosește câmpul env în configurație:

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

}

}

}

Setează variabilele de mediu în sistemul de operare sau în pipeline-ul CI/CD pentru a evita stocarea secretelor în clar.

Utilizarea MCP în FlowHunt

Pentru a integra servere MCP în fluxul tău FlowHunt, începe prin a adăuga componenta MCP în flux și a o conecta la agentul tău AI:

Dă click pe componenta MCP pentru a deschide panoul de configurare. În secțiunea de configurare MCP a sistemului, inserează detaliile serverului MCP folosind acest format JSON:

{

"multi-ai-advisor-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

După configurare, agentul AI va putea folosi acest MCP ca unealtă cu acces la toate funcțiile și capabilitățile sale. Amintește-ți să schimbi “multi-ai-advisor-mcp” cu numele real al serverului tău MCP și să înlocuiești URL-ul cu cel al serverului tău propriu MCP.

| Secțiune | Disponibilitate | Detalii/Note |

|---|---|---|

| Prezentare generală | ✅ | README.md, pagina principală |

| Listă de Prompts | ⛔ | Nu s-au găsit template-uri de prompt |

| Listă de Resurse | ⛔ | Nu sunt resurse explicite listate |

| Listă de Unelte | ⛔ | Nu există listă de unelte în cod sau documentație |

| Securizare chei API | ✅ | .env & exemple de configurare JSON |

| Suport sampling (mai puțin important la evaluare) | ⛔ | Nu este menționat |

Multi-Model Advisor MCP este bine documentat pentru configurare și oferă o abordare unică de tip „consiliu de consilieri”, dar îi lipsește transparența în privința prompturilor, resurselor și uneltelor. Valoarea sa este mare pentru fluxurile de decizie multi-model, dar detaliile tehnice suplimentare i-ar îmbunătăți utilitatea. Aș acorda acestui MCP un scor de 6/10 pe baza celor două tabele, deoarece acoperă bazele și oferă un caz de utilizare convingător, dar îi lipsește profunzimea documentației tehnice.

| Are LICENȚĂ | ✅ (MIT) |

|---|---|

| Are cel puțin o unealtă | ⛔ |

| Număr de Forks | 15 |

| Număr de Stars | 49 |

Este un server MCP care conectează asistenții AI la mai multe modele Ollama simultan, permițând combinarea răspunsurilor de la mai multe modele („consiliu de consilieri”) pentru răspunsuri mai cuprinzătoare și nuanțate.

Cazurile de utilizare includ agregarea opiniilor modelelor pentru decizii echilibrate, interogare bazată pe rol pentru analiză de scenarii, decizii AI colaborative și fluxuri de lucru dezvoltator îmbunătățite cu perspective multi-model.

Ar trebui să folosești câmpul 'env' în configurația MCP pentru secrete și să setezi variabilele în sistemul de operare sau mediul CI/CD, evitând includerea lor directă în cod sau fișiere de configurare.

Da, poți atribui prompturi de sistem sau roluri distincte fiecărui model Ollama, permițând simularea de scenarii cu mai multe perspective de experți.

Adaugă componenta MCP în fluxul tău, apoi folosește panoul de configurare MCP pentru a introduce detaliile serverului. Acest lucru permite agenților AI să acceseze toate funcțiile serverului.

Dezvăluie puterea unui consiliu de consilieri AI. Agregă perspective din mai multe modele și îmbunătățește-ți fluxul de lucru cu informații mai bogate folosind Multi-Model Advisor MCP de la FlowHunt.

Serverul ModelContextProtocol (MCP) acționează ca o punte între agenții AI și sursele externe de date, API-uri și servicii, permițând utilizatorilor FlowHunt să...

Kubernetes MCP Server creează o punte între asistenții AI și clusterele Kubernetes/OpenShift, permițând gestionarea programatică a resurselor, operarea podurilo...

Serverul MCP any-chat-completions-mcp conectează FlowHunt și alte unelte la orice API de Chat Completion compatibil cu SDK-ul OpenAI. Permite integrarea fără pr...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.