ModelContextProtocol (MCP) Server-integration

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

FlowHunts Multi-Model Advisor MCP-server låter dina AI-agenter rådgöra med flera Ollama-modeller samtidigt och kombinerar deras svar för mer heltäckande lösningar och avancerat samarbetsbeslutstagande.

FlowHunt erbjuder ett extra säkerhetslager mellan dina interna system och AI-verktyg, vilket ger dig granulär kontroll över vilka verktyg som är tillgängliga från dina MCP-servrar. MCP-servrar som hostas i vår infrastruktur kan sömlöst integreras med FlowHunts chatbot samt populära AI-plattformar som ChatGPT, Claude och olika AI-redigerare.

Multi-Model Advisor MCP-servern är en Model Context Protocol (MCP)-server utformad för att koppla AI-assistenter till flera lokala Ollama-modeller, vilket gör det möjligt att fråga flera modeller samtidigt och kombinera deras svar. Detta tillvägagångssätt, beskrivet som ett “rådgivarråd”, gör att AI-system som Claude kan syntetisera olika synsätt från olika modeller, vilket resulterar i mer heltäckande och nyanserade svar på användarfrågor. Servern stöder att tilldela olika roller eller personligheter till varje modell, anpassa systemprompter och integreras sömlöst med miljöer som Claude för Desktop. Den förbättrar utvecklararbetsflöden genom att underlätta uppgifter som att aggregera modellåsikter, stötta avancerat beslutsfattande och ge rikare kontextuell information från flera AI-källor.

server.py eller liknande fil, och inga verktygsgränssnitt är uttryckligen dokumenterade i README eller synlig filstruktur.mcpServers-sektion:{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

npx -y @smithery/cli install @YuChenSSR/multi-ai-advisor-mcp --client claude

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434"

}

}

}

Skydda API-nycklar

För att skydda API-nycklar eller känsliga miljövariabler, använd fältet env i din konfiguration:

{

"multi-ai-advisor-mcp": {

"command": "npx",

"args": ["@YuChenSSR/multi-ai-advisor-mcp@latest"],

"env": {

"OLLAMA_HOST": "http://localhost:11434",

"MY_SECRET_API_KEY": "${MY_SECRET_API_KEY}"

}

}

}

Sätt miljövariabler i ditt operativsystem eller CI/CD-pipeline för att undvika hårdkodning av hemligheter.

Använda MCP i FlowHunt

För att integrera MCP-servrar i ditt FlowHunt-arbetsflöde, börja med att lägga till MCP-komponenten i ditt flöde och koppla den till din AI-agent:

Klicka på MCP-komponenten för att öppna konfigurationspanelen. I systemets MCP-konfigurationssektion, sätt in dina MCP-serveruppgifter med detta JSON-format:

{

"multi-ai-advisor-mcp": {

"transport": "streamable_http",

"url": "https://yourmcpserver.example/pathtothemcp/url"

}

}

När det är konfigurerat kan AI-agenten nu använda denna MCP som ett verktyg med tillgång till alla dess funktioner och möjligheter. Kom ihåg att ändra “multi-ai-advisor-mcp” till det faktiska namnet på din MCP-server och byt ut URL:en mot din egen MCP-server-URL.

| Sektion | Tillgänglighet | Detaljer/Noteringar |

|---|---|---|

| Översikt | ✅ | README.md, hemsida |

| Lista över promptar | ⛔ | Inga promptmallar funna |

| Lista över resurser | ⛔ | Inga explicita resurser listade |

| Lista över verktyg | ⛔ | Ingen verktygslista hittad i kod eller dokument |

| Skydda API-nycklar | ✅ | .env & JSON-konfigexempel |

| Sampling-stöd (mindre viktigt i utvärdering) | ⛔ | Inte nämnt |

Multi-Model Advisor MCP är väl dokumenterad för installation och erbjuder ett unikt “rådgivarråd”-upplägg, men saknar transparens kring promptar, resurser och verktyg. Dess värde är högt för multi-modellbeslutsarbetsflöden, men mer teknisk detalj hade förbättrat den. Jag skulle ge denna MCP 6/10 baserat på de två tabellerna, då den täcker grunderna och erbjuder ett övertygande användningsfall men saknar djup i teknisk dokumentation.

| Har LICENSE | ✅ (MIT) |

|---|---|

| Har minst ett verktyg | ⛔ |

| Antal förgreningar | 15 |

| Antal stjärnor | 49 |

Det är en MCP-server som kopplar AI-assistenter till flera Ollama-modeller samtidigt, så att de kan kombinera svar från flera modeller ("rådgivarråd") för mer heltäckande och nyanserade svar.

Användningsområden inkluderar aggregering av modellåsikter för balanserade beslut, rollbaserad frågeställning för scenarioanalys, samarbetsbaserat AI-beslutsfattande och förbättrade utvecklararbetsflöden med multi-modellinsikter.

Du bör använda fältet 'env' i din MCP-konfiguration för hemligheter och sätta variabler i ditt OS eller CI/CD-miljö, och undvika att hårdkoda dem i kod eller konfigurationsfiler.

Ja, du kan tilldela distinkta systempromptar eller roller till varje Ollama-modell, vilket möjliggör scenariosimuleringar med flera expertperspektiv.

Lägg till MCP-komponenten i ditt flöde och använd systemets MCP-konfigurationspanel för att lägga in dina serveruppgifter. Detta gör att dina AI-agenter får tillgång till alla funktioner i servern.

Utnyttja kraften hos ett råd av AI-rådgivare. Sammanfoga perspektiv från flera modeller och förbättra ditt arbetsflöde med djupare insikter via FlowHunts Multi-Model Advisor MCP.

ModelContextProtocol (MCP) Server fungerar som en brygga mellan AI-agenter och externa datakällor, API:er och tjänster, vilket gör det möjligt för FlowHunt-anvä...

Model Context Protocol (MCP) Server kopplar samman AI-assistenter med externa datakällor, API:er och tjänster, vilket möjliggör smidig integrering av komplexa a...

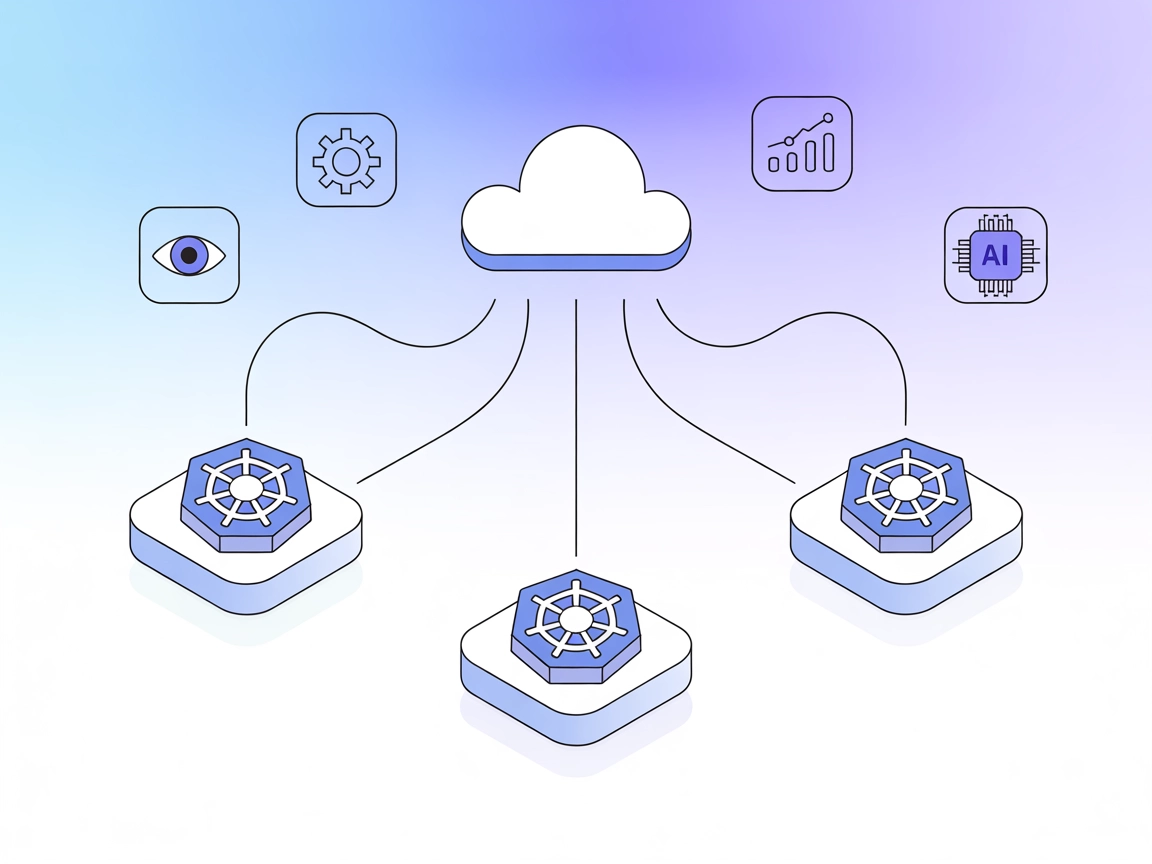

Multicluster MCP-servern ger GenAI-system och utvecklarverktyg möjlighet att hantera, övervaka och orkestrera resurser över flera Kubernetes-kluster via Model C...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.