OpenAI O3 Mini vs DeepSeek für agentische Nutzung

Vergleichen Sie OpenAI O3 Mini und DeepSeek hinsichtlich Schlussfolgerungsfähigkeit, Schachstrategie-Aufgaben und agentischer Tool-Nutzung. Erfahren Sie, welche...

OpenAI O1 nutzt Reinforcement Learning und native Chain-of-Thought-Reasoning, um GPT4o bei komplexen RAG-Aufgaben zu übertreffen – allerdings zu höheren Kosten.

OpenAI hat gerade ein neues Modell namens OpenAI O1 aus der O1-Serie veröffentlicht. Die wichtigste architektonische Änderung dieser Modelle ist die Fähigkeit, vor der Beantwortung einer Benutzeranfrage nachzudenken. In diesem Blog gehen wir ausführlich auf die wichtigsten Neuerungen von OpenAI O1 ein, die neuen Paradigmen, die diese Modelle verwenden, und wie dieses Modell die RAG-Genauigkeit deutlich steigern kann. Wir vergleichen dabei einen einfachen RAG-Flow mit dem OpenAI GPT4o und dem OpenAI O1 Modell.

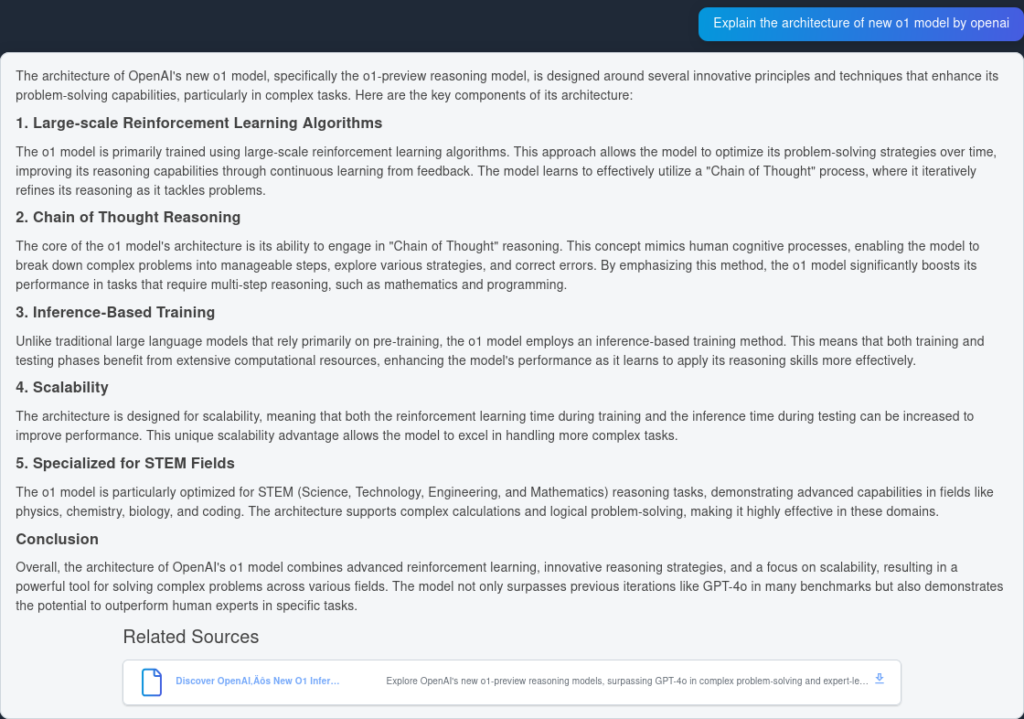

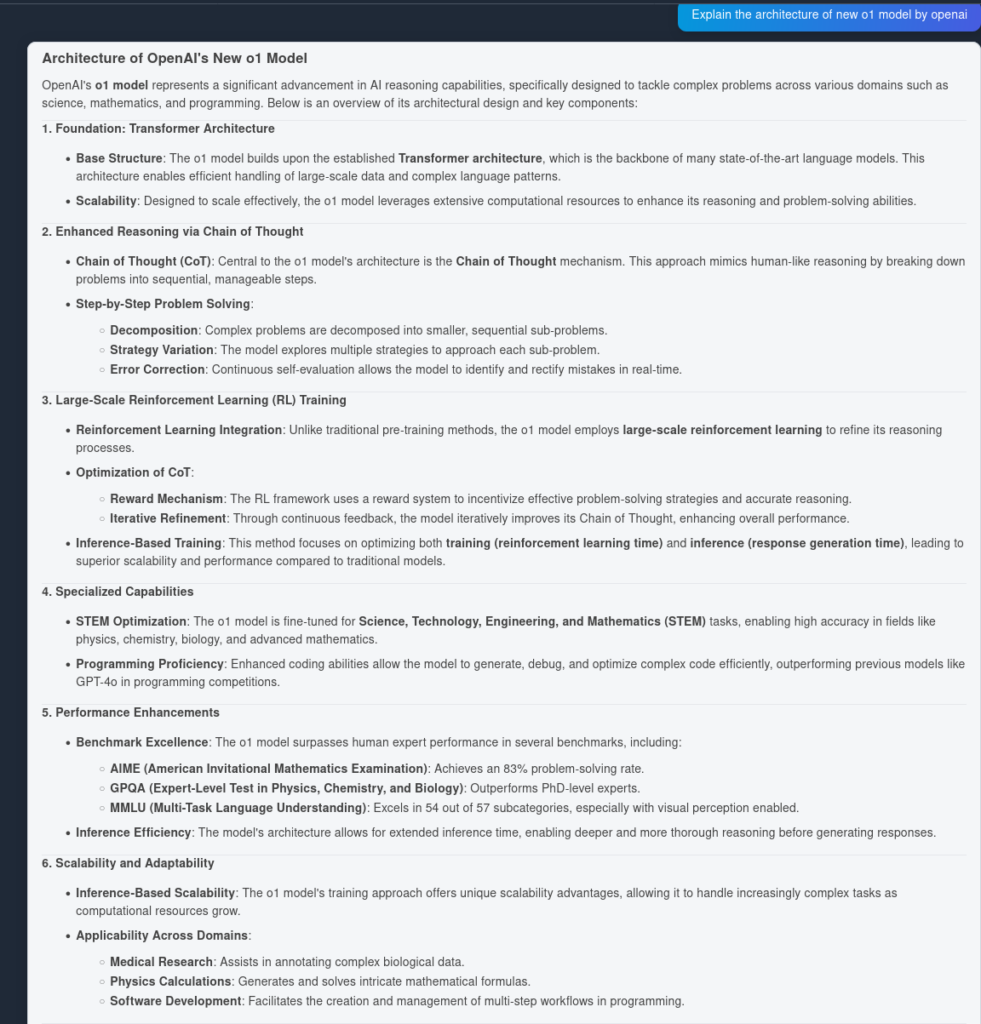

Das O1-Modell nutzt groß angelegte Reinforcement-Learning-Algorithmen während seines Trainingsprozesses. Dadurch kann das Modell eine robuste „Chain of Thought“ entwickeln, die es ihm ermöglicht, Probleme tiefer und strategischer zu durchdenken. Durch kontinuierliche Optimierung seiner Reasoning-Pfade mittels Reinforcement Learning verbessert das O1-Modell seine Fähigkeit, komplexe Aufgaben effizient zu analysieren und zu lösen, erheblich.

Bisher hat sich Chain of Thought als nützliches Prompt-Engineering-Verfahren erwiesen, um LLMs dazu zu bringen, eigenständig Schritt für Schritt komplexe Fragen zu beantworten. Bei O1-Modellen ist dieser Schritt fest integriert und kommt standardmäßig zur Inferenzzeit zum Einsatz, was sie für mathematische und programmiertechnische Problemlösungen besonders nützlich macht.

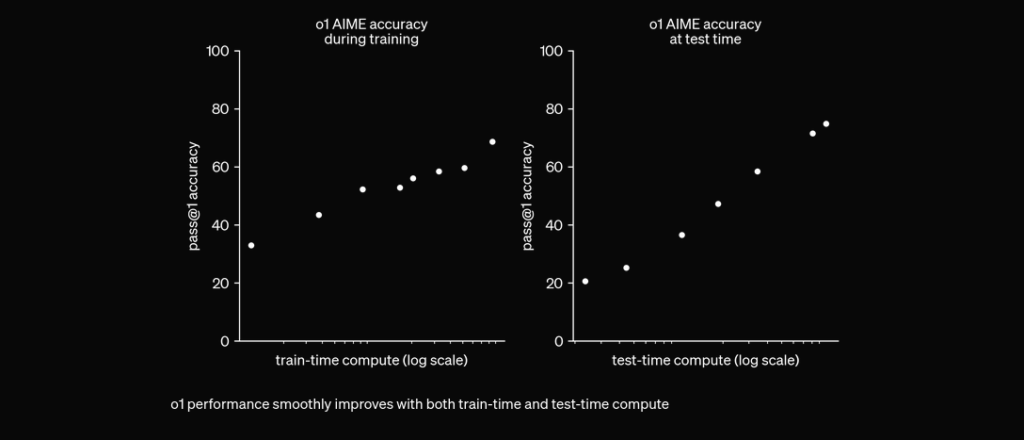

O1 wird mit RL trainiert, um vor der Antwort über eine private Chain of Thought „nachzudenken“. Je länger es nachdenkt, desto besser schneidet es bei Reasoning-Aufgaben ab. Das eröffnet eine neue Skalierungsdimension. Wir sind nicht mehr nur durch Pretraining limitiert. Wir können jetzt auch die Inferenz-Rechenleistung skalieren. pic.twitter.com/niqRO9hhg1

— Noam Brown (@polynoamial) 12. September 2024

In umfangreichen Evaluierungen hat das O1-Modell bemerkenswerte Leistungen in verschiedenen Benchmarks gezeigt:

Um die Performance-Genauigkeit von OpenAI O1 und GPT4o zu testen, haben wir zwei identische Flows erstellt, jedoch jeweils mit einem anderen LLM. Wir vergleichen die Frage-Antwort-Fähigkeit der Modelle anhand von zwei Quellen, die zum technischen Bericht von OpenAI O1 indexiert sind.

Zunächst erstellen wir im FlowHunt einen einfachen RAG-Flow. Er besteht aus Chat Input, Document Retriever (holt relevante Dokumente), Prompt, Generator und Chat Output. Die LLM-OpenAI-Komponente wird hinzugefügt, um das Modell auszuwählen (ansonsten wird standardmäßig GPT4o genutzt).

Hier ist die Antwort von GPT4o:

Und hier das Ergebnis von OpenAI O1:

Wie man sieht, hat OpenAI O1 mehr architektonische Vorteile aus dem Artikel herausgearbeitet – 6 Punkte statt 4. Außerdem zieht O1 logische Schlussfolgerungen aus jedem Punkt und bereichert das Dokument mit zusätzlichen Erkenntnissen, warum die architektonische Änderung sinnvoll ist.

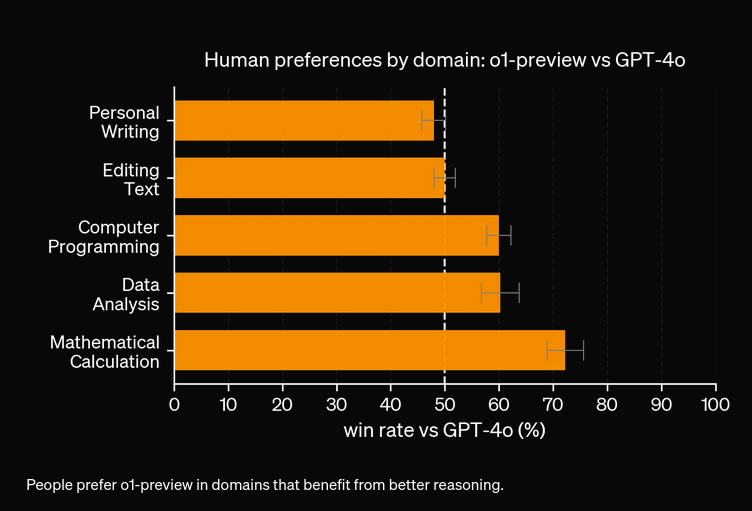

In unseren Experimenten kostet das O1-Modell mehr für die gesteigerte Genauigkeit. Das neue Modell verfügt über drei Token-Typen: Prompt Token, Completion Token und Reason Token (ein neu hinzugefügter Token-Typ), was potenziell teurer ist. In den meisten Fällen liefert OpenAI O1 hilfreichere Antworten, sofern sie auf Fakten beruhen. Es gibt jedoch auch Fälle, in denen GPT4o OpenAI O1 übertrifft – manche Aufgaben benötigen schlicht kein Reasoning.

OpenAI O1 verwendet groß angelegtes Reinforcement Learning und integriert Chain-of-Thought-Reasoning zur Inferenzzeit, was ein tieferes, strategischeres Problemlösen als bei GPT4o ermöglicht.

Ja, O1 erzielt höhere Werte in Benchmarks wie AIME (83 % vs. 13 % bei GPT4o), GPQA (übertrifft Experten auf PhD-Niveau) und MMLU und ist in 54 von 57 Kategorien führend.

Nicht immer. Während O1 bei reasoning-intensiven Aufgaben glänzt, kann GPT4o bei einfacheren Anwendungsfällen, die kein fortgeschrittenes Reasoning erfordern, besser abschneiden.

O1 führt einen neuen 'Reason'-Token zusätzlich zu Prompt- und Completion-Tokens ein, was anspruchsvolleres Reasoning ermöglicht, aber die Betriebskosten erhöhen kann.

Sie können Plattformen wie FlowHunt nutzen, um RAG-Flows und KI-Agenten mit OpenAI O1 für Aufgaben zu erstellen, die fortschrittliches Reasoning und genaue Dokumentenrecherche erfordern.

Yasha ist ein talentierter Softwareentwickler mit Spezialisierung auf Python, Java und Machine Learning. Yasha schreibt technische Artikel über KI, Prompt Engineering und Chatbot-Entwicklung.

Testen Sie FlowHunt, um die neuesten LLMs wie OpenAI O1 und GPT4o für überlegene Reasoning- und Retrieval-Augmented-Generation zu nutzen.

Vergleichen Sie OpenAI O3 Mini und DeepSeek hinsichtlich Schlussfolgerungsfähigkeit, Schachstrategie-Aufgaben und agentischer Tool-Nutzung. Erfahren Sie, welche...

FlowHunt v2.19.14 bringt OpenAIs GPT-4.1-Modelle, 9 neue Bildgenerierungsmodelle von Stable Diffusion, Google und Ideogram sowie eine HubSpot-Integration für op...

Ist OpenAI O3 Mini das richtige KI-Tool für Sie? Wir haben es getestet – von der Inhaltserstellung über Berechnungen bis hin zu weiteren Aufgaben. Sehen Sie, wi...

Cookie-Zustimmung

Wir verwenden Cookies, um Ihr Surferlebnis zu verbessern und unseren Datenverkehr zu analysieren. See our privacy policy.