OpenAI O3 Mini vs DeepSeek para Uso Agente

Compare OpenAI O3 Mini e DeepSeek em tarefas de raciocínio, estratégias de xadrez e uso agente de ferramentas. Veja qual IA se destaca em precisão, acessibilida...

Automação de IA

O OpenAI O1 utiliza aprendizado por reforço e raciocínio nativo em cadeia para superar o GPT4o em tarefas complexas de RAG, embora com um custo mais elevado.

A OpenAI acaba de lançar um novo modelo chamado OpenAI O1 da série O1 de modelos. A principal mudança arquitetural nesses modelos é a capacidade de pensar antes de responder à consulta de um usuário. Neste blog, vamos nos aprofundar nas principais mudanças do OpenAI O1, nos novos paradigmas que esses modelos utilizam e em como esse modelo pode aumentar significativamente a precisão do RAG. Vamos comparar um fluxo RAG simples usando o OpenAI GPT4o e o modelo OpenAI O1.

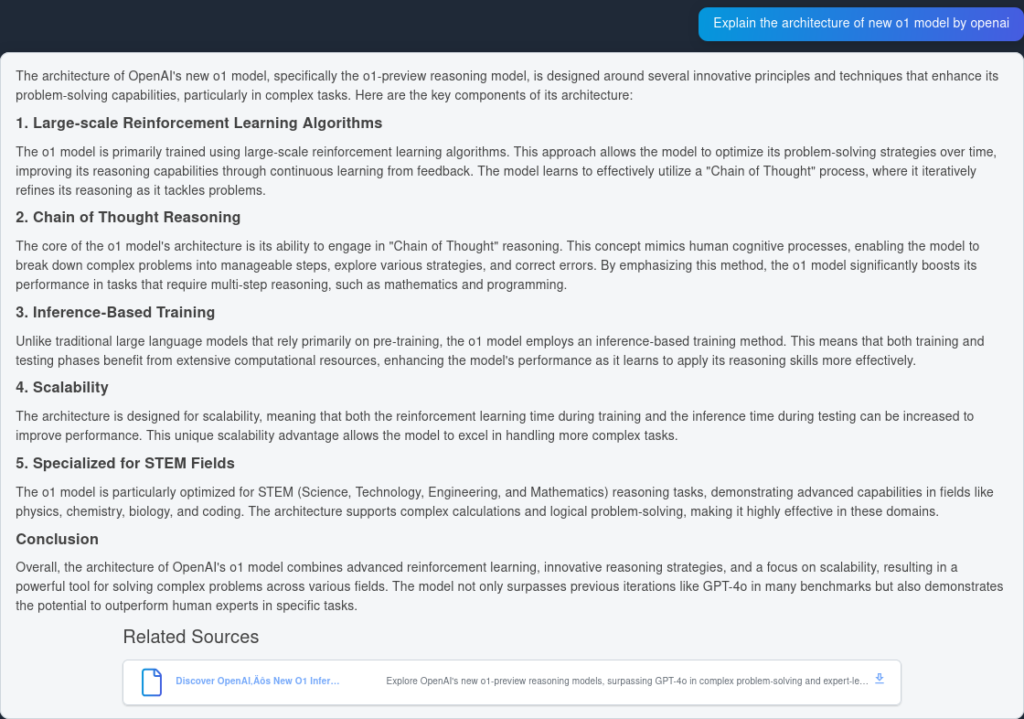

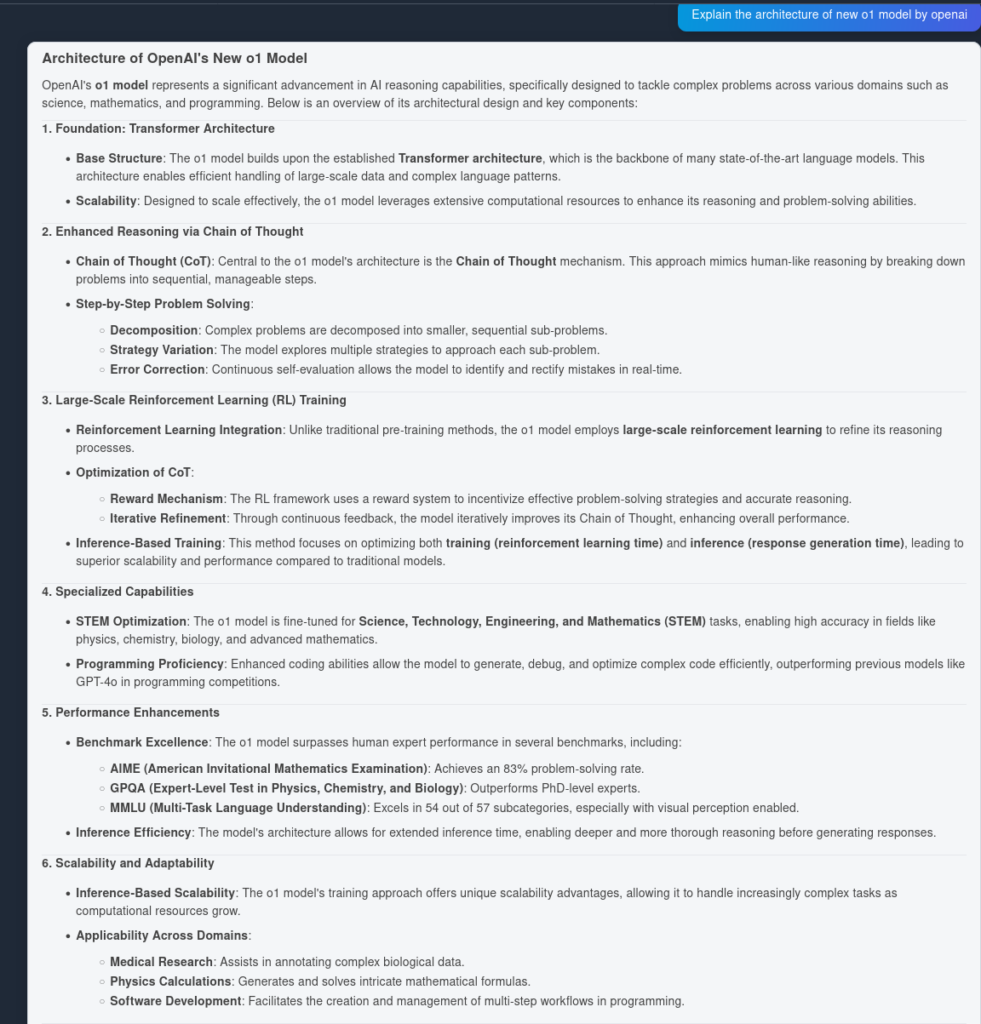

O modelo O1 utiliza algoritmos de aprendizado por reforço em larga escala durante o seu processo de treinamento. Isso permite que o modelo desenvolva uma robusta “Cadeia de Raciocínio”, possibilitando pensar de forma mais profunda e estratégica sobre os problemas. Ao otimizar continuamente seus caminhos de raciocínio por meio do aprendizado por reforço, o modelo O1 melhora significativamente sua capacidade de analisar e resolver tarefas complexas com eficiência.

Anteriormente, a cadeia de raciocínio provou ser um mecanismo útil de engenharia de prompt para fazer o LLM “pensar” por si só e responder perguntas complexas em um plano passo a passo. Com os modelos O1, esse passo já vem de fábrica e é integrado nativamente ao modelo no momento da inferência, tornando-o útil para tarefas de resolução de problemas matemáticos e de programação.

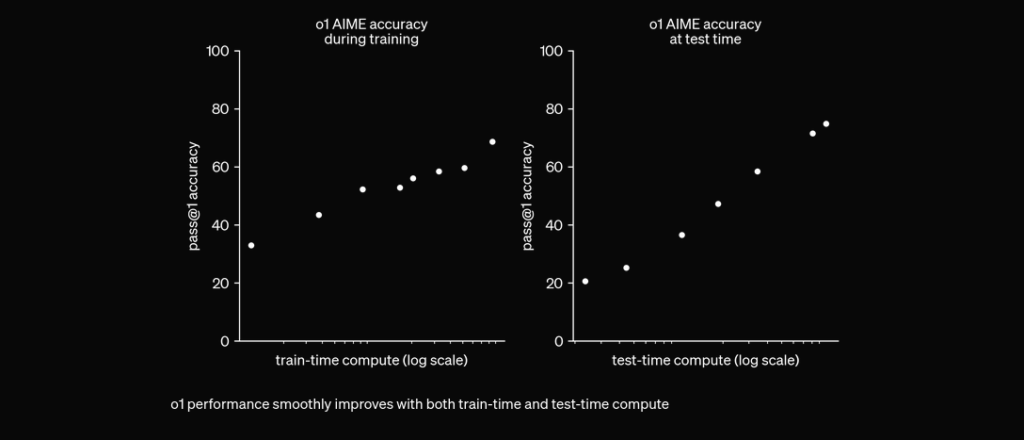

O O1 é treinado com RL para “pensar” antes de responder via uma cadeia de raciocínio privada. Quanto mais tempo pensa, melhor se sai em tarefas de raciocínio. Isso abre uma nova dimensão para escala. Não estamos mais limitados pelo pré-treinamento. Agora podemos escalar a computação da inferência também. pic.twitter.com/niqRO9hhg1

— Noam Brown (@polynoamial) 12 de setembro de 2024

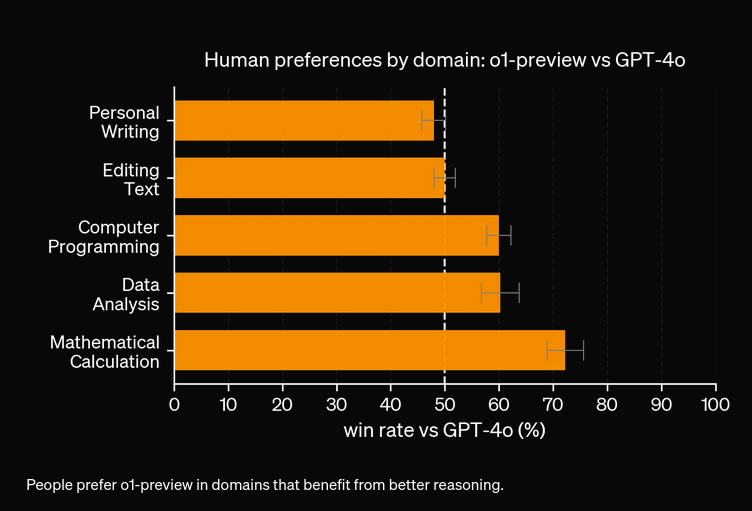

Em avaliações extensas, o modelo O1 demonstrou desempenho notável em vários benchmarks:

Para testar a precisão de desempenho do OpenAI O1 e do GPT4o, criamos dois fluxos idênticos, mas com dois LLMs diferentes. Vamos comparar a capacidade de resposta das perguntas dos modelos em duas fontes indexadas referentes ao relatório técnico do OpenAI O1.

Primeiro, vamos criar um fluxo RAG simples no FlowHunt. Ele consiste em Chat Input, Document Retriever (busca documentos relevantes), Prompt, Generator e Chat Output. O componente LLM OpenAI é adicionado para especificar o modelo (caso contrário, o GPT4o é usado por padrão).

Aqui está a resposta do GPT4o:

E aqui está o resultado do OpenAI O1:

Como você pode ver, o OpenAI O1 capturou mais vantagens arquiteturais do próprio artigo—6 pontos contra 4. Além disso, o O1 faz implicações lógicas de cada ponto, enriquecendo o documento com mais insights sobre por que a mudança arquitetural é útil.

Em nossos experimentos, o modelo O1 custaria mais para maior precisão. O novo modelo possui 3 tipos de tokens: Token de Prompt, Token de Conclusão e Token de Raciocínio (um tipo de token recém-adicionado), tornando-o potencialmente mais caro. Na maioria dos casos, o OpenAI O1 fornece respostas que parecem mais úteis se estiverem fundamentadas na verdade. No entanto, há algumas situações em que o GPT4o supera o OpenAI O1—algumas tarefas simplesmente não precisam de raciocínio.

O OpenAI O1 utiliza aprendizado por reforço em larga escala e integra o raciocínio em cadeia no momento da inferência, permitindo uma resolução de problemas mais profunda e estratégica do que o GPT4o.

Sim, o O1 alcança pontuações mais altas em benchmarks como AIME (83% contra 13% do GPT4o), GPQA (superando especialistas com doutorado) e MMLU, destacando-se em 54 de 57 categorias.

Nem sempre. Embora o O1 se destaque em tarefas que exigem muito raciocínio, o GPT4o pode superá-lo em casos de uso mais simples que não exigem raciocínio avançado.

O O1 introduz um novo token 'Reason', além dos tokens Prompt e Completion, permitindo um raciocínio mais sofisticado, mas podendo aumentar o custo operacional.

Você pode usar plataformas como o FlowHunt para construir fluxos RAG e agentes de IA com o OpenAI O1 para tarefas que exigem raciocínio avançado e recuperação precisa de documentos.

Yasha é um talentoso desenvolvedor de software especializado em Python, Java e aprendizado de máquina. Yasha escreve artigos técnicos sobre IA, engenharia de prompts e desenvolvimento de chatbots.

Experimente o FlowHunt para aproveitar os LLMs mais recentes como OpenAI O1 e GPT4o para raciocínio superior e geração aumentada por recuperação.

Compare OpenAI O3 Mini e DeepSeek em tarefas de raciocínio, estratégias de xadrez e uso agente de ferramentas. Veja qual IA se destaca em precisão, acessibilida...

O FlowHunt v2.19.14 traz os modelos GPT-4.1 da OpenAI, 9 novos modelos de geração de imagens da Stable Diffusion, Google e Ideogram, além de integração com o Hu...

Explore os avanços revolucionários do ChatGPT-5, casos de uso, benchmarks, segurança, preços e direções futuras neste guia definitivo FlowHunt.